Комментарии 510

Офис по кибербезопасности Белого дома США призвал разработчиков переходить на безопасные ЯП типа Rust https://habr.com/p/796901/

...подождите ещё хоть полгодика.

Пожалуйста, читайте статьи полностью, а не только заголовки.

он пожаловался, что C и C++ опять объединяют в одну категорию, полностью игнорируя более 30 лет развития

Ой, почему же так происходит? Почему столько лет игнорируют всё это ваше «развитие»? Может, не стоило добавлять четыре разных приведения типов, каждое из которых требует двух угловых скобок, двух обычных и символа подчёркивания? Может, не стоило вместо List<>.Add() (как у нормальных людей) делать vector<>.push_back()? Может, не стоило алгоритмы оформлять как классы (!!!), вместо того, чтобы инкапсулировать как часть коллекций? Может, не стоило делать два разных типа стрингов, широкие и узкие, которые умеют делать примерно ничего?

Да не, фигня какая-то.

Это претензии к чему? То что разные вещи называются по разному (касты)?) Считание угловых скобочек это что-то уже совсем странное, претензии такие, что даже объяснять что тут не так как то смешно

К удобству. Писать (T) и * проще, чем std::reinterpreprepret_cast<T>( ) и std::shared_ptr<T>( ). Общий смысл такой:

В C++ есть старые инструменты, позволяющие писать небезопасный код

В C++ также есть новые инструменты, позволяющие писать безопасный код

Большинство новых инструментов сделаны вырвиглазными, многословными, многобуквенными и неудобными. Да, ими можно пользоваться. Но удобными они от этого не становятся

Многословная многобуквенность. Очень напоминает бюрократию из человеческого мира, где на каждый чих нужна справка. Вот тут тоже — захотел чихнуть, пиши громоздкую конструкцию с квадроточиями, подчёркиваниями и длинными словами. А всё что писалось буквально одним символом — это теперь ересь, так делать нельзя. Спасибо что хоть перед фигурными скобками std::{ не надо писать std::}

Это (добавление новых возможностей для безопасности) надо было сделать — да. Это C++, он профессиональный язык для серьёзных штук, а не какой‑нибудь там питон — снова да. Но, всё равно, это надо было сделать удобнее. Даже в int32_t не обошлось без земли! Ну зачем так делать?

Эргономика есть не только у кружек, дрелей, и приложений. У языка она тоже есть. Человек, создающий сложные серьёзные штуки, может страдать от сложности задачи, но он не должен страдать от инструмента, с помощью которого он эти задачи решает.

Вот перейти надо трассу. Можно просто перелезть через отбойник и быстро перебежать. А вон справа вон, безопасный мост. Вы идёте до него 100 метров, пристёгиваетесь к перилам, поднимаетесь по 8 лестничным пролётам. Затем отстёгиваетесь, наверху, у вас проверяют паспорт, проверяют знание стихотворений Лермонтова наизусть, потом вы идете первую половину моста, вас останавливают, досматривают, спрашивают цель перехода и собираетесь ли вы потом идти обратно, вам дают ключ, потом проходите вторую половину моста, проходите тест на трезвость (а вдруг вы упадёте) открываете калитку, пристёгиваетесь к перилам, спускаетесь по лестинце 8 пролётов, отстёгиваетесь от перил, проходите 100 метров обратно. Безопасно? Безопасно. И чего все возмущаются, глупости какие‑то...

Что вам мешает сделать свой алиас, который будет по вашему "многословные" вещи делать такими, как вам удобно?

И опять же противоречие, в одном месте - нужно чтобы небезопасный код было писать сложнее, в другом месте reinterpret_cast (самое небезопасное что можно придумать) - а давайте покороче!

Про указатели вы совсем не попали, просто поинтер (*) и shared_ptr это максимально разные вещи, одно на другое заменить нельзя никогда

Эргономика есть не только у кружек, дрелей, и приложений. У языка она тоже есть.

Вот тут то вы и правы, только у языка не эргономика, а семантика. Чтобы код можно было читать и писать язык должен быть логичным и понятным, т.е. его семантика должна быть интуитивна

И в этом качестве я конкурента С++ ни одного не знаю, shared_ptr отлично выражает то что происходит в коде, также как и reinterpret_cast, читаешь код и всё однозначно и понятно.

Теперь сравните с семантикой "безопасного" языка(Rust)

shared_ptr => Arc

reinterpret_cast<T>(x); => let new_value = unsafe { mem::transmute(bytes) };

Ну как, понятно? Если подумаете, что понятно, то скажите к какому типу "трасмутируются" байты во втором сценарии. (ответ: неизвестно, это выведется из дальнейшего использования 'new_value', очень безопасно)

Конечно, можно обточить напильником любую дичь и сделать из неё конфетку. Но проблема как раз в том, что без напильника эта дичь — дичь.

И опять же противоречие, в одном месте - нужно чтобы небезопасный код было писать сложнее, в другом месте reinterpret_cast (самое небезопасное что можно придумать) - а давайте покороче!

Моя претензия как раз и состоит в том, что в этом языке покороче является противоположностью безопаснее. Так быть не должно. Должно быть (покороче и безопаснее) или (подлиннее и небезопаснее).

Про Rust я ничего не писал, Вы сами его упомянули. Я на нём не пишу и отношусь к нему нейтрально никак. Появится мой личный опыт работы с ним — будут сравнивать.

И в этом качестве я конкурента С++ ни одного не знаю, shared_ptr отлично выражает то что происходит в коде, также как и reinterpret_cast, читаешь код и всё однозначно и понятно.

Ч — std::reinterpert_cast<std::word>(std::shared_ptr<std::sarcasm>(std::читаемость_t))

Я не специалист по С++, но лет много назад читал, что названия типа reinterpret_cast специально выбирали такими неудобными, чтобы программистам было неохота использовать подобные приемы в коде. Ведь если тебе надо использовать байты одного типа как байты другого типа, то явно что-то не так в логике - это либо хитрая оптимизация, и тогда не жалко написать специальное слово, либо так делать не надо.

А то что то же самое можно записать парой символов в стиле С - ну это для совместимости оставили, а не для удобства.

Речь то не про конкретно приведение типов, а про то, что почти всё новое в C++ сделано неудобно. С каждым разом от тебя хотят всё больше и больше __всяких:::::::слов, <std::букв> и constexpr [[std::вырвиглазных]]:::<<<<конструкций___t>>> constexpr, апеллируя к Безопасности с большой красивой буквы std::Б.

Ниже unC0Rr привёл отличный пример:

30 лет развития C++ - это когда вместо

std::string doit(std::string param);нужно писать[[nodiscard]] constexpr auto doit(std::string_view param) noexcept -> std::string;

Это что вообще за дичь? Зачем так делать? Зачем они пытаются догнать брейнфак? Им там скучно?

C++ хороший, не закапывайте C++, пожалуйста.

когда вместо ... нужно писать

Не нужно. Каждое слово что-то значит, должно быть написано зачем-то. Не хотите писать - не пишите

Вот и не хотят. Вот и не пишут. Вот и получается небезопасно. Об этом и речь. Надо чтобы вероятность захотеть написать безопасно была выше, чем вероятность захотеть написать небезопасно.

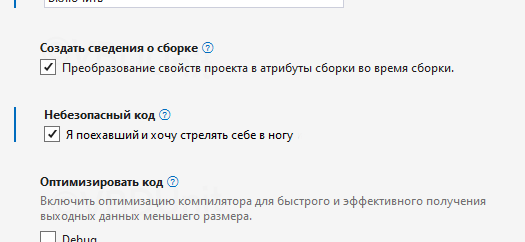

Более‑менее неплохой пример — то, как это сделано в C#. Я могу писать только безопасно. Если я хочу писать опасно, я сначала должен зайти, поставить галочку

потом написать

unsafe

{

}И только внутри мне позволят творить опасные опасности. А для __makeref и __refvalue вообще не показываются автокомплиты. Небезопасному коду мешает и семантика языка, и компилятор языка, и среда разработки. А безопасный код пишется проще.

А в C++ наоборот: если я хочу писать опасно, я просто пишу * и &. Если же я хочу писать безопасно, мне надо std::shared_ptr constexpr const const std::lock_guard.

Я не говорю что такой подход идеальный, просто в нём вектор удобства повернут в нужную сторону — удобнее писать безопасно, чем небезопасно.

Вы просто не пишите на C++ в принципе, поэтому ретранслируете всевозможные дурацкие примеры вроде "нужно писать [[nodiscard]] constexpr auto doit(std::string_view param) noexcept -> std::string; " или "Если же я хочу писать безопасно, мне надо std::shared_ptr constexpr const const std::lock_guard". Можно подумать за пределами c++ разделяемое владение никому не нужно (или наоборот, всем нужно только и исключительно оно, поэтому shared_ptr там опущено и принимается по умолчанию), как и блокировки.

Мне часто приходится писать на C++, хотя да — это далеко не основной язык, которым я пользуюсь. В основном я хожу туда за числодробилками и/или 3D‑графикой.

Можно подумать за пределами c++ разделяемое владение никому не нужно (или наоборот, всем нужно только и исключительно оно, поэтому shared_ptr там опущено и принимается по умолчанию), как и блокировки.

Это частности, на примере которых я объясняю непродуманность и неудобность нововведений языка.

Я не говорю «частное владение нужно» или «частное владение не нужно», я не говорю «блокировки нужны» или «блокировки не нужны».

Я говорю, что в язык C++ блокировки были вставлены бездумно и неудобно, я говорю, что разделяемое владение было сделано бездумно и неудобно. И почти всё новое, что они туда засунули, они засунули бездумно и неудобно.

Ещё раз, само то, что засунули — хорошо, то каким именно способом засунули — плохо.

И почти всё новое, что они туда засунули, они засунули бездумно и неудобно.

А удобно это как? Вот есть int, есть int *, как должен выглядеть, по-вашему, удобный std::shared_ptr<int>?

int* написать проще, чем std::shared_ptr<int>. Поэтому опасность удобнее и лаконичнее безопасности. Это проблема

Я рассуждаю следующим образом. Что мы могли бы сделать с языком, если наша задача предоставить сообществу разработчиков удобный, эффективный и безопасный инструмент?

Сломать обратную совместимость и сделать так, что int* — это и есть std::shared_ptr<int>, а для небезопасного указателя сделать std::unsafe_ptr<int>. Тогда получится, что безопасно писать удобнее, а небезопасно — неудобнее. Профит. Минус: мы тотально уничтожили обратную совместимость, да ещё и запутали разработчиков.

Сохранить обратную совместимость, но сделать так, что новый безопасный указатель проигрывает конкуренцию по эргономике небезопасному указателю - это то, что сделано сейчас. Вот это вот std::shared_ptr<int> - это неудобная дичь.

Сохранить обратную совместимость, но сделать так что новый указатель выигрывает конкуренцию по эргономике небезопасному указателю. Это будет стимулировать разработчиков использовать его. Это идеальный вариант. Проблема в том, что сложно придумать что-то лаконичнее, чем звёздочка *. Я понятия не имею, что это может быть.

Сохранить обратную совместимость, но сделать так что новый указатель не проигрывает конкуренцию по эргономике небезопасному указателю. Это не будет стимулировать разработчиков использовать его, но и не будет отталкивать. Как? Это уже дискусионный вопрос. Самое главное, что должно быть обязательно — эта форма не должна быть менее удобной, чем *. В рамках мозгового штурма можно накидать предлагаемые варианты:

int`

int@

int^ (занят C++ CLI)

int+

int$

int_ptr (добавление постфикса _ptr к любому типу делает его безопасным указателем)

Ничего не добавлять, но обязать встраивать в компилятор ИИ‑анализатор, который будет палить потенциальные неочевидные места, где int* выстрелит тебе в ногу и выкидывать варнинги — то, что сейчас кажется безумием, в будущем будет нормой.

Ещё что-нибудь, что не будет требовать писать жирные::__монструозные<констр>(укции) const.

Да, лезть в синтаксис с неочевидной фигнёй, наверное, не круто. А звёздочка — она разве очевидная? Она привычная, но не очевидная. Звёздочка есть часть синтаксиса, и она состоит из одного символа. Конкурировать по эргономике с ней может только то, что не сложнее. Поэтому, как бы неприятно это не было, это может быть только ещё один какой‑то символ. Да, это не так очевидно для тех, кто видит это в первый раз. Но C++ — это не про низкий порог вхождения, наверное. Хотя может я ошибаюсь.

Я не думаю, что моё предложение прям хорошее, и сам в нём не особо уверен, это просто размышления. Это субъективщина.

Обращаю внимание: утверждение о том, что текущая реализация плоха, и утверждение о том, как это, по моему субъективному мнению, можно было бы сделать лучше — это два разных утверждения. И даже если моё предложение неудачно — из ложности второго утверждения не следует ложность первого. Логика.

Не поверите, писать небезопасно (не проверять условия и тд и тп), всегда проще. В любом языке.

"int* написать проще, чем std::shared_ptr<int>. Поэтому опасность удобнее и лаконичнее безопасности. Это проблема "

Проблема - это вот такие бездумные комментарии. shard_ptr - это всего лишь шаблон. Один из многих. Ваши фантазии на тему, что этот шаблон самый правильный и нуждается в особом синтаксисе, конечно прикольные, но жизнь несколько разнообразнее. Ну и конкретно в вашем примере, не поверите, писать shared_ptr не надо. Можно юзать auto. При создании используется make_shared. Не говоря уже о том, что для int обычно юзают optional. А если вам нужны особые сокращения, то никто не мешает написать для себя using или typedef. Но прочитать такой код смогут немногие )

Уважаемый, расскажите нам всем как использовать стд::опшинал со ссылками и не надо тут ляля разводить, что мне это не надо или что вот используйте указатель или что я с++ не понимаю или ещё какую ересь. Где мои безопасные нулабл ссылки я вас спрашиваю!? А нету их и не будет пока страуса буквально не закопают.

reference_wrapper?

Бтв, ссылки по стандарту это вообще алиас на имя и по возможности резолвятся без оверхедов, а не немутабельный указатель, поэтому столько болей.

Для вашей задачи вполне подойдёт T*, хоть и архаично выглядит. Ну а безопасность на уровне опшонала через операторы)

Во-первых врапер НЕ нулабл, во вторых задеррекейчен, а в третьих в с++20 удален.

Для моей задачи (безопасная работа с нулабл ссылками) Т* НЕ подойдёт.

Безопасность на уровне опшинал через операторы - я тут не понимаю о чем вы. Вот операторы из опшионала для безопасности как раз таки надо удалить потому что это как раз и есть проблема писать не безопасно (*) легко, а безопасно (валью) сложно.

Во-первых врапер НЕ нулабл, во вторых задеррекейчен, а в третьих в с++20 удален.

Я уже чуть было не испугался.std::reference_wrapper не за'deprecate'чен.std::reference_wrapper не удалён в C++20.

А то когда-то давно была такая шутка, что комитет принял решение запретить указатели в C++.

Так вам получается и shared_ptr не подходит, он тоже не проверяет сам, лежит ли в нём nullptr. Вообще, все стандартные контейнеры ориентированы не только на безопасность, но и на возможность извлечь максимальную производительность, причём в случае конфликта обычно отдавая предпочтение последнему.

А если вам не нужна производительность, то зачем вы пишете на плюсах?

лишний if прописать слабо? или оно само все должно у вас там раскорячиваться?

оборачиваете во wrapper и передаете хоть null, хоть не инициализирующее значение. без страуструпа никак не наваять?

Вся эта страшная страшность про неудобность написания std::shared_ptr<T> вместо, скажем, T@ разбивается о наличие достаточно работоспособной системы вывода типов. Да, я напишу std::shared_ptr в объявлении или make_shared где-то локально, но на этом +/- и всё.

А лезть в синтаксис ради оптимизации двух с половиной символов в каких-то там миллионных долях кодовой базы действительно не круто

Ну, даже со звездой еще в Сишечке было не все в порядке. Контекстная зависимость сделала злобное дело, и теперь один и тот же символ, написанный перед именем, обозначает разное в зависимости от типа значения, причем тип значения к самому имени, естественно, визуально никак не прикреплен.

В том же Паскале хоть как то пытались с этим бороться:

^integer - тип указателя на значение

a^ - разыменованый указатель (само значение получаемое по указателю)

Здесь хотя бы положение уголка меняется, да и операция разыменовывания (тоже уродское слово из мира сишечки) написана после имени. Казалось бы, ерунда? Вот только эта ерунда приводит к тому, что программист на сишечке вынужден читать тип выражения по спирали а понимание деклараторов превращается в пытку. Очень удобно и интуитивно понятно.

Так что тут до std::shared_ptr<int> еще авгиевы конюшни даже с одной кривой сущностью разгребать и разгребать.

Вот только эта ерунда приводит к тому, что программист на сишечке вынужден читать тип выражения по спирали а понимание деклараторов превращается в пытку. Очень удобно и интуитивно понятно.

Всякие спирали выдумываются потому, что изначальной идеи авторы спиралей не знают. Вот поэтому и пытка.

А как удобно и думно? Реально интересует

Простейший пример - датаграмма (которые используются много где).

Состоит из заголовка фиксированной длины и структуры + байтового буфера переменной длины и структуры.

Содержимое байтового буфера интерпретируется обработчиком в соответствии с тем, что указано в заголовке (тип датаграммы).

Но на транспортном уровне - все это просто байтовый буфер. Ни содержимое ни структура там не важны. Только размер.

Далеко не каждый тип данных можно таким образом представить в буфере, а потому и далеко не любое сообщение можно получить из буфера с помощью чего-то reinterpret_cast-подобного.

Банальнейший пример - массивы переменной длины в середине сообщения.

Ну а если в общем случае чтение сообщения через reinterpret_cast бесполезно, опасно и вообще не работает - то те частные случаи, которые работают, как раз и являются теми самыми "хитрыми оптимизациями".

Далеко не каждый тип данных можно таким образом представить в буфере

Интересный тезис.

Напомню, что в датаграммых передаются данные, но не объекты (не надо их путать на низком уровне). А любые данные (неожиданно) как-то лежат в памяти и точно также могут быть уложены в буфер и переданы по каналу связи Откуда и куда - не важно - на другую машину через IP каналы, на контроллер по какому-нибудь RS485 или в другой процесс через pipe или локальный сокет.

Суть в том, что любые данные представляют собой просто набор байт. Все остальное - это уже интерпретация этого набора для работы с ним.

В системах, работающих в режимах реального времени или просто высоконагруженных системах обрабатывающих большие объемы данных, вам придется столкнуться с тем, что необходимо думать и о быстродействии и о минимизации потребления ресурсов (памяти, процессора, коммуникационных каналов). И вам придется всесильно снижать накладные расходы везде, где это только можно. И тут зачастую датаграмма в общем виде или ее более формализованный вариант protobuf - тот самый путь который выберет вас (на вы его, а он вас)

Так protobuf же как раз и не использует reinterpret_cast для преобразования массива байт в объект!

Это уже внутренняя конкретная реализация. Работа с protobuf может быть реализована на том языке, где никаких reinterpret_cast нет. И там даже объектов как таковых может не быть.

Речь о том, что вы получаете набор байт с которым потом вам что-то нужно делать. Смысл этого набора байт определяется из информации в фиксированном заголовке. И по этой информации вы уже интерпретируете массив байт как какую-то осмысленную структуру данных. Которая (при необходимости) может стать основной для создания вокруг нее объекта. Или не создания, если это будет нести излишние накладные расходы и вам достаточно просто взять эти данные и как-то их однократно обработать.

Довольно странно говорить о конкретном семействе библиотек в отрыве от конкретных реализаций.

Кроме того, повторюсь, вы не можете преобразовать массив переменной длины посреди сообщения в набор байт через аналог reinterpret_cast.

вы не можете преобразовать массив переменной длины посреди сообщения в набор байт через аналог reinterpret_cast.

почему?

Для начала, потому что в языке нету подходящего типа данных для представления такого сообщения. У структур можно хаком "расширять" массив в последнем поле, но только в последнем.

Кроме того, обычно если с сообщением работают не как с массивом байт - значит, его редактируют. Редактирование массива переменной длины включает в себя удаление или добавление в него элементов. Как это делать сохраняя основное свойство - возможность в любой момент сделать reinterpret_cast всего сообщения в массив байт?

если я правильно понял, то подобные проблемы стандартно решаются дополнительным объектом. т.е. исходные данные лежат не в буфере, а самописном байт-стриме. стрим основан на коллекции блоков разной длины. втыкаете новую дату в новом блоке в любое место стрима и итогом формируете свой буфер из стрима. если надо еще добавить, повторяете операцию обновление стрима-выгрузка из стрима. для 90% случаев, а тем более датаграмм до 64к будет работать шустро. в чем проблема?

По моему опыту, когда объемы данных становятся большими (не единичной датаграммы, но их количества), любая лишняя работа с динамической памятью становится заметна в performance explorer статистиках (и вызывает вопросы "а нельзя ли как-нибудь без вот этого всего" на нагрузочном тестировании). Даже на машинках со 120-ю ядрами power9.

Как вариант, однако написанное вами уже выходит за рамки простого reinterpret_cast.

Для начала, потому что в языке нету подходящего типа данных для представления такого сообщения.

Массив это пара (T*, size_t)

У структур можно хаком "расширять" массив в последнем поле, но только в последнем.

Это никак не относится к задачи

Кроме того, обычно если с сообщением работают не как с массивом байт - значит, его редактируют.

Нет. Я хочу работать рид-онли с разными структурами данных, а не только с байтами.

Банальнейший пример - массивы переменной длины в середине сообщения.

Я, конечно, не language lawyer, но после принятия p0593, если вы сами создаёте буфер, а потом отдаёте в читалку, то всё, что implicit lifetime, по идее, создать таки можно static_cast'ом, не вызывая UB.

Смех в том что приниятие какого pXXX зачастую нетребует изменений в реализации компилятора. Т.е. оно как работало так и работает, просто у стандартизаторов дошли руки это описать.

Время жизни - отдельный вопрос, который и правда можно решить. Проблема в том, что VLA в середине сообщения вы в принципе не сможете представить в качестве структуры.

Напильник для грамотной разработки кода не нужен - нужна культура программирования и структура кода. Как пример, ПЛК в пром автоматике, там языки для контроллера ну проще некуда, но без грамотного подхода будет именно дичь, да такая, что иногда проще переписать, чем разруливать наслоения логики и зависимости всего от всего.

Что вам мешает сделать свой алиас, который будет по вашему "многословные" вещи делать такими, как вам удобно?

Если мы используем 5 подсистем, написанных разными командами в разное время, то мне придётся выучить 5 разных наборов алиасов.

Если мне нужно заглянуть в код сторонней библиотеки, то нужно начинать с изучения их алиасов.

Могут возникнуть конфликты при использовании в коде нескольких библиотек с разными наборами алиасов.

только у языка не эргономика, а семантика.

И семантика, и эргономика. Язык (невольно) поощряет использование более лаконичных конструкций.

Например, в Питоне есть map и фильтр. Но какой вариант будет выбирать программист?

list2 = list(map(lambda x: x * 2, filter(lambda x: x > 5, list1)))

list2 = [x*2 for x in list2 if x > 5]Для примера сравните с Хаскель

list2 = map (*2) $ filter (>5) list1К удобству.

Вообще идея всех этих многобуквенных кастов и была в том чтобы было не удобно и чтобы человек не бездумно писал (T*) и позволял языку вольно кастовать, а подумал пока печатает какой ему каст реально нужен и реально ли надо std::reinterptet_cast или static_cast пойдет лучше. Источник - траст ми бро Дизайн и эволюция С++.

Прочитал первою строку: std::reinterpreprepret_cast<T>( ) демонстрирует полное незнание темы. Дальше время тратить на чтение мнения эксперта не стал.

Про многобуквенность и `std::reinterpreprepret_cast<T>( ) `

Расскажу одну свою историю, мне кажется, она поучительная. Мир С, плюсов и даже асма мне знаком, но вот много лет назад я выбирал, куда развиваться, было два новых интересных молодых перспективных языка программирования. ruby и python. А еще, в те давние времена не было гитхаба (по крайней мере как нынешнего стандарта), зато был freshmeat.net - каталог опен-сорсного софта.

И я должен быть принять важное "инвестиционное" решение. Какой новый модный перспективный язык я буду изучать? Пайтон или руби? Я сделал поиск по проектам на каждом из языков и пришел к интересному выводу: На каждом из языков много разных интересных проектов. Каждый хорош, на каждом можно много что сделать. Но было существенное отличие: на пайтоне было больше "дурацких" проектов, некоммерческих, бессмысленных (по крайней мере в плане монетизации) - таких, которые люди писали явно просто так, для себя, для развлечения, по приколу. Вот у человека свободный день, он может пить пиво или гулять по парку - а он выбирает программировать какую-то фигню на пайтоне - просто потому что это приятно и прикольно! На руби таких проектов было гораздо меньше (по крайней мере, мне так показалось).

Я выбрал пайтон. Не жалею. Да, это удовольствие! Код легко читается и легко пишется. Даже вот то, что "тяжелые" фигурные скобки нужны гораздо реже (а их ведь надо с shift нажимать) - даже это - тоже добавляет плюсик. Мне кажется, python придумали люди, которые не желали отомстить всему миру.

За деньги - люди готовы на многое. Начиная от преступлений и интимных услуг на трассе и до программирования на плюсах и Java. Многие готовы писать код вида `std::reinterpreprepret_cast<T>( )` если им за это будут платить. Но кайф - это то, что ты делаешь, когда тебе НЕ платят, когда ты сам этого хочешь. И на мой взгляд, очень интересный и мозгорасширяющий вопрос - А хочешь ли ты программировать на этом языке сам, просто ради самого процесса? Приятно ли это?

Я просто хотел сказать следующее. Когда я смотрю на все вышеперечисленные вещи, я иногда не сдерживаюсь, и спрашиваю: ребята, да что же вообще творит Комитет?! Ведь это же настоящий — девки-бабы, а ну заткнули уши! — ХАОС.

А мне фанаты модерн-плюсов отвечают: да что случилось? Ничего же плохого не случилось! Всё хорошо, все в восхищении, гости в восхищении, королева в восхищении, а ты (ну, то есть я) идёшь в ж. Я уже начал думать: может, действительно, это со мной что-то не так? Может, это и правда красиво и выразительно, и не вызывает желания повеситься?

А потом Страуструп вдруг проговаривается: оказывается, разработчики такие плохие, что игнорируют это развитие за много-много лет. И не просто игнорируют, а ПОЛНОСТЬЮ.

Так а что вам не нравится в C++17?

std::optional? Который крайне удобен в выражении идеи отсутствия значения?

Нововведения типа copy-elision, которые просто гарантируют, что временные объекты оптимизируются и полностью обратно совместим?

Стринг-вью это поинтер+сайз, никаких сложностей. Инлайн с 17 плюсов имеет смысл, что можно нарушать ODR.

C++14 с мутабельными лямбдами, которые позволяют переносить контекст между вызовами функции. Шаред поинтеры?

Очередное упрощение написания темплейтов через require в C++20? Рэнжи, которые можно просто игнорировать, если не пишете в функциональном стиле?

Корутины пока нигде в реальных местах не видел, можно игнорировать?

Что не так то? О каком хаосе идет речь? Мы же не будем называть C++11 новым стандартом же да?

Расскажите о своем опыте, как то в среднем на хаос в современных плюсах жалуются люди, которые не смогли освоить reference вместо указателя в коде и вообще пишут на си с классами.

Так а что вам не нравится в C++17?

Позвольте мне:

std::optional? Который крайне удобен в выражении идеи отсутствия значения?

Отличная задумка, но не хватает нескольких базовых вещей: оператора or, метода flatten для преобразования optional<optional<T>> в optional<T>>, да даже банальный transform появился только в C++23.

Нововведения типа copy-elision, которые просто гарантируют, что временные объекты оптимизируются и полностью обратно совместим?

Претензий никаких, но забавно, что "самый быстрый язык с zero-cost abstractions" оказалось несложно ускорить.

C++14 с мутабельными лямбдами, которые позволяют переносить контекст между вызовами функции.

Отличная вещь, но некоторые лямбды нельзя вызывать больше одного раза, что к сожалению невыразимо в типе.

хаос в современных плюсах

Код современный до выхода нового стандарта. Если начал проект 8 лет назад, нужно постоянно ковыряться в старом коде, чтобы приводить его в приличный вид и использовать новые концепции, которые позволяют делать старые вещи шестым по счёту способом.

Отличная задумка, но не хватает нескольких базовых вещей: оператора or, метода flatten для преобразования optional<optional> в optional>, да даже банальный transform появился только в C++23.

Я думаю они в с++ не нужны. Подход с++ это if и early return. Другой подход имеет смысл только вместе с другими боле базовыми фичами языка

Нет, скорее потому, что даже эти примитивные стринги гениальные личности не юзают по религиозным соображениям, предпочитая выпендриваться с сырыми указателями. Если вы не сумели применить плюсы для решения задач, то ваши задачки не нуждаются в этом языке, но не нужно кричать о бесполезности)

Какие алгоритмы оформлены как классы? Насколько я знаю весь stl работает через методы. std::sort это вообще-то метод. О каких классах идёт речь вообще?

Касты многословные? Забахайте дефайн или используйте c-style каст. Но вообще, если вам нужно обильно мазать касты в своем коде - вы делаете что-то не так.

Разные типы стрингов... ну... так они для разных целей. UTF-16/32 строки прикажете как хранить? Как однобайтовую строку и в местах применения душиться на тему размеров? Из строки тривиально достается итератор и едет все все алгоритмы стл, вообще не понятно, какое не "ничего" вам от строк надо?

За что следовало бы пинать кресты, так это за зоопарк систем сборок и рокетсайенс подключения библиотек к проекту, а то, что написали вы это какая то вкусовщина.

std::sort это вообще-то метод.

std::sort это вообще-то функция. Методами в C++ называются функции - члены классов. Все алгоритмы в стандартной библиотеки являются функциями.

Совет про "забахать дефайн" и c-style cast в контексте обсуждения уменьшения выстрелов в ногу в 2024г прям как бальзам на душу. А вот с тем, что если в коде много кастов, то скорее всего что-то не так с проектированием, пожалуй соглашусь.

С одной стороны, да, а с другой... Подключаем две библиотеки на C, в одной строка - signed char*, в другой unsigned char*, а код у нас на C++. Пример почти сочинил, потому что проект был на C, но с очень хорошей строковой библиотекой. И вот тут особо ничего не сделаешь. Хотя да, в проекте "что-то не то", просто видно, что именно "не то" - разнобой с типами символов/строк, только в конкретном случае ничего сделать нельзя.

Все проще, достаточно использовать Windows API. И там будет много преобразований просто потому, что этот API такой по жизни. Одна обработка сообщений доставляет, когда LPARAM и WPARAM преобразуются к самым разным типам, от целочисленных до указателей на разные структуры.

Как сказал однажды Юрий Нестеренко: я в силах Кориолиса, конечно, не разбираюсь, но вот рядом стоит другой дом, и у него стены прямые.

Почему-то в C# есть один тип строк. Вы думаете, программисты на C# не работают с разными кодировками? Или им перфоманс не важен? Или только им нужен IndexOf(String, Int32, StringComparison)? (Поскольку вам «вообще не понятно, какое не "ничего" от строк надо», поясню: это поиск индекса вхождения подстроки с заданной позиции с явно заданным правилом применения культур-мультур). Нет. Это не так.

На практике это приводит к тому, что люди плюют и берут какой-нибудь QString, который делает что-то действительно полезное (хоть и меньше, чем BCL). Проблема в том, что QString не входит в стандарт языка. И когда потом они встречаются с разработчиками другого модуля, где используется какой-нибудь другой стринг, начинаются конверсии, а это приводит к тем самым ошибкам с памятью, про которые эта новость.

Вы можете называть это «вкусовщина», но это источник большой доли ошибок из упомянутых 70%.

QString берут кьютэшники потому что у них весь проект на них завязан.

Искать по подстроке с локалями это действительно сложный кейс и работа с локалями на стандартных плюсах действительно состоит из болей. Но визуально, внутри класса строки это не нужно, а нужно в виде внешней функции. Строка так то, контейнер.

В любом случае, ктют строки совместимы с стл алгоритмами и все умеют.

Но честно говоря я и с QT строками успел поесть, когда звал винапи который WCHAR* кушал.

Как всегда уперлись в то, что лучше делать хорошо, а не хорошо не делать.

П.С. расшифруйте BCL пожалуйста, я каменщик работаю 3 дня.

Почему-то в C# есть один тип строк.

Теперь голову ломают как вкорячить UTF-8.

программисты на C# не работают с разными кодировками?

Конвертациями в православный UTF-16 и сырым byte[], который валидной строкой быть не обязан.

В UTF-16 ничего православного нет. Это ошибка природы, историческое недоразумение.

А других не завезли, полноценная поддержка в языке только у него.

В каком таком языке? Для С/С++ в POSIX мире вполне естественным и стандартом де-факто является UTF-8, в библиотеках ничего переписывать не надо, просто работаем с однобайтовым char как обычно, в целом от ASCIIZ мало что отличается.

А для прям полноценной полноценности (сколько там букв-символов печатаемых в тексте подсчитать и т.п.) есть же всякие libunistring и т.д..

Теперь голову ломают как вкорячить UTF-8

Так методами же! Методами! В какой кодировке хотите строку обработать, тот метод и вызываете. Это же удобно, разве нет?

Не очень понимаю ваших страданий. Кто вам мешает использовать один любимый тип строк и конвертеры к нему, как в вашем любимом C#? На практике используют то, что будет удобнее конкретно для данного проекта. Не можете определиться? )

Кто вам мешает использовать один любимый тип строк и конвертеры к нему, как в вашем любимом C#?

Код, с которым приходится работать на крупных проектах, написан множеством разных команд в разное время. И они почему-то не использовали мой любимый тип строк. То же самое касается и сторонних библиотек, которые используются в проекте.

На практике используют то, что будет удобнее конкретно для данного проекта.

В этом то и проблема. Приходишь работать на новое место и начинаешь учить новые строки, списки, (умные) указатели, контейнеры внедрения зависимостей и так далее... вплоть до разбора xml и отправки почты.

p.s. Возможно, сейчас уже не всё так плохо - я не знаю.

UTF-16/32 строки прикажете как хранить?

Простите, а зачем их хранить в таком непотребном виде? Весь сознательный мир давным давно перешел на UTF-8, ничего лучшего уже никогда не будет. Все остальные древние кодировки сразу на входе (на входе внешних данных) должны быть к utf-8 через какой iconv() приведены, и приложение потом внутри ничем иным оперировать не должно, и выдавать тоже - только UTF-8. Ну ок, для каких Win32 API или RPC можно наверное API врапперов написать, но там просто конвертация на лету в байтовый массив на стеке, хранить это точно не надо.

Может, не стоило вместо List<>.Add() (как у нормальных людей) делать vector<>.push_back()? Может, не стоило алгоритмы оформлять как классы (!!!), вместо того, чтобы инкапсулировать как часть коллекций?

Какие забавные глупости. Что-то всерьёз комментировать тут - только портить.

А ведь 17 плюсов, я даже прикинул, что может быть накрутка от антиплюсового картеля, но быстро одумался.

Я как-то не понял, что это резво так все правительство США пришло С++ закапывать? Может грант какой под капотом можно распилить? Или разработчики раста стали очень уж рукопожатые?

Очень научно, Джерри.

может, не стоило вместо

List<>.Add()(как у нормальных людей) делатьvector<>.push_back()?

Ну, STL появилась в 94ом, а первая версия джавы с List<>.Add() - в 95ом, допустим.

от этого только больше вопросов как имея STL в качестве примера можно сделать такой ужас как List<>.Add()

А MFC появился в 1992-м. И там был и нормальный стринг, который умел всё, о чём только можно было мечтать в 92-м году, и .Add(). Правда, List там назывался CArray, но вот это комитет и мог бы пофиксить. Да и то, если выбирать между CT и T_t, я выбираю первое.

Что плохого, что язык не ограничен одним лишь решением? Напишите свой add

30 лет развития C++ - это когда вместо std::string doit(std::string param); нужно писать [[nodiscard]] constexpr auto doit(std::string_view param) noexcept -> std::string;

Неа, 30 лет назад все юзали using namespace std и получали нормальный человекочитаемый код

string doit(string param)

30 лет развития С++ это когда если вам не нужно, то вы можете продолжать писать std::string doit(std::string param); и оно будет работать не хуже чем 30 лет назад.

Да, конечно, зря я опустил вполне очевидное "если вы хотите писать на современном C++, отказавшись от устаревших практик", ведь это как раз то, о чём говорит Страуструп: пишите на современном С++, давайте компилятору больше информации для анализа кода.

Никакие современные практики не обязывают вас писать ничего из того, что вы там привели в пример.

Если вы хотите современный производительный код, писать-таки придётся.

Раскажите как nodiscard, constexpr и traling return влияют на производительность?

nodiscard позволит не оставить висячих вызовов функции, constexpr - перенести часть вычислений в компайлтайм (начиная с C++23 его имеет смысл ставить практически в каждой сигнатуре, синтаксический кошмар!). trailing return на производительность, конечно, не влияет в этом случае, но улучшает читабельность и вполне может понадобиться для консистентности стиля в проекте.

то есть никак

constexpr - перенести часть вычислений в компайлтайм

const propagation оптимизация работает и в си без всяких constexpr

Сообщите в комитет C++, что они что-то лишнее придумали.

Если вы не знаете что делает constexpr то следует ознакомится с документацией прежде чем писать чушь в комментариях. Заодно узнаете про consteval.

Я правильно понимаю, что вы утверждаете, что constexpr не является инструментом, потенциально позволяющим проводить часть вычислений в compile-time?

Ключевое слово "потенциально". Просто мазать constexpr везде смысла мало. Современный С++ даёт возможность специализировать поведение программы для разных данных через метапрограммирование и constexpr как его часть. Но для этого нужно писать соответсвующий код. Мы рассуждаем в контексте других языков, где таких возможностей попросту нет. Значит сравнивать надо с С++ кодом в котором так же эти возможности не задёствуются, и лишние кейворды вроде constexpr/noexcept не возникают.

Единственное, что там более-менее обозримо влияет на производительность это тип параметра, но дописать & или * можно было испокон веков. noexcept должен дать чуть меньший размер бинаря и, в теории, в исключительных случаях будет работать быстрее, но я не уверен, что эту прибавку можно будет измерить.

30 лет развития C++ - это когда вместо

std::string doit(std::string param);нужно писать[[nodiscard]] constexpr auto doit(std::string_view param) noexcept -> std::string;

Это надо зачитывать актёрам на репетиции «Ревизора» )))))))

Произнесенные слова поражают, как громом, всех. Звук изумления единодушно излетает из дамских уст; вся группа, вдруг переменивши положенье, остается в окаменении.

Немая сцена.

Когда я открываю проект на C#, я обычно вижу там обработку png, или генерацию веб-страниц, или ещё что-то полезно-прикладное. Но как ни открою проект на модерн-плюсах, так половина кода оказывается вот таким вот говном вещью в себе, нужной самой по себе и для себя. Потому что автор такой: смарите, посоны, как я могу!

Если играть в дурацкие игры, то можно и вдвоём: когда я открывают проект на C#, я обычно вижу там internal sealed partial class SuperClass : IInterfacable static public get set. Какая-то вещь в себе, нужная сама себе и для себя.

Вы правила игры неправильно понимаете. Я же не придумываю чушь поразвесистее (как вы), я просто показываю пальцем на реальный код, которым люди гордятся. Один пример выше. Другой пример: https://habr.com/ru/articles/798929/ https://web.archive.org/web/20240308160403/https://habr.com/ru/articles/798929/. (Это статья, как перебрать члены enum'а — раньше мы добавляли в конец enum'а Last, и всё, итерировались от 0 до Last, а теперь нам предлагается сорок бочек арестантов, и необходимость добавлять в enum не только Last, но и First). Это я из недавно прочитанного взял. Ещё? Я могу просто ткнуть по тегу C++, и набрать оттуда сколько угодно примеров с лютой упячкой. Половина статей как раз на эту тему: «смарите, посоны, как я могу!».

Вот и вы так же: возьмите не выдуманный код, а ткните пальцем в реальный. Для начала приведите, пожалуйста, хоть один реальный пример, а потом мы уже перейдём к их количеству.

Я же не придумываю чушь поразвесистее

Иронично, но я ничего не придумывал. Я буквально загуглил github c# projects, взял из выдачи "Trending C# repositories on GitHub today", тыкнул на самый первый DevToys-app, залез в src->app->dev->DevToys.Core и выбрал Settings как выглядящее нейтрально и понятно. Там есть несколько файлов исходников, откуда я это и вычитал. 20к+ звёзд, в трендах, реальный код, которым, уверен, создатели гордятся.

P.S. там ещё перед этой лапшой есть [Export(typeof(ISettingsProvider))], которое я сюда копировать не стал.

там ещё перед этой лапшой

Речь не о том, насколько понятен код незнакомому с языком. Речь о назначении кода. О том, какая его часть предназначена для решения стандартных задач (например, свой класс для строк), а какая для решения конкретной задачи, поставленной автору кода.

Например, я встречал успешных С++ программистов, которые принципиально не использую STL, потому что "там г. и можно написать лучше".

В этом и сила с++, что можно написать лучше. В с# жрешь то говно что дали.

Зато коллеги не охотятся за тобой с топором, а бывший работодатель не поминает коротким злобным словом.

Эм.. а что если там просто из коробки уже написано достаточно хорошо?

Но даже если и написано из коробки плохо, то все равно ничего не мешает написать свою реализацию, если так уж сильно нужно.

Если прям очень сильно нужно, то можно её написать с использованием unsafe кода.

Всё тоже самое применимо и к плюсам. Также как в шарпе все эти internal sealed partial class вместо class пишутся не просто по приколу, так и в плюсах все эти [[nodiscard]] constexpr noexcept пишутся не по тому, что кому-то стало скучно.

как vector<>.push_back() соотносится с проблемами утечек памяти? это просто более трудночитаемая и понимаемая конструкция шаблона. ваше фи - не по теме, хотя мнение имеет место быть.

по теме он сказал все правильно: используйте ссылку и тип автопоинтер вместо обычных поинтеров, применяйте raii (погуглите примеры кода, что это) где возможно - и будет вам безопасный код.

от себя добавлю еще пару вещей:

1) выделять и освобождать динамическую память для объектов нужно через паттерн проектирования фабрика или фабричный метод. они могут подсчитывать размер выделенной памяти и при своем закрытии сигнализировать об утечках, если что-то к этому моменту не успело освободиться. т.о. утечки памяти ловятся уже на этапе разработки. что предотвращает ошибки типа out of memory и исчерпание хендлов.

2)raii нужно использовать в том числе для механизмов блокировок в памяти. т.е. зашел в скоп программы - raii инициировала блокировку (если надо здесь). вышел из скопа - блокировка сама снялась.

3) пример ms показывает, как можно уйти от разных cast в с++. смотрите как работает метод iunknown.QueryInterface. он прекрасно работает на получение ссылок для разных интерфейсов (классов). нужные классы (в составе одного объекта) имеют динамическую типизацию и выгребаются по запросу с параметром типа.

ключевые слова - применение динамической типизации, которую так любят отключать компиляторы.

4) каждый метод должен проверять свои входяшие параметры. тогда не будет взрывов в тех методах, где exception не предусмотрены, в принципе. как пример - сейчас многие функции winapi генерируют исключения при неверных параметрах, вместо возвращения обычного hresult.

этих рекомендаций достаточно для того, чтобы иметь стабильный код. однако, зачем вникать в тонкости, когда можно перейти на rust... и оставить в коде все те же проблемы с дедлоками, о чем и сказал Страуструп. ну потому что rust проблемой блокировок не занимается😁

Погодите, но всем этим барахлом можно же не пользоваться!

Мне кажется, что Страуструп так и не осознал, что безопасность - это не когда легко можно сделать хорошо, а когда сложно сделать плохо. И не стоит с таким высокомерием судить об авторах предостережений, а лучше задуматься, что же всё же он сам делает не так.

C и C++ не зря ставят вместе - их объединяют из-за почти полной совместимости сверху вниз, каковая и предоставляет широкие возможности для стрельбы себе в ногу. Линтеры и статические анализаторы - это прекрасно, но даже если они настроены так, чтобы не пропускать небезопасные техники, нет никаких гарантий, что они применены - это опциональные инструменты, а значит - зачастую не будут использованы.

Современные синтаксические конструкции - это хорошо. Но надёжности не будет, пока устаревшие не станет невозможно или сложно использовать (например, если их придётся оборачивать блоком типа OBSOLETE_SYNTAXIS наподобие растовского unsafe). Я так вижу.

Мне кажется, что Страуструп так и не осознал, что безопасность - это не когда легко можно сделать хорошо, а когда сложно сделать плохо.

Золотые слова. Чтобы сделать безопасный C++, придётся сделать обратно несовместимый со всеми предыдущими реализациями язык. Но тогда зачем его называть C++, можно как-нибудь по-другому назвать, например C# или Rust

А можно назвать его как-нибудь типа safeC++. Которым он и будет являться.

А по-моему, безопасность языка заключается не в невозможности натворить много бед, а в вероятности. Например, возьмём сишечку 20 летней давности и любой "песочный" язык, например, ту же Яву. Ява, конечно, сознательно ограничивает именно сложностью низкоуровневой работы с памятью, но всё же получить уязвимость типа переполнения стека куда ниже, чем на первом - там указатели и массивы, и границы никак не проверяются, это программист должен внимательно следить и не тай пох ошибиться на единичку, чтобы в случайном сегменте затереть что-то критически важное. А ещё возьмём менее очевидные плюшки некоторых языков, такие как nullable types и иммутабельность - сначала кажется, что от этого не очень много выгоды, а потом оказывается, что программа реже падает, потому что мы загнали null/void туда, где его никогда не хотим видеть; а иммутабельность, хоть и повышает использование памяти, но в обмен получаем более целостное состояние. Тут, главное, не перестараться, а то вот создатели Явы однажды эпично попали с проверяемыми исключениями - или обработай или пробрось. Но это оказалось настолько утомительным, что много гениев просто оборачивали исключение пустым обработчиком, т.е. эффект получился обратным. Или вот совсем неочевидная штука, как отсутствие неявных кастов даже в случае расширения типов: тоже сначала кажется, что это излишне, но потом оказывается, что это оберегает от широкого класса ошибок. Тут же вспомню и отсутствие UB - тоже полезная штука, когда код работает всегда так, как написан, а не шаг влево, шаг вправо - и как повезёт, сначала всё хорошо, а потом рванёт. Да, сюда ещё хороши и встроенные средства работы в многопоточной среде, ибо без них и софт становится дырявым, и дебаг очень сложным занятием.

Т.е. безопасность - это не невозможность натворить бед, а помощь не натворить их на ровном месте. Чтобы или компилятор орал, что здесь что-то не так, или по коду сразу видно, где ошибка - без требования супервнимательности и спец.знаний о том, что делать так, как кажется логичным - нельзя. (из нелогичного можно вспомнить equals из джавы или switch case где обязательно надо ставить break) специальные знания - это, из той же джавы - volatile для корректной работы полей в многопоточной среде, или что самые известные коллекции потоконебезопасные, и нужно знать про потокобезопасные.

Так что безопасный язык предлагает соответствие предположений с реальностью и интуитивно читаемый код (т.е. чтобы ошибку можно было найти, пробежав глазами код, а не после суток непрерывного дебага). А также безопасный язык больше проверок берёт на себя, не заставляя программиста держать в голове знания о потенциальных засадах. И, например, пусть при нарушении границ программа сразу падает, а не тихонько натворит и продолжит работать.

С этой точки зрения небезопасны даже такие языки, как php, который, например, позволит работать с несуществующим файлом, попутно засирая лог (не так давно это был браузер); небезопасен и даже он же или javascript, оба позволяют неявно кастить почти что угодно, и потому получается, что "2"+2 это 22, а 2+"2" это 4 - форменное свинство.

А если я думаю, что я крутая и хочу напрямую работать с памятью - пусть язык не запрещает мне это делать, но и не требует (опять привет указатели), тут уже сама лезу.

А потому я вряд ли для обычного проекта выберу С/С++ - слишком утомительна необходимость быть ооочень внимательной в мелочах - безопасносные языки берут это на себя, и это хорошо.

Точно

Вот из-за таких непродуманных решений и невозможности переделать язык не сломав совместимость и не хочется писать на срр

Самый прикол, что плюсы и не требуют ни от кого работать с памятью, там давно есть весь набор, чтобы не делать этого вообще. О какой совместимости вы пишете, если стартуете новый проект?

Вы напомнили анекдот, которому лет уж точно больше, чем нам с вами.

Приходит Рабинович устраиваться на работу в советское учреждение. Начальник мнётся, мычит, в общем — видно, что не хочет брать (борьба с космополитизмом в разгаре), но и отказать неудобно.

— Да вы не переживайте так, я же русский на самом деле!

— У-у, ну тогда ступайте себе. С такой фамилией я уж лучше еврея возьму.

Если уж начинать новый безопасный проект, то зачем брать C++?

Ваш подход к выбору языков программирования, а особенно суждение и "безопасности" напоминает одну известную поговорку... Там про стеклянный предмет. Я бы спросил, как вы умудряетесь в плюсах без указателей руки порезать, но зачем )

Я бы спросил, что вы знаете о моём подходе к выбору языков программирования и откуда...

Если указатели не нужны, то зачем нужен C++?

"Если уж начинать новый безопасный проект, то зачем брать C++? "

Вот тут ваше суждение. Напоминаю, если забыли.

Ну и прекратите позориться уже своими познаниями. Представляете, в современных плюсах с динамической памятью работают БЕЗ указателей. Исключением пока что является Qt, где есть своеобразная сборка мусора.

Да, у плюсов куча минусов, но у кого их нет? )

Вы как-то очень странно читаете текст. Я разве где-то писал, что на C++ невозможно писать, не используя указатели? Наверное, можно, верю вам на слово. Но зачем? Без указателей можно и на других языках писать.

Да нормально читаю. Расшифровывайте свои мысли, если смысл отличается от очевидного. Вот ваш же текст

"Если указатели не нужны, то зачем нужен C++? "

Я предположил, что вы имеете ввиду вообще не работать с динамическим выделением памяти. Если нет, то похоже на какое-то извращение: хочу работать именно с указателями, а потом говорить, какой он небезопасный.

На ваше зачем есть контраргумент: а зачем на других, если можно на плюсах? )))

Язык выбирают исходя из специфики проекта, а не так, чтоб в резюме строчка покруче была )

Э-э... то есть по-вашему «указатели» равносильны «динамическому выделению памяти»? Это мягко говоря не так. Под словом «указатели» я понимаю именно указатели, а если вам в этом слове очевидно что-то другое, то тут я бессилен.

На ваше зачем есть контраргумент: а зачем на других, если можно на плюсах? )))

Ну в принципе да, аргумент принимается. Но знаете... я когда-то давно писал на плюсах, а вот на Java не написал ни строчки. Но когда я вижу какие-то примеры на современной версии C++ и на Java, то Java намного понятнее. Поэтому выбор C++ и кажется мне странным. Хотя Java тоже, мягко говоря, не идеальна.

Вы юзаете указатели без динамической памяти? Да вы интересная личность. )

Я несколько раз переписывал с явы на го, плюсах или шарпе. И во всех случаях понятность зависит прежде всего от того, кто писал проект, а не от языка. Если я на плюсах напишу завёрнутые шаблоны, да ещё и с SFINAE, да, никто код не разберёт. И это решают, медленно, но решают. Есть концепты, а вьюшки - так и вовсе фантастика. Проблема тут в том, что стандарт языка принимает комитет, а не какой-то один мейнтейнер.

По простоте и концепциям мне, например, очень нравится го. Но вот мне однажды понадобились ordered мапы... И там таких болей много. Но для своих целей отличный язык.

там давно есть весь набор

Да ну? Что прям и нормальный сборщик мусора "из коробки" имеется? Потокобезопасный и с графом, а не на подсчёте ссылок?

Дайте два!

Вроде в qt есть gc, но что там у него с безопасностью на потоках не вкурсе

Я не очень понял, зачем вам сборщик мусора при использовании стандартной библиотеки (буста, qt и тд). Где именно у вас мусор остаётся?

Вы про графы что-нибудь слышали?

Неужели специфика построения графов такова, что ведет к неконтролируемой генерации мусора?

Нет, это такова специфика тяп-ляп разработки. Никогда не знаешь где твой коллега оставил лишнюю ссылку и не замкнула ли эта неучтённая ссылка цикл из объектов.

Не всегда, далеко не всегда можно во время написания кода построить остовное дерево графа для будущих данных. Модель MVC как пример. Да и weak_ptr это костыль на обе ноги так-то.

В MVC как раз всё просто, и даже слабые ссылки не нужны: у V есть свой жизненный цикл, и в нём есть момент когда компонент уходит с экрана. В этот момент нужно отписаться от соответствующих M, что разорвёт ссылки от M к V.

Гораздо больше проблем возникает не в самой MVC, а внутри каждой из этих трёх букв. Особенно связи M -> M опасны.

А зачем вы делите MVC на слои? В памяти то у вас всё в одном клубке. Двусвязные отношения многие-ко-многим как между M, V и C, так и внутри них. Изменилась какая-то моделька, она должна оповестить все вьюхи, в которых отображается. А ещё в реальном софте обработчики у вас будут в отдельных потоках, и запускаться не только из вьюх.

Удачки тут построить и потом поддерживать spanning tree на этапе программирования.

В смысле - зачем? Зачем я делю MVC на M, V и C? Ну так в том же и суть паттерна, разве нет? Или вы вообще про что спрашиваете?

Изменилась какая-то моделька, она должна оповестить все вьюхи, в которых отображается.

Ну да. И это правильно, поскольку что отображаемые на экране вьюхи, что отображаемая в них модель совершенно точно живые и должны быть в памяти. А когда вьюха уйдёт с экрана - она должна отписаться от модели, что разорвёт любые циклы в которые эта вьюха входит.

она должна отписаться от модели

И если это была последняя вьюха, то вы приходите к печально знаменитому

delete this;

Я просто участвовал в большом проекте, где на подобных соплях всё было построено. Там не только M, V и C, там ещё бывают исключения с логгерами и т.д. и т.п.

Врагу не пожелаю отлаживать многопоток.

Э-э-э, зачем сразу delete this;-то? С чего бы вообще время жизни модели зависело не от количества ссылок на неё, а от количества подписок? Мы ж shared_ptr обсуждаем...

И в чём тут проблема с многопоточностью - тоже непонятно.

Потоки здесь при том, что shared_ptr не atomic, а даже если брать атомик версию, то он атомик только сам по себе, и более сложные изменения в модели без дополнительных приседаний он не чинит.

Циклы могут проходить не только через вьюху, но и через что угодно, контроллеры, БД, просто модели сами по себе могут иметь циклы. И инструментом для дерева, которым является shared_ptr, это не разруливается.

(На расте, если что, это специально сделано явно и очень больно. Раст - лучшая реклама gc, какую только можно придумать!)

Ну так я сразу же и написал, что связи M -> M - это да, это может быть больно. А вот любой цикл, проходящий через V, разорвётся когда этот V закроется (по крайней мере, должен разорваться при правильной реализации).

Да понятно что не сама БД, а коннектор к ней. Если он асинхронный или неблокирующий, то в нём могут быть указатели на ваши модели в процессе исполнения запросов.

Да-да, в каком-нибудь OLTP, OLAP или там в модном IoT соединение с БД закрыто или висит в пуле:)

А, я кажется понял. Не всем программам от БД нужен только CRUD. Бывают ещё всякие транзакции, хранимые процедуры и прочее. И пока транзакция не закоммичена, все участвующие в ней обьекты-модели "подвисают".

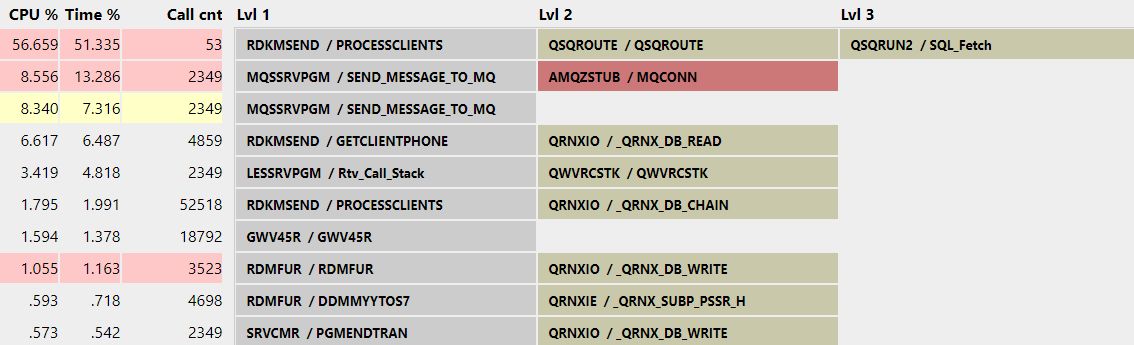

Ну мир не ограничивается только UI и отчетами. У нас вот >80% сводится к тому, что формируется поток данных (как правило, это выборка из БД в которой может быть десятки миллионов (и более) записей, каждая из которых обрабатывается в соответствии с бизнес-логикой задачи и уходит обратно в БД (так или иначе).

Что прям и нормальный сборщик мусора "из коробки" имеется?

А вот интересная тема про мусор и его сборку. И вот (когда в основном работаю с языками, работающими в виртуальных машинах - естественно, со сборкой):

Чем хороша и чем плоха идея уничтожать объект сразу, как только выполнение выйдет за пределы его объявления (выше, не ниже)? Обязательно ли, чтобы в довесок к основной программе прилагалась целая виртуальная машина, которая бы не сразу уничтожала объекты, а тогда, когда ей захочется?

п.с. идея создавать и вручную удалять объекты тоже так себе.

п.п.с.: о ручном управлении памятью, как вспомню, так вздрогну: хочешь создать новую сущность? сначала посчитай, сколько тебе потребуется памяти, выдели её, потом передай отдельно и начальный адрес (естественно, виртуальный) и отдельно (!) размер; при переполнении буфера случится либо затирание чего-то либо обрезание без намека на это - даже если есть намек на возврат значения сколько памяти надо было бы, это ещё самостоятельно проверять... это я уж не говорю, что надо уничтожить выделенный буфер - тогда, когда захочется, иначе , всё будет "хорошо", просто памяти становится всё меньше и всё работает медленнее. Да ну, нет! Просто, создали объект, внутри его обработали, дальше он уничтожается, если не был скопирован куда-то.

Вот чем плохо? Ато так и получаются программы, которым, а принципе, достаточно и условно 1Мб для работы, но постепенно для них и 64Гб становится мало... Ну и плюс, конечно, отдельная обслуживающая ВМ тоже хочет кушать.

Язык для проекта выбирается исходя из потребностей, включая наличие сторонних библиотек и возможностей интеграции с другими языками. Внимательность в мелочах требуется при использовании любого языка, если пишете что-то сложнее hw, ибо ни один язык не будет думать за вас. Исходя из ваших рассуждений, хотелось бы спросить, а когда вы юзали плюсы последний раз, что вам приходится работать с памятью напрямую? я почему-то не делаю этого уже очень давно

С этой точки зрения небезопасны даже такие языки, как php

А что значит "даже такие"? PHP, JS и С - это самые известные языки со слабой типизацией. Они все по определению небезопасны.

из нелогичного можно вспомнить equals из джавы или switch case где обязательно надо ставить break

Ну, тут вы загнули, конечно. Метод equals() нужен потому, что объекты нужно как-то сравнивать, а механизма перегрузки операторов в джаве не было отродясь. Если бы вы сказали про отсутствие этой перегрузки, я бы с вами согласился, а так – хороший инструмент в рамках правил самого языка(напоминаю, что оператор сравнения сравнивает объекты на эквивалентность, то бишь сравнивает хеши, а метод equals() сравнивает объекты так, как нужно вам).

Но вот насчет switch case и break я с вами соглашусь... но дело в том, что во многих сиподобных языках дело обстоит точно так же. Во всяком случае, в плюсах и си все идентично. Но даже так, в джаве есть альтернатива – вы можете вызвать лямбду в кейсе, и все будет работать. Если вы не поняли, о чем я, вот пример:

switch (param) { //стандартный вариант писать кейсы

case value:

//some code;

break;

}

switch (param) { //вариант через лямбды

case value -> {

//some code;

}

}Вот о чем я говорю. Хотя, я могу согласиться, что это неочевидно и требует знаний некоторых тонкостей языка, но я считаю, что это, внезапно, проблема не языка.

Это проблема учителей этого языка и программистов. Если они сразу начнут учить писать код по-новому, безопасно, а не пихая в голову нормы устаревшего си, то сюрприз, багов будет меньше, а код станет безопаснее.

Чтобы сделать безопасный C++, придётся сделать обратно несовместимый со всеми предыдущими реализациями язык. Но тогда зачем его называть C++

"Плюсстопиццот", как говорится.

Есть С. Кому-то он нужен. Где-то. Зачем-то. Оставьте его, не трогайте (ну по крайней мере то, что лежит в основе его идеологии)

Первые реализации С++ были как добавление объектности к С. "С с классами". Отлично. Кому-то это нравилось. В т.ч. и обратная совместимость с "чистым С" Оставьте, не трогайте.

А все эти "...цтать лет развития" выделите в отдельный язык. Забудьте про С и обратную с ним совместимость. Выкиньте все старое наследие и не мучайте себя и всех остальных.

Если вы строите сверхзвуковой реактивный самолет, не надо пытаться сохранить в нем поршневой двигатель и планер от биплана.

Выкиньте все старое наследие и не мучайте себя и всех остальных.

Это и произойдёт через какое-то время. Но прежде чем это произойдёт, новые подходы должны быть обкатаны, осознаны и пойти в массы. Старые подходы будут вызывать предупреждения, потом ошибки без специального режима компиляции или каких-то обвязок и так далее.

Но тогда зачем его называть C++, можно как-нибудь по-другому назвать, например C# или Rust

Так уже были попытки. D, Vala, Cyclone, C-- какой. Это все не взлетит даже по той простой причине, что просто некому допиливать VS Code и GDB/LLDB.

На самом же деле там нужно лишь немного доработать сам С++ (разрешить перегружать оператор точка и еще пару вещей), ну и заново реализовать всю библиотечную часть, и наступит счастье, никакой Rust и Swift будет не нужен.

C# не проходит кастинг по причине бельзальтернативности GC коллектора, да и там и так уже давно over 9000 базовых класов в Runtimе (40513 in 3.5SP1), их теперь остается только выбросить, жизни не хватит даже перечитать это API великолепие .

Пока вам кажется, я более чем уверен, что Страуструп осознал намного больше, чем неизвестный комментатор на Хабре. Весь этот опыт современных языков, якобы надёжных и безопасных, говорит о том, что они не работают. Есть программа, написанная в 2006 году, она стоит 3000$, она работает, она не падает, она работает в критически важной отрасли, соответствует стандартам безопасности, и ее ещё никто не взломал в 2024 году, поэтому она до сих пор стоит 3000$ и не валяется на Рутрекере. Написана она на древнющем c++ безо всяких ваших умных указателей и прочих финтов. Зато весь современный софт, написанный на расте или каком-нибудь голанге обновляется каждую неделю (ой мы тут подправили, тут убавили, мы обнаружили уязвимость, вот тут ускорили). Это я не сравниваю преимущества синтаксиса или системы сборки якобы более эффективного модернового япа. Сколько я не смотрел, на расте в 2024 году не решили проблему зависимостей при сборке(раз язык новый, современный, они учли весь негативный опыт прошлого)- я в языке 2024 года вообще не хочу зависимости, я хочу из коробки понятный синтаксис(потому что простота и ясность - это основа грамотных программ, не содержащих ошибки), и я не хочу думать как мне собрать программу и где шарить библиотеки(пусть всё уже будет в std, мне без разницы, сколько весит папка с компилятором 100мб или 10гб, я думаю это можно пережить в 2024 году) я хочу сделать rc program и радоваться жизни. Но всего этого, увы - нет.

Штаты тупо собрали статистику взломов, получили статистику по языкам исходных кодов модулей с уязвимостью, и поняли, что чинить дороже чем заново писать. Коммерческий выпуск ПО всегда имеет соблазн пренебречь безопасностью.

Но всего этого, увы - нет.

Как же я рад, что всего, что вы указали нет в Rust да и в других языках тоже.

Вот прям стало интересно, что это за программа за 3К и которую с 2006 еще не сломали? Какой-то уж очень специфичный софт?

Какой-нибудь модуль в CAD который нельзя скачать, не подписав NDA, поэтому и не сломали. Я часто слышу такое передёргивание. А вот чтобы развитие программы считали признаком отстойности - это впервые.

Это какое-то когнитивное искажение - мол, если не выходят обновления для программы, то в ней нет багов, а если обновления выходят часто - то программа полна багов.

Если программа работает так, как заявлено и без разных "побочных эффектов", то можно считать что в ней нет выявленных багов. В такой ситуации что-то в ней менять зачем? Добавить новые фичи? Да, если это надо. Если нет - то зачем трогать то, что работает?

Вот работаю в банке. Развитие ЦБС (центральных банковских систем - все, что работает на центральных серверах - АБС и т.п.). Есть куча программных модулей, которые работают по 5-10 лет уже. Они просто работают и исправно выполняют свои функции. И никто не станет их трогать просто так. Только или есть требуется изменение логики, или обнаружено нештатное поведение (дефект промсреды).

Что-то менять просто так очень дорого на mission critical уровне любое изменение кода требует полного цикла регресс-тестирования. А это время и ресурсы.

Есть куча программных модулей, которые работают по 5-10 лет уже. Они просто работают и исправно выполняют свои функции

Знаю. Работал с такими. И с таким программпм5, обычно, прилагается толстый документ ошибок и WA как их обходить.

И эти ошибки годами не правятся. Потому как на их наличие уже кто-то где-то завязался случайно и теперь это фича-баг.

И эти ошибки годами не правятся.

У нас нет. Любой дефект промсреды имеет приоритет над любой проектной задачей. Потому что его наличие очень дорого может обойтись банку во всех смыслах (прямые убытки, репутационные убытки, привлечение лишнего внимания регулятора с потенциальными штрафами и т.п.).

Так что никаких

толстый документ ошибок и WA как их обходить

тут нет. Или оно работает, или заводится дефект и вносятся исправления.

Так у вас и обновления выходят. А обсуждались-то священные неизменяемые артефакты из прошлого...

Человек пишет два утверждения:

1) Если проявляются дефекты, то они исправляются.

2) У них есть программные модули, которые работают 5-10 лет исправно.

Как эти два утверждения друг другу противоречат?

В системе работает несколько десятков тысяч программных объектов. Какие-то работают годами без изменений ("священные неизменяемые артефакты из прошлого"). Какие-то изменяются по необходимости (обнаружен дефект или потребовалось изменение бизнес-логики). Какие-то добавляются (появилась новая бизнес-логика, новые бизнес-процессы).

Там такая примерно логика: если не выходят обновления - значит программа идеально решает свою задачу, достигла пика идеальности и не требует улучшений. И не имеет критичных багов. Потому что обновления ведь не только из-за багов выходят, но из-за фич) Но мне кажется, что это очень странный способ оценивать качество приложения.

А не путаете "развитие" как появление новых фич с латанием дыр в том что уже есть?

Есть проекты с дорогой доставкой. Сколько времени занимает накатить патч на вашу банковскую программу, если делать всё по регламенту, включая тестирование?

Есть проекты с дешёвой доставкой. Условно какай-нибудь веб-сайт. Поменял, за 1 час проверил, за 5 минут накатил патч. Если плохо проверил, то не беда - сейчас быстренько всё исправим. В таких проектах новые фичи (большие и маленькие) могут быть каждую неделю и даже чаще.

Если в банке ошибка ПО - это ЧП, то в проектах другого типа может быть дешевле накатить и исправить, чем очень тщательно проверять.

Банк ещё ладно. А вот какие-нибудь умные лампочки с дырой в прошивке - тут часто дешевле купить новые лампочки, чем перепрошить старые.

Вы правы на 100%. Все упирается в цену ошибки. Или клиент не может на маркетплейсе зарядник для телефона купить, или у крупных корпоративных клиентов миллионы непойми куда уходят...

В нашем цикле (обобщенный случай)

Согласование бизнес-требований

Разработка архитектурного решения

Разработка ТЗ

Разработка кода

Компонентное тестирование

Бизнес-тестирование

Нагрузочное тестирование

Интеграционное тестирование

Внедрение

п.4 занимает (обычно) меньше всего времени (бывают исключения но не часто), а пп. 5-7 самые длительные и часто связаны с доработками и правками кода.

При этом ситуаций

Если плохо проверил, то не беда - сейчас быстренько всё исправим.

у нас не припомню. Да, бывают дефекты промсреды, но они вылезут нескоро и обычно связаны с какими-то сильно нестандартными и редко встречающимися ситуациями. А чаще всего это дефекты производительности промсреды - пока было 20млн клиентов все было хорошо, а когда их стало 50млн уже производительности стало нехватать и потребовалась оптимизация. Но тут годы могут пройти прежде чем вопрос встанет ребром.

Вам никто не мешает использовать rustc напрямую, скачав нужные зависимости вручную или по сишной привычке написав велосипеды, и использовать их без каких либо обновлений. Только зачем?

Вашу программу до сих пор не взломали только потому что она массово никому не нужна. А компаниям из критически важной отрасли очевидно проще её купить, чтобы по документам провести и поддержку какую-то получить на всякий случай.

Но от прямоты рук программистов тоже многое зависит. Поэтому сейчас, когда профессия программиста стала массовой, а кол-во хороших программистов особо не увеличилось, тем более неразумно использовать C++

Кто вам такое сказал, что она массово никому не нужна? Сами придумали?) Покупают ее не ради "по документам провести", а потому что от неё зависит бизнес, и она приносит деньги. За 10 лет работы разработчиком, я вижу сотни тысяч разрабов, которые почему-то со уверены, что бизнес не сможет без их CRM, систем управления персоналом, без веб-сайтов, без ещё какой-то кучи бесполезного софта. Если этот софт перестанет работать или исчезнет - бизнес это не заметит, где-то придется изменить привычный ход вещей, кому-то переучиться, но бизнес продолжит работать. А вот если сломаются те программы, о которых я говорил: всё, всё встанет. Это такие вещи как скады, системы автоматизации и диспетчеризации, скуд, видеонаблюдение, СУБД, контрольно-кассовое оборудование, системы строгой отчётности, кады и т.д. И этих прикладных областях никто не будет менять с++ на всякие модерновые язычки, потому что незачем. А весь тот софт, который я не перечислил, который пишется сегодня на самых новых япах, на последнем с++ - он постоянно обновляется, постоянно какая-то гонка, баги, фичи, фичи, баги, доработки. И оно нихрена не приносит деньги.

Кто вам такое сказал, что она массово никому не нужна?

Просто мы знакомы с анекдотом про неуловимого Джо

Да, бизнес постоянно платит кучу денег за фичи и багфикс в софте, который не нужен и не приносит денег, вот такие все дураки, а вы один очень умный.

Это невероятно, "сотни тысяч" это же в 4 порядках от населения земли.

Сколько из них одновременно являются программистами, писали хотя бы раз свою CRM и при этом считали что именно их CRM не заменима...

Как минимум

У вас на входе фильтр на повторяющиеся элементы не отрабатывает

И ... похоже вы встретились с каждым существующим программистом на земле

Но надёжности не будет, пока устаревшие не станет невозможно или сложно использовать (например, если их придётся оборачивать блоком типа OBSOLETE_SYNTAXIS наподобие растовского unsafe).

Но это будет не С++ уже. Плюсы и си до сих пор активно используются там, где важна скорость, а часто безопасность получается жертвованием скорости. В итоге получится ситуация когда половина использует Python2 preSafeC++ другая половина Python3 safeC++, никто не может определиться какая версия более правильная, две версии развиваются параллельно и вообще всё становится только хуже.

Мне кажется, с каждым годом ниша языков для "сделать быстрый код в ущерб корректности программы и скорости разработки" постепенно уменьшается. В 70-ых, когда делали Си, это было необходимым условием, потому что иначе программы просто не работали за разумное время.

Сейчас в моде "тяп-ляп и в продакшен", да и компиляторы других языков неплохо подтянулись. С другой стороны, программисты сейчас намного больше времени читают, отлаживают и поддерживают код, чем собственно пишут. Зачем в 2024 бороться с ошибками доступа к памяти, если можно взять другой язык и не бороться? Опять же процессоры давно суперскалярные, проверка индекса массива или там указателя на nullptr в большинстве случаев стоит примерно ничего.

Си ещё долго будет первым выбором для многих ниш по историческим причинам: драйверы там, всякие контроллеры и т.д. А вот ниша плюсов мне лично всё менее понятна.

с каждым годом ниша языков для "сделать быстрый код в ущерб корректности программы и скорости разработки" постепенно уменьшается

Но она все так же есть (я дочитал ваш коммент и вы не спорите :) ). Я за то чтобы для правильной работы использовать правильный инструмент - если для задачи не прям так критично важен перформанс и прямой доступ к памяти, то наверное городить туда С/С++ и не надо, но если нужен контроль над битами/байтами/регистрами и т.д. то safeC/C++ там и не взлетит, в итоге и будет мертворожденный язык (имхо конечно же), всякие ОС/геймдев/драйверописатели будут плеваться и использовать старый добрый unsafe C++, а там где этот сэйф С будет уместен, есть уже свои языки которые уже обкатаны. Ниша С++ это там где нужен С, но хотелось бы все таки классы для лучшей упорядоченности и вагон фишек из std (половина из которых будет выключена или забанена хех) - геймдев и рендеринг в частности например, всякие симуляции (строго говоря геймдев и есть симуляция), наверное чет еще есть..

Тут ещё такой момент есть. Старый софт не исчезает. Если была написана числодробилка на плюсах, то никто не будет писать её следующую версию на языке который даст просадку в перформансе на 10% даже если это будет новый крутой язык. Геймдев тут отличный пример: если новый язык не даст на том же железе как минимум тот же перформанс то никто не будет его использовать так как откат в производительности увидят клиенты и уйдут к тем кто продолжил грызть кактус. Вот и получается что там, где перформанс будет виден клиенту, нет выбора просто.

программируйте на васике. там песочница не позволяет выпасть в осадок.

с и с++ задумывались как системные языки программирования. ну то есть, никто не пишет драйвера и осе на асме, это очень трудоемко.

естественно, что там полно низкоуровневых и небезопасных фич. и нифига они не obsolete. на поинтерах, например, весь язык держится. вы помните как происходит возврат значения из процедуры в с++? либо по ссылке, либо через поинтер. ссылку в ооп далеко не везде удобно применять, а вот поинтеры - самый рабочий механизм. а вы его в obsolete. ну потому что - небезопасные.

любой серьезный проект предполагает некую дисциплину - как надо делать и как не надо. совершенно очевидно, что бардак начинается там, где не настроена такая дисциплина. называется она best practice. и, например, в том же мелкософте она не настроена. потому как winapi часто взрывается exception при передаче неверных параметров. банально функции winapi не проверяют правильность входящих параметров.

вот пример. не далее как вчера обнаружил неправильную работу одной функции работы с сертификатом. в первый вызов она считает необходимое к-во байт для выходного буфера, выделяю сколько надо, а второй раз -опять сообщает, что размера буфера не достаточно. курил долго. оказалось, что в нее был передан контейнер, в котором не было ключа. а почему бы не выдать ей ошибку - в контейнере нет ключа? нет, мы сразу ломимся в бой на непроверенных данных. оттого и размер плавал, что какая-то подфункция смотрела на мусор.

и за 20 лет ситуация не поменялась. чем поможет здесь переход на rust, если входные параметры и там ровно также не будут проверять?

чем поможет здесь переход на rust, если входные параметры и там ровно также не будут проверять?

Все еще интереснее. Когда Раст станет достаточно популярным среди "простых программистов", unsafe будут пихать по поводу и без повода, просто потому, что "компилятор без этого ругается". Так что массовый переход на Раст не изменит ничего.

с и с++ задумывались как системные языки программирования. ну то есть, никто не пишет драйвера и осе на асме, это очень трудоемко.

Это ключевой момент.

В принципе, любой ЯВУ в той или иной степени является специализированным. В том смысле, что изначально он задумывался для решения какого-то класса задач наилучшим образом. Ну так и стоит придерживаться начального замысла, а не пытаться "развивать" микроскоп в сторону придания ему свойств молотка чтобы удобнее было гвозди забивать.

Не смотря на все перечисленные Страуструпом отмазки "Около 70 % уязвимостей, которые Microsoft добавляет в каталог CVE, связаны с памятью. Microsoft Security Response Center"

А теперь взглянем с другой стороны, сколько было шуток что в 10/11 версии винды было много элементов из ХР и семёрки? А это ведь только видимый простому пользователю элемент интерфейса в настройках. Под капотом там до сих пор скорее всего куча Легаси кода на Си и плюсах 98го стандарта.

Продавать старое по цене нового - классика бизнеса, так то.

Ещё во времена win98 ходили шутки типа (восстановлено по памяти):

в процессе анализа исходных кодов windows 98, которые утекли из микрософт, были обнаружены следующие строки кода:

#include "msdos.h"

#include "win311.h"

#include "win95.h"

Самое главное там было

char make_program_look_big[10005000];

Под капотом там до сих пор скорее всего куча Легаси кода на Си и плюсах 98го стандарта.

И слава богу. Это отличный код, написанный умными людьми, вроде Dave Cutler, Lou Pezzoli, Mark Zbiowski, Landy Wang. Людьми, у которых в голове не понос, а мозги. Если бы не этот код, Microsoft бы вообще не было как компании.