Комментарии 271

Начну как всегда первый, специализируюсь на высоконагруженных проектах, облаке amazon(оно по сравнению с русскими облаками так редко падает), пмж в Тайланде.

+2

Как в Тайланде с доступом в сеть?

+2

Samsung Note 2 уже продают? А почём :)

+2

Что используете в качестве http балансеров в проектах? (Слышал что амазон может предоставить для этого)

+1

Nginx, haproxy, mysql proxy, varnish.

У amazon есть свой elastic load balancer, на нем можно сделать не сложную связку на несколько инстансов, автоматически поднимая и опуская их в зависимости от нагрузки.

У amazon есть свой elastic load balancer, на нем можно сделать не сложную связку на несколько инстансов, автоматически поднимая и опуская их в зависимости от нагрузки.

+1

а как реализовано НА?

heartbeat? или более мощные решения? pacemaker-corosync?

Я думал что высоконагруженные проекты используют специализированные железки.

heartbeat? или более мощные решения? pacemaker-corosync?

Я думал что высоконагруженные проекты используют специализированные железки.

+1

Использую hearbeat и corosync, иногда пишу самодельные решения, в амазоне как то это все не особо нужно, на уровне железа там HA уровнем ниже работает.

0

в том смысле что виртуалки не умирают просто так?

0

Для таких вещей, как reverse proxy, мне кажется стоит использовать keepalived. Возможно ли поднять подобное в EC2? Или это в принципе не возможно?

0

ec2 это обычные vps с linux или windows там можно поднять что угодно.

ну а keepalived как то не в тренде, всего один раз его встречал.

ну а keepalived как то не в тренде, всего один раз его встречал.

0

Про keepalived хорошо написал разработчик HAproxy: www.formilux.org/archives/haproxy/1003/3259.html

Если перевести коротко:

— heartbeat надо использовать, когда у вас требование «сервис доступен максимум на одном узле»

— keepalived надо использовать, когда «сервис доступен минимум на одном из узлов»

Если перевести коротко:

— heartbeat надо использовать, когда у вас требование «сервис доступен максимум на одном узле»

— keepalived надо использовать, когда «сервис доступен минимум на одном из узлов»

+1

Не вижу причин использовать keepalived вместо мейнстримного nginx.

Тут просто по цене не выгодно его использовать.

Тут просто по цене не выгодно его использовать.

0

Я не об этом. keepalived используют как раз для того, что бы nginx или haproxy был высокодоступен.

+1

Такой же функционал есть в nginx, так же будет проверять ноды и выключать умершие.

Или мне кажется я вас совсем не понимаю.

Как добавит keepalived высокодоступности для nginx и haproxy?

Или мне кажется я вас совсем не понимаю.

Как добавит keepalived высокодоступности для nginx и haproxy?

+1

Сам nginx является spof. И если он падает, то всё, что за ним, становится недоступным.

+1

А что становится с keepalived если он упадет?

0

keepalived работает там же, где и ngnix, т.е. если 2 сервера с nginx, то на обоих работает keepalived и следит, что бы как минимум за одним из серверов был закреплён определённый ip адрес.

+1

Ах у него функционал аналогичный hearbeat и corosync, тогда все понятно.

В рамках amazon cloud keepalived совершенно не интересен, так же как и hearbeat и corosync.

В рамках amazon cloud keepalived совершенно не интересен, так же как и hearbeat и corosync.

0

как nginx проверяет ноды на доступность?

+1

Напрямую и проверяет, шлет запрос если не отвечает то fail.

+1

а если апликейшн ответил 404? 500? 403?

0

Это нормальные ответы приложения, почему nginx должен failить такую ноду?

+1

Нуу…

Я думал что вы используете такую магическую штуку, которая позволяет nginx'у продвинуто loadbalanc'ить…

Эх, чудес не бывает

Я думал что вы используете такую магическую штуку, которая позволяет nginx'у продвинуто loadbalanc'ить…

Эх, чудес не бывает

0

ну как можно лоадбалансить по ответам 404 например?

Приведите пример реального балансера с магической штукой, очень интересно.

Elastic load balancer например просто запрашивает определенный адрес, который забиваешь вручную и по этому адресу всегда должен быть ответ 200, иначе нода помечается fail.

Я думаю также можно сделать и в nginx.

Приведите пример реального балансера с магической штукой, очень интересно.

Elastic load balancer например просто запрашивает определенный адрес, который забиваешь вручную и по этому адресу всегда должен быть ответ 200, иначе нода помечается fail.

Я думаю также можно сделать и в nginx.

+2

Всякие железячные балансеры.

citrix netscaler как пример.

citrix netscaler как пример.

0

Можете что-нибудь посоветовать на замену ELB? Нужно терминирование HTTP/HTTPS/TCP + LB на статическом IP. Пока приходит на ум только haproxy-dev + ручное/внешнее мигрирование ElasticIP на запасную vm в случае отказа основной.

Какой процент незапланированных отказов vm? Т.е. имеет ли смысл делать HA на уровне виртуалок, а не ограничиться нотификацией и ручным перебросом ElasticIP на другую виртуалку

Какой процент незапланированных отказов vm? Т.е. имеет ли смысл делать HA на уровне виртуалок, а не ограничиться нотификацией и ручным перебросом ElasticIP на другую виртуалку

0

Нет смысла, у меня крутится куча проектов в амазоне и пока что я не помню ни одного отказа по вине амазона, в глобальное падение амазона ни один мой проект не попал.

Основная идея делать HA это падение железа, в амазоне такого произойти не может, то есть у вас остается только софтовый уровень, но тут мне кажется если уж упало на одном сервере, то упадет и на другом точно таком же.

Основная идея делать HA это падение железа, в амазоне такого произойти не может, то есть у вас остается только софтовый уровень, но тут мне кажется если уж упало на одном сервере, то упадет и на другом точно таком же.

0

А если падение в масштабах AZ, что делаете в этом случае?

0

У меня такого не было, в целом у меня не такие крупные проекты чтобы они были готовы реализовывать такие вещи.

Есть у меня один проект, который рулится scalr и может развернуться в случае падения в ракспейсе или амазоне.

Я думаю если у проект достаточно тяжелый и у него есть деньги, настроить по мануалу доступность в нескольких AZ.

Есть у меня один проект, который рулится scalr и может развернуться в случае падения в ракспейсе или амазоне.

Я думаю если у проект достаточно тяжелый и у него есть деньги, настроить по мануалу доступность в нескольких AZ.

0

Приходилось ли использовать Route 53?

Насколько удобно использовать его для переключения сервиса между AZ, регионами?

Что используете для замены multicast?

Насколько удобно использовать его для переключения сервиса между AZ, регионами?

Что используете для замены multicast?

0

Использую просто как днс, в целом там все очень легко настраивается в веб интерфейсе для чекания и переключения.

Вопрос про мультикаст не понял.

Вопрос про мультикаст не понял.

0

Мультикаст используется для автоматического обнаружения узлов в сети. Например JBoss использует его для автоматического обнаружения других узлов кластера. В амазоне мультикаст выключен и приходится выделять сервер, который выступает в роли связующего.

Другой вариант — на этапе запуска определять какие уже узлы запущены и связываться с ними, но потом эту информацию надо обновлять периодически в приложении.

Используете ли вы что-то подобное?

Другой вариант — на этапе запуска определять какие уже узлы запущены и связываться с ними, но потом эту информацию надо обновлять периодически в приложении.

Используете ли вы что-то подобное?

0

1. Работали с DynamoDB? Выбираем между ней и собственной dynamo-like базой (Cassandra etc.) на ec2. Смущает стабильность Dynamo по latency и throughput. В описании сервиса обещают единицы милисекунд и до 10К read/write операций. Можете что-нибудь сказать о том, насколько это реальные цифры и насколько стабильные, бывают ли спайки по несколько секунд на запрос?

2. Из этой же задачи — насколько стабильна производительность дисковой подсистемы на ec2? Из документации aws.amazon.com/ec2/instance-types/ не очень понятно, что гарантируется. Меня уверяли что на High-Memory Quadruple Extra Large Instance видели деградацию дискового ввода-вывода до 10 операций в секунду — сталкивались с таким или меня обманули? Может производительность IO зависеть от того Reserved у нас инстанс или On Demand?

Заранее спасибо.

2. Из этой же задачи — насколько стабильна производительность дисковой подсистемы на ec2? Из документации aws.amazon.com/ec2/instance-types/ не очень понятно, что гарантируется. Меня уверяли что на High-Memory Quadruple Extra Large Instance видели деградацию дискового ввода-вывода до 10 операций в секунду — сталкивались с таким или меня обманули? Может производительность IO зависеть от того Reserved у нас инстанс или On Demand?

Заранее спасибо.

+1

1) Не встречал чтобы были такие задержки у людей с dinamodb, в целом оно очень производительное и хорошо скалится само внутри амазона.

2)Дисковая подсистема слабая у всех облаков, отсюда и всякие попытки ускорения с помощью собирания 10 рейдов из 8 ebs винтов. Ни разу не видел падения до 10 операций в секунду, больше похоже на миф, но сразу скажу что оно медленнее обычного винта, ещё точнее я сказал бы что производительность ebs стабильно не высокая, ни один проект у меня пока что не проседал по io. Сейчас есть возможность брать ebs на ssd дисках, очень быстрые и очень дорогие. Reserved instance это не реальный инстанс, это купон на скидку, даст вас скидку от 10 до 50 процентов на реальный инстанс в том же регионе, соответственно от него не может зависеть io диска.

Если вам нужно жесткая производительность винта то сначала пробуйте рейд из 8 дисков, если мало переходите на ebs из ssd дисков.

2)Дисковая подсистема слабая у всех облаков, отсюда и всякие попытки ускорения с помощью собирания 10 рейдов из 8 ebs винтов. Ни разу не видел падения до 10 операций в секунду, больше похоже на миф, но сразу скажу что оно медленнее обычного винта, ещё точнее я сказал бы что производительность ebs стабильно не высокая, ни один проект у меня пока что не проседал по io. Сейчас есть возможность брать ebs на ssd дисках, очень быстрые и очень дорогие. Reserved instance это не реальный инстанс, это купон на скидку, даст вас скидку от 10 до 50 процентов на реальный инстанс в том же регионе, соответственно от него не может зависеть io диска.

Если вам нужно жесткая производительность винта то сначала пробуйте рейд из 8 дисков, если мало переходите на ebs из ssd дисков.

+2

Спасибо за ценные подсказки, в сторону ebs raid и ebs on ssd обязательно посмотрю. Хочу еще спросить про instance storage — он есть у каждого инстанса и, по идее, если его хватает, ebs не нужен (если мы не хотим делать raid). Из той же странички описания следует, что на них ставят ssd с приличной производительностью. Можете прокомментировать? Или instance storage — это тот же ebs, приатаченный к инстансу по умолчанию?

0

Тот же ebs наверно, просто есть инстансы без диска, разворачиваются с образа, но на них нельзя хранить данные, то есть можно сделать образ с приложением своим и запускать без ebs диска, а данные например на другом интансе с ebs и mysql.

EBS это просто винт(sda и sdb и sdc в линуксе), сейчас у некоторых инстансов можно выбрать какой вы хотите ebs простой или highperfomance ssd. Так же если вы используете обычный ebs с увеличением типа инстанса повышается приоритет ваших io операций, то есть чем мощнее инстанс тем более производительным будет ваш io на обычно ebs.

Ebs на базе ssd появились буквально 3 месяца назад.

EBS это просто винт(sda и sdb и sdc в линуксе), сейчас у некоторых инстансов можно выбрать какой вы хотите ebs простой или highperfomance ssd. Так же если вы используете обычный ebs с увеличением типа инстанса повышается приоритет ваших io операций, то есть чем мощнее инстанс тем более производительным будет ваш io на обычно ebs.

Ebs на базе ssd появились буквально 3 месяца назад.

+1

Погуглил вопрос — stackoverflow.com/questions/3630506/benefits-of-ebs-vs-instance-store-and-vice-versa

Получается instance store != ebs и у каждого свои плюсы. IS должен быть быстрее ebs, особенно по лэтенси и точно дешевле ebs. Производительность и лэтенси должны быть стабильнее, т.к. сеть не задействована. Зато ebs надежнее и гибче, в том числе можно сделать рейд. Все это применимо и к ssd IS/EBS с поправкой на цену и скорость.

Поправьте, если я в чем-то катастрофически заблуждаюсь: )

Получается instance store != ebs и у каждого свои плюсы. IS должен быть быстрее ebs, особенно по лэтенси и точно дешевле ebs. Производительность и лэтенси должны быть стабильнее, т.к. сеть не задействована. Зато ebs надежнее и гибче, в том числе можно сделать рейд. Все это применимо и к ssd IS/EBS с поправкой на цену и скорость.

Поправьте, если я в чем-то катастрофически заблуждаюсь: )

0

Это разные вещи в целом, зачем вам что то писать на инстанс сторе? Все равно при перезагрузке ваш инстанс поднимется с образа и не сохранит ваши изменения на инстанс сторе.

0

зачем вам что то писать на инстанс сторе?

Это нужно, конечно, проверить, но выглядит так что на instance store можно получить лучшую лэтенси и более стабильную производительность — дешевле чем ebs raid, т.к. не надо ходить через сеть. Для моей задачи лэтенси достаточно критична, а то что инстанс может внезапно исчезнуть вместе со всеми данными в dynamo-like системах не страшно.

Это нужно, конечно, проверить, но выглядит так что на instance store можно получить лучшую лэтенси и более стабильную производительность — дешевле чем ebs raid, т.к. не надо ходить через сеть. Для моей задачи лэтенси достаточно критична, а то что инстанс может внезапно исчезнуть вместе со всеми данными в dynamo-like системах не страшно.

0

А не проще хранить все в памяти тогда?

0

Да, этот вариант тоже рассматривается: ) Это будет очень быстро, но со своими минусами: дороже, т. к. нужны инстансы с бОльшим объемом памяти; менее надежно, ведь падать может не только весь инстанс, но и сама база — нужно делать больше избыточности, опять дороже; нужно настраивать базу под работу в пямяти — возможно это и не сложно, пока не смотрел.

0

Помимо raid 10 на ebs посмотрите в сторону high i/o instances.

На них обещают бОльшую производительность io, чем на High-Memory Quadruple Extra Large Instance.

Про них можно почитать в конце странички: aws.amazon.com/ec2/instance-types/

Но сразу скажу: сам я с ними не работал, поэтому стоит почитать отзывы в интернете.

На них обещают бОльшую производительность io, чем на High-Memory Quadruple Extra Large Instance.

Про них можно почитать в конце странички: aws.amazon.com/ec2/instance-types/

Но сразу скажу: сам я с ними не работал, поэтому стоит почитать отзывы в интернете.

+1

Это ebs на базе ssd. Стоит просто нереальных денег пока что, наверно купить три сервера аналогичных в аренду выйдет дешевле в раз 10.

+1

Тут как говорится «вам шашечки или ехать?» :)

В контексте использования DynamoDB цены не такие уж и дорогие.

Стоимость динамо на 10к чтения и 1к записи будет примерно 2к$ в месяц. На ssd с mongo, мне кажется, можно добиться более высоких скоростей за меньшие деньги.

Есть ещё Cluster Computing инстансы, стоят в 2.5 раза меньше, чем High I/O. В них обычные ebs или тоже на базе ssd?

В контексте использования DynamoDB цены не такие уж и дорогие.

Стоимость динамо на 10к чтения и 1к записи будет примерно 2к$ в месяц. На ssd с mongo, мне кажется, можно добиться более высоких скоростей за меньшие деньги.

Есть ещё Cluster Computing инстансы, стоят в 2.5 раза меньше, чем High I/O. В них обычные ebs или тоже на базе ssd?

0

Я читал эту страничку, сам же на нее ссылался комментарием выше. На сколько я понял, High-Memory Quadruple Extra Large Instance относится к этим самым High I/O Instances (имеет пометку I/O Performance: High в описании). Возможно, проседания в производительности были еще до того, как на них стали ставить SSD. Тогда базу перевели на работу в памяти и больше не перепроверяли. Хорошая мысль, нужно будет посмотреть.

0

Нет, не относится. High I/O инстансы, о которых я говорил имеют пометку:

I/O Performance: Very High (10 Gigabit Ethernet).

+ про них отдельно написано, что они используют SSD.

P.S. Cluster Compute так же имеют Very High (10 Gigabit Ethernet) в описании, но SSD не используют.

I/O Performance: Very High (10 Gigabit Ethernet).

+ про них отдельно написано, что они используют SSD.

P.S. Cluster Compute так же имеют Very High (10 Gigabit Ethernet) в описании, но SSD не используют.

+1

Вопрос по Амазону.

Что лучше: использовать амазоновское NoSQL решение (Dynamo или Simple) или брать, к примеру, просто инстанс на основе официального AMI mongo из маркетплейса? Задачи какой-то конкретной пока нет — просто интересует, что выгоднее, проще, надежнее.

С elaticsearch не приходилось работать?

Что лучше: использовать амазоновское NoSQL решение (Dynamo или Simple) или брать, к примеру, просто инстанс на основе официального AMI mongo из маркетплейса? Задачи какой-то конкретной пока нет — просто интересует, что выгоднее, проще, надежнее.

С elaticsearch не приходилось работать?

0

1)Что вам ближе, динамо, rds и simple это такие обертки над типо монгами mysql и memcached.

2)Просто инстанс всегда дешевле.

3)Обертки местами удобнее.

4)Обертки нельзя кастомизировать по любому желанию.

5)Надежно все одинаково, на амазоне нет падений по железу(проц, винт, мать, память) для конечного пользователя.

6)Нет с поиском не работаю, использую интеграцию solr и sphinx/

2)Просто инстанс всегда дешевле.

3)Обертки местами удобнее.

4)Обертки нельзя кастомизировать по любому желанию.

5)Надежно все одинаково, на амазоне нет падений по железу(проц, винт, мать, память) для конечного пользователя.

6)Нет с поиском не работаю, использую интеграцию solr и sphinx/

0

XSLT — в основном в UMI CMS, но и так могу чего-нибудь полезного сказать

0

Виртуализация (XEN,KVM). VoIP (Asterisk,Cisco), Сети (уровень провайдера, динамическая маршрутизация, VPN, SLA и т.д.).

и немного Junos.

и немного Junos.

+3

Вот сижу мучаюсь с OpenVPN. На одном конце сервер на OpenWRT с сетью 192.168.0.0/24 на другом Android ICS с клиентом.

Никак не пойму что мешает соединению ибо нифига не смыслю в настройке iptables. Вот например где iptables хранит свои правила и как их посмотреть в консоли после ребута OpenWRT? Ещё забавный глюк — соединение по TCP устанавливается и практически сразу отваливается с Android, а на винде не отваливается, а по UDP вообще никак не соединяется :(

Никак не пойму что мешает соединению ибо нифига не смыслю в настройке iptables. Вот например где iptables хранит свои правила и как их посмотреть в консоли после ребута OpenWRT? Ещё забавный глюк — соединение по TCP устанавливается и практически сразу отваливается с Android, а на винде не отваливается, а по UDP вообще никак не соединяется :(

0

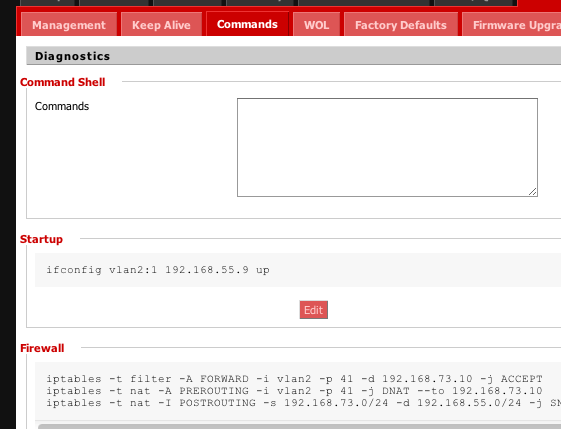

Надеюсь Android рутованый, иначе не поставить OpenVPN.

Про OpenWRT не скажу, а в dd-wrt правила пишутся в «команды при загрузке».

Вам бы подробнее описать всё, можно в личку.

Про OpenWRT не скажу, а в dd-wrt правила пишутся в «команды при загрузке».

см. картинку

Вам бы подробнее описать всё, можно в личку.

0

НЛО прилетело и опубликовало эту надпись здесь

Слышали, знаем.

Почитайте про него на форумах например, куча глюков.

Почитайте про него на форумах например, куча глюков.

0

Не согласен. Рут нужен для tap, мне достаточно tun, который вполне без рута работает. Подробности напишу в личку, потом решение опубликуем, если кому будет интересно.

0

В консоли посмотреть:

iptables -L -n -v

ну и по NAT

iptables -t nat -L -n -v

iptables -L -n -v

ну и по NAT

iptables -t nat -L -n -v

+1

Хочу на домашнем сервере развернуть гипервизор с несколькими виртуалками. Хочется что-то вроде одна виртуалка для разработки (LAMP, Postgres, git), другая с NAS, третья со всякой фигней типа mpd, vpn, торренты? Под NAS хочется полностью отдать 2 диска в md RAID1, другой диск отдать полностью под хранение разработки, и на четвертом нарезать LVM тома под ОСи для виртуалок.

1. Что удобнее с учетом вышеперечисленного?

2. Какие есть способы бэкапа виртуалок и сколько весят эти бэкапы?

1. Что удобнее с учетом вышеперечисленного?

2. Какие есть способы бэкапа виртуалок и сколько весят эти бэкапы?

0

В Вашем случае я бы посоветовал KVM.

Если дисковое пространство на LVM, то самое просто делать LVM-снапшоты.

Если отдаете реальные диски виртуалкам, то бекап делайте на ваше усмотрение, либо всего диска, либо файлов — это уж Вам решать.

Размер бекапов (снапшотов с LVM) идетничен размеру тома, но естественно Вы будете его сжимать (gzip, bzip2), и получите сокращение на 20-70% в среднем, в зависимости от заполненности тома.

Если дисковое пространство на LVM, то самое просто делать LVM-снапшоты.

Если отдаете реальные диски виртуалкам, то бекап делайте на ваше усмотрение, либо всего диска, либо файлов — это уж Вам решать.

Размер бекапов (снапшотов с LVM) идетничен размеру тома, но естественно Вы будете его сжимать (gzip, bzip2), и получите сокращение на 20-70% в среднем, в зависимости от заполненности тома.

+2

А спапшот виртуалки можно сделать? Чтобы я ловким движением руки, не запариваясь, восстановил как было. И сколько такое счастье будет весить?

0

Снапшоты относятся к LVM, про размер я выше написал.

Если это раздел на диске либо файл, то достаточно остановить виртуалку. скопировать раздел(файл), сжать. размер будет такой же как писал выше.

Для того что бы вернуть все «как было», опять таки, остановить виртуалку, востановить раздел (файл) из бекапа, и запустить.

Преимущество LVM со снапшотами, в том, что для бекапа, останавливать машину не надо, но для востановления остановить придеться.

Если это раздел на диске либо файл, то достаточно остановить виртуалку. скопировать раздел(файл), сжать. размер будет такой же как писал выше.

Для того что бы вернуть все «как было», опять таки, остановить виртуалку, востановить раздел (файл) из бекапа, и запустить.

Преимущество LVM со снапшотами, в том, что для бекапа, останавливать машину не надо, но для востановления остановить придеться.

+1

Если Вы про конфиг виртуалки, то это обычный текстовый файл, все настройки в нем, и он не весит практически ничего. Сама виртуалка размещена на разделе(файле, томе), и все остальное в нем.

+2

Я для домашнего сервера использую KVM виртуализацию.

1 — шлюз, куда отдана одна сетевушка и бридж в локальную сеть

2-7 — другие виртуалки

Виртуалки живут на 1ом софтварном рейде

Бекаплю… а не бекаплю, но сегодня точно сяду и настрою бакулу.

1 — шлюз, куда отдана одна сетевушка и бридж в локальную сеть

2-7 — другие виртуалки

Виртуалки живут на 1ом софтварном рейде

Бекаплю… а не бекаплю, но сегодня точно сяду и настрою бакулу.

+1

ESXi 5 бесплатный поставить можно, клиент только для управления под win.

0

поставить можно. только не у всех есть второй копьютер, куда можно поставить управляющую станцию, это надо помнить, т.к на ESXi из консоли можно поменять только пароль и IP адрес сетевого интерфейса.

0

Это да. Но у автора вопроса «Хочу на домашнем сервере развернуть гипервизор с несколькими виртуалками.» — ему подходит.

0

у меня «домашний сервер» — коробочка роутер с двумя юсб портами + юсб винт и резервный модем.

Но ESXi с нуля для дома достаточно сложно, плюс привязка к винде для станции управления.

Но ESXi с нуля для дома достаточно сложно, плюс привязка к винде для станции управления.

0

И второй вариант — 2008R2 с виртуалками на нём, если надо поставить что-то хитрое. Плюс в том, что я за ним работаю в консоли

0

Бесплатная система?

0

чисто 2008r2 — hyper-v сервер был в бесплатной редакции, но у него список ролей был ограничен, попробуйте

— wiki ru.wikipedia.org/wiki/Hyper-V — Отдельная версия Hyper-V Server является бесплатной. Она была выпущена 1 октября 2008. Является базовым («Server Core») вариантом Windows Server 2008, то есть включает в себя полную функциональность Hyper-V; прочие роли Windows 2008 Server отключены, также лимитированы службы Windows.

— вот ссылка, вроде.

— wiki ru.wikipedia.org/wiki/Hyper-V — Отдельная версия Hyper-V Server является бесплатной. Она была выпущена 1 октября 2008. Является базовым («Server Core») вариантом Windows Server 2008, то есть включает в себя полную функциональность Hyper-V; прочие роли Windows 2008 Server отключены, также лимитированы службы Windows.

— вот ссылка, вроде.

0

К сожалению, рабочие отношения с виндоус у меня не сложились, так что такой вариант отпадает.

0

Не думаю, что мне подойдет ESXi, но спасибо за совет.

0

Ну вообще-то Вы не совсем правы. Сейчас, на ESXi5 вполне можно даже включать-выключать некоторые сервисы типа SSH.

0

это сервис ssh для доступа к хост системе — всё делается через gui, практически

Порулить в ssh виртуалками может и можно, если нагуглите как :), это дольше отладочное подключение — логи посмотреть, например.

кстати, там vmware player у меня один раз упал, при запущенном vsphere, возможно оно через него частично работает

Порулить в ssh виртуалками может и можно, если нагуглите как :), это дольше отладочное подключение — логи посмотреть, например.

кстати, там vmware player у меня один раз упал, при запущенном vsphere, возможно оно через него частично работает

0

Добрый день.

Есть желание собрать дома полигон для экспериментов, т.к. играться с амазоном не всегда удобно.

Что можете посоветовать по железу в рамках 1к $?

Для организации storage планирую отдельный NAS. И тут ещё один вопрос: взять NAS типа QNAP TS-412

и использовать 2 массива RAID1 и RAID0 — один для хранения своих данных, второй для виртуалок, или взять тот же QNAP на 2 винта и пару винтов в сам сервер поставить?

За ранее извиняюсь за возможное ламерство, но с виртуализацией знаком пока только на уровне конечного пользователя.

Есть желание собрать дома полигон для экспериментов, т.к. играться с амазоном не всегда удобно.

Что можете посоветовать по железу в рамках 1к $?

Для организации storage планирую отдельный NAS. И тут ещё один вопрос: взять NAS типа QNAP TS-412

и использовать 2 массива RAID1 и RAID0 — один для хранения своих данных, второй для виртуалок, или взять тот же QNAP на 2 винта и пару винтов в сам сервер поставить?

За ранее извиняюсь за возможное ламерство, но с виртуализацией знаком пока только на уровне конечного пользователя.

0

Я даже представить себе не могу что Вам посоветовать по железу в рамках 1$к, ибо, наверняка мы с Вами в разных странах и цены совершенно разные. Если полигон для дома, то сильно переплачивать за железо не имеет смысла.

По поводу storage, если прикручивать NAS по сети, тормоза будут еще те. Если же есть возможность прикрутить по железным интерфейсам, тогда другое дело.

Лучше взять достойную мамку с поддержкой 6-8 винтов и железным рейдом, и собрать все в корпусе машины.

Это все я пишу исходя из «домашнего полигона».

На продакшн несколько раз использовал супермикро storage. Но это и по цене и по производительности совсем другое.

По поводу storage, если прикручивать NAS по сети, тормоза будут еще те. Если же есть возможность прикрутить по железным интерфейсам, тогда другое дело.

Лучше взять достойную мамку с поддержкой 6-8 винтов и железным рейдом, и собрать все в корпусе машины.

Это все я пишу исходя из «домашнего полигона».

На продакшн несколько раз использовал супермикро storage. Но это и по цене и по производительности совсем другое.

+1

Все домашние насы ужасны более чем, производительность по nfs и smb ниже плинтуса обычно, если в пределах 100 мегабит это ещё ничего, то на гигабите оно даже и рядом не упирается в сетевой интерфейс.

+1

НЛО прилетело и опубликовало эту надпись здесь

Что за пространственные типы данных в mysql?

Пример в студию пожалуйста.

Пример в студию пожалуйста.

-1

Почему выбран именно мускуль и в чем суть вашей задачи?

0

Расскажите по подробнее про то, что ещё осталось недопиленного. Его можно было бы использовать для создания вложенного меню. Например как попадает ли точка в область. Но из-за непонятной документации реализовать сие для тестов даже не вышло.

0

НЛО прилетело и опубликовало эту надпись здесь

НЛО прилетело и опубликовало эту надпись здесь

НЛО прилетело и опубликовало эту надпись здесь

НЛО прилетело и опубликовало эту надпись здесь

НЛО прилетело и опубликовало эту надпись здесь

Искать в самопересекающемся многоугольнике легко. Рисуем луч от тестируемой точки в любую сторону и проверяем, сколько раз она пересекла контур (будут проблемы, если луч прошел через вершину, но они легко обходятся). Если число пересечений четно — точка снаружи. Проблема возникнет, если пользователь решит нарисовать пятиконечную звезду — тогда центральный пятиугольник окажется вне области. Если и это неприемлемо, придется искать внешний контур (ищем все точки пересечения отрезков, строим плоский граф, и обходим его по правилу правой руки, начиная с самой левой точки). Но я бы остановился на варианте с четностью. Главное, не забыть про 180-й меридиан!

0

НЛО прилетело и опубликовало эту надпись здесь

Python под высокими нагрузками, tips and tricks. Cassandra как первичное хранилище данных.

+3

Ну и плюс к тому четыре года в Чехии.

+1

Как уехали в чехию?

По чем хорошее пиво в баре?

По чем хорошее пиво в баре?

+2

После универа нашёл здесь школу, которая учила чешскому. Язык учил некоторое время (около полугода), потом около полугода учился в Карловом университете и искал работу. Чуть меньше 3 лет работаю в чешской фирме Python/PHP программистом.

От 25-30 крон за кружку. То есть 1-1,5 евро. Или в районе 50 рублей, если я правильно помню курс.

От 25-30 крон за кружку. То есть 1-1,5 евро. Или в районе 50 рублей, если я правильно помню курс.

0

НЛО прилетело и опубликовало эту надпись здесь

Виртуализация Hyper-V, в том числе 2012, Powershell, MS SQL Server, Мониторинг (PRTG в частности).

+3

Разработка под iOS и OS X.

+2

Киньте примеры своих программ.

0

Чем лучше всего (и с наименьшим количеством зависимостей) автоматизировать Safari?

Пока самый приемлемый вариант — встроить его в приложение, что звучит как оверкилл.

Selenium работает, но как-то неуловимо через одно место (и аддон надо пересобирать).

Пока самый приемлемый вариант — встроить его в приложение, что звучит как оверкилл.

Selenium работает, но как-то неуловимо через одно место (и аддон надо пересобирать).

+1

Unity3d, tips and tricks

+2

Какие есть способы создать сервер для Unity не считая Photon'a?

Что например лучше всего использовать для синхронизируемого уровня на 3-5 человек?

Что например лучше всего использовать для синхронизируемого уровня на 3-5 человек?

+2

Есть вот такая табличка:

docs.google.com/spreadsheet/ccc?key=0AjZV0SdoOTsPdFVGQWxUWW9Fdmk2RzNfa3hUZU90V1E&hl=en_US#gid=0

В текущем проекте юзаем смартфокс для синхронизации 20 игроков в реалтайме. А вообще все зависит от конкретной задачи. Может вам и юнитевой сети хватит.

docs.google.com/spreadsheet/ccc?key=0AjZV0SdoOTsPdFVGQWxUWW9Fdmk2RzNfa3hUZU90V1E&hl=en_US#gid=0

В текущем проекте юзаем смартфокс для синхронизации 20 игроков в реалтайме. А вообще все зависит от конкретной задачи. Может вам и юнитевой сети хватит.

+2

Какие плохие моменты в юнитевской сети вы можете назвать?

+1

Юнитевая сеть хороша для игр, у которых сервак хостится на клиенте. Типа десматчи в контре, когда ты сам можешь поднять у себя сервак и резаться с друзьями.

Для всех остальных случаев, когда нужен полноценный сервер, с разделением по комнатам и т.д. и т.п, юнитевая сеть не приспособлена и вам придетс это все делать самому.

Кроме того, юнитевая сеть работает внутри билда юнити, и если вам не надо обслуживать физику на сервере, то билд юнити — это лишнаяя трата ресурсов.

На юнитевой сети нельзя сделать одновременно симуляцию физики для разных комнат-боев. Только для одного.

Для всех остальных случаев, когда нужен полноценный сервер, с разделением по комнатам и т.д. и т.п, юнитевая сеть не приспособлена и вам придетс это все делать самому.

Кроме того, юнитевая сеть работает внутри билда юнити, и если вам не надо обслуживать физику на сервере, то билд юнити — это лишнаяя трата ресурсов.

На юнитевой сети нельзя сделать одновременно симуляцию физики для разных комнат-боев. Только для одного.

+1

Как вы сказали для Unity'вой сити, один билд, одна комната по сути. Следовательно для n комнат, будет нужно n build'ов, что будет наверное очень немерянно потреблять ресурсы.

Но если прицепить NetworkView то объекты будут автоматически синхронизировать себя между всеми клиентами, в случае же использование SmartFox или Photon всю физику и положения объектов придется вручную обсчитывать на сервере, или же есть возможности упростить это?

p.s. У меня почему то не получилось запустить обсчет комнаты для headless build'a, наверное я что то делаю не так. Может есть какие нибудь особенности в реализации?

Но если прицепить NetworkView то объекты будут автоматически синхронизировать себя между всеми клиентами, в случае же использование SmartFox или Photon всю физику и положения объектов придется вручную обсчитывать на сервере, или же есть возможности упростить это?

p.s. У меня почему то не получилось запустить обсчет комнаты для headless build'a, наверное я что то делаю не так. Может есть какие нибудь особенности в реализации?

0

Следовательно для n комнат, будет нужно n build'ов, что будет наверное очень немерянно потреблять ресурсы.

Именно так.

Но если прицепить NetworkView то объекты будут автоматически синхронизировать себя между всеми клиентами, в случае же использование SmartFox или Photon всю физику и положения объектов придется вручную обсчитывать на сервере, или же есть возможности упростить это?

можно схитрить и на каждом клиенте держать свою физику. а нужные объекты синхронизировать.

p.s. У меня почему то не получилось запустить обсчет комнаты для headless build'a, наверное я что то делаю не так. Может есть какие нибудь особенности в реализации?

Ищите ошибку у себя. Сеть в хэдлесс режиме работает нормально.

Именно так.

Но если прицепить NetworkView то объекты будут автоматически синхронизировать себя между всеми клиентами, в случае же использование SmartFox или Photon всю физику и положения объектов придется вручную обсчитывать на сервере, или же есть возможности упростить это?

можно схитрить и на каждом клиенте держать свою физику. а нужные объекты синхронизировать.

p.s. У меня почему то не получилось запустить обсчет комнаты для headless build'a, наверное я что то делаю не так. Может есть какие нибудь особенности в реализации?

Ищите ошибку у себя. Сеть в хэдлесс режиме работает нормально.

0

Работаю в дирекции по обеспечению безопасности в крупном банке. За время работы приходилось разбираться с вопросами обеспечения безопасности системы ДБО, мошенничества с использованием пластиковых карточек, банкоматные мошенничества, эквайринг, интернет эквайринг, взаимодействие с органами при расследовании инцидентов, обеспечение внутренней информационной безопасности (контроль приложений, контроль аппаратуры.

Готов рассказать то, что не запрещено рассказывать. Если какие-то темы особенно заинтересуют — могу написать развернутый пост.

Готов рассказать то, что не запрещено рассказывать. Если какие-то темы особенно заинтересуют — могу написать развернутый пост.

+1

используете машинное обучение для детектирования аномалий, мошенничества и тому прочее, или только какие то свои эвристические алгоритмы?

+1

аномалий в чем именно?

Работа клиентов в системе ДБО фиксируется, логируется, анализируется в автоматическом режиме. Сами платежки анализируются как автоматически, так и вручную. Заявки на получение кредитов проверяются и вручную, и автоматически.

Правила для автоматических проверок меняются, оптимизируются, подстраиваются под новые виды угроз. Иногда полностью меняется ПО, которое занимается анализом той или иной системы.

Работа клиентов в системе ДБО фиксируется, логируется, анализируется в автоматическом режиме. Сами платежки анализируются как автоматически, так и вручную. Заявки на получение кредитов проверяются и вручную, и автоматически.

Правила для автоматических проверок меняются, оптимизируются, подстраиваются под новые виды угроз. Иногда полностью меняется ПО, которое занимается анализом той или иной системы.

+1

ну аномального поведения клиентов-держателей карт например, с целью выявления каких то «не стандартных» способов использования карт -)

вовово я именно про это, понятно что я не спрашиваю про софт (ведь это наверняка корп. тайна), интересно какие именно методы используются. как они автоматически подстраиваются, это какая то система которая сама выводит правила из логики, или есть ряд фич и используя какую то модель нелинейной оптимизации вы система адаптируется, ну или чисто сатистически, строятся распределения и выявляются сильно отклоняющиейся точки

я спрашиваю от того, что у меня какое то ощущение что область машинного обучения и ИИ в общем, у нас не сильно применяется в бизнесе, ну кроме таких компаний типа яндекса или мыл.ру

Правила для автоматических проверок меняются, оптимизируются, подстраиваются под новые виды угроз. Иногда полностью меняется ПО, которое занимается анализом той или иной системы.

вовово я именно про это, понятно что я не спрашиваю про софт (ведь это наверняка корп. тайна), интересно какие именно методы используются. как они автоматически подстраиваются, это какая то система которая сама выводит правила из логики, или есть ряд фич и используя какую то модель нелинейной оптимизации вы система адаптируется, ну или чисто сатистически, строятся распределения и выявляются сильно отклоняющиейся точки

я спрашиваю от того, что у меня какое то ощущение что область машинного обучения и ИИ в общем, у нас не сильно применяется в бизнесе, ну кроме таких компаний типа яндекса или мыл.ру

+1

Самообучение в таких системах не то, что в зачаточном состоянии, оно почти отсутствует. Никто не доверяет таким системам настолько, чтобы позволять ей самой придумывать новые правила. Необходимость введения нового правила долго обсуждается разными подразделениями, оценивается его необходимость. Когда это правило вводят, то его работу долгое время контролируют вручную. И лишь после успешного пройденного периода тестирования правило можно считать успешно введенным в эксплуатацию.

Так что система постоянно меняется, подстраивается под нужды бизнеса, но слепо ей доверять никто никогда не будет. Сначала все делается ручками и только потом аккуратно автоматизируется. Слишком дороги будут ошибки.

Так что система постоянно меняется, подстраивается под нужды бизнеса, но слепо ей доверять никто никогда не будет. Сначала все делается ручками и только потом аккуратно автоматизируется. Слишком дороги будут ошибки.

+2

а вообще разработки ведутся в этом направлении? существует ли в банках какой то отдел исследований? или покупаются готовые проверенные решения?

судя по зарубежным статьям (я не банковский работник, просто когда читаю какие то новые статьи по алгоритмам ИИ, бывает что авторы приводят примеры реального использования их наработок, и говорят про банки) они используют это очень даже активно

наверняка не автоматизируют принятие решений, но например исходя из статистики вообще, если находятся какие то очень редкие шаблоны поведения, вполне можно его ставить как кандидата для более тщательного ручного исследования

судя по зарубежным статьям (я не банковский работник, просто когда читаю какие то новые статьи по алгоритмам ИИ, бывает что авторы приводят примеры реального использования их наработок, и говорят про банки) они используют это очень даже активно

наверняка не автоматизируют принятие решений, но например исходя из статистики вообще, если находятся какие то очень редкие шаблоны поведения, вполне можно его ставить как кандидата для более тщательного ручного исследования

+1

Половина банков использует общепринятые решения, половина — собственные разработки. Причина в этом разделении в том, что ни те, ни другие программы до сих пор не спасают от мошенничества на должном уровне.

В банках не очень часто содержат штат хороших разработчиков. Чаще используют сторонние разработки. Если надо разработать что-то свое, то обычно покупается компания, производящая нечто похожее. Какими-то серьезными исследованиями в банках не занимаются. Исследуют обычно сторонние фирмы, которые хотят таким образом подороже продать свои услуги.

В банках не очень часто содержат штат хороших разработчиков. Чаще используют сторонние разработки. Если надо разработать что-то свое, то обычно покупается компания, производящая нечто похожее. Какими-то серьезными исследованиями в банках не занимаются. Исследуют обычно сторонние фирмы, которые хотят таким образом подороже продать свои услуги.

+1

Вы могли бы рассказать про методы авторизации в онлайн-банкингах? Какие методы авторизации надежнее (одноразовые пароли, смс-авторизация, аппаратные ключи, может еще что-то), какая у каждого из них отказоустойчивость? Я имею ввиду возможность возобновить работу при отсутствии под рукой ключа, или утрате списка паролей. Принято ли делать какой-то каскад методов с разной защищенностью?

+1

Способов много. Очень. Основной критерий — авторизация должна быть двухфакторной (как минимум):

1. что-то, что вы знаете/помните (логин-пароль);

2. что-то, чем вы владеете физически (токен, смска на телефон, скретч-карта с одноразовыми паролями...).

Ни один из этих способов не дает стопроцентной гарантии защищенности. Любую из имеющихся на данный момент защит можно обойти. Как правило, из-за безалаберности пользователя.

Давайте рассмотрим доступные средства защиты и то, как мошенники их обходят.

1. Логин-пароль.

Фишинговые сайты, подбор паролей, перехват пароля (атака man in the midle — несколько организаций сидят в одном бинес-центре и выходят в инет с одного роутера. Умный админ одной из контор ставит «правильную» прошивку на роутер...), кейлогеры и прочее, прочее, прочее…

2. Смс-пароль.

Злоумышленник получает дубликат симки и получает смску вместо вас. Когда вы замечаете, что ваш телефон не работает — уже, как правило, поздно. Как получить дубликат чужой симки — читай «Искусство обмана» К.Митника, применяй харизму, находчивость и шоколадку.

3. Скретч-карты с одноразовым паролем (это карточка, на которой много-много одноразовых паролей заклеены стираемой полосой). Пользователь видит сообщение «введите пароль №99», стирает защитный слой, вводит пароль. При следующей операции видит «введите пароль №98», стирает защитный слой, вводит пароль.

Злоумышленник запускает на компьютере жертвы вирус (что-то вроде прокси сервера на яве), встроенный прямо в браузер. Пользователь входит на сайт банка, сайт просит ввести пароль №99. Вирус перехватывает этот пароль, запоминает его и выводит пользователю сообщение «ошибка, введите пароль №98». Пользователь вводит и этот пароль. Далее вирус пускает пользователя в систему ДБО, скормив сайту пароль №99 (а 98-й пароль вирус помнит! и использует его для своих нужд). При любом действии пользователя вирус знает как минимум один следующий пароль.

То же самое с брелками, которые выводят одноразовые пароли.

4. Аппаратные ключи.

Тут все совсем просто. Пользователи обычно вставляют его в USB порт и больше никогда не вынимают. Злоумышленник запускает вирус (что-то вроде Radmin'a). Дожидается, когда пользователя не будет за компом и делает все, что надо.

5. Какое-то подобие аппаратного ключа с дисплеем — он выводит реквизиты платежки и на ее основании генерирует переменный код.

Тут все дело в внимательности. Кто из вас помнит свой номер счета наизусть? Узнаете его, увидев на экране? (на ввод переменного кода у вас всего 60 секунд).

Дело осложняется нетривиальными случаями: системой ДБО может пользоваться организация, а не физическое лицо. День зарплаты. Отправляется много платежек. Проверять их все на маленьком дисплее — убиться можно. Вводить переменный код на каждую платежку — дня не хватит. Получать смс — некоторые организации (маленькие магазинчики) находятся в подвалах, где сотовый не ловит.

Таким образом все банки понимают, что они не могут гарантировать стопроцентную безопасность своим клиентам. Они лишь могут быть чуть более безопасны, чем банки-конкуренты. Если есть банк, у которого нет всех этих защит, то его сломать будет проще и мошенники будут специализироваться именно на нем. Так что это игра в перетягивание одеяла.

В любом случае, мы своим клиентам рассказываем про самый идеальный и безопасный вариант — отдельный ноутбук, на котором файерволом закрыты подключения на все адреса кроме адреса банка. Операционкой стоит «невинда» (если софт конкретного банка и софт организации позволяет). В этот ноут не втыкаются флешки для «ой я тут фоток принесла, щас покажу». Ноут лежит в сейфе. С него только отправляются платежки в банк. Это не во всех организациях возможный вариант работы, но он наиболее труден для злоумышленников.

1. что-то, что вы знаете/помните (логин-пароль);

2. что-то, чем вы владеете физически (токен, смска на телефон, скретч-карта с одноразовыми паролями...).

Ни один из этих способов не дает стопроцентной гарантии защищенности. Любую из имеющихся на данный момент защит можно обойти. Как правило, из-за безалаберности пользователя.

Давайте рассмотрим доступные средства защиты и то, как мошенники их обходят.

1. Логин-пароль.

Фишинговые сайты, подбор паролей, перехват пароля (атака man in the midle — несколько организаций сидят в одном бинес-центре и выходят в инет с одного роутера. Умный админ одной из контор ставит «правильную» прошивку на роутер...), кейлогеры и прочее, прочее, прочее…

2. Смс-пароль.

Злоумышленник получает дубликат симки и получает смску вместо вас. Когда вы замечаете, что ваш телефон не работает — уже, как правило, поздно. Как получить дубликат чужой симки — читай «Искусство обмана» К.Митника, применяй харизму, находчивость и шоколадку.

3. Скретч-карты с одноразовым паролем (это карточка, на которой много-много одноразовых паролей заклеены стираемой полосой). Пользователь видит сообщение «введите пароль №99», стирает защитный слой, вводит пароль. При следующей операции видит «введите пароль №98», стирает защитный слой, вводит пароль.

Злоумышленник запускает на компьютере жертвы вирус (что-то вроде прокси сервера на яве), встроенный прямо в браузер. Пользователь входит на сайт банка, сайт просит ввести пароль №99. Вирус перехватывает этот пароль, запоминает его и выводит пользователю сообщение «ошибка, введите пароль №98». Пользователь вводит и этот пароль. Далее вирус пускает пользователя в систему ДБО, скормив сайту пароль №99 (а 98-й пароль вирус помнит! и использует его для своих нужд). При любом действии пользователя вирус знает как минимум один следующий пароль.

То же самое с брелками, которые выводят одноразовые пароли.

4. Аппаратные ключи.

Тут все совсем просто. Пользователи обычно вставляют его в USB порт и больше никогда не вынимают. Злоумышленник запускает вирус (что-то вроде Radmin'a). Дожидается, когда пользователя не будет за компом и делает все, что надо.

5. Какое-то подобие аппаратного ключа с дисплеем — он выводит реквизиты платежки и на ее основании генерирует переменный код.

Тут все дело в внимательности. Кто из вас помнит свой номер счета наизусть? Узнаете его, увидев на экране? (на ввод переменного кода у вас всего 60 секунд).

Дело осложняется нетривиальными случаями: системой ДБО может пользоваться организация, а не физическое лицо. День зарплаты. Отправляется много платежек. Проверять их все на маленьком дисплее — убиться можно. Вводить переменный код на каждую платежку — дня не хватит. Получать смс — некоторые организации (маленькие магазинчики) находятся в подвалах, где сотовый не ловит.

Таким образом все банки понимают, что они не могут гарантировать стопроцентную безопасность своим клиентам. Они лишь могут быть чуть более безопасны, чем банки-конкуренты. Если есть банк, у которого нет всех этих защит, то его сломать будет проще и мошенники будут специализироваться именно на нем. Так что это игра в перетягивание одеяла.

В любом случае, мы своим клиентам рассказываем про самый идеальный и безопасный вариант — отдельный ноутбук, на котором файерволом закрыты подключения на все адреса кроме адреса банка. Операционкой стоит «невинда» (если софт конкретного банка и софт организации позволяет). В этот ноут не втыкаются флешки для «ой я тут фоток принесла, щас покажу». Ноут лежит в сейфе. С него только отправляются платежки в банк. Это не во всех организациях возможный вариант работы, но он наиболее труден для злоумышленников.

+12

Спасибо за развернутый ответ!

А резервные методы доступа банками обычно создаются? Например — имеем основной метод авторизации по аппаратному ключу, какие действия в случае его утраты, приостановка работы с банковским аккаунтом до получения нового ключа?

А резервные методы доступа банками обычно создаются? Например — имеем основной метод авторизации по аппаратному ключу, какие действия в случае его утраты, приостановка работы с банковским аккаунтом до получения нового ключа?

+1

Его утрата — это инцидент безопасности. Ключ надо заблокировать как можно скорее. При звонке ключ замораживается (но ведь по телефону нельзя быть на сто процентов уверенным, что с банком говорит именно сотрудник фирмы). А потом клиент должен приехать в филиал и лично подтвердить, что факт утери имеет место быть, что ключ надо заблокировать. Рассказывает как потерял ключ, надо ли блокировать остальные ключи в организации (обычно ключ дают бухгалтеру и генеральному) и заказывает срочный перевыпуск ключа.

В качестве резервного доступа есть второй (третий ключ), по которому можно провести операции. Можно лично в бумажном виде принести платежки в банк и операционист их примет и обработает. В некоторых случаях можно подтверждать каждую операцию лично по телефону (это редко практикуется, возможно уже отменили).

В качестве резервного доступа есть второй (третий ключ), по которому можно провести операции. Можно лично в бумажном виде принести платежки в банк и операционист их примет и обработает. В некоторых случаях можно подтверждать каждую операцию лично по телефону (это редко практикуется, возможно уже отменили).

+1

Если у меня списали бабло с карты(провели покупку в магазине или в интернет магазине, без пинкода, скопировав карту или её данные), легко ли вернуть?

0

что можете рассказать про мошенничества с карточками и банкоматами?

0

Они случаются )

0

А если серьезно, то половина моих коллег не пользуется карточками вообще. Другая половина использует в повседневной жизни 2-3 карты. Плюс дома лежат еще штук 5-7. Они перевыпускают карты по несколько раз в год, постоянно пишут отказы от спорных операций.

Мошенники всегда были и всегда будут. Они ищут людей, которые либо ничего не знают о безопасности, либо просто невнимательные.

Иногда упор делается на пожилых и технически неподкованных кассиров в магазинах — их можно легко обмануть.

Иногда на бедных студентов-кассиров — они за небольшую сумму соглашаются копировать карты.

Иногда на проходимость какого-то места — можно поставить скимер на банкомат и за пару часов насобирать нужное количество данных о картах.

Мошенники всегда будут там, где деньги.

Мошенники всегда были и всегда будут. Они ищут людей, которые либо ничего не знают о безопасности, либо просто невнимательные.

Иногда упор делается на пожилых и технически неподкованных кассиров в магазинах — их можно легко обмануть.

Иногда на бедных студентов-кассиров — они за небольшую сумму соглашаются копировать карты.

Иногда на проходимость какого-то места — можно поставить скимер на банкомат и за пару часов насобирать нужное количество данных о картах.

Мошенники всегда будут там, где деньги.

0

Хм. У нас с женой 14 пластиковых карт 6 различных банков.

Я пользуюсь пластиком с 16 лет. И ни разу ни у меня, ни у жены никакого косяка с ними не было, кроме случая когда украли кошелек. Но потратив 5 минут на звонки в банки я не потерял ни копейки.

Пластик гораздо надежнее налички.

Я пользуюсь пластиком с 16 лет. И ни разу ни у меня, ни у жены никакого косяка с ними не было, кроме случая когда украли кошелек. Но потратив 5 минут на звонки в банки я не потерял ни копейки.

Пластик гораздо надежнее налички.

0

Лично у меня неприятность с картой была только однажды — дважды списали деньги по одной операции.

Но карты, как перчатки — каждая под определенную погоду. Для оплаты в интернете — карта помойка. На ней никогда не бывает денег. Надо что-то оплатить — положил на нее деньги и тут же оплатил товар в инете. Даже если данные по этой карте куда-то уйдут — вреда мне это не принесет.

Пара карт для оплаты в магазинах — с чипом и без. Разных банков. Разных платежных систем. Некоторые магазины бывают привередничают и «вот эти мы не принимаем».

Для поездок заграницу евровая карта.

Для зарплаты не важно какая — деньги с нее все равно через интернет-банк расходятся по другим картам. Зарплатная карта никогда не светится ни в магазинах, ни в интернете.

Сегодня оформил еще одну карту только потому что при ее оформлении дают бесплатно хорошую скидочную карту для покупок в Финляндии.

Еще есть карта, с которой списывается ипотека. Еще есть карта, у которой удобный интернет банк и на нее приятно получать переводы за разного рода мелкую работу.

Вот и получается, что карту, которую я сегодня оформил, я закрою через несколько месяцев (ну не нужна она мне). Карту, которую я возьму зимой в отпуск, я заблокирую еще в аэропорту как только вернусь (мало ли кто и где ее там мог скопировать). Следить за всем этим зоопарком, отслеживать тарифы, изменения условий обслуживания, вовремя продлевать или блокировать — нетривиальная задача для рядового человека. А для меня это часть работы — быть в курсе новых веяний, следить за основными тенденциями и конкурентами. Ну и в любой ситуации я всегда найду способ, как оплатить покупки ;)

Но карты, как перчатки — каждая под определенную погоду. Для оплаты в интернете — карта помойка. На ней никогда не бывает денег. Надо что-то оплатить — положил на нее деньги и тут же оплатил товар в инете. Даже если данные по этой карте куда-то уйдут — вреда мне это не принесет.

Пара карт для оплаты в магазинах — с чипом и без. Разных банков. Разных платежных систем. Некоторые магазины бывают привередничают и «вот эти мы не принимаем».

Для поездок заграницу евровая карта.

Для зарплаты не важно какая — деньги с нее все равно через интернет-банк расходятся по другим картам. Зарплатная карта никогда не светится ни в магазинах, ни в интернете.

Сегодня оформил еще одну карту только потому что при ее оформлении дают бесплатно хорошую скидочную карту для покупок в Финляндии.

Еще есть карта, с которой списывается ипотека. Еще есть карта, у которой удобный интернет банк и на нее приятно получать переводы за разного рода мелкую работу.

Вот и получается, что карту, которую я сегодня оформил, я закрою через несколько месяцев (ну не нужна она мне). Карту, которую я возьму зимой в отпуск, я заблокирую еще в аэропорту как только вернусь (мало ли кто и где ее там мог скопировать). Следить за всем этим зоопарком, отслеживать тарифы, изменения условий обслуживания, вовремя продлевать или блокировать — нетривиальная задача для рядового человека. А для меня это часть работы — быть в курсе новых веяний, следить за основными тенденциями и конкурентами. Ну и в любой ситуации я всегда найду способ, как оплатить покупки ;)

0

Какие-то системы или алгоритмы противодействия мошенничеству можете посоветовать?

0

1. Компьютерная графика и ее математика.

2. Архитектура КИС.

2. Архитектура КИС.

+1

Посоветуйте книжку/ресурс по КГ для начального уровня, чтобы относительно быстро изучить основные принципы.

0

А что конкретно интересует? Математика ее, или DirectX / OpenGL? В контексте gamedev?

0

Математика, пока без привязки к конкретным технологиям. Да, в контексте геймдева.

0

Виктор Порев — Компьютерная графика. Книга начального уровня. Опирается на наличие базовых знаний высшей математики, но и без того можно осилить.

Признаюсь, книга, по моим меркам не очень хорошая (хромает структура, последовательность и объяснения), но ничего лучше для начального уровня я не видел.

Признаюсь, книга, по моим меркам не очень хорошая (хромает структура, последовательность и объяснения), но ничего лучше для начального уровня я не видел.

+1

Работаю в компании, занимающейся оптимизацией роуминг бизнеса мобильных операторов. В частности предоставляем возможности по улучшения различных KPI в Wholesale/Retail областях. Могу более детально рассказать как «устроен» роуминг бизнес мобильных операторов, что такое ТАП файлы и какие основные процессы происходят для предоставления роуминга конечному абоненту и еще много деталей.

+1

Специалист по прикручиванию рельс в ДЦ :)

+3

А я всё равно спрошу. :-P

Есть древний корпус Supermicro, есть рельсы (неизвестного происхождения, раздвижные). Не сходятся отверстия для крепления. Сверлить в рельсах новые?

Есть древний корпус Supermicro, есть рельсы (неизвестного происхождения, раздвижные). Не сходятся отверстия для крепления. Сверлить в рельсах новые?

+2

А я подумал, что человек говорил о ruby on rails на продуктивных серверах)

+4

Как вариант. Важно только подобрать правильные болты чтобы шляпка была не слишком толстая и полозья в рельсы заходили. От морды на правильное расстояние полозья разметить, чтобы не вышло чтобы сервер не заходит 10см до конца упираясь в ограничители на рельсах из-за того что полозья очень далеко от морды отдалены. Ну и если толще одного юнита то не ошибиться с высотой раз рельсы не родные, что бы не получилось что сервер в стойке где то между юнитами окажется. Но вэ том случае уже сам корпус придется сверлить а не полозья.

+1

Файловые системы вцелом и в частностях UFS, NTFS, ZFS и более простые. Тонкие места и толстые преимущества под конкретные задачи. Вопросы надежности, совместимости и производительности. С удовольствием отвечу, только прошу без холиваров, т.к. тема весьма вызывающаяя.

Однако, сразу напомню себе и окружающим, «что на каждого мудреца довольно...»

Однако, сразу напомню себе и окружающим, «что на каждого мудреца довольно...»

+2

Что сейчас лучше выбирать xfs или ext4 на centos?

zfs на linux чего нибудь достиг?

zfs на linux чего нибудь достиг?

0

ZFS на linux достиг многого, однако всё ещё есть некоторые ограничения, с учётом которых это вполне можно использовать.

Подробно тут, кстати, если кто может дайте тому новичку из песочницы инвайт. Человек реально шарит и пишет хорошо. На CentOS обе ФС поддерживаются очень хорошо, выбор зависит от задачи.

Подробно тут, кстати, если кто может дайте тому новичку из песочницы инвайт. Человек реально шарит и пишет хорошо. На CentOS обе ФС поддерживаются очень хорошо, выбор зависит от задачи.

+2

Подскажите где лучше всего почитать про файловые системы вообще и про фс линукса в частности.

+1

Два бытовых вопроса:

1. Домашний сервер (веб, svn), он же NAS, он же медиаплеер (XBMC + ТВ). 2 жестких диска — 1Тб и 120Гб (системный). Ubuntu desktop x32. Как лучше разбить диски на разделы и какие файловые системы использовать?

2. Ноутбук. Жесткий диск 500Гб и SSD 24Гб. Windows и Ubuntu. По винде всё понятно, а по убунте аналогичный вопрос, что и в п.1

1. Домашний сервер (веб, svn), он же NAS, он же медиаплеер (XBMC + ТВ). 2 жестких диска — 1Тб и 120Гб (системный). Ubuntu desktop x32. Как лучше разбить диски на разделы и какие файловые системы использовать?

2. Ноутбук. Жесткий диск 500Гб и SSD 24Гб. Windows и Ubuntu. По винде всё понятно, а по убунте аналогичный вопрос, что и в п.1

+1

1. По серверу: Т.к. 2 очень разные задачи на одном железе не есть хорошо, то мой вам совет — веб, svn выселить в виртуалку и использовать там ту фс которая понравится вашей серверной ОС на виртуалке (если позволит железо и ресурсы) под эти задачи. Сам файл-образ же хранить на любой простой фс типа ext4 и регулярно бэкапить. В зависимости от силы удушения жабой можно организовать на больших дисках зеркальный рейд или просто rsync бэкап файлов редкого доступа типа фотовидео архива и прочего и подмонтировать это к вашей NAS-медиаплеер системе, а системный 120гб диск разбить на части в соответсвии с требованиями ОС и процессов, там будут находиться раздел swap и например рабочая папка из которой по факту окончания интенсивной записи файло скидывается на хранение на вышеописаное хранилище. Сам системный диск, соответсвенно тоже регулярно бэкапить туда для быстрого восстановления системы после его износа. Кстати если много оперативки, то износ можно снизить поместив разделы с интенсивной записью в RAM.

2. По ноутбуку, в зависимости от основной системы, вторую я бы поместил в виртуалку, но если всё же так необходим дуалбут с прямым доступом к железу, то делите SSD в соответсвии с требованиями OS и форматируйте не думая в родные NTFS/Ext4. Раздел SWAP при достатке RAM в общем может и не понадобиться, но если уж возникнет необходимость, то лучше его разместить на SSD, если же свопитесь очень активно, то лучше сохранить ресурс SSD и поместить своп на HDD. Большой диск оставьте в NTFS, т.к. иначе будете иметь проблемы с полноценным доступом к данным на нём из windows, да способы есть типа ex2fsd, но они уступают по скорости и надёжности FUSE решениям linux.

2. По ноутбуку, в зависимости от основной системы, вторую я бы поместил в виртуалку, но если всё же так необходим дуалбут с прямым доступом к железу, то делите SSD в соответсвии с требованиями OS и форматируйте не думая в родные NTFS/Ext4. Раздел SWAP при достатке RAM в общем может и не понадобиться, но если уж возникнет необходимость, то лучше его разместить на SSD, если же свопитесь очень активно, то лучше сохранить ресурс SSD и поместить своп на HDD. Большой диск оставьте в NTFS, т.к. иначе будете иметь проблемы с полноценным доступом к данным на нём из windows, да способы есть типа ex2fsd, но они уступают по скорости и надёжности FUSE решениям linux.

+3

Насколько сложно и насколько эффективно делать шифрование самой таблицы файлов, чтобы защитить данные от непрофессионального взломщика? Есть ли файловые системы, для которых этот метод эффективнее, чем для других?

0

Тут можно уйти в адовую демагогию. Давайте конкретизировать.

Моя позиция такова, что половинчатые меры, типа защиты от непрофессиональных взломщиков, — чушь по сути.

Защита либо устойчива против конкретного типа атаки, либо считай, что её нет. Шифрование таблицы файлов имеет единственный плюс против кучи минусов — быстро но не очень хорошо защитить большой объём данных. Сложности в этом особой нет, однако я не встречал конкретных реализаций данного подхода на практике. Общее понимание таково, что данный метод однозначно можно применить ко всем ФС от Microsoft за исключением надстройки EFS. Для таких систем как ZFS и BtrFS он просто неприменим. Остальные популярные файловые системы типа XFS, UFS/FFS, JFS и семейства Ext малопригодны для такого подхода, т.к. имеют сильно распределённую по тому структуру записей и суперблоков, проще уж шифровать всё уровнем ниже. В любом случае такой подход на мой взгляд малоэффективен — он не устоит даже против самых банальных программных средств восстановления данных.

P.S.: Вот старая, но полезная обзорная статейка на смежную тему.

Моя позиция такова, что половинчатые меры, типа защиты от непрофессиональных взломщиков, — чушь по сути.

Защита либо устойчива против конкретного типа атаки, либо считай, что её нет. Шифрование таблицы файлов имеет единственный плюс против кучи минусов — быстро но не очень хорошо защитить большой объём данных. Сложности в этом особой нет, однако я не встречал конкретных реализаций данного подхода на практике. Общее понимание таково, что данный метод однозначно можно применить ко всем ФС от Microsoft за исключением надстройки EFS. Для таких систем как ZFS и BtrFS он просто неприменим. Остальные популярные файловые системы типа XFS, UFS/FFS, JFS и семейства Ext малопригодны для такого подхода, т.к. имеют сильно распределённую по тому структуру записей и суперблоков, проще уж шифровать всё уровнем ниже. В любом случае такой подход на мой взгляд малоэффективен — он не устоит даже против самых банальных программных средств восстановления данных.

P.S.: Вот старая, но полезная обзорная статейка на смежную тему.

0

Team Foundation Server, кастомизация шаблонов для TFS

+1

Приветствую.

Я начинающий разработчик на C# (WPF, MVC4), в последней (2012) версии TFS бесплатен для 5 разработчиков.

Меня интересует как логически правильнее вести коллекцию проектов и как правильно назначать права доступа — давать себе же права доступа администратора коллекции для обычных commit'ов глупо и не очень безопасно.

И как на основе своего TFS организовать багтрекер для анонимных пользователей, без регистрации.

нескромный PS — а может есть желание что-то по этому поводу написать тут, на хабре?

Я начинающий разработчик на C# (WPF, MVC4), в последней (2012) версии TFS бесплатен для 5 разработчиков.

Меня интересует как логически правильнее вести коллекцию проектов и как правильно назначать права доступа — давать себе же права доступа администратора коллекции для обычных commit'ов глупо и не очень безопасно.

И как на основе своего TFS организовать багтрекер для анонимных пользователей, без регистрации.

нескромный PS — а может есть желание что-то по этому поводу написать тут, на хабре?

0

По поводу коллекции проектов — для небольших компаний можно рекомендовать иметь одну коллекцию проектов, особенно если речь идёт об Express версии.

В одной коллекции у Вас могут быть несколько TeamProject, со своими администраторами, своими шаблонами, административными группами и т.д. В одном TeamProject у Вас может быть несколько команд, несколько Solution, несколько веток (например, продуктивная, тестовая и ветка для разработки).

Назначать себе в TFS админские права доступа, если Вы совмещаете роль админа, — нормально. В подобных системах не применяется принцип Elevated privilegies. Впрочем, при большом желании, Вы можете использовать стандартный подход — выдать права админа учетке администратора, а работать под пользовательской учеткой. На мой взгляд, это излишне, а главное, займёт одну из 5 бесплатных лицензий.

По поводу лицензирования: TFS Express бесплатен для любых 5 пользователей, но имеет функциональные ограничения.

Обычная версия TFS также бесплатна, если у вас есть хоть одна Visual Studio с подпиской MSDN. К TFS могут бесплатно подключаться любое количество пользователи любой коммерческой версии Visual Studio (в них включена клиентская лицензия на TFS).

Также у обычного TFS есть возможность иметь группу пользователей, работающих через Web в режиме WorkItem Only View. Эти пользователи могут создавать дефекты (и любые другие типы WorkItem — задачи, требования и проч), следить за работой над ними, редактировать их. То есть, TFS можно использовать и для багтрекинга без коммерческих лицензий.

Анонимного доступа в TFS нет. Можете просто завести одну запись типа Guest и раздать пользователям пароль от неё, но лучше пусть каждый ходит под своей учеткой.

про статьи на хабре — посмотрите вот эти:

habrahabr.ru/post/143268/ — моя статья про планирование работ

habrahabr.ru/post/144162/ — не моя обзорная статья про TFS Express.

А ещё на msdn есть хорошие статьи про TFS, в том числе на русском языке.

В одной коллекции у Вас могут быть несколько TeamProject, со своими администраторами, своими шаблонами, административными группами и т.д. В одном TeamProject у Вас может быть несколько команд, несколько Solution, несколько веток (например, продуктивная, тестовая и ветка для разработки).

Назначать себе в TFS админские права доступа, если Вы совмещаете роль админа, — нормально. В подобных системах не применяется принцип Elevated privilegies. Впрочем, при большом желании, Вы можете использовать стандартный подход — выдать права админа учетке администратора, а работать под пользовательской учеткой. На мой взгляд, это излишне, а главное, займёт одну из 5 бесплатных лицензий.

По поводу лицензирования: TFS Express бесплатен для любых 5 пользователей, но имеет функциональные ограничения.

Обычная версия TFS также бесплатна, если у вас есть хоть одна Visual Studio с подпиской MSDN. К TFS могут бесплатно подключаться любое количество пользователи любой коммерческой версии Visual Studio (в них включена клиентская лицензия на TFS).

Также у обычного TFS есть возможность иметь группу пользователей, работающих через Web в режиме WorkItem Only View. Эти пользователи могут создавать дефекты (и любые другие типы WorkItem — задачи, требования и проч), следить за работой над ними, редактировать их. То есть, TFS можно использовать и для багтрекинга без коммерческих лицензий.

Анонимного доступа в TFS нет. Можете просто завести одну запись типа Guest и раздать пользователям пароль от неё, но лучше пусть каждый ходит под своей учеткой.

про статьи на хабре — посмотрите вот эти:

habrahabr.ru/post/143268/ — моя статья про планирование работ

habrahabr.ru/post/144162/ — не моя обзорная статья про TFS Express.

А ещё на msdn есть хорошие статьи про TFS, в том числе на русском языке.

+1

Да, ещё два варианта посмотрите — TFS в облаке, он же tfspreview.com — полнофункциональная, пока бесплатная версия.

codeplex — тоже построен на TFS, бесплатен, но проект должен быть OpenSource

codeplex — тоже построен на TFS, бесплатен, но проект должен быть OpenSource

0

Про оба проекта в курсе, спасибо.

Но меня больше интересовал сбор багов от любого анонимного пользователя средствами TFS…

Видимо придётся отдельно разворачивать багтрекер (есть такие под IIS, кстати?)

Но меня больше интересовал сбор багов от любого анонимного пользователя средствами TFS…

Видимо придётся отдельно разворачивать багтрекер (есть такие под IIS, кстати?)

0

Намного проще и удобнее всё-таки иметь баги тоже в TFS.

Это можно легко сделать двумя способами:

1. Завести гостевой аккаунт и сказать его пользователям. В шаблоне продумать, в каких состояних гость может изменять баг.

2. Сделать на IIS простую форму, которая публикуется для анонимного доступа, а в ней из кода создавать дефект в TFS. Вот есть пример, правда, под старую версию, но там изменений мало.

www.codeproject.com/Articles/14108/Web-Forms-for-Submitting-Issues-to-Team-Foundation

детали лицензирования и мелочи там уже устарели, а вот концепция правильная, на мой взгляд.

Это можно легко сделать двумя способами:

1. Завести гостевой аккаунт и сказать его пользователям. В шаблоне продумать, в каких состояних гость может изменять баг.

2. Сделать на IIS простую форму, которая публикуется для анонимного доступа, а в ней из кода создавать дефект в TFS. Вот есть пример, правда, под старую версию, но там изменений мало.

www.codeproject.com/Articles/14108/Web-Forms-for-Submitting-Issues-to-Team-Foundation

детали лицензирования и мелочи там уже устарели, а вот концепция правильная, на мой взгляд.

+1

Много лет работаю с Drupal.

+2

LMS, дистанционное обучение, выбор инструмента для проведения вебинаров.

+1

Что нынче можно использовать для вебинаров? Платно или бесплатно?

0

Самые популярные Webex и Adobe Presenter. На западном рынке также заслуженно пользуются популярностью Saba Centra и AT&T Interwise за свою стабильность и простоту. Есть ещё очень популярный в США Citrix, который лично я недолюбливаю из-за странного звука и неудобного интерфейса.

Бесплатно или платно, зависит от ваших нужд и количества участников. Webex, например, позволяет бесплатно использоваться виртульный класс для 1 ведущего + 3 слушателей. Кроме того, если требований особых нет и не планируете показывать презентацию, всегда можно воспользоваться бесплатными Skype или Google Hangouts.

Выбор инструмента должен опираться на ваши задачи. Сам я пользуюсь в основном Saba Centra и Webex, в зависимости от поставленных задач. Первая расчитана больше на интерактивность, вторая лучше работает с видео.

Российские представители сервисов (COMDI и Webinar.ru) имеют более высокие тарифы, чем конкуренты. С чем это связанно мне тяжело сказать. С российскими сервисами не особо знаком, пользовался пару раз и каких-то особых впечатлений они не вызвали.

Будут ещё вопросы по теме — пишите.

Бесплатно или платно, зависит от ваших нужд и количества участников. Webex, например, позволяет бесплатно использоваться виртульный класс для 1 ведущего + 3 слушателей. Кроме того, если требований особых нет и не планируете показывать презентацию, всегда можно воспользоваться бесплатными Skype или Google Hangouts.

Выбор инструмента должен опираться на ваши задачи. Сам я пользуюсь в основном Saba Centra и Webex, в зависимости от поставленных задач. Первая расчитана больше на интерактивность, вторая лучше работает с видео.

Российские представители сервисов (COMDI и Webinar.ru) имеют более высокие тарифы, чем конкуренты. С чем это связанно мне тяжело сказать. С российскими сервисами не особо знаком, пользовался пару раз и каких-то особых впечатлений они не вызвали.

Будут ещё вопросы по теме — пишите.

0

BPEL, BPMN, учеба на магистра в Европе

+1

Платежные системы Visa/MasterCard. Пластиковые карты, эквайринг. Как с технической точки зрения, так и с потребительской.

+3

1. Что нужно предприятию/интернет-магазину для того, чтобы принимать платежи (если руководство не хочет сторонние сервисы) с карт пользователей?

2. Какие сторонние сервисы стоит использовать? Есть ли отечественные аналоги забугорных сервисов по организации платежей с карт?

3. В чем принципиальное отличие Visa от MasterCard? Встречал не раз различие комиссий при платежах разными типами карт — с чем это всязано?

2. Какие сторонние сервисы стоит использовать? Есть ли отечественные аналоги забугорных сервисов по организации платежей с карт?

3. В чем принципиальное отличие Visa от MasterCard? Встречал не раз различие комиссий при платежах разными типами карт — с чем это всязано?

+2

По первому вопросу:

1. Выбрать банк. Уровень сервиса и качество обслуживания почти везде одинаковые, так что смотрите только на проценты. Ну и еще возьмется ли за вас банк. Некоторые не хотят заниматься предприятиями с низкими оборотами. Для интернет-эквайринга стандартно около 2.5%, но если поискать можно и на 2% найти.

2. Созвониться с менеджером, получить список документов. Обычно не так много — документы гендира, документы на ООО/ИП, иногда требуют на помещение)

3. Собрать документы и отдать.

4. Дальше проходят внутренние банковские проверки и операции. После чего можно будет интегрировать.

По подводным камням:

Нельзя устанавливать доп.плату в клиента если он оплачивает картой. Нельзя сохранять какие-либо платежные данные клиента. Лучше если банк проходит сертификацию PCI DSS.

По второму вопросу затрудняюсь ответить, т.к. работаю только с банками. Да и не сторонник сторонних сервисов — процент у них выше.

3. Принципиально — никакого. Сейчас уже принимают и те и дургие все сервисы и банки. American Express — только через банк Русский Стандарт.

Отличают немного правила систем, но больше в части мелочей и при инцидентах. К примеру Визу при конфискации надо разрезать вдоль магнитной полосу, а мастер — поперек.

Комиссии различаются скорее всего из-за различий в договоренностях между банком и ПС.

Вообще банк львиную долю комиссии(а иногда и больше) отдает ПС. Так что если у какого-то банка индивидуальные договоренности с ПС и ему интерчейндж(комиссия отдаваемая банком плат. системе) ниже, то он может и клиентам снизить.

Для справки: Интерчендж зависит от того кто банк-эквайер, в какой стране находится, кто банк-эмитент, из какой страны эмитент, статус карточки.

Самый высокий интерчейндж, ЕМНИП, когда в твоем терминале проводят картой виза платинум американского банка — около 6%.

1. Выбрать банк. Уровень сервиса и качество обслуживания почти везде одинаковые, так что смотрите только на проценты. Ну и еще возьмется ли за вас банк. Некоторые не хотят заниматься предприятиями с низкими оборотами. Для интернет-эквайринга стандартно около 2.5%, но если поискать можно и на 2% найти.

2. Созвониться с менеджером, получить список документов. Обычно не так много — документы гендира, документы на ООО/ИП, иногда требуют на помещение)

3. Собрать документы и отдать.

4. Дальше проходят внутренние банковские проверки и операции. После чего можно будет интегрировать.

По подводным камням:

Нельзя устанавливать доп.плату в клиента если он оплачивает картой. Нельзя сохранять какие-либо платежные данные клиента. Лучше если банк проходит сертификацию PCI DSS.

По второму вопросу затрудняюсь ответить, т.к. работаю только с банками. Да и не сторонник сторонних сервисов — процент у них выше.

3. Принципиально — никакого. Сейчас уже принимают и те и дургие все сервисы и банки. American Express — только через банк Русский Стандарт.

Отличают немного правила систем, но больше в части мелочей и при инцидентах. К примеру Визу при конфискации надо разрезать вдоль магнитной полосу, а мастер — поперек.

Комиссии различаются скорее всего из-за различий в договоренностях между банком и ПС.