Само по себе понятие виртуализации существует уже 50-60 лет. Еще в 60-х годах прошлого столетия этим вопросом занималась компания IBM. Однако, на тот момент виртуализация не нашла достаточного использования в существующих технологиях, поскольку компьютеров было немного и они всегда использовались под завязку. После появления персональных компьютеров в 80-х годах ситуация в корне не изменилась, поскольку идея заключалась в запуске всего лишь одной программы на одном устройстве, и поэтому использование ресурсов было очень низким. Всех это долгое время устраивало вплоть до наступления энергетического кризиса, когда цена на электроэнергию возросла по всему миру. Как следствие, возник вопрос экономии ресурсов.

В 1999 году компания VMware впервые виртуализировала компьютер на базе Intel: на одном аппарате было запущено несколько операционных систем и, соответственно, несколько приложений. При этом затраты электроэнергии распределялись на несколько операционных систем уже на одном комплекте аппаратного обеспечения, что позволило рационализировать нагрузку.

Как всё это работает? Между сервером и операционными системами есть тонкий слой программного обеспечения для виртуализации или же на сервере устанавливается ОС, на которую накладывается уровень виртуализации.

Задачей виртуализации является введение в заблуждение ОС, чтобы она идентифицировала её как собственное аппаратное обеспечение. Подобные хитрости необходимы из-за слишком большого количества приложений, созданных под конкретную ОС. Таким образом виртуальная машина имеет ряд преимуществ, таких как инкапсуляция, изоляция отдельного приложения, совмещение его с ОС и другими программами, и при этом создаётся некая независимость аппаратного обеспечения. Рассмотрим эти компоненты по-отдельности.

Инкапсуляция — это сбор данных или функций в единый компонент. Создаётся программа, которая маскируется под отдельную физическую машину, выполняющую все свои функции. И ОС вместо того, чтобы идентифицировать набор различных устройств, на самом деле видит набор разных файлов.

Изоляция означает, что все приложения, работая на одном устройстве, работают независимо друг от друга, идентифицируя себя, как разные устройства. В результате, если зависает или падает одна ОС, это никак не влияет на работу других ОС и приложений.

Совмещение означает создание отдельного кластера, где ОС и все системы, которые с ней работают имеют все функции отдельного компьютера. Но, хотя машина является виртуальной, а не реальной, она в любом случае взаимодействует со всеми ОС и приложениями, которые работают на базе Intel x86.

Независимость аппаратного обеспечения означает, что виртуальную машину можно перенести с реального аппаратного обеспечения на одной системе в другое без особых проблем. К примеру, рассмотри два сервера: HP и Cisco. Для переноса запущенной программы на ОС и обеспечении HP на Cisco в обычных условиях была бы необходима повторная инсталляция этой программе на новой ОС. В итоге, много работы по инсталляции и тестированию всей системы. Виртуальная же машина позволяет произвести беспрепятственный перенос с одной системы на другую. Причём большинство систем виртуальных машин позволяют переносить конкретную виртуальную машину с одной системы на другую в рабочем режиме серверов. Это также позволяет делиться ресурсами, дисковым пространством и процессорной мощностью. Так, для приложения, которому требуется большое количество дискового пространства нет необходимости добавлять диски к физическому серверу — их можно реконфигурировать в процессе работы. Таким образом системные администраторы получают куда больший простор для творчества.

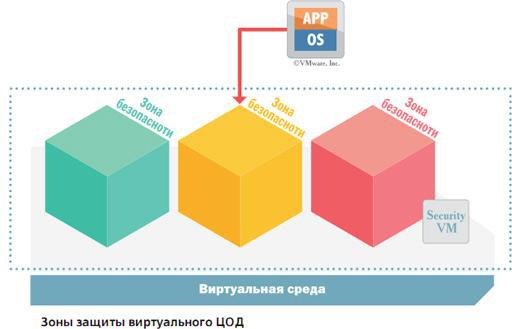

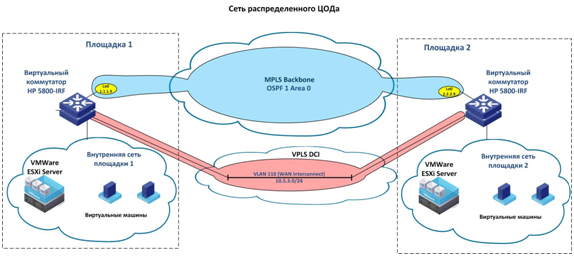

В современных условиях при установке в дата-центре нового обеспечения все машины виртуализируются. Виртуальными становятся сети, системы хранения и сами дата-центры. Сегодня при желании заиметь свой собственный центр обработки данных достаточно определиться с конфигурацией оборудования, обратиться в хостинговую компанию, где будет создан персональный ЦОД. Естественно, что физчески всё заявленное оборудование должно где-то находиться. Основной дата-центр (производственный) — это часть видимая пользователем. Но есть еще один ЦОД (резервный), который имеет двойную роль: он функционирует как резервная копия реального ЦОД и как участок для разработчиков. Основной ЦОД предназначен для пользователя, а место для разработчиков — резервный ЦОД, где есть почва для тестирования приложений. После тестирования виртуальные машины переносятся из резервного ЦОД на основной, где непосредственно используются. В случае нештатных ситуаций в основном дата-центре виртуальные машины могут также перетаскиваться на резервный. Таким образом вся система становится намного более доступной.

Каковы же основные причины популярности виртуализации в наше время? Во-первых, это снижение затрат на физическую инфраструктуру, что означает меньшее количество серверов, шкафов, комнат. Во-вторых, снижение оперативных затрат, таких как электричество и охлаждение. В-третьих, увеличивается операционная гибкость и производительность системных администраторов.

Как яркий пример физической экономии можно привести модель, где 4 сервера, оснащённых системой VMware заменяет собой 50 физических серверов. При этом производительность возросла с 5-10% до 80%, а вместо 10 шкафов требуется всего один. Касаемо операционных затрат, расход энергии снижается на 80%, при этом ещё 25% энергии снижается за счёт оптимизации нагрузки. Продуктивность работы системных администраторов увеличивается элементарно за счёт снижения количества выполняемых задач и большей доступности оборудования.

На данный момент половина серверов во всём мире виртуальны. Именно виртуализация является направляющей всей IT-индустрии, поэтому всё новейшее обеспечение готовится уже под задачи виртуализации.

В 1999 году компания VMware впервые виртуализировала компьютер на базе Intel: на одном аппарате было запущено несколько операционных систем и, соответственно, несколько приложений. При этом затраты электроэнергии распределялись на несколько операционных систем уже на одном комплекте аппаратного обеспечения, что позволило рационализировать нагрузку.

Как всё это работает? Между сервером и операционными системами есть тонкий слой программного обеспечения для виртуализации или же на сервере устанавливается ОС, на которую накладывается уровень виртуализации.

Задачей виртуализации является введение в заблуждение ОС, чтобы она идентифицировала её как собственное аппаратное обеспечение. Подобные хитрости необходимы из-за слишком большого количества приложений, созданных под конкретную ОС. Таким образом виртуальная машина имеет ряд преимуществ, таких как инкапсуляция, изоляция отдельного приложения, совмещение его с ОС и другими программами, и при этом создаётся некая независимость аппаратного обеспечения. Рассмотрим эти компоненты по-отдельности.

Инкапсуляция — это сбор данных или функций в единый компонент. Создаётся программа, которая маскируется под отдельную физическую машину, выполняющую все свои функции. И ОС вместо того, чтобы идентифицировать набор различных устройств, на самом деле видит набор разных файлов.

Изоляция означает, что все приложения, работая на одном устройстве, работают независимо друг от друга, идентифицируя себя, как разные устройства. В результате, если зависает или падает одна ОС, это никак не влияет на работу других ОС и приложений.

Совмещение означает создание отдельного кластера, где ОС и все системы, которые с ней работают имеют все функции отдельного компьютера. Но, хотя машина является виртуальной, а не реальной, она в любом случае взаимодействует со всеми ОС и приложениями, которые работают на базе Intel x86.

Независимость аппаратного обеспечения означает, что виртуальную машину можно перенести с реального аппаратного обеспечения на одной системе в другое без особых проблем. К примеру, рассмотри два сервера: HP и Cisco. Для переноса запущенной программы на ОС и обеспечении HP на Cisco в обычных условиях была бы необходима повторная инсталляция этой программе на новой ОС. В итоге, много работы по инсталляции и тестированию всей системы. Виртуальная же машина позволяет произвести беспрепятственный перенос с одной системы на другую. Причём большинство систем виртуальных машин позволяют переносить конкретную виртуальную машину с одной системы на другую в рабочем режиме серверов. Это также позволяет делиться ресурсами, дисковым пространством и процессорной мощностью. Так, для приложения, которому требуется большое количество дискового пространства нет необходимости добавлять диски к физическому серверу — их можно реконфигурировать в процессе работы. Таким образом системные администраторы получают куда больший простор для творчества.

В современных условиях при установке в дата-центре нового обеспечения все машины виртуализируются. Виртуальными становятся сети, системы хранения и сами дата-центры. Сегодня при желании заиметь свой собственный центр обработки данных достаточно определиться с конфигурацией оборудования, обратиться в хостинговую компанию, где будет создан персональный ЦОД. Естественно, что физчески всё заявленное оборудование должно где-то находиться. Основной дата-центр (производственный) — это часть видимая пользователем. Но есть еще один ЦОД (резервный), который имеет двойную роль: он функционирует как резервная копия реального ЦОД и как участок для разработчиков. Основной ЦОД предназначен для пользователя, а место для разработчиков — резервный ЦОД, где есть почва для тестирования приложений. После тестирования виртуальные машины переносятся из резервного ЦОД на основной, где непосредственно используются. В случае нештатных ситуаций в основном дата-центре виртуальные машины могут также перетаскиваться на резервный. Таким образом вся система становится намного более доступной.

Каковы же основные причины популярности виртуализации в наше время? Во-первых, это снижение затрат на физическую инфраструктуру, что означает меньшее количество серверов, шкафов, комнат. Во-вторых, снижение оперативных затрат, таких как электричество и охлаждение. В-третьих, увеличивается операционная гибкость и производительность системных администраторов.

Как яркий пример физической экономии можно привести модель, где 4 сервера, оснащённых системой VMware заменяет собой 50 физических серверов. При этом производительность возросла с 5-10% до 80%, а вместо 10 шкафов требуется всего один. Касаемо операционных затрат, расход энергии снижается на 80%, при этом ещё 25% энергии снижается за счёт оптимизации нагрузки. Продуктивность работы системных администраторов увеличивается элементарно за счёт снижения количества выполняемых задач и большей доступности оборудования.

На данный момент половина серверов во всём мире виртуальны. Именно виртуализация является направляющей всей IT-индустрии, поэтому всё новейшее обеспечение готовится уже под задачи виртуализации.