Комментарии 71

ИМХО лучше делать качественную вирутализацию, потому что физический сервер это всегда single point of failure. То что скорости винчестеров на VDS не хватает это проблема конкретной реализации, а не виртуализации вообще.

0

В виртуализации проблема с памятью никуда пока не уходит. Выше 8Гб на 1U — начинает быстро расти цена. Естественно, жалко целый сервер делить всего на 4-8 клиентов. Single point of failure — да, но MBTF может быть больше 10 лет при таких температурах, отсутствиии движущихся частей. Виртуализация — тоже Single point of failure, только падает сразу куча «серверов». С любым VDS-провайдером такое бывало — сервер ложится — сразу куча клиентов в дауне. И нет возможности работать на «своём купленом железе». На своё железо денег не жалко :-)

0

>> Виртуализация — тоже Single point of failure,

Послушайте, вы общались с идиотами. Это печально, но не имеет никакого отношщения к вирутализции. Любая система виртуализации (XenServer, VMWare ESX, Hyper-V) позволяет делать кластер и в случае сбоя сервера перезапускать ваши машины на другом физическом сервере. Если кто-то из хостеров не задействовал эту функцию, это его проблемы.

За виртуализацией будущее.

Послушайте, вы общались с идиотами. Это печально, но не имеет никакого отношщения к вирутализции. Любая система виртуализации (XenServer, VMWare ESX, Hyper-V) позволяет делать кластер и в случае сбоя сервера перезапускать ваши машины на другом физическом сервере. Если кто-то из хостеров не задействовал эту функцию, это его проблемы.

За виртуализацией будущее.

+6

Не знал, согласен — круто и удобно. Жаль только 2-4Гб памяти за 30$ никто не дает :-( :-)

0

ну, тут стоит отметить что взрослые системы виртуализации вроде как уже давно умеют при отказе одного сервера незаметно переезжать на другой.

Но со своей железякой как-то спокойнее.

Но со своей железякой как-то спокойнее.

+3

Да, тут я с вами особенно согласен. Своё железо ближе к телу :-)

Думаю виртуализация и коло на mini-ITX это 2 немножко разных ниши, которые впрочем сильно пересекаются.

Думаю виртуализация и коло на mini-ITX это 2 немножко разных ниши, которые впрочем сильно пересекаются.

+2

Да я сам настраивал миграцию с помощью DRBD, используя ganeti. Работает отлично, я вам скажу.

0

Посмотрел по ссылкам в постинге — там предлагают сплошь варианты с одним HDD (ну если брать именно дешёвые варианты). Это совсем несерьёзно. Сдохнет диск и чего делать? Бэкапы это не решение в данном случае. А если купил виртуальную машинку, так обычно на серваке есть RAID какой-либо и отказы дисков проходят незаметно для клиента.

0

дело в том, что виртуализацию часто оверселлят и поймать на этом хостёра очень сложно.

Я вполне бы соблазнился на идею дёшево коллоекйтить маленькие ITX где-нибудь. Причём не арендовать, а именно коллокейтить.

Я вполне бы соблазнился на идею дёшево коллоекйтить маленькие ITX где-нибудь. Причём не арендовать, а именно коллокейтить.

+2

Оверселят всё.

+1

Я хочу разместить в датацентре два микро-ITX блока. Каким образом это можно соверселить?

+1

я бы взял, возможно даже парочку.

0

infobox.ru предосталяет свои сервера на Atom, но минус — это цена, она конечно высоковата :(

0

Я бы не сказал, что у Atom'a с пассивным охлаждением все хорошо, в штатных GCLF2 при активном использовании температура камня стремится к 70 градусов.

Какое-то корпусное охлаждение ему нужно в любом случае.

Какое-то корпусное охлаждение ему нужно в любом случае.

0

Так там же древнючий 945 чипсет, который тепла дает в 5 раз больше, чем сам атом.

Под максимальной нагрузкой 1-ядерный атом точно в пассиве работает на этой Zotac-овской плате (на столе, в 1U корпусе то будут вентиляторы). Вот 2-х ядерному атому может быть труднее…

Да, пожалуй нужно всетаки иметь пару вентиляторов на радиаторе, если один и выйдет из строя, второй справится )

Под максимальной нагрузкой 1-ядерный атом точно в пассиве работает на этой Zotac-овской плате (на столе, в 1U корпусе то будут вентиляторы). Вот 2-х ядерному атому может быть труднее…

Да, пожалуй нужно всетаки иметь пару вентиляторов на радиаторе, если один и выйдет из строя, второй справится )

0

Там проблема именно в «старом чипсете», т.к. помоему еще на 90 нанометровой технологии собран.

пс

А когда выйдет новый BarsWF? Я помню год назад был разговор что будут хеши с солью поддерживаться для перебора.

пс

А когда выйдет новый BarsWF? Я помню год назад был разговор что будут хеши с солью поддерживаться для перебора.

0

Acer Aspire Revo на роль сервера как то дороговато, а вот нароль компьютера для инета и не сильно крутых игрушек в самый раз

+1

300-400$ за сервер на Revo это дорого, а 1000$+ за 1U обычный сервер это дешево? :-)

+3

Взял за 400$ 1U сервер Asus без винчестеров, оперативки и процессора (под 775). После покупки 4-х ядерного Xeon 3300 2,4GHz, 2 SATA HDD по 1Tb и 8Gb DDR2 800MHz (можно и без ECC) цена как раз стала 1000$. На материнке 2 гигабитных сетевых адаптера и возможность установить PCIe через рейзер.

По-моему такая система с учетом ее нарезки посредством KVM-виртуализации интереснее чем mini-itx.

По-моему такая система с учетом ее нарезки посредством KVM-виртуализации интереснее чем mini-itx.

-1

По процессору — еще терпимо, по памяти,IO, энергопотреблению — нет.

Когда в 1U стоят 6 атомов, мы имеем 24Гб памяти в 12-и канальном режиме, 12 физических ядер, и 6-12 винчестеров, которые друг-другу не мешают :-) Думаю, 3 ядра атома сравнимы с 1 Xeon-ом :-)

Проще? Да, пожалуй собрать и поставить 1 бокс проще, чем размещать 6 атомов внутри 1U.

PS. А есть еще mini-ITX в которые квады лезут ;-) Но тут уже проблемы с питанием.

Когда в 1U стоят 6 атомов, мы имеем 24Гб памяти в 12-и канальном режиме, 12 физических ядер, и 6-12 винчестеров, которые друг-другу не мешают :-) Думаю, 3 ядра атома сравнимы с 1 Xeon-ом :-)

Проще? Да, пожалуй собрать и поставить 1 бокс проще, чем размещать 6 атомов внутри 1U.

PS. А есть еще mini-ITX в которые квады лезут ;-) Но тут уже проблемы с питанием.

0

согласен с плюсами распараллеленности, кучи ядер и памяти…

но я бы не сказал что три ядра атома сравнимы с ксеоном. Атом же не просто за счёт частоты такой холодный — там архитектура довольно слабая для этого (ну, тупо транзисторов меньше). Скорее всего на CPU-intensive задачах атомы будут сильно проигрывать ксеону.

но я бы не сказал что три ядра атома сравнимы с ксеоном. Атом же не просто за счёт частоты такой холодный — там архитектура довольно слабая для этого (ну, тупо транзисторов меньше). Скорее всего на CPU-intensive задачах атомы будут сильно проигрывать ксеону.

0

я бы взял такой DS… за 39 долларов особенно понравился. Прям таки все как у меня дома на тестовом сервере) другое дело что с тестовым сервером дома помимо основного мороки много. IP то всё таки один.

0

НЛО прилетело и опубликовало эту надпись здесь

1 микроконтроллер + кучка деталей + паяльник + мозги = перезагружалка целой стойки микросерверов.

Микроконтроллер подключаем к одному из компов, пишем небольшой софт, который общается с COM портом напримем (если СОМа нет, то переходник USB2СОМ) и узнаёт как там дела у микросерверов или насильный ребут заставляет делать.

Микроконтроллер подключаем к одному из компов, пишем небольшой софт, который общается с COM портом напримем (если СОМа нет, то переходник USB2СОМ) и узнаёт как там дела у микросерверов или насильный ребут заставляет делать.

+1

Угу, все так. Кажется что легко, когда для себя, т.к. личное время на R&D условно бесплатное.

А если придут и попросят выставить ценник за готовый продукт, получатся совсем не копейки :-)

А если придут и попросят выставить ценник за готовый продукт, получатся совсем не копейки :-)

+1

Может знакомый есть, кому нужно место на минисерваке? А вдруг он ещё любитель попрограммировать микроконтроллеры и паять любит?

В плане софта для управления, вроде как подручными средствами в линуксе можно в СОМы кидать данные (могу ошибаться, я виндоус юзер). На крайняк, можно обойтись скриптами которые в СОМ шлют номер минисервера, который хочется ребутнуть.

Если сильно захотеть, можно в космос полететь :)

В плане софта для управления, вроде как подручными средствами в линуксе можно в СОМы кидать данные (могу ошибаться, я виндоус юзер). На крайняк, можно обойтись скриптами которые в СОМ шлют номер минисервера, который хочется ребутнуть.

Если сильно захотеть, можно в космос полететь :)

0

Примерно такое придумали и сделали для суперкомпьютеров СКИФ. Назвали «Управляющей сетью ServNet»

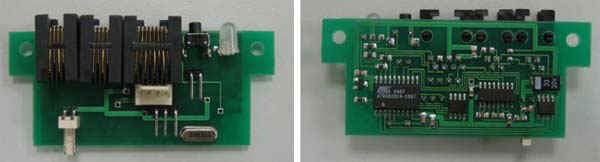

Модуль:

Задачи модуля:

— операции включение/выключение питания;

— аппаратного сброса (reset);

— возможности организации с управляющей ЭВМ консольного доступа к любому вычислительному узлу на этапах загрузки и конфигурирования BIOS, загрузки и работы ОС;

— «посмертного» чтения последних консольных сообщений ОС.

skif.pereslavl.ru/psi-info/rcms/rcms-leaflets.rus/serv-net-leaflet.pdf

Модуль:

Задачи модуля:

— операции включение/выключение питания;

— аппаратного сброса (reset);

— возможности организации с управляющей ЭВМ консольного доступа к любому вычислительному узлу на этапах загрузки и конфигурирования BIOS, загрузки и работы ОС;

— «посмертного» чтения последних консольных сообщений ОС.

skif.pereslavl.ru/psi-info/rcms/rcms-leaflets.rus/serv-net-leaflet.pdf

+4

Не плохо, но я бы сделал на одной микросхеме + резонатор. По стоимости даже дешевле, а плата проще, хотя она и так достаточно примитивна. Вот побороть собственную лень и на выходных спроэктировать свой бюджетный kvm.

0

В современных контроллерах часто есть внутренний RC-резонатор, двухпроцентной точности которого вполне достаточно для большинства не слишком высокоскоростных интерфейсов (RS-232 9600, например). К тому же, есть синхронные интерфейсы.

Таким образом, на плате нужен контроллер, БП (стабилизатор), развязки для вводов-выводов и ключи для индикаторов.

Таким образом, на плате нужен контроллер, БП (стабилизатор), развязки для вводов-выводов и ключи для индикаторов.

0

НЛО прилетело и опубликовало эту надпись здесь

Не хочешь попасть на хостинг с диким оверселлингом? Читай www.hostnadzor.ru — социальная сеть обманутых хостерами.

-4

НЛО прилетело и опубликовало эту надпись здесь

Мне кажется что будут проблемы с креплением всего этого добра.

На этих корпусах даже нет крепления, как их хранить в количестве, скажем 100 штук?

Что делать с охлаждением? Ну т.е. с охлаждением стандартных 1U серверов дело откатанное, а с этими как быть?

Как быть с сертификатами? Их на сервера надо целую уйму, если их не будет, при первой проверке органами сервер «потеряется».

Не забываем про подвод питания, проводов из-за меньшего размера надо больше. Во всех ДЦ есть утверждённые схемы и подвод дополнительных кабелей может стать проблемой.

А как mini-itx горят? Вот пожар, к примеру, есть у кого статистика?

Плюс много других неясных вопросов о том как это всё будет функционировать из-за отсутствия опыта эксплуатации.

Как мне кажется предоставление услуг dedicated/collocation для mini-itx возможны только в новых ДЦ, которые для этого изначально планируются.

ps. У инфобокса как раз и есть новый ДЦ. Я не знаю в каком корпусе они ставят свои атомы. Есть мнение что всё же не на mini-itx.

На этих корпусах даже нет крепления, как их хранить в количестве, скажем 100 штук?

Что делать с охлаждением? Ну т.е. с охлаждением стандартных 1U серверов дело откатанное, а с этими как быть?

Как быть с сертификатами? Их на сервера надо целую уйму, если их не будет, при первой проверке органами сервер «потеряется».

Не забываем про подвод питания, проводов из-за меньшего размера надо больше. Во всех ДЦ есть утверждённые схемы и подвод дополнительных кабелей может стать проблемой.

А как mini-itx горят? Вот пожар, к примеру, есть у кого статистика?

Плюс много других неясных вопросов о том как это всё будет функционировать из-за отсутствия опыта эксплуатации.

Как мне кажется предоставление услуг dedicated/collocation для mini-itx возможны только в новых ДЦ, которые для этого изначально планируются.

ps. У инфобокса как раз и есть новый ДЦ. Я не знаю в каком корпусе они ставят свои атомы. Есть мнение что всё же не на mini-itx.

0

Я не предлагаю ставить в корпусах mini-Itx, я предлагаю ставить в корпусах 1U несколько штук в 1. Вариантов внутреннего крепления масса, от резинки с неодимовыми магнитами на концах, до просверливания дырочек под стандартные медные ввинчивающиеся «столбики». Сертификаты — да, это проблема, когда сервер уже в стойке, проверка ходит и каждый сервер открывает — смотрит?

Я предлагаю общий БП, поэтому никаких дополнительных силовых кабелей.

С охлаждением ПРОЩЕ чем с обычными 1U серверами, т.е. суммарная мощность 120-150W а не 250-300 отдаваемая на радиаторы гораздо большей суммарной площади.

Я предлагаю общий БП, поэтому никаких дополнительных силовых кабелей.

С охлаждением ПРОЩЕ чем с обычными 1U серверами, т.е. суммарная мощность 120-150W а не 250-300 отдаваемая на радиаторы гораздо большей суммарной площади.

0

Я видимо, не чётко выразил свою мысль.

Проблема, как мне кажется в том, что нет стандартных промышленных решений для того что вы предлагаете.

Нет, проверка просит выдать документы на все сервера, если на какие-то нет, возникают проблемы.

Кстати, а как в вашем варианте предусмотрена замена одного из серверов?

Вынимать весь 1U?

Не думаю что с охлаждением проще, всё опять же упрётся в отсутствие стандартных решений.

Т.е. может один сервер и отдаёт 150W, а вот когда их пяток напихать в 1U, сколько оно отдавать будет и как рулить тепловые потоки внутри?

Мне реализация подобного в ДЦ видится как отдельная, специально спроектированная стойка. Где под каждый mini-itx выдаётся один слот. Ибо, как мне кажется, по другому проблему замены не решить.

Проблема, как мне кажется в том, что нет стандартных промышленных решений для того что вы предлагаете.

Нет, проверка просит выдать документы на все сервера, если на какие-то нет, возникают проблемы.

Кстати, а как в вашем варианте предусмотрена замена одного из серверов?

Вынимать весь 1U?

Не думаю что с охлаждением проще, всё опять же упрётся в отсутствие стандартных решений.

Т.е. может один сервер и отдаёт 150W, а вот когда их пяток напихать в 1U, сколько оно отдавать будет и как рулить тепловые потоки внутри?

Мне реализация подобного в ДЦ видится как отдельная, специально спроектированная стойка. Где под каждый mini-itx выдаётся один слот. Ибо, как мне кажется, по другому проблему замены не решить.

0

Один отдает не 150, а 20-30 под нагрузкой, и 15 без нагрузки.

150 — это как раз максимум, которого можно достичь напихав в 1U под завязку, причем это уже с учетом КПД блока питания.

Замена — разве нельзя выдвинуть 1U из стойки, открыть крышку не отключая ничего, и поменять один?

А когда берут сервер на коло — хостер забирает себе документы на него? Не теряет? :-)

Промышленное решение — это промышленный корпус 1U, в котором сверлятся дополнительные дырки под mini-ITX платы.

150 — это как раз максимум, которого можно достичь напихав в 1U под завязку, причем это уже с учетом КПД блока питания.

Замена — разве нельзя выдвинуть 1U из стойки, открыть крышку не отключая ничего, и поменять один?

А когда берут сервер на коло — хостер забирает себе документы на него? Не теряет? :-)

Промышленное решение — это промышленный корпус 1U, в котором сверлятся дополнительные дырки под mini-ITX платы.

0

Документы необходимо предоставить, с них снимают копии.

Может и можно, но опять же повторюсь, промышленных решений нет.

Всё остальное будет кустарничеством, а это со средним бизнесом (строительство ДЦ) не связано.

Опять же как быть с винчестерами не понятно, кому-то надо один, кому-то два.

А тут ещё SSD на подходе, которые можно в тот же атом пихать. Надо будет много разных дырок сверлить.

Может и можно, но опять же повторюсь, промышленных решений нет.

Всё остальное будет кустарничеством, а это со средним бизнесом (строительство ДЦ) не связано.

Опять же как быть с винчестерами не понятно, кому-то надо один, кому-то два.

А тут ещё SSD на подходе, которые можно в тот же атом пихать. Надо будет много разных дырок сверлить.

0

Остается только дождаться промышленного решения от HP или IBM, так чтобы по высоте был 1U, а по ширине в стойку влезало хотя бы 2 сервера вместо одного. :) Вот тогда предлагать подобную услугу будет выгодно, ибо по питанию, реально, особых проблем нет.

0

Такое промышленное уже есть, просто простым смертным не продают, чтобы случайно не оказали серьёзной конкуренции :-) Например сервера гугл из этой серии.

0

Я рассуждаю с точки зрения владельца датацентра. ДЦ есть, предложить подобную услугу, возможно, было бы интересно. Но надо считать. Если просто брать материнку под Атом и совать в корпус 1U, то не интересно совсем: во-первых, самосбор — дела давно минувших дней, во-вторых, лучше поставить нормальный сервер и брать за него нормальные деньги.

А вот если бы сейчас можно было бы заказать то решение, о котором я выше написал на пробу, то можно было бы и в аренду сразу предложить. :)

А вот если бы сейчас можно было бы заказать то решение, о котором я выше написал на пробу, то можно было бы и в аренду сразу предложить. :)

+1

у датацентров есть подобная услуга — блейд-сервера там правда в 10U влезает всего 16 штук. Но какая-никакая, а экономия.

0

С другой стороны: есть порядка 10 хостеров в РФ, которые берут на коло minitower-ы. Имхо им было бы проще реализовать это, я думаю им всем отпишу на эту тему. Хотя ДЦ там конечно не такие козырные.

0

Проблемма с RVM решается выбором мамки умеющей редиректить консоль на последовательный порт (лучше сразу в сеть). Такие мамки под Atom совершенно не проблемма. Дальше стоит железка (обысный писюк с платами расширения) на 64 последовательных порта с тупым шлюзом COM-TCP. В железку все последовательные порты сходятся — клиент за небольшую мзду (сугубо чтобы окупить железку) имеет доступ к консоли.

В качесте бонуса — можно дать совсем мело денег знающим людям и они прикрутят удалённое нажимание на конки сброса. Кнопки сброса — это обысные двуконтактные разъёмчики — они собираются и заводятся на неую железку, коия умеет по TCP или Serial жать на них. За это денег драть не нужно — ибо есть потребность насущная.

В качесте бонуса — можно дать совсем мело денег знающим людям и они прикрутят удалённое нажимание на конки сброса. Кнопки сброса — это обысные двуконтактные разъёмчики — они собираются и заводятся на неую железку, коия умеет по TCP или Serial жать на них. За это денег драть не нужно — ибо есть потребность насущная.

0

А BIOS через такую консоль работает? А BIOS RAID контроллера?

0

Да, BIOS работает. все нормальные RAID /Ethernet BIOS'ы тоже. И фсякого рода загрузчкии тоже (иногда нужно ключи указывать, чтобы ввод/ввывод через BIOS делали). И ядро linux'a тоже может через него косноль делать (до определённго момента ввод/выод идёт через BIOS, а затем редиректится непосредственно на последовательный порт). С консолью непосредственно по TCP/IP сложнее. Я такие фишки видел на интеловский мамках. Там BIOS видно и начало загрузки, но потом консоль пропадает, т.к. нужно сетевую карту инициализировать.

0

Кстати, если совсем интересно — есть недорогоие платки (правда покупать нужно за границей — у нас накручивают по 300%) формата cPCI — там процессорная плата со всей обвязкой вставляется в слот обычной стойки 3 или 6U. В качестве загрузочного диска используется compact flash. Позволяет в габаритах 19«x6U собрать с десяток полноценных компьютеров. Ко всему прочему не греется, отличается высокой надёжностью и т.п.

Это к тому — откуда такая тяга к ITX если есть специальные решения?

Это к тому — откуда такая тяга к ITX если есть специальные решения?

0

Вопрос почти не в тему. Кто нибудь пользовался услугами https://interserver.net/custom-managed-dedicated-servers.html? Что то очень захотелось перейти от российского хостера, ибо дешевле почти в 4 раза, но немного страшно, малоли какая то левая конторка

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Публикации

Изменить настройки темы

Intel Atom colocation