Комментарии 65

Предположим, что удав похож на 1 удава, 0,5 слоника, 0,125 мартышки и 0,0208 попугая. Теперь, если есть группа масок, содержащая маски представляющие удава, слоника, мартышку и попугая, можно с определённой долей уверенности, исходя из активность этих масок, предполагать наличие перед нами удава.

На реальных данных удав будет похож на удава — 0.6783, на крокодила — 0.6784, на трактор — 0.6762 и т.д. Важно выявить кластер (маска по вашему) победитель. На MNISTе насколько реально оказывается активность маски-победителя выше её ближайших соседей?

Какой получен уровень ошибок (ложно-положительных и ложно-отрицательных) на том же MNIST?

Какой размер масок?

Сколько получается масок на класс (цифру)?

Откуда у масок берётся обобщающая способность? Ведь, насколько я понял, вы просто без предобработки строите маски из сырых данных из MNIST.

— Маска – это одиночный нейрон, который хранить только фрагмент информации о событии (и может относиться к нескольким событиям сразу). Кластер победитель — это группа масок. Соответственно одно и тоже: группа масок – результирующая маска – кластер – группа нейронов – КОГ (по Анохину). А какая разница насколько реально оказывается активность группы-победителя выше её ближайших соседей? Выбирается самая активная. А все остальные подтягиваются, что позволяет со временем выбрать группу наиболее соответствующую событию. И не важно, что конкретно хранится в масках если с их помощью можно выразить событие (сделать обобщение).

— Ошибки на ложноположительные и ложноотрицательные, разделить не получится. Тут это не применимо. Есть предположение программы, есть фактический индекс изображения. Они либо совпадают, и тогда программа распознала правильно, либо нет.

— А в какой момент вас интересует уровень ошибки. В этом плане, модель ведёт себя как биологический интеллект (как бы в этом цель). Пока идёт обучение, ошибка падает. В данном случае, есть два режима обучения: с использованием индексации данных для классификации (быстрое формирование первичных навыков), или постоянный режим, при котором модель сама классифицирует данные опираясь на накопленный опыт.

Эффективное обучение с индексами идёт до возникновения полки. После чего можно закрепить материал, продолжив обучение с индексами, а можно перейти в постоянный режим и тогда начнётся процесс искажения. Соответственно, чем дольше закреплялся материал, тем медленнее происходит его искажение. В любой момент можно возобновить обучении с индексами, и тогда ошибка начнёт опять снижаться.

Отдельно отмечу, что модель всегда обучается, используя для этого любые поступающие данные.

Единственное что можно точно сказать про уровень ошибки, его минимальное значение которое мне удалось получить в районе 9%. Можно добиться её снижения, но тогда информация в памяти не закрепляется. А цель именно в том, чтобы память вела себя как биологическая.

— И простые маски (которые нейроны) и результирующие маски (которые группы нейронов), формируются в самой программе, исходя из поступающей информации. Есть алгоритм, удаляющий всё лишнее, но полностью от мусора избавится сложно.

Маски соответствуют сенсорному пространству, то есть в данном случае изображению 28х28 или 784 символа, по две переменные float на каждый. Результирующие маски содержат информацию о всех маска (нейронах) нижнего уровня, количество которых достигает 8000 по две переменные float на каждый, а также информацию о сенсорном пространстве 784 символа по три переменные Single на каждый.

— Количество групп масок (групп нейронов) в районе 400.

Термин «событие» тоже не к месту. Вы обрабатываете статику, отдельные образы.

А какая разница насколько реально оказывается активность группы-победителя выше её ближайших соседей?А как понять что сеть видит? По самому активному её выходному нейрону. А если там разница на уровне двух знаков после запятой, то сеть не выполняет своего предназначения — ничего не распознаёт.

Ошибки на ложноположительные и ложноотрицательные, разделить не получится. Тут это не применимо.Применимо, просто бинаризуйте выход.

Эффективное обучение с индексами идёт до возникновения полки. После чего можно закрепить материал, продолжив обучение с индексами, а можно перейти в постоянный режим и тогда начнётся процесс искажения.Возникает ощущение, что где-то пропущено две-три статьи. Если есть желание рассказать об алгоритме, то писать требуется как туториал.

Результирующие маски содержат информацию о всех маска (нейронах) нижнего уровня, количество которых достигает 8000Скорее всего ваш алгоритм просто выучивает обучающие образы и всё. В таком случае вы могли бы под каждый образ просто выделить по отдельной маске.

Я вас так «допрашиваю», потому что вижу сходные черты со своей работой. Но у меня нет такого дикого количества «масок» (кластеров, если говорить в терминологии Анохина) как у вас. Один кластер (ака нейрон у вас) сжимает в 5-15 раз. Оказывается достаточно одной маски на класс. И я бы почитал про иерархию, которую вы строите из масок.

Повторений 1100%. Ошибка 08,53%. Количество масок 8220. Количество групп 445. Частота 45 кадров в секунду, среднее значение за 4 часа.

Без нормального второго слоя и алгоритма backpropagation (или его аналога) вам точность выше не поднять.

Справились с MNIST, где однослойная сеть даёт 92%, а двухслойная 97% — идите теперь дальше, к FashionMNIST и SVHN, а потом к CIFAR10. А на MNIST покажите 98% хотя бы.

И ещё, очень интересно, научится ли ваша сеть выделять паттерны при наличии шумов.

Если бы стаяла задача добиться минимальной ошибки, я бы воспользовался готовыми инструментами, а не городил для этого велосипед. Ошибка в данной модели необходима, она позволяет ей непрерывно учиться. Что, как я понял, для нейронных сетей ещё та задача. Например, можно научит обученную нейронную сеть чему-то новому, сохранив старые навыки? Насколько я знаю нет. А вот биологические точно можно, хотя точность обучения будет явно ниже 92%.

На этой модели решалась другая задача, о чём написано в обоих статьях.

Есть более стандартные способы обеспечить ошибку через аугментацию. И более новые через self-supervised learning.

>Например, можно научит обученную нейронную сеть чему-то новому, сохранив старые навыки? Можно конечно :) Разными способами. Можно и вашим способом, просто он не очень эффективен (и по скорости, и по качеству), как вы и сами видите.

> А вот биологические точно можно, хотя точность обучения будет явно ниже 92%.

Серьёзно? Неужели вы не распознаёте написанную цифру в 8% случаев?

>Любая группа масок(группа нейронов), опосредованно передаёт сигнал активности дальше, другим группам. Количество элементов в такой цепочке неограниченно.

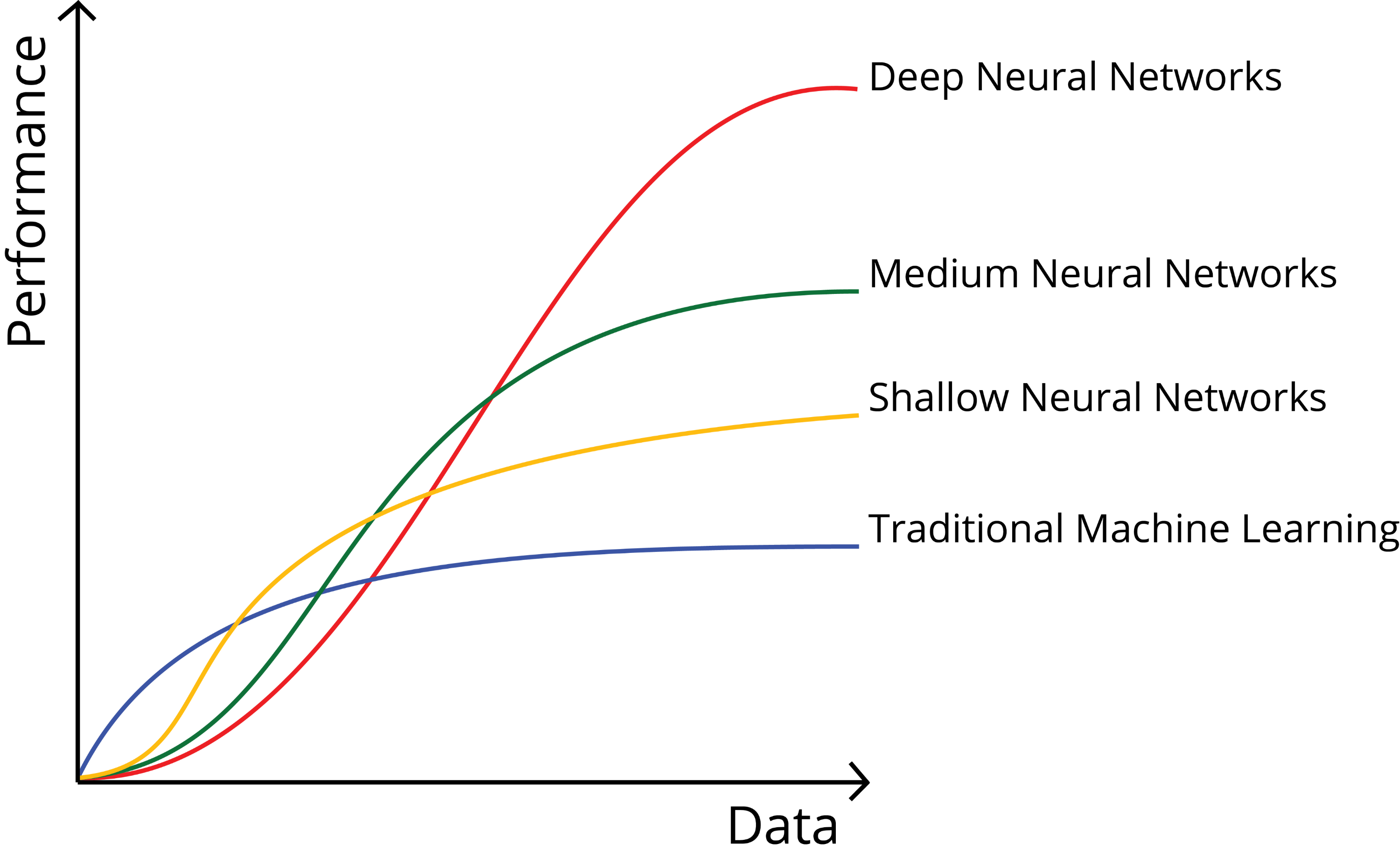

А, градиентный бустинг на деревьях. Ну, с удовольствием посмотрим на решение более сложной задачи вашим способом, и убедимся в том, что ваш «BICA»-метод не универсален (как вы явно считаете). Напоминаю классическую картинку:

По поводу современных BICA-методов лучше смотреть на Can a Fruit Fly Learn Word Embeddings? и думать о том, зачем вообще сетям нужны эмбеддинги ( если совсем по-простому, то вот зачем )

Проблема в том, что свою модель я строил, описывая процессы лежащие в основе мышления. И исходя из ваших утверждений, а так же результатов опроса, которые говорят что ничего нового я не предложил, я делаю предполагаю, что мои выводы верны. То есть, что такое мышление мышления, я описал правильно.

По поводу современных BICA-методов лучше смотреть на Can a Fruit Fly Learn Word Embeddings?Я так понял из AGI канала в телеге, что недавно была закрытая «сходка» на тему хеш-сетей той самой мухи. Что-нибудь интересное там было?

А можно пример способов? Я вот что-то с ходу вариантов не вижу, кроме формирования полного датасета из старого и нового. Я пока не встречал концепции дообучения сетей на новых данных без значительной потери ранее усвоенного. Можно фризить веса, но все равно: в том объеме, в котором сеть сможет дообучится — в этом объеме она и потеряет прошлые навыки.

Всевозможный бустинг и ансамбли сетей вроде круто, но проблема та же: как заставить сеть постигать новое, не забывая старое, используя для дообучения не полный датасет, а только новое. Просто если бы было какое-то концептуальное решение этого вопроса, можно было бы дообучать сеть только на примерах, где процент ошибки больше…

Вообще, при обучении большой сети с хорошей генерализацией вообще нету проблемы с забыванием, так что, пожалуй, забывание старого — это один из видов переобучения на маленьких/узких сетях. Особенно сильно у меня были ему подвержены RNN, кстати.

Возможно я отстал, но, некоторое время назад я не только искал сам, но и спрашивал у более продвинутых товарищей на этот счет… Если вы знаете нечто похожее — направьте меня хотя бы по ключевым словам.

deepmind.com/blog/article/enabling-continual-learning-in-neural-networks и arxiv.org/abs/1910.01526, например, но… Даже в этих исследованиях проблема дообучения заявлена как фундаментальная. И не так что бы закрытая, мягко говоря…

Ортогональное обучение — интересно конечно, но это такое себе решение: чисто за счет тотального наращивания размерности сети… Да и оно как-то не идеально работает.

Поэтому меня несколько удивляет ваше заявление о том, что «вообще нету проблемы с забыванием», ибо или я конкретно чего-то недопонимаю, или мы о разных вещах говорим.

а вот на практике её вообще нет, т.к. онлайновое дообучение обычно не проводят, только оффлайновое.

Поэтому и не проводят. ;) А очень бы хотелось! Не обязательно прям онлайн — можно чередовать фазы (в процессе работы в новыми данными проводить валидацию и формировать из ошибок новый корректирующий датасет, который с определенной периодичностью или по необходимости в качестве дообучающей выборки прогонять), но хочется именно дообучать, а не переобучать, вот в чем загвоздка.

Впрочем, я понимаю, что это скорее действительно не проблема, а некий аспект текущего похода в обучении ИНС.

Дорогой собеседник, я не хочу больше писать на хабре, потому что там сейчас сидит некомпетентный обыватель и минусует меня каждый раз.

Короче, поясняю. Никакой проблемы забывчивости нет, она надумана некомпетентными философами. А то, что она "не решена" на уровне нейросетей — это вообще трэшак. Просто эту проблему никто не решал. )))) Это проблема неуловимого Джо, которого никто не ловит.

Обычная нейросеть работает со статическими объектами. Популярный способ оптимизации — спуск по стохастическому градиенту (SGD) предполагает случайную выборку из совокупности, это значит, что во времени объекты изучения перемешаны.

Идем дальше: динамические нейросети RNN, LSTM, GRU ищут закономерности в последовательных рядах. Ну, конечно, как правило, там довольно короткие временные промежутки, просто задачи такие.

А вообще, решается проблема забывчивости следующим образом — нужно найти некоторую закономерность на большом промежутке времени (скрытые закономерности нейросети ищут на раз-два). Если эта закономерность неуловимого Джо не повторяется, а происходит один раз, то придется применять методы из серии дообучения и one-shot learning. Если закономерность единична, то это и не закономерность вовсе, строго говоря.

Но минусую я не за позицию, а за безапелляционные высказывания, что называется «в зал», при полном отсутствии аргументации! Вот сейчас — другое дело. Сейчас комментарий развернутый и позиция в целом понятна. С ней можно спорить! )

>>> Никакой проблемы забывчивости нет, она надумана некомпетентными философами.

Это не правда. Выше я кидал ссылки на статью в википедии, а еще выше — на статьи в блоге deepmind и arxiv.org, где вопросу уделено значительное внимание. Так же я процитирую уважаемого мною члена сообщества: "В общем, дообучение нейросетей на новом датасете без потери памяти о предыдущем имеет долгую историю с десятками методов как с этим бороться. Хотя результат так себе… Еще далеко до способностей биологического мозга. Гуглить можно по deep learning catastrophic forgetting, lifelong learning, continual learning и тому подобное.".

Собственно заявленная проблема (еще раз повторю, для исключения неправильного прочтения: проблема дообучения нейросетей на новом датасете!) напрямую вытекает, я бы даже сказал является следствием градиентного спуска: в режиме обучения каждый новый прогон смещает градиент тем сильнее, чем больше была ошибка на выходном значении. И только постоянное усреднение этих коррекций НА ВСЕМ ДАТАСЕТЕ позволяет избежать перекосов в сторону тех или иных данных. Причем не просто постоянное усреднение (ибо реальное усреднение на самом деле имеет место только в пределе мини-батча), а обучение с постоянным снижение learning rate! Ибо чем ближе аппроксимирует сеть входящие данные тем больше отклонение каждого конкретного паттерна от этой аппроксимации (ну при условии конечно, что выразительная способность сети не превышает размерность входа).

Я знаю, что вы, вероятно, все это знаете и я сейчас выступаю в роли кэпа, но хочу это все проговорить, что бы было понятно о чем речь и к азам больше не возвращаться.

У меня была идея (уверен не только у меня! :) ) построить такую систему: обучаем сеть на начальном датасете большого объема. Далее переводим в режим эксплуатации, но при этом контролируем процесс: собираем все случаи, где результат сети неудовлетворителен. Таким образом у нас формируется новый корректировочный датасет. Безусловно — при сопоставимом размере исходного и корректировочного датасетов можно их просто замешать. Тогда мы получим вполне годную процедуру, где дополним недостающими данными обучающую выборку…

Но что если у нас начальный датасет был… Хорош! ) Если его объем исчислялся сотнями тысяч (порядок дорисуйте, что б получилось МНОГО) паттернов и обучение заняло не одну тысячу часов на 16 топовых GPU? А корректировочная выборка на 5 порядков скромнее. Каким образом дообучить сеть, если мы понимаем, что есть все-таки недостатки в исходных данных?

>>>придется применять методы из серии дообучения и one-shot learning

one-shot learning — это не метод. Это то, что видимо имел ввиду Юрий, когда говорил про хорошую генерализацию: когда мы имеем сеть, обученную на столь большой, разнообразной и равномерной выборке, что ЛЮБОЙ паттерн из предметной области достаточно верно размещается в «пространстве эмбендинга» (современные большие ResNet подходят для ЛЮБЫХ картинок, с минимальным дообучением последнего слоя классификатора, а системы распознавания лиц умеют сравнить две фотографии человека, которого они видят впервые и сказать — один и тот же это человек или нет, просто по расстоянию между эмбендингами). Необходимым условием для работы этого подхода является УЖЕ сформированная глубокая архитектура, не изменяемая в дальнейшем. Это прекрасный подход, но вопрос заключается в том, как именно таковую сформировать? ;) Если бы можно было дообучать сеть на новых данных — все бы заметно оживилось.

Я понимаю, вы считаете, что все решается хорошим датасетом. И в принципе на это нечего возразить: «Лучше быть богатым и здоровым, чем бедным и больным(с)». На это у меня лишь два замечания: во-первых, многие архитектурные прорывы на всей истории развития ИНС случились на попытках избежать вручную сформированного датасета, например тренировать «сети внутри сетей» (даже свертка — ни что иное, как маленькая сеточка, в составе большей сети вход и выход которой не заданы явно). Нельзя недооценивать роль ImageNet, и языковых корпусов, на которых тренировались GPT, но… Мне кажется жизнь — лучший учитель, а сформированный человеком датасет всегда будет несовершенен. Ну а во-вторых, что называется «рад бы в рай, да грехи не пускают» — большие, качественные датасеты — вотчина корпораций, которые могут себе позволить бюджет, распределенные задачи и прочая. Это не для одиночек-энтузиастов.

Ну я, собственно, за это и зацепился, что у автора подход не то что бы совсем бессмысленный и беспощадный… Он экспериментирует в направлении постоянного дообучения, возможно делает это в некоторой степени наивно (я, если честно, к своему стыду пока не разобрался, что именно он делает), но… Вообще — это интересная тема, на мой взгляд. Как минимум заслуживает внимания.

>>> гуглить что-то типа gradient boosting neural networks

Ага, спасибо, посмотрю… Бустинг в первом приближении, как концепция, мне понравился, может действительно, я что-то интересное проглядел!

Будьте осторожны, в этой области тоже есть философы, а не инженеры. Первые ловят неуловимого Джо, а вторым он не нужен. Короче, не стоит развешивать уши, когда звучат безапелляционные заявления в зале…

Человеческое мышление — это оперирование понятиями. То, что у вас сейчас делается — это искусственная интуиция (бессознательное решение задач, возможно, с формированием примитивных внутренних понятий в этом процессе) и искусственное запоминание (запоминание информации с каким-то минимальным обобщением при этом). Манипулирования понятиями у вас нет, значит, это не мышление. Да и роль обобщения вы не разобрали.

И программа рассчитана для обучения на одноплатных компьютерах, каждый из которых должен выполнять роль отдельного нервного узла.

Наверняка есть решения способные обучаться на одноплатных компьютерах, не всем же нейронным сетям нужны видеокарты?

>описывая процессы лежащие в основе мышления.

Я вот про это. Вы описали процессы, лежащие в основе низкоуровневой деятельности мозга, но не в основе мышления.

Я так и ответил в голосовалке: вы не говорите ничего нового. А модель человеческих процессов у вас ещё плохо уложилась в голове. Да, для пчелы или муравья подходит, правда, у них тоже есть десятки и сотни блоков с фиксированным природой предназначением, у вас же пока лишь достаточно общее описание и выделено лишь два блока: «память» и «блок реагирования».

>Наверняка есть решения способные обучаться на одноплатных компьютерах, не всем же нейронным сетям нужны видеокарты?

Нет, искусственным нейронным сетям вообще не нужна видеокарта. Просто типичный CPU в 10-50 раз медленнее типичной видюшки, вот и всё.

Я так и ответил в голосовалке: вы не говорите ничего нового. А модель человеческих процессов у вас ещё плохо уложилась в голове. Да, для пчелы или муравья подходит, правда, у них тоже есть десятки и сотни блоков с фиксированным природой предназначением, у вас же пока лишь достаточно общее описание и выделено лишь два блока: «память» и «блок реагирования».

Это и есть та проблема на которой я встал. Ради такого вопроса, я на самом деле всё это затеял. Нужно было понять куда двигаться дальше. Ради исторической справедливости стоит отметить, что похожий вопрос задали и под прошлой статьёй.

На самом деле, вопрос мышления, вопрос определения — что такое мысль. Я так назвал ситуацию, при которой группы нейронов начинают передавать на вход системы информацию неотличимую от внешней. Чем это может быть ещё, для меня загадка.

Очевидно, что у понятия «мышление» может быть много выражений. Но должен быть и примитивный пример.

Воспоминание, может быть?

Хотя, вообще, не происходит такого в человеческом организме (да и у других животных тоже): На глаз никто ничего не передаёт (и на зону V1 коры тоже не передаётся никакого изображения, неотличимого от исходного).

1) Память не даёт вам запоминания, она даёт вам воспоминания. Запоминается же информация в структуре нервных путей. «Информация, неотличимая от внешней» при вспоминании — это воспоминания на верхних уровнях абстракции.

2) Нет, мышление — это про осознаваемые процессы. Просто поделите существ на тех, кто обладает мышлением, и кто не обладает. И попробуйте понять, что у них есть различного, ведь мышление должно быть обусловлено какими-то различиями. У муравьев и пчёл есть какие-то элементы мышления, но называть их мыслящими существами я бы не стал.

Воспоминание, может быть?А воспоминания форму мыслей не обретают?

Со зрительной корой всё вроде ясно, она распознаёт изображения (как минимум у кошки). Для модели которую я описал, выход зрительной коры и будет одним из участков сенсорного пространства. Модель не предназначена для работы с изображениями на прямую.

Нет, мышление — это про осознаваемые процессы.Тогда может вы и говорите о сознании. Мышление не обязано иметь внешних проявлений, людям обычно не свойственно обдумывать мелкую моторику при движении.

Иногда кажется, что это важные понятия, но на практике оказывается, что более важными понятиями являются учитель, классификация, признак, объект, обучающий пример, функция потерь… Короче, одним словом, пустословие это — мысль, мышление… Когда говоришь обывателям, мышление — это по сути аппроксимация, у них глаза на лоб лезут.)))

Я к тому, что все, что вы перечислили, как «важные понятия» — они безусловно важны, но довольно-таки неплохо определены. В отличие от мысль/мышление о которых у каждого свое представление…

Вы просто не понимаете, где лежит верхняя граница сложности аппроксимационной задачи… Вы сейчас подумали об аппроксимации графика на плоскости 0xy?

И поэтому оскорбились от мысли, что предел деятельности вашего мозга — всего лишь аппроксимация? А что? Вы думаете там "более сложные процессы, которые пока еще не открыты человечеством"? Чтобы открыть банку пива, нужно что-то более сложное нежели оптимизация?

Я вам скажу: у обывателя когнитивные искажения очень сильные…

Если бы стояла задача, начать с нейронов, матриц и аппроксимации, получилось бы тоже самое, но описанное тем языком который вам ближе. А если быть точнее, то получился бы велосипед, в то время когда остальные строят гоночные болиды.

Вас смущает, что мне не интересно строить велосипеды? Так я вас наверное огорчу, но обывателю проще взять готовый инструмент.

Мысль не может оскорблять. ;) Но, к сожалению, довольно часто за словоблудием мысль в лучшем случае теряется. В худшем — ее там и не было.

Я же вам уже объяснял: вбросы без аргументации — банально и не интересно. Разверните посыл, и тогда он, возможно, превратится в мысль.

Меня вполне устраивает концепция мышления, как аппроксимации. К сожалению мало дает в практическом плане: ряд вопросов остается не решенным. Т.е. сама по себе идея — норм. Но без раскрытия и детальной проработки ничем не отличается от голографической рентгенографии — такой же «лозунг».

Тестировал на MNIST на ограниченном обучающем наборе в 30-50 образов на класс/цифру.

Разницы между 10 кластерами на класс и 100 практически нет. FRR лежит в диапазоне 0-3%. FPR же зависит от количества нейронов во входном хеш-слое. При 300 хеш-нейронах FPR < 20%, при 500 < 10%. Так как кластеры правильного класса часто срабатывают кучно, то FPR легко понижается ещё вдвое.

Заметил, что спотыкается на одних и тех же образах — единичные «каракули», у которых трудно найти сходство с остальными образцами.

У вас есть минимум по одной маске, соответствующей каждому классу цифр. У каждой маски есть числовое значение её «активности» от 0 до 1. В итоге получаем десять чисел.

Пусть на демонстрацию нуля будет, например, так:

0: 0.69; 1: 0.23; 2: 0.61; 3: 0.45; 4: 0.57; 5: 0.33; 6: 0.66; 7: 0.54; 8: 0.73, 9: 071

Находим, допустим, два максимальных значения — они у 8 и 9.

Итого, ноль не распознан — одна ложноотрицательная ошибка. Распознаны 8 и 9 вместо нуля — две ложноположительные ошибки.

Прогоняете такой тест по датасету и считаете суммарное количество ошибок.

Если вы не посчитали ошибки, то не можете утверждать, что алгоритм вообще что-то распознает, а не просто греет процессор.

Предполагая при этом, что булева операция имеет какой-то порог.

В результате, фактическая ошибка в 8,53% случаях, которую можно посчитать напрямую, превратилась в какой-то кошмар. Математика ради математики.

Предполагая при этом, что булева операция имеет какой-то порог.Да, порог есть. Поэтому я выше и спрашивал, — насколько разнится максимальное значение от остальных.

Это не математика ради математики. Как только вы захотите узнать видит сеть яблоко или велосипед, вам придётся задать порог и найти единственное решение. Потому что ответ сети — «я вижу в этой картинке тысячу предметов» не имеет практического смысла. Чем лучше сеть отличает яблоко от велосипеда, тем она качественнее.

Как только вы захотите узнать видит сеть яблоко или велосипед, вам придётся задать порог и найти единственное решение. Потому что ответ сети — «я вижу в этой картинке тысячу предметов» не имеет практического смысла. Чем лучше сеть отличает яблоко от велосипеда, тем она качественнее.

Не тот случай. В данном случае нейронная сеть ничего не ищет. Ошибка — косвенный показатель способности нейронной сети запоминать информацию. Та модель которую я выложил, не предусматривает вывода результатов. И вывести эти результаты исходя из активности нейронов, не получится.

Не тот случай. В данном случае нейронная сеть ничего не ищет.Всмысле? Ваши слова «можно с определённой долей уверенности, исходя из активность этих масок, предполагать наличие перед нами удава». Эту самую «определённую долю уверенности» вы и должны продемонстрировать, чтобы заявлять, что алгоритм имеет хоть какое-то отношение к ИИ.

Лучше не реальных примерах!

Активность групп сделаю чуть позже.

Или это и имелось ввиду под активностью групп?

if (если ошибка)

{

all.Add(1);

allEror++;

}

else

{

all.Add(0);

}

if (если пошло по кругу)

{

allEror = allEror - all[0];

all.RemoveAt(0);

}Суммирую все случаи, когда модель ошиблась. А по поводу ROC-кривой, я не понимаю её практического смысла.

Суммирую все случаи, когда модель ошиблась.Откуда вы знаете, что модель ошиблась? Вы же весь этот тред утверждаете, что понятия не имеете распознала сеть что-то или нет.

Я всё больше склоняюсь к тому, что вы создали какую-то специфическую структуру данных и просто подгоняете её под входной образ. Только к ИИ это не имеет отношение, если она не производит сжатие.

Точнее, визуализировать можно, но что это значит для нейронной сети, сказать нельзя.

Даже, когда группа не активна, она меняется. Может измениться так, что будет соответствовать другому индексу.

А то что сделали вы называется Computer Vision, а не AI.

Если по существу, то вот Питерский математик, который дает очень оригинальную концепцию работы нашего мозга.

Удачи в ваших начинаниях!

А интеллект — это качественный показатель.

Обывательская реализация Искусственного Интеллекта