Комментарии 20

Википедия подсказывает, что размер нейрона от 5 до 150 мкм. Т.е на этом скане должны быть хорошо видны отдельные нейроны?

А вот синапсы в толщину порядка 100нм, т.е. точность сканирования нужно поднимать еще минимум в 10 раз? Или на этом скане уже можно как-то отследить все синапсы мозга?

Если так, то возможно когда-то в будущем получится загрузить эту модель мозга в комп и восстановить нервную активность этой женщины?

А вот синапсы в толщину порядка 100нм, т.е. точность сканирования нужно поднимать еще минимум в 10 раз? Или на этом скане уже можно как-то отследить все синапсы мозга?

Если так, то возможно когда-то в будущем получится загрузить эту модель мозга в комп и восстановить нервную активность этой женщины?

0

НЛО прилетело и опубликовало эту надпись здесь

Я как-то «работал» по распознаванию сканов срезов нервной ткани там разрешение было если не путаю 0.25 мкм на пиксель (но отсканирован с таким качеством был не целый мозг а только отдельные совсем небольшие кусочки)

Да сами нейроны(тело нейрона) там получаются огромными и легко определимыми. Аксоны и дендриты нейронов имеют диаметры порядка нескольких мкм и тоже относительно неплохо различимы на таких сканах, но из-за их жуткого и плотного переплетения во всех 3х измерениях по стопке полупрозрачных плоских срезов зачастую затруднительно разобрать где и как они изгибаются, где пересекаются с другими без контакта(просто проходят рядом), а где имеют контакт (образуют синапс).

При этом клетки зачастую деформированы или смещены от исходного положения на срезах оказываются (лезвие делающее тончайшие срезы все-таки не идеально, хоть и используется лучшее из доступного), что дополнительно усложняет задачу.

Алгоритмы и ИНС для автоматического распознавания образов сильно лажают и не могут нормально в автоматическом режиме восстановить карту связей по таким сканам. Для чего собственно и привлекали людей (добровольцев) разбирать эту жуткую кашу — человеческий мозг в таких зачах все еще намного лучше компьютеров.

Но с людьми другая проблема — очень медленно это все. На точное картирование кусочка ткани буквально с несколькими сотнями нейронов уходят целые человеко-годы ручной однообразной работы.

Да сами нейроны(тело нейрона) там получаются огромными и легко определимыми. Аксоны и дендриты нейронов имеют диаметры порядка нескольких мкм и тоже относительно неплохо различимы на таких сканах, но из-за их жуткого и плотного переплетения во всех 3х измерениях по стопке полупрозрачных плоских срезов зачастую затруднительно разобрать где и как они изгибаются, где пересекаются с другими без контакта(просто проходят рядом), а где имеют контакт (образуют синапс).

При этом клетки зачастую деформированы или смещены от исходного положения на срезах оказываются (лезвие делающее тончайшие срезы все-таки не идеально, хоть и используется лучшее из доступного), что дополнительно усложняет задачу.

Алгоритмы и ИНС для автоматического распознавания образов сильно лажают и не могут нормально в автоматическом режиме восстановить карту связей по таким сканам. Для чего собственно и привлекали людей (добровольцев) разбирать эту жуткую кашу — человеческий мозг в таких зачах все еще намного лучше компьютеров.

Но с людьми другая проблема — очень медленно это все. На точное картирование кусочка ткани буквально с несколькими сотнями нейронов уходят целые человеко-годы ручной однообразной работы.

+1

Спасибо за ответ! Очень интересно.

Но ведь технологии развиваются, вполне возможно через n-лет будут делать полные сканы с разрешением 0,01 мкм… тогда наверное и автоматические алгоритмы справятся?

Еще такой вопрос, а при замораживании, подобные структуры сохраняют свою целостность? Те люди кто заказали посмертную заморозку мозга, хотя бы в теории, могут быть в будущем «воскрешены», путем сканирования мозга и воссоздания его работы? Или заморозка приводит к необратимой порче материала, например, если кристаллы льда разрывают нервные связи?

Но ведь технологии развиваются, вполне возможно через n-лет будут делать полные сканы с разрешением 0,01 мкм… тогда наверное и автоматические алгоритмы справятся?

Еще такой вопрос, а при замораживании, подобные структуры сохраняют свою целостность? Те люди кто заказали посмертную заморозку мозга, хотя бы в теории, могут быть в будущем «воскрешены», путем сканирования мозга и воссоздания его работы? Или заморозка приводит к необратимой порче материала, например, если кристаллы льда разрывают нервные связи?

0

Да, с увеличением разрешения работать алгоритмам легче и при достаточно высоком разрешении со временем наверно получится автоматизировать оцифровку или по крайней мере основную ее часть, а человек будет проводить только инспекцию и по мере необходимости правку мест, в которых у компьютера возникают затруднения (как например сейчас OCR программы могут отмечать буквы/слова вызывающие у них сложности, но 99.9% объема при этом обрабатывают на автомате корректно).

Компьютерному анализу нужна большая избыточность информации, он в отличии от человека по 2-3 пикселям понять и восстановить исходную картинку не может. А человек обычно может — т.к. смотрит не только на эти 2-3 пикселя, но прилегающие области, заглянет в соседние слои (выше/ниже), повращает во всех проекциях под разными углами, мысленно представит возможные варианты (что тут могло быть изначально — как дендрит проходил давший такой такой отпечаток на скане, мог он например тут на 270 градусов назад развернуться или же это кусочек от соседнего прилип, или же это нож нарезавший слои его порвал и смял, а на самом деле он проходил по другому почти прямо и вот те 4 пикселя рядом это его оторванное продолжение и т.д.), сравнит со своим опытом и выберет правильный вариант отбросив другие как невозможные.

Все это в формальных алгоритмах описать проблематично. Но такой опыт людей и результаты их работы сейчас например пробуют использовать для обучения искусственных нейронных сетей, чтобы потом их использовать для автоматической реконструкции структуры по сканам имитируя подобный сложный «творческий» подход человека.

С простым увеличением разрешения есть как технологические проблемы — как тонко нарезать и точно сканировать так и IT пробемы (как всю полученную информацию анализировать).

Но с технологией увеличения разрешения уже есть неплохие идеи как дальше двигаться — например предлагают мозг замораживать в жидком азоте и вместо нарезки мягких слоев свехтонкими и сверхострыми лезвиями(например используются сапфировые лезвия с лазерной заточкой), сошлифовывать самый тонкий верхний слои, сканировать, сошлифовывать следующий слой, опять сканировать и т.д.

Заморозка позволит избежать упомянутой в прошлом сообщении проблемы небольших деформации/смещений клеток при нарезке в мягком мозге сделав его твердым и практически недеформируемым.

При этом шлифовку (снятие слоев) рассматривают как механическую(тонкими абразивами), так и послойное испарение лучом импульсного лазера(вроде пока не очень получается — лазер слишком сильно поверхность разрушает, получается даже хуже чем хорошими механическими лезвиями) так и пучком разогнанных в небольшом ускорителе ионов имитирующих лезвие (тяжелые ионы в отличии от лазера не столько разогревают и испаряют материал, сколько отрывают и уносят частицы с него практически механически).

Но кроме этих технологических задач и вопрос обработки данных очень остро стоит.

Допустим научились замороженный мозг отслаивать по 0.01 мкм (10 нм) почти не повреждая остающуюся поверхность и сканировать с аналогичным разрешением(10 нм/пиксель) открывающиеся срезы. Ну, например, автоматизированным электронным микроскопом — оптические приборы тут уже бесполезны будут, но электронный микроскоп-сканер нужную точность может дать.

Объем мозга человека порядка 1500 см3. Если его целиком (а не какой-то кусочек для эксперимента/отладки технологии) сканировать с подобным разрешением, то 1 кубик после оцифровки будет представлять собой 3д массив с 1 млн. элементов по каждой размерности. А полная оцифрованная копия мозга до преобразования в более компактную модель будет иметь размер 1500*1000000^3 = 1.5*10^21 вокселей (3д пикселей)

Если кодировать хотя бы 1 байтом на воксель (256 градаций серого), то это… 1 364 242 052 ТБ данных на один единственный мозг.

Ну округлим немного — порядка 1 ЗеттаБайта данных на мозг!

Таким объемом данных даже крупнейшие суперкомпьютеры Земли подавятся без шансов их обработать. Наш текущий предел для масштабных вычислительных систем это порядка 1 Петабайта оперативной памяти и 10 Петабайт емкости накопителей. Т.е. 0.0001% и 0.001% соответственно от необходимых объемов. Это без учета скорости и времени обработки.

Сама модель после распознавания образов будет на порядки компактнее, но вот объем «сырых»(RAW) данных которые нужно сначала сохранить (при сканировании) и потом обработать именно такого порядка.

Так что нестись «в лобовую атаку» за максимальным разрешением тоже не лучшая идея — даже если все получится, то сейчас(и в обозримом будущем) будет просто нечем соответствующие объемы данных сохранять и обрабатывать.

Даже указанные мною 0.25 мкм/пиксель (уже довольно давно доступные на практике) если бы оцифровывали не мелкие образцы, а мозг целиком дали бы 1500*40000^3 = 9.6 * 10^16 вокселей или 87 000 ТБ данных. Т.е. 10 тысяч топовых жестких дисков.

Поэтому пока основные усилия прилагаются к совершенствованию алгоритмов обработки данных, а не на увеличение разрешения исходных данных.

Насчет заморозки — вроде уже научились с этой проблемой более-менее бороться. Успешных экспериментов по «оживлению» после глубокой (азотной) заморозки насколько знаю пока еще не было, но сильного разрушения клеток кристаллами льда уже научились избегать вводя какие-то препараты в кровь непосредственно перед заморозкой. Так что не факт, что организм можно будет восстановить как живое и целое, но вот мешать сканированию и оцифровке (если уровня нейронов и синапсов достаточно и что-то важное не скрывается на еще более глубоких слоях) заморозка не помешает.

Компьютерному анализу нужна большая избыточность информации, он в отличии от человека по 2-3 пикселям понять и восстановить исходную картинку не может. А человек обычно может — т.к. смотрит не только на эти 2-3 пикселя, но прилегающие области, заглянет в соседние слои (выше/ниже), повращает во всех проекциях под разными углами, мысленно представит возможные варианты (что тут могло быть изначально — как дендрит проходил давший такой такой отпечаток на скане, мог он например тут на 270 градусов назад развернуться или же это кусочек от соседнего прилип, или же это нож нарезавший слои его порвал и смял, а на самом деле он проходил по другому почти прямо и вот те 4 пикселя рядом это его оторванное продолжение и т.д.), сравнит со своим опытом и выберет правильный вариант отбросив другие как невозможные.

Все это в формальных алгоритмах описать проблематично. Но такой опыт людей и результаты их работы сейчас например пробуют использовать для обучения искусственных нейронных сетей, чтобы потом их использовать для автоматической реконструкции структуры по сканам имитируя подобный сложный «творческий» подход человека.

С простым увеличением разрешения есть как технологические проблемы — как тонко нарезать и точно сканировать так и IT пробемы (как всю полученную информацию анализировать).

Но с технологией увеличения разрешения уже есть неплохие идеи как дальше двигаться — например предлагают мозг замораживать в жидком азоте и вместо нарезки мягких слоев свехтонкими и сверхострыми лезвиями(например используются сапфировые лезвия с лазерной заточкой), сошлифовывать самый тонкий верхний слои, сканировать, сошлифовывать следующий слой, опять сканировать и т.д.

Заморозка позволит избежать упомянутой в прошлом сообщении проблемы небольших деформации/смещений клеток при нарезке в мягком мозге сделав его твердым и практически недеформируемым.

При этом шлифовку (снятие слоев) рассматривают как механическую(тонкими абразивами), так и послойное испарение лучом импульсного лазера(вроде пока не очень получается — лазер слишком сильно поверхность разрушает, получается даже хуже чем хорошими механическими лезвиями) так и пучком разогнанных в небольшом ускорителе ионов имитирующих лезвие (тяжелые ионы в отличии от лазера не столько разогревают и испаряют материал, сколько отрывают и уносят частицы с него практически механически).

Но кроме этих технологических задач и вопрос обработки данных очень остро стоит.

Допустим научились замороженный мозг отслаивать по 0.01 мкм (10 нм) почти не повреждая остающуюся поверхность и сканировать с аналогичным разрешением(10 нм/пиксель) открывающиеся срезы. Ну, например, автоматизированным электронным микроскопом — оптические приборы тут уже бесполезны будут, но электронный микроскоп-сканер нужную точность может дать.

Объем мозга человека порядка 1500 см3. Если его целиком (а не какой-то кусочек для эксперимента/отладки технологии) сканировать с подобным разрешением, то 1 кубик после оцифровки будет представлять собой 3д массив с 1 млн. элементов по каждой размерности. А полная оцифрованная копия мозга до преобразования в более компактную модель будет иметь размер 1500*1000000^3 = 1.5*10^21 вокселей (3д пикселей)

Если кодировать хотя бы 1 байтом на воксель (256 градаций серого), то это… 1 364 242 052 ТБ данных на один единственный мозг.

Ну округлим немного — порядка 1 ЗеттаБайта данных на мозг!

Таким объемом данных даже крупнейшие суперкомпьютеры Земли подавятся без шансов их обработать. Наш текущий предел для масштабных вычислительных систем это порядка 1 Петабайта оперативной памяти и 10 Петабайт емкости накопителей. Т.е. 0.0001% и 0.001% соответственно от необходимых объемов. Это без учета скорости и времени обработки.

Сама модель после распознавания образов будет на порядки компактнее, но вот объем «сырых»(RAW) данных которые нужно сначала сохранить (при сканировании) и потом обработать именно такого порядка.

Так что нестись «в лобовую атаку» за максимальным разрешением тоже не лучшая идея — даже если все получится, то сейчас(и в обозримом будущем) будет просто нечем соответствующие объемы данных сохранять и обрабатывать.

Даже указанные мною 0.25 мкм/пиксель (уже довольно давно доступные на практике) если бы оцифровывали не мелкие образцы, а мозг целиком дали бы 1500*40000^3 = 9.6 * 10^16 вокселей или 87 000 ТБ данных. Т.е. 10 тысяч топовых жестких дисков.

Поэтому пока основные усилия прилагаются к совершенствованию алгоритмов обработки данных, а не на увеличение разрешения исходных данных.

Насчет заморозки — вроде уже научились с этой проблемой более-менее бороться. Успешных экспериментов по «оживлению» после глубокой (азотной) заморозки насколько знаю пока еще не было, но сильного разрушения клеток кристаллами льда уже научились избегать вводя какие-то препараты в кровь непосредственно перед заморозкой. Так что не факт, что организм можно будет восстановить как живое и целое, но вот мешать сканированию и оцифровке (если уровня нейронов и синапсов достаточно и что-то важное не скрывается на еще более глубоких слоях) заморозка не помешает.

+2

Спасибо за подробный ответ!

Приятно, что хотя бы в теории, задача решается))

Объемы конечно фантастические, но по идее и не обязательно все хранить в «сыром» виде, чтобы получить модель. Уже получая очередной скан с микроскопа можно сразу отсеивать определенные области где такое качество избыточно.

Скажем тело нейрона на скане будет занимать сотни тысяч пикселей, тогда как программе распознавания достаточно сохранить только его очертания в векторной форме с неким приближением.

Конечно придется разработать специальный формат хранения, возможно обрабатывать слои не по одному, а хранить очередь из нескольких дампов, и обрабатывать средний, периодически «подсматривая» в соседние…

Вероятно будет некий стек для нейронов и синапсов которые распознаются на текущем этапе, и на каждом скане будут определяться новые элементы, а для существующих — будут корректироваться их характеристики (пространственные углы, векторные формы на нескольких предыдущих слоях и т.п.). Завершенные элементы уже будут сохраняться в базу.

В общем тут уже дело разработки алгоритма. И вероятнее всего распознавание конечно будет на базе нейронной сети. Даже если будет какой-то (очень небольшой) процент неправильных срабатываний — вероятно искусственный мозг сможет самовосстановиться, ведь выживают люди при различных ранениях, операциях на мозге и т.п. Главное, в принципе — это возможно) Есть смысл замораживаться, в случае чего)

Приятно, что хотя бы в теории, задача решается))

Объемы конечно фантастические, но по идее и не обязательно все хранить в «сыром» виде, чтобы получить модель. Уже получая очередной скан с микроскопа можно сразу отсеивать определенные области где такое качество избыточно.

Скажем тело нейрона на скане будет занимать сотни тысяч пикселей, тогда как программе распознавания достаточно сохранить только его очертания в векторной форме с неким приближением.

Конечно придется разработать специальный формат хранения, возможно обрабатывать слои не по одному, а хранить очередь из нескольких дампов, и обрабатывать средний, периодически «подсматривая» в соседние…

Вероятно будет некий стек для нейронов и синапсов которые распознаются на текущем этапе, и на каждом скане будут определяться новые элементы, а для существующих — будут корректироваться их характеристики (пространственные углы, векторные формы на нескольких предыдущих слоях и т.п.). Завершенные элементы уже будут сохраняться в базу.

В общем тут уже дело разработки алгоритма. И вероятнее всего распознавание конечно будет на базе нейронной сети. Даже если будет какой-то (очень небольшой) процент неправильных срабатываний — вероятно искусственный мозг сможет самовосстановиться, ведь выживают люди при различных ранениях, операциях на мозге и т.п. Главное, в принципе — это возможно) Есть смысл замораживаться, в случае чего)

0

Ну частями конечно можно и предварительную обработку делать тоже можно (препроцессинг) чтобы резко сократить объем сохраняемых данных, но все-равно для текущих технологий слишком много данных — даже для препроцессинга все-равно нужно полные сырые данные в указанном объеме снять и передать на кластер хотя бы для предварительной обработки и пересохранения в промежуточный более компактный формат.

Допустим хотим за месяц (целый месяц непрерывной круглосуточной работы! при этом мозг еще все это время постоянно жидким азотом поливается, чтобы не оттаивал раньше времени) отсканировать. Тогда непрерывный поток данных с микроскопа-сканера будет 1364242052/(30*24*60*60) = 526 ТБ в секунду / 4 Петабит/с в течении всего этого месяца

Это в разы больше чем весь мировой поток трафика всей сети Интернет — все виды данных передающиеся по всем магистральным каналам вместе взятым.

Ну а уж обработать хотя бы по самым простым алгоритмам такой поток графических данных (~500 Террапикселей/с — примерно как 8 милиллионов параллельных потоков несжатого видео в FullHD формате) в реальном времени — это вообще пока фантастика и за гранью обозримых перспектив.

Если не будет революционных скачков в производительности вычислений, объемах памяти и пропускной способности шин, то более-менее реалистичный вариант это только реализовывать предварительную грубую обработку (снижающую объем сырых данных хотя бы на 2 порядка) прямо внутри сканера (т.е. не передавая никуда данные) при помощи специально заточенных специализированных чипов (ASIC — аппаратная реализация одного конкретного алгоритма), сидящих прямо в одном устройстве прямо на сенсорах. И уже сильно обработанные и ужатые данные пересылать на обработку на суперкомпьютер для построения полной модели.

Насчет слоев — всегда нужно будет не просто в несколько соседних подглядывать, а придется работать сразу с большим количеством слое. В ПО которым я пользовался работа шла сразу со «стопкой» от 64 до 256 слоев (которые крутились колесиком мыши — получается анимация чем-то похожая на МРТ, только с больше чем порядок лучшим разрешением) и даже этого зачастую было маловато(оно было специально ограничено, чтобы шустро работать на обычной персоналке или ноутбуке — весь пакет должен в оперативке помещаться одновременно) — постоянно отростки уходили за края и их нужно отмечать как пересекающие границу блока, чтоб те люди кто будет обработкой соседнего блока сканов заниматься сразу понимали, что в этом месте к ним отросток из соседнего блока приходит из выше/ниже лежащих слоев.

Нейроны они же заразы не в курсе что их потом плоскими слоями снимать будут и поэтому растут произвольно не вдоль этого слоя, а в любом из 3х измерений и поэтому их аксоны и дендриты очень часто проходят почти перпендикулярно сечению среза (на скане они в этом случае выглядят как маленькие кружочки или овальчики вместо длинных полосок и «усиков»). Чтобы определить как выглядит и как проходил такой отросток надо от десятков до сотен соседних слоев просматривать одновременно.

С увеличением разрешения кол-во одновременно обрабатываемых слоев будет расти, т.к для адекватного распознавания пачка слоев должна охватывать хотя бы область равную средней длине дендритов у нейрона. Это порядка 0.2-1 мм, т.е. при разрешении 10нм это от 20 до 100 тыс. слоев.

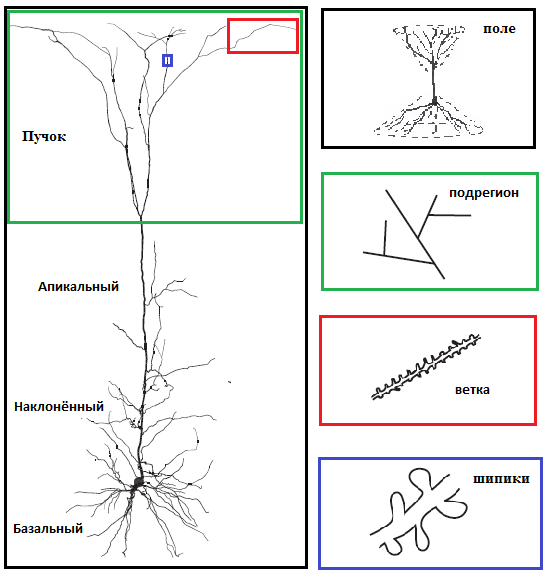

Иначе если имеем вот такой нейрон(а это как раз типичный пример из наиболее интересной области — коры головного мозга) растущий преимущественно перпендикуляно плоскости сечений понять как и к чему он был подключен будет крайней проблематично:

(Мысленно рассекайте этот нейрон на тысячи слоев горизонтальными плоскостями — тогда на каждом слое ценральный отросток этого нейрона будет лишь крохотным кружочком. и чтобы определить, что это на самом деле длинный ветвящийся отросток нужно все эти тысячи слоев разом просмотреть/обработать)

А ведь у нейронов бывают еще и очень длинные аксоны длинной в несколько сантиметров, которые миллионы слоев пройти насквозь могут… Так что видимо только обработка в несколько стадий (проходов), первый с небольшой глубиной по слоям (тысячи-десятки тысяч соседних слоев), где распознаются все «горизонтальные» (направленные преимущественно вдоль сечений срезов) связи и локальные вертикальные связи, переводятся в компактный векторный формат. Потом такие «облегченные» уже частично векторизованные слои уже миллионами и десятков миллионов обрабатываются совместно на суперкомпьютере — чтобы распознавать длинные нелокальные связи.

А точность да, есть надежда что сверхвысокая точность не обязательна. У мозга довольно большая избыточность и пластичность. Во многом он вообще признаки подобные голографической организации данных демонстрирует, когда умеренные повреждения носителя не уничтожают какую-то конкретную информацию, а лишь приводят к общему ее размытию (снижению точности/четкости).

Поэтому единичные ошибки в отдельных связях большого значения иметь не должны.

Ну а пока дейсвительно только и остается что работать над алгоритмами. Т.к. «в лоб» задача в обозримой перспективе не решаема.

Так же как например задача фолдинга белка (определения 3д структуры и функций белка по известной ДНК последовательности его кодирующей). В «лоб» прямым моделированием она не решается кроме самых простейших и примитивных белков(про которые обычно и так уже все хорошо известно) — данных совсем немного, но вот в плане вычислительных мощностей даже топовые суперкомпьютеры слишком слабы. Но и с использованием хитрых и сложных алгоритмов выходит получать приблизительные (но уже достаточно точные для многих практических применений) решения уже сейчас.

Допустим хотим за месяц (целый месяц непрерывной круглосуточной работы! при этом мозг еще все это время постоянно жидким азотом поливается, чтобы не оттаивал раньше времени) отсканировать. Тогда непрерывный поток данных с микроскопа-сканера будет 1364242052/(30*24*60*60) = 526 ТБ в секунду / 4 Петабит/с в течении всего этого месяца

Это в разы больше чем весь мировой поток трафика всей сети Интернет — все виды данных передающиеся по всем магистральным каналам вместе взятым.

Ну а уж обработать хотя бы по самым простым алгоритмам такой поток графических данных (~500 Террапикселей/с — примерно как 8 милиллионов параллельных потоков несжатого видео в FullHD формате) в реальном времени — это вообще пока фантастика и за гранью обозримых перспектив.

Если не будет революционных скачков в производительности вычислений, объемах памяти и пропускной способности шин, то более-менее реалистичный вариант это только реализовывать предварительную грубую обработку (снижающую объем сырых данных хотя бы на 2 порядка) прямо внутри сканера (т.е. не передавая никуда данные) при помощи специально заточенных специализированных чипов (ASIC — аппаратная реализация одного конкретного алгоритма), сидящих прямо в одном устройстве прямо на сенсорах. И уже сильно обработанные и ужатые данные пересылать на обработку на суперкомпьютер для построения полной модели.

Насчет слоев — всегда нужно будет не просто в несколько соседних подглядывать, а придется работать сразу с большим количеством слое. В ПО которым я пользовался работа шла сразу со «стопкой» от 64 до 256 слоев (которые крутились колесиком мыши — получается анимация чем-то похожая на МРТ, только с больше чем порядок лучшим разрешением) и даже этого зачастую было маловато(оно было специально ограничено, чтобы шустро работать на обычной персоналке или ноутбуке — весь пакет должен в оперативке помещаться одновременно) — постоянно отростки уходили за края и их нужно отмечать как пересекающие границу блока, чтоб те люди кто будет обработкой соседнего блока сканов заниматься сразу понимали, что в этом месте к ним отросток из соседнего блока приходит из выше/ниже лежащих слоев.

Нейроны они же заразы не в курсе что их потом плоскими слоями снимать будут и поэтому растут произвольно не вдоль этого слоя, а в любом из 3х измерений и поэтому их аксоны и дендриты очень часто проходят почти перпендикулярно сечению среза (на скане они в этом случае выглядят как маленькие кружочки или овальчики вместо длинных полосок и «усиков»). Чтобы определить как выглядит и как проходил такой отросток надо от десятков до сотен соседних слоев просматривать одновременно.

С увеличением разрешения кол-во одновременно обрабатываемых слоев будет расти, т.к для адекватного распознавания пачка слоев должна охватывать хотя бы область равную средней длине дендритов у нейрона. Это порядка 0.2-1 мм, т.е. при разрешении 10нм это от 20 до 100 тыс. слоев.

Иначе если имеем вот такой нейрон(а это как раз типичный пример из наиболее интересной области — коры головного мозга) растущий преимущественно перпендикуляно плоскости сечений понять как и к чему он был подключен будет крайней проблематично:

(Мысленно рассекайте этот нейрон на тысячи слоев горизонтальными плоскостями — тогда на каждом слое ценральный отросток этого нейрона будет лишь крохотным кружочком. и чтобы определить, что это на самом деле длинный ветвящийся отросток нужно все эти тысячи слоев разом просмотреть/обработать)

А ведь у нейронов бывают еще и очень длинные аксоны длинной в несколько сантиметров, которые миллионы слоев пройти насквозь могут… Так что видимо только обработка в несколько стадий (проходов), первый с небольшой глубиной по слоям (тысячи-десятки тысяч соседних слоев), где распознаются все «горизонтальные» (направленные преимущественно вдоль сечений срезов) связи и локальные вертикальные связи, переводятся в компактный векторный формат. Потом такие «облегченные» уже частично векторизованные слои уже миллионами и десятков миллионов обрабатываются совместно на суперкомпьютере — чтобы распознавать длинные нелокальные связи.

А точность да, есть надежда что сверхвысокая точность не обязательна. У мозга довольно большая избыточность и пластичность. Во многом он вообще признаки подобные голографической организации данных демонстрирует, когда умеренные повреждения носителя не уничтожают какую-то конкретную информацию, а лишь приводят к общему ее размытию (снижению точности/четкости).

Поэтому единичные ошибки в отдельных связях большого значения иметь не должны.

Ну а пока дейсвительно только и остается что работать над алгоритмами. Т.к. «в лоб» задача в обозримой перспективе не решаема.

Так же как например задача фолдинга белка (определения 3д структуры и функций белка по известной ДНК последовательности его кодирующей). В «лоб» прямым моделированием она не решается кроме самых простейших и примитивных белков(про которые обычно и так уже все хорошо известно) — данных совсем немного, но вот в плане вычислительных мощностей даже топовые суперкомпьютеры слишком слабы. Но и с использованием хитрых и сложных алгоритмов выходит получать приблизительные (но уже достаточно точные для многих практических применений) решения уже сейчас.

+1

Очень интересно!

Полагаю все же многие задачи упростятся когда сильно возрастет точность сканирования. Как при анализе спутниковых снимков. На разрешении 20м/пиксель отличить домик от дерева — сможет только человек так как кроме сероватого пикселя он обратит внимание на дороги рядом, форму тени и т.п. Но увеличим разрешение в 25 раз, и с задачей справится несложная программа.

Также и тут. На срезе в 0,25мкм, да еще на котором были смещения и сдвиги при резке — крайне проблематично отследить объекты размером 2-3 мкм. и меньше. В перпендикулярном синапсу срезе будет маленький кружок на разных слоях, еще и смещенных друг относительно друга…

Но при снятии, как вы описали, слоя пучком ионов, без каких-либо смещений, на скане с разрешением в 25 раз выше — все может оказаться проще. На экране монитора (72dpi) поперечный срез синапса был бы кругом с диаметром в 10 см… На таком качестве — не так сложно обучить сканер распознавать границы между телом (нейрона/синапса) и окружающим пространством. Вполне возможно, что сканер даже не будет получать «фотографию», а сразу измерять преломление (плотность/прозрачность/...) участка и записывать бит при изменении этого параметра. Т.е. на выходе мы получим не дамп сканируемой строки, а набор расстояний между границами. Объем данных должен сократиться на много порядков.

На выходе сканера — можно сразу переводить границы в вектор, и в таком виде сопоставлять с соседними слоями и распознавать направление.

Полагаю все же многие задачи упростятся когда сильно возрастет точность сканирования. Как при анализе спутниковых снимков. На разрешении 20м/пиксель отличить домик от дерева — сможет только человек так как кроме сероватого пикселя он обратит внимание на дороги рядом, форму тени и т.п. Но увеличим разрешение в 25 раз, и с задачей справится несложная программа.

Также и тут. На срезе в 0,25мкм, да еще на котором были смещения и сдвиги при резке — крайне проблематично отследить объекты размером 2-3 мкм. и меньше. В перпендикулярном синапсу срезе будет маленький кружок на разных слоях, еще и смещенных друг относительно друга…

Но при снятии, как вы описали, слоя пучком ионов, без каких-либо смещений, на скане с разрешением в 25 раз выше — все может оказаться проще. На экране монитора (72dpi) поперечный срез синапса был бы кругом с диаметром в 10 см… На таком качестве — не так сложно обучить сканер распознавать границы между телом (нейрона/синапса) и окружающим пространством. Вполне возможно, что сканер даже не будет получать «фотографию», а сразу измерять преломление (плотность/прозрачность/...) участка и записывать бит при изменении этого параметра. Т.е. на выходе мы получим не дамп сканируемой строки, а набор расстояний между границами. Объем данных должен сократиться на много порядков.

На выходе сканера — можно сразу переводить границы в вектор, и в таком виде сопоставлять с соседними слоями и распознавать направление.

0

Проблема что какого-то «оружающего пространства» практически нет. На рисунке выше изображен 1 нейрон со всеми отростками, но изолированно. Но в реальности весь этот объем со всех сторон вокруг него заполнен (причем битком вплотную с максимальной плотностью) отростками соседних нейронов. И надо анализировать не только наличие границы, но и какая она эта граница (мембрана) — отростки почти по всей длине прижаты ко множеству соседних отростков (от других нейронов, хотя иногда встречаются связи и между разными отростками одного нейрона), но только в некоторых местах образуют контактую связь (синапс), в других просто идут рядом практически касаясь мембранами друг друга.

Соответственно надо эту границу внимательно исследовать и алгоритму там будет трудновато — размеры синапсов несколько сотен нм, синаптическая щель 10-50 нм в ширину и не намного больше в длину. Т.е. даже при разрешении 10нм/пиксель это будет анализ по картинке уровня 10х10 точек в которую уложатся 2 мембраны (от аксонов/дендритов 2 соседних нейронов) и зазор между ними через который передается сигнал. Надо определить что тут синапс вообще есть (самое главное), а так же хотя бы примерно оценить его «силу». Ну или хотя бы опознать, чтобы не «сжать» его до 1 бита(потеряв информацию) и оставить эту область в исходном формате для анализа алгоритмами более высокого порядка.

Собственно сами нейроны (тело) занимают порядка 1% объема или меньше. Считанные % приходится на межклеточное пространство. А порядка 90% объема это адский клубок из отростков, увидев который задохнулся бы от зависти сам ЛММ. Ну и популярные в интернете фото из разряда «ад сетевого администратора» (огромные пуки беспорядочно перепутанных проводов из витой пары и оптических патчей) это образец простоты и порядка.

Насчет сканера — ну примерно это я имел ввиду, когда писал про ASIC чипы для сканера. Подобный первичный алгоритм обработки после его разработки и тестирования на обычных процессорах (в виде ПО) придется реализовывать аппаратно как ASIC-чипы (или аппаратную нейронную сеть на нейроморфных чипах, если это будет нейроалгоритм получившийся путем тренировки ИНС) и запихивать прямо внутрь сканера.

Т.к. на обычных процессорах даже будущих поколений либо не хватит выч. мощности для обработки такого объема данных либо не пройдет по ограничениям на физические габариты и потребление энергии/тепловыделение при распараллеливании (невозможно нужную выч. мощность вложить в сам сканер — а для внешнего обработчика опять упираемся в требуемые объемы памяти и пропускную способность каналов передачи данных).

А так, за счет ASIC или нейроморфных чипов с аппаратной реализацией есть хотя бы в теории возможность решить туже же задачу используя в 100-1000 раз меньше энергии/мощности и реализовать препроцессинг в самом сканере…

И тогда на выходе будут уже более вменяемых объемы данных, которые со временем возможно будет передать по каналам связи и переработать на суперкомпьютерах недалекого будущего в полную модель целого мозга.

Соответственно надо эту границу внимательно исследовать и алгоритму там будет трудновато — размеры синапсов несколько сотен нм, синаптическая щель 10-50 нм в ширину и не намного больше в длину. Т.е. даже при разрешении 10нм/пиксель это будет анализ по картинке уровня 10х10 точек в которую уложатся 2 мембраны (от аксонов/дендритов 2 соседних нейронов) и зазор между ними через который передается сигнал. Надо определить что тут синапс вообще есть (самое главное), а так же хотя бы примерно оценить его «силу». Ну или хотя бы опознать, чтобы не «сжать» его до 1 бита(потеряв информацию) и оставить эту область в исходном формате для анализа алгоритмами более высокого порядка.

Собственно сами нейроны (тело) занимают порядка 1% объема или меньше. Считанные % приходится на межклеточное пространство. А порядка 90% объема это адский клубок из отростков, увидев который задохнулся бы от зависти сам ЛММ. Ну и популярные в интернете фото из разряда «ад сетевого администратора» (огромные пуки беспорядочно перепутанных проводов из витой пары и оптических патчей) это образец простоты и порядка.

Насчет сканера — ну примерно это я имел ввиду, когда писал про ASIC чипы для сканера. Подобный первичный алгоритм обработки после его разработки и тестирования на обычных процессорах (в виде ПО) придется реализовывать аппаратно как ASIC-чипы (или аппаратную нейронную сеть на нейроморфных чипах, если это будет нейроалгоритм получившийся путем тренировки ИНС) и запихивать прямо внутрь сканера.

Т.к. на обычных процессорах даже будущих поколений либо не хватит выч. мощности для обработки такого объема данных либо не пройдет по ограничениям на физические габариты и потребление энергии/тепловыделение при распараллеливании (невозможно нужную выч. мощность вложить в сам сканер — а для внешнего обработчика опять упираемся в требуемые объемы памяти и пропускную способность каналов передачи данных).

А так, за счет ASIC или нейроморфных чипов с аппаратной реализацией есть хотя бы в теории возможность решить туже же задачу используя в 100-1000 раз меньше энергии/мощности и реализовать препроцессинг в самом сканере…

И тогда на выходе будут уже более вменяемых объемы данных, которые со временем возможно будет передать по каналам связи и переработать на суперкомпьютерах недалекого будущего в полную модель целого мозга.

0

А как насчёт статистической достоверности? Ведь это мозг одного человека — со своими индивидуальными особенностями.

0

Профессор Савельев должен быть счастлив, ведь как он утверждает, теперь людей можно будет подвергнуть церебральному сорсингу и отобрать гениев и талантливых людей от социального мусора. Евгеника в завуалированном виде, но, чтото мне подсказывает, что профессор Савельев шарлатан.

0

Савельев С.В. утверждает, что необходимо разрешение томографа увеличить до 1 микрон, чтобы были видны не только границы полей и подполей, но и синаптические связи между нейронами. Сейчас для этого ведутся работы по совершенствованию рентгеновской оптики, но, по его словам, не в России. Тогда таким томографом можно будет определять предрасположенность к той или иной деятельности уже при жизни.

0

Савельев говорил о томографе, который позволит сканировать живого человека. Тут анализировались, всё таки, тонкие срезы.

Для изучения, конечно это интересно, но церебрального сортинга — пока далековато.

Для изучения, конечно это интересно, но церебрального сортинга — пока далековато.

чтото мне подсказывает, что профессор Савельев шарлатан.не знаю, пока всё что я смотрю у него — весьма и весьма логично и объясняет практически весь окружающий мир. С чем не справлялись — ни религия, ни психология — в коих я копался, пытаясь понять, почему мы (люди) поступают так, а не эдак.

0

кстати свежая презентация книги

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Впервые составлен полный атлас человеческого мозга с клеточным разрешением 1 мкм/пиксель