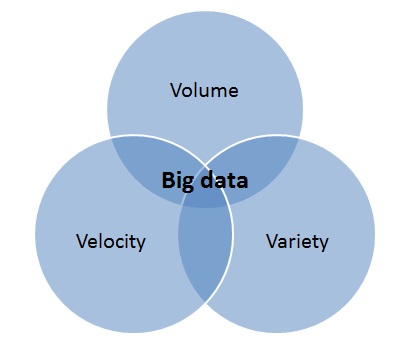

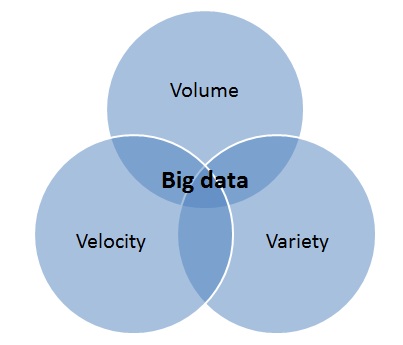

Рассматривая разные технологии хранения данных и решения, предлагаемые компанией LSI, мы немного подзабыли о практически-прикладном смысле этого всего. Зачем нужны все возрастающие скорости и емкости дисков? Одно из первых, приходящих в голову применений — это, конечно, Big Data или Большие данные. Чем же эти Большие данные отличаются от просто больших, чтоб заслужить написание с большой буквы? Обычно это называют «правило трех V».

Volume (объем) — логично, что «большие данные» в первую очередь отличаются большими объемами.

Velocity (скорость) — в данном случае имеется ввиду и скорость накопления этих данных, и необходимость в высокой скорости их обработки.

Variety (разнообразие) — данные бывают часто или плохо структурированы, или же структурированы они хорошо, но надо обрабатывать много разных структур одновременно.

Сам термин «Большие данные» появился относительно недавно, но уже надежно захватил лидирующие позиции в списке трендов современных IT-технологий. Как зачастую бывает, не всегда понятно, что стоит за модным термином, поэтому мы решили разобраться в этом на примерах, первым из которых будет прогнозирование погоды.

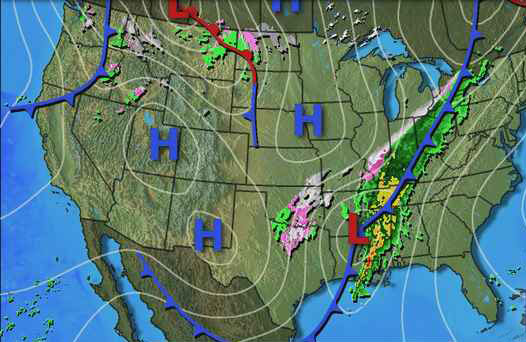

Мы все интересуемся прогнозами погоды: по телевизору, в Интернете, по радио. Прогнозы бывают верные и не очень, но сложно поспорить с простым фактом: чем большим архивом данных, как современных, так и исторических, вы обладаете — тем точнее будут ваши прогнозы на ближайшие часы, дни и даже недели.

Информация о множестве замеров множества параметров погоды в разных местах — как раз и представляет собой типичный пример Big Data. Обычно, для анализа огромного количества источников, используемых метеорологами, используется Apache Hadoop, так как его гибкость позволяет создать масштабируемые инструменты анализа, необходимые для того чтоб «причесать» и максимально использовать данные.

Специалисты в обработке метеорологических данных шутят, что погода порождает «ливень данных», особенно когда идет сбор информации по всему миру. Используя результаты наблюдений, мощнейшие суперкомпьютеры выполняют миллиарды расчетов для того чтоб смоделировать реальные процессы, происходящие в атмосфере, чтобы получить долгосрочные прогнозы для заданной точки Земли. Самым интересным оказался тот факт, что далеко не все модели одинаково хороши.

В то время как моделированием погоды занимаются многие компании и организации, Европейское сообщество метеорологов признано показывает наилучшие результаты. Именно благодаря превосходству в аппаратном и программном обеспечении, европейским площадкам удается добиться таких успехов. Американские специалисты в области анализа погоды почти всегда стараются включить данные коллег Старого Света в свои расчеты, и в случае конфликта своей модели и европейской — зачастую отдают предпочтение последней. Это во-первых подчеркивает ключевую роль информационных технологий и решений в области дата-майнинга в прогнозах погоды, и во-вторых показывает нам, что прогнозы погоды зачастую могут являться без преувеличения вопросом жизни и смерти, поэтому тут так важно сотрудничество.

Примером такой ситуации являлся ураган Сэнди (англ. Hurricane Sandy) — мощный тропический циклон, образовавшийся в конце октября 2012 года и затронувший Ямайку, Кубу, Багамские острова, Гаити, побережье Флориды и, впоследствии, северо-восток США и восточную Канаду.

Ураган нанес наиболее тяжёлый ущерб северо-восточным штатам США, в частности Нью-Джерси, Нью-Йорк и Коннектикут, но без полноценных прогнозов погоды и предсказаний, касавшихся этого урагана — ущерб был бы значительно больше. Практически безоговорочно, метеорологи США признали, что если бы хоть один, пусть даже маленький, источник данных был бы опущен в анализе движения Сэнди, точность предсказаний (например такой важный вопрос: где именно ураган «выйдет» на сушу) могла бы заметно снизиться, а это могло бы иметь катастрофические, а может даже и летальные последствия для многих людей.

На этом графике можно увидеть, как спустя 72 часа модель европейских метеорологов разительно вырвалась вперед в точности прогноза действий урагана.

Технология Hadoop хороша для анализа таких больших объемов данных, но при всех ее достоинствах, она хороша настолько, насколько ей это позволяет аппаратная часть систем анализа и обработки данных, и одним из ключевых характеристик, влияющих на эффективность Hadoop — является скорость работы дисковой подсистемы. Неважно, какие именно большие данные вы обрабатываете, будь это прогноз погоды, или, например, разработка вакцины от гриппа — одним из признанных во всем мире способов ускорить работу Hadoop являются решения LSI серии Nytro. Прочитать поподробней о том, как Nytro позволяет ускорить Hadoop и другие приложения, можно на сайте.

Volume (объем) — логично, что «большие данные» в первую очередь отличаются большими объемами.

Velocity (скорость) — в данном случае имеется ввиду и скорость накопления этих данных, и необходимость в высокой скорости их обработки.

Variety (разнообразие) — данные бывают часто или плохо структурированы, или же структурированы они хорошо, но надо обрабатывать много разных структур одновременно.

Сам термин «Большие данные» появился относительно недавно, но уже надежно захватил лидирующие позиции в списке трендов современных IT-технологий. Как зачастую бывает, не всегда понятно, что стоит за модным термином, поэтому мы решили разобраться в этом на примерах, первым из которых будет прогнозирование погоды.

Мы все интересуемся прогнозами погоды: по телевизору, в Интернете, по радио. Прогнозы бывают верные и не очень, но сложно поспорить с простым фактом: чем большим архивом данных, как современных, так и исторических, вы обладаете — тем точнее будут ваши прогнозы на ближайшие часы, дни и даже недели.

Информация о множестве замеров множества параметров погоды в разных местах — как раз и представляет собой типичный пример Big Data. Обычно, для анализа огромного количества источников, используемых метеорологами, используется Apache Hadoop, так как его гибкость позволяет создать масштабируемые инструменты анализа, необходимые для того чтоб «причесать» и максимально использовать данные.

Специалисты в обработке метеорологических данных шутят, что погода порождает «ливень данных», особенно когда идет сбор информации по всему миру. Используя результаты наблюдений, мощнейшие суперкомпьютеры выполняют миллиарды расчетов для того чтоб смоделировать реальные процессы, происходящие в атмосфере, чтобы получить долгосрочные прогнозы для заданной точки Земли. Самым интересным оказался тот факт, что далеко не все модели одинаково хороши.

В то время как моделированием погоды занимаются многие компании и организации, Европейское сообщество метеорологов признано показывает наилучшие результаты. Именно благодаря превосходству в аппаратном и программном обеспечении, европейским площадкам удается добиться таких успехов. Американские специалисты в области анализа погоды почти всегда стараются включить данные коллег Старого Света в свои расчеты, и в случае конфликта своей модели и европейской — зачастую отдают предпочтение последней. Это во-первых подчеркивает ключевую роль информационных технологий и решений в области дата-майнинга в прогнозах погоды, и во-вторых показывает нам, что прогнозы погоды зачастую могут являться без преувеличения вопросом жизни и смерти, поэтому тут так важно сотрудничество.

Примером такой ситуации являлся ураган Сэнди (англ. Hurricane Sandy) — мощный тропический циклон, образовавшийся в конце октября 2012 года и затронувший Ямайку, Кубу, Багамские острова, Гаити, побережье Флориды и, впоследствии, северо-восток США и восточную Канаду.

Ураган нанес наиболее тяжёлый ущерб северо-восточным штатам США, в частности Нью-Джерси, Нью-Йорк и Коннектикут, но без полноценных прогнозов погоды и предсказаний, касавшихся этого урагана — ущерб был бы значительно больше. Практически безоговорочно, метеорологи США признали, что если бы хоть один, пусть даже маленький, источник данных был бы опущен в анализе движения Сэнди, точность предсказаний (например такой важный вопрос: где именно ураган «выйдет» на сушу) могла бы заметно снизиться, а это могло бы иметь катастрофические, а может даже и летальные последствия для многих людей.

На этом графике можно увидеть, как спустя 72 часа модель европейских метеорологов разительно вырвалась вперед в точности прогноза действий урагана.

Технология Hadoop хороша для анализа таких больших объемов данных, но при всех ее достоинствах, она хороша настолько, насколько ей это позволяет аппаратная часть систем анализа и обработки данных, и одним из ключевых характеристик, влияющих на эффективность Hadoop — является скорость работы дисковой подсистемы. Неважно, какие именно большие данные вы обрабатываете, будь это прогноз погоды, или, например, разработка вакцины от гриппа — одним из признанных во всем мире способов ускорить работу Hadoop являются решения LSI серии Nytro. Прочитать поподробней о том, как Nytro позволяет ускорить Hadoop и другие приложения, можно на сайте.