Комментарии 48

Сейчас вечер 11 мая, ждем продолжения (завершения?) повествования о PSOD и поддержке VMware.

+5

а так хорошо всё начиналось! Кстати, заметен новый тренд, использовать хабр как ускоритель реакции различных компаний и сервисов.

+2

Машков прикольный товарищ, был у него на курсах по VMWare 2 раза. И да, lib.ru его проект.

0

Уже 11 мая… Как же битва с ошибкой? Победили?

Меня в таких случаях vmware community спасало, тоже были проблемы с LSI, а также Areca. А вот Adaptec тьфу, тьфу второй год пашет. никаких танцев с бубном и мониторится хорошо.

Меня в таких случаях vmware community спасало, тоже были проблемы с LSI, а также Areca. А вот Adaptec тьфу, тьфу второй год пашет. никаких танцев с бубном и мониторится хорошо.

+1

так и есть. Поддержка затянулась: почему то им было сложно привязать наши лицензии к новому аккаунту на vmware и они упорно настаивали, что их нужно привязать к почте указанной в контракте (по их правилам никакой поддержки пока не активируешь лицензии на vmware.com), тем не менее это случилось и вот последний ответ (сегодня):

Thank you for your Support Request.

I have created a seperate support request with our technical team to address this issue.

You will be contacted in due course to offer assistance.

As the licensing issue has now been fixed I will proceed to close this case.

If you have any further questions or issues regarding the licensing issue then please contact me in the next 24 hours and ler me know.

Thank you for your Support Request.

I have created a seperate support request with our technical team to address this issue.

You will be contacted in due course to offer assistance.

As the licensing issue has now been fixed I will proceed to close this case.

If you have any further questions or issues regarding the licensing issue then please contact me in the next 24 hours and ler me know.

0

Хабра творит чудеса. Вот самый последний ответ (буквально пару минут назад, наверное можно и ему прямую ссылку на этот пост скинуть):

меня зовут Пётр, я работаю в VMware Global Support Services и буду помогать Вам в решении Вашей проблемы.

Картинка с экраном не прикрепилась. Просьба прислать ее снова.

Также пришлите логи kb.vmware.com/kb/653 на FTP kb.vmware.com/kb/1008525

После того как логи будут получены, я свяжусь с Вами для дальнейшей работы.

С уважением,

Пётр Рудницкий

Как собрать логи. kb.vmware.com/kb/1008524

Как прислать информацию на FTP.http://kb.vmware.com/kb/1008525

меня зовут Пётр, я работаю в VMware Global Support Services и буду помогать Вам в решении Вашей проблемы.

Картинка с экраном не прикрепилась. Просьба прислать ее снова.

Также пришлите логи kb.vmware.com/kb/653 на FTP kb.vmware.com/kb/1008525

После того как логи будут получены, я свяжусь с Вами для дальнейшей работы.

С уважением,

Пётр Рудницкий

Как собрать логи. kb.vmware.com/kb/1008524

Как прислать информацию на FTP.http://kb.vmware.com/kb/1008525

+1

рядом сервер под оракл – собирает статистику посещения муниципального сайта.

O_o

Что это у вас за муниципалитет такой, что для сбора статистики нужен Oracle?

+5

Обычный роспильный муниципалитет. БД? Оракл! Маршрутизатор? Шеститонник от циски по гыпыэлю без скидок.

+5

Как же прекрасно я Вас понимаю. Но это еще не самое страшное.

Куда интереснее дела обстоят с технической поддержкой, администрированием и обслуживанием такого ПО и железа. Не владею ситуацией в России, но в Украине, в гос. секторе, все достаточно печально. Интеграторы «впаривают» где только нужно и не нужно самые дорогие и, чаще всего, сложные решения. А томом это железо и софт аутсорсят провайдеры и интеграторы. Официальных договоров конечно же нету — ибо это абсурд (мего дыра в безопасности). Вот Вам и защита информации.

Куда интереснее дела обстоят с технической поддержкой, администрированием и обслуживанием такого ПО и железа. Не владею ситуацией в России, но в Украине, в гос. секторе, все достаточно печально. Интеграторы «впаривают» где только нужно и не нужно самые дорогие и, чаще всего, сложные решения. А томом это железо и софт аутсорсят провайдеры и интеграторы. Официальных договоров конечно же нету — ибо это абсурд (мего дыра в безопасности). Вот Вам и защита информации.

0

Скорее всего он еще чем-то занят. Или куплен сто лет назад и прикручен к чему было.

А так — посмотрите население города. И количество муниципальных контор в нем.

Ничего удивительного, что они пытались сделать 25 доменов в начале. И это даже безо всякого распила.

А так — посмотрите население города. И количество муниципальных контор в нем.

Ничего удивительного, что они пытались сделать 25 доменов в начале. И это даже безо всякого распила.

0

НЛО прилетело и опубликовало эту надпись здесь

А как решен вопрос с резервированием хранилища? Или мы создали монстра который умерев положит вообще всё что есть?

+1

Хороший вопрос. Постараюсь ответить кратко:

1. в 5ой vSphere очень «красиво» решен вопрос бекапов

2. Когда мы говорим об отказоустойчивости мы подразумеваем полную независимость от хостов (гипервизоров) и да: все хранится на хранилище, если оно не доступно то ничего не работает.

3. Если нам нужна катастрофоустойчивость: нам нужно еще одно хранилище в другом здании и оптика между ними (и уже другой пакет vsphere enterprice plus, в итоге совсем другие деньги)

в данной работе решался вопрос создание отказоустойчивого центра обработки данных.

1. в 5ой vSphere очень «красиво» решен вопрос бекапов

2. Когда мы говорим об отказоустойчивости мы подразумеваем полную независимость от хостов (гипервизоров) и да: все хранится на хранилище, если оно не доступно то ничего не работает.

3. Если нам нужна катастрофоустойчивость: нам нужно еще одно хранилище в другом здании и оптика между ними (и уже другой пакет vsphere enterprice plus, в итоге совсем другие деньги)

в данной работе решался вопрос создание отказоустойчивого центра обработки данных.

0

Вообще, отказоустойчивость подразумевает независимость от любых отказов, в том числе — от отказов хранилища. Иначе вы просто переносите точку отказа с сервера на хранилище. Для реализации отказоустойчивости в общем случае нормальные хранилища имеют по два контроллера, а в серверы ставится два HBA. Либо — более крутой вариант — два отдельных хранилища с репликацией. А если разнести эти хранилища (и добавить еще серверов, конечно) территориально, то таки да — вы получите еще и катастрофоустойчивость.

0

Хочу заметить, что на фоне вероятности отказа хранилища, отказ сети между хранилищем и хостами очень маловероятен.

Так что правильно в другом порядке: сначала репликация между хранилищами, а потом уже multipath.

Так что правильно в другом порядке: сначала репликация между хранилищами, а потом уже multipath.

0

Я к тому, что есть бюджетные варианты с двумя головами (RAID-контроллерами) в одном корпусе, если помрет одна, то вторая живая. Имелись ввиду не сетевые контроллеры, конечно. Например, даже младшая модель IBM DS3200 может нести два контроллера, причем с горячей заменой.

А в остальном я с вами согласен. Вернее, мы друг другу и не противоречили, если я вас правильно понял.

А в остальном я с вами согласен. Вернее, мы друг другу и не противоречили, если я вас правильно понял.

0

спасибо за комментарий, но в нашей комплектации два контроллера на хранилище и оба сервера подключены через SAS HBA каждый к двум контроллерам. По поводу второго хранилища: цена будет совсем другой.

0

25 доменов???? Да они с дуба рухнули. Сайты для кого придумали?

+1

Ширина каналов для межсайтовых репликаций?

Было у нас: головная контора — канал 512. Филиалы — около 20. Канал 128. КД в головной конторе. Качество каналов связи — пинг от 100 до 1000.

Здесь у людей каналы связи в начале были явно такие же.

Было у нас: головная контора — канал 512. Филиалы — около 20. Канал 128. КД в головной конторе. Качество каналов связи — пинг от 100 до 1000.

Здесь у людей каналы связи в начале были явно такие же.

+1

Слова «муниципалитет города Томска» встречаются 4 раза + тег, «администрация города Томска» — 3 раза. Слегка многовато, зачем их рекламировать? Ну, wmware, пусть и 25 раз, но понятно, но муниципалитет?

0

> Если сегодня для меня выбор бренда для виртуализации очевиден, то…

Рекомендую потрогать Proxmox VE 2.x.

Рекомендую потрогать Proxmox VE 2.x.

0

Статья выглядит не то чтобы заказной, но какой-то невнятной. Техническая составляющая производит странное впечатление — сначала говорится про парк из сотни серверов, потом оказывается что всё положили на четыре компьютера, причём из них под vmware только два, как я понял. Но потом оказывается что в 25-ти отделениях по ESXi хосту. Потом ещё сервера набежали, но сколько и каких — непонятно. Что с системой хранения, зачем грузиться по сети при четырёх дисках в сервере тоже непонятно.

Финансовая составляющая в тени. Если это 3 сервера, то можно за копейки купить лицензии, если 25 — то это уже не копейки а скорее тысяч 100-200 долларов в зависимости от лицензии только на софт, причём если бы эти сервера были в одном месте то всё хорошо, так они же разбросаны по городу — тогда ни HA, ни DRS не светит, непонятно почему бесплатный proxmox обойдён стороной — то же примерно позволит сделать.

Поддержка VmWare описана как отсутствующая, насколько я понял?

Ну и пассаж про Мошкова просто потряс.

Финансовая составляющая в тени. Если это 3 сервера, то можно за копейки купить лицензии, если 25 — то это уже не копейки а скорее тысяч 100-200 долларов в зависимости от лицензии только на софт, причём если бы эти сервера были в одном месте то всё хорошо, так они же разбросаны по городу — тогда ни HA, ни DRS не светит, непонятно почему бесплатный proxmox обойдён стороной — то же примерно позволит сделать.

Поддержка VmWare описана как отсутствующая, насколько я понял?

Ну и пассаж про Мошкова просто потряс.

+5

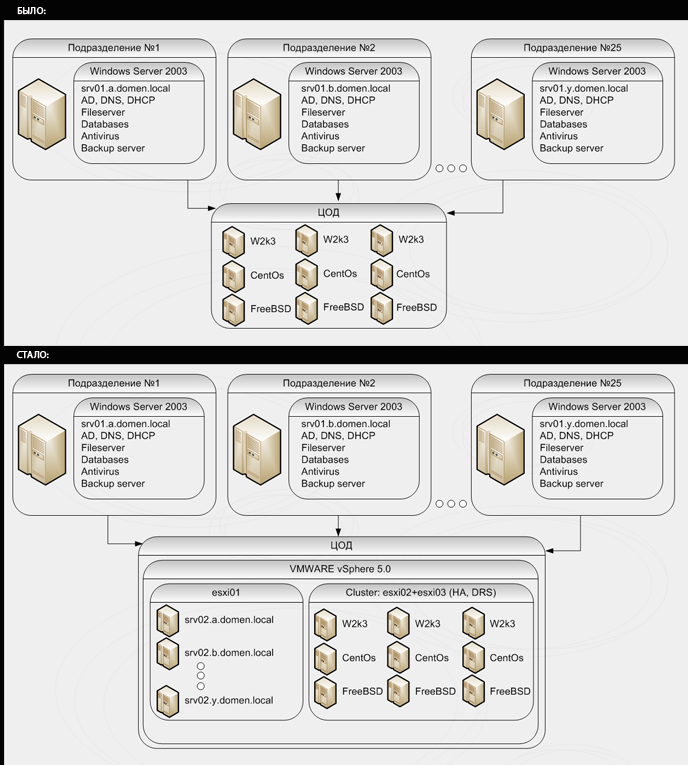

к сожалению опыта написания подобных статей почти нет. Хотелось просто рассказать как оно было по пунктам, если получилось «невнятно» и «непонятно» — прошу прощения, постараюсь исправится. По поводу организации сети, постарался структурно показать что «было» и что «стало», надеюсь станет понятнее а не наоборот:

+1

Не понятны пара моментов:

1. все таки как решили вопрос с бэкапами? Куда бэкапитесь с хранилища? Объемы данных видимо немаленькие (на всякий случай уточню: речь о оперативных бэкапах, своего рода защита от «ой я тут файл случайно удалила» на всех уровнях от бухгалтера до сисадмина), а если сделат какую-никакую глубину (неделя-две хотя бы) и учитывать всевозможные БД и сложные системы, которые инкрементно не особо побэкапишь, то объемы вырастают неслабо.

2. повышение отказоустойчивости конечно произошло, но вы же понимаете, что малейший отказ хранилища вспучит вам все волосы во всех местах разом.

3. Железо вы брали некое самосборное? В смысле — решения от местных поставщиков? Не смотрели в сторону тех же HP, IBM и иже с ними?

4. судя по схеме вы виртуализировали только ЦОД, и добавили дополнительные контроллеры домена для каждого их поддоменов на отдельном ESXi. Почему бы их не втиснуть в тот-же кластер?

5. в 5 сфере уже можно использовать ESXi под HA и DRS или вы просто опечатались в схеме?

6. Если не секрет — какая лицензия Vsphere используется в итоге? (бандл? версия?)

1. все таки как решили вопрос с бэкапами? Куда бэкапитесь с хранилища? Объемы данных видимо немаленькие (на всякий случай уточню: речь о оперативных бэкапах, своего рода защита от «ой я тут файл случайно удалила» на всех уровнях от бухгалтера до сисадмина), а если сделат какую-никакую глубину (неделя-две хотя бы) и учитывать всевозможные БД и сложные системы, которые инкрементно не особо побэкапишь, то объемы вырастают неслабо.

2. повышение отказоустойчивости конечно произошло, но вы же понимаете, что малейший отказ хранилища вспучит вам все волосы во всех местах разом.

3. Железо вы брали некое самосборное? В смысле — решения от местных поставщиков? Не смотрели в сторону тех же HP, IBM и иже с ними?

4. судя по схеме вы виртуализировали только ЦОД, и добавили дополнительные контроллеры домена для каждого их поддоменов на отдельном ESXi. Почему бы их не втиснуть в тот-же кластер?

5. в 5 сфере уже можно использовать ESXi под HA и DRS или вы просто опечатались в схеме?

6. Если не секрет — какая лицензия Vsphere используется в итоге? (бандл? версия?)

0

постараюсь по пунктам:

1. Оперативные бекапы по прежнему: теневое копирование в windows. Сами образы виртуалок за счет родного бекапшика в 5 всфере.

2. согласен. но это лучше чем то, что было.

3. Рассматривали — цена выше на порядок.

4. Дело в том что я и работаю в этом ЦОДе, все что на схеме обозначено «подразделение» — отдельные юрлица, они вроде и входят в корпоративную сеть, но имеют свое руководство со всеми вытекающими последствиями. Дополнительные контроллеры домена для каждого их поддоменов на отдельном ESXi — исключительно моя инициатива, по поводу добавления в кластер — как раз думаем над этим сейчас.

5. Это разумеется опечатка. Везде стоят ESXi

6. VMware vSphere 5 Standart Acceleration Kit

1. Оперативные бекапы по прежнему: теневое копирование в windows. Сами образы виртуалок за счет родного бекапшика в 5 всфере.

2. согласен. но это лучше чем то, что было.

3. Рассматривали — цена выше на порядок.

4. Дело в том что я и работаю в этом ЦОДе, все что на схеме обозначено «подразделение» — отдельные юрлица, они вроде и входят в корпоративную сеть, но имеют свое руководство со всеми вытекающими последствиями. Дополнительные контроллеры домена для каждого их поддоменов на отдельном ESXi — исключительно моя инициатива, по поводу добавления в кластер — как раз думаем над этим сейчас.

5. Это разумеется опечатка. Везде стоят ESXi

6. VMware vSphere 5 Standart Acceleration Kit

0

5. Либо мы не поняли друг друга, либо снова опечатка. :)

0

Томск класный город, привет Политеху!

1. Посмотрите в сторону продуктов Veeam, у них есть как вариант лицензирования продуктов Essential, как раз по вашему бюджету.

3. На порядок? т.е вы за железо заплатили суммарно $3000? Для примера собрал аналогичную конфу на IBM:

2 х x3550m3, 2xX5675, 64GB, 2x SAS HBA, USB VMware.

IBM DS 3512, 12x2TB NL-SAS

Вышло в лист-прайсе $30000, т.е. с учетом скидки для парнера и его маржи так и выйдет.

Заказывали бы Express модели было бы дешевле.

Есть еще HP, где цены еще дешевле.

Не понял в вашем конфиги, вы в сервера тоже диски ставили?

Для VMware локальные диски не нужны, если есть общее хранилище.

Если общего хранилища нет, можно поставить Vmware Storage Appliance, будет HA, DRS.

Не обязательно загружаться со стораджа, VMware ESXi прекрасно загружается с USB, никакой разницы, только дешевле.

Т.е. с учетом этого вам и iSCSI не надо было. Можно было ограничиться стораджем с подключением по SAS.

Конкретно выше названная модель (кстати OEM LSI) поддерживает в начальной конфигурации 4 порта SAS (2 хоста в HA), с раcширением до 8 портов.

У HP также есть аналогичная модель.

6. В вашей конфигурации вам достаточно было VMware Essential Plus Kit, цена в 2 раза ниже, теже возможности.

7. (От меня) Если вы планируете размешать в будущем много VM c Microsoft Windows Server, подумайте надо покупкой/апгрейдом лицензий до Windows Server Datacenter. Разница в цене в 6 раз против Standart, но стандартном вы покрываете только одну VM, а Datacenter, лицензируется на процессор (сокет), и позволяет неограниченное количество VM.

8. (От меня) если уже купили VMware Standart, то пользуйтесь по полной! Начиная со стандарт, вы можете бесплатно использовать SUSE Linux Enterprise Server 11. Подробности на сайте VMware.

Не в обиду, но вы типичный «экономный» клиент, экономит на железе, которое не понятно есть или нет в HCL, а потом ничего не работает.

Допустим в случае с IBM купили бы сразу сервис-пак, стоит несколько сот долларов, и уже на next-business day у вас были бы сбойные запчасти.

Думаю и у HP такое тоже есть.

После регистрации лицензий, вы можете звонить на телефон поддержки VMware, там ответят по-русски, достаточно грамотно.

P.S. я не сотрудник IBM, HP, VMware, просто работаю с их продуктами.

1. Посмотрите в сторону продуктов Veeam, у них есть как вариант лицензирования продуктов Essential, как раз по вашему бюджету.

3. На порядок? т.е вы за железо заплатили суммарно $3000? Для примера собрал аналогичную конфу на IBM:

2 х x3550m3, 2xX5675, 64GB, 2x SAS HBA, USB VMware.

IBM DS 3512, 12x2TB NL-SAS

Вышло в лист-прайсе $30000, т.е. с учетом скидки для парнера и его маржи так и выйдет.

Заказывали бы Express модели было бы дешевле.

Есть еще HP, где цены еще дешевле.

Не понял в вашем конфиги, вы в сервера тоже диски ставили?

Для VMware локальные диски не нужны, если есть общее хранилище.

Если общего хранилища нет, можно поставить Vmware Storage Appliance, будет HA, DRS.

Не обязательно загружаться со стораджа, VMware ESXi прекрасно загружается с USB, никакой разницы, только дешевле.

Т.е. с учетом этого вам и iSCSI не надо было. Можно было ограничиться стораджем с подключением по SAS.

Конкретно выше названная модель (кстати OEM LSI) поддерживает в начальной конфигурации 4 порта SAS (2 хоста в HA), с раcширением до 8 портов.

У HP также есть аналогичная модель.

6. В вашей конфигурации вам достаточно было VMware Essential Plus Kit, цена в 2 раза ниже, теже возможности.

7. (От меня) Если вы планируете размешать в будущем много VM c Microsoft Windows Server, подумайте надо покупкой/апгрейдом лицензий до Windows Server Datacenter. Разница в цене в 6 раз против Standart, но стандартном вы покрываете только одну VM, а Datacenter, лицензируется на процессор (сокет), и позволяет неограниченное количество VM.

8. (От меня) если уже купили VMware Standart, то пользуйтесь по полной! Начиная со стандарт, вы можете бесплатно использовать SUSE Linux Enterprise Server 11. Подробности на сайте VMware.

Не в обиду, но вы типичный «экономный» клиент, экономит на железе, которое не понятно есть или нет в HCL, а потом ничего не работает.

Допустим в случае с IBM купили бы сразу сервис-пак, стоит несколько сот долларов, и уже на next-business day у вас были бы сбойные запчасти.

Думаю и у HP такое тоже есть.

После регистрации лицензий, вы можете звонить на телефон поддержки VMware, там ответят по-русски, достаточно грамотно.

P.S. я не сотрудник IBM, HP, VMware, просто работаю с их продуктами.

+2

в случае с IBM купили бы сразу сервис-пак, стоит несколько сот долларов, и уже на next-business day у вас были бы сбойные запчасти.

Стало интересно: думаете в реалиях Томска next business day — это действительно следующий календарный день? Терзают меня смутные сомнения на этот счёт, зная как они работают, например в Киеве

0

Технику вы же аукционами покупали, да и софт. Киньте ссылки на zakupki.gov.ru Народу и будет ясно, что именно вы купили.

0

Скоро-скоро VMware Forum :) интересный пост в впредверии VMware Forum 2012 в Москве!

IMHO думаю автору стоит поделиться своей sussess-story на данном мероприятии. ;)

IMHO думаю автору стоит поделиться своей sussess-story на данном мероприятии. ;)

+1

по поводу локальных винчестеров на хостах могу сказать, что гипервизор на них может хранить файлы подкачки для вируальных машин, что очевидно выоднее чем хранить их на хранилище

0

Скажите, а вот VmWare — как Вы ее покупали, да еще с High-Availabilty кластером, если до этого денег только на винчестеры хватало? И, если у Вас уже техника сыпалась, не боязно взгромоздить на нее еще и WmWare?

0

В статье же написано: на винчестеры — это затраты на содержание, а VmWare была куплена под целевую программу (разовый проект, может быть и финансировался областью или федерацией, а не городом).

0

Спасибо, что взяли на себя труд ответить вместо автора, но статью я читал и сам.

Мне, в частности, был интересно вот что: ПО сначала ставилось, настраивалось, а потом покупалось (что некрасиво, но логично с точки зрения потестировать полгодика до оплаты немалого счета) — тогда имеем подход «попросить под целевую программу финансирование на оплату оттестированного решения», либо ПО все же сначала покупалось (выбираясь по описанию, без теста) — тогда, боюсь, могло все получиться не самым оптимальным образом. Вы, раз уж взялись, не проясните для меня эту ситуацию вместо автора?

Мне, в частности, был интересно вот что: ПО сначала ставилось, настраивалось, а потом покупалось (что некрасиво, но логично с точки зрения потестировать полгодика до оплаты немалого счета) — тогда имеем подход «попросить под целевую программу финансирование на оплату оттестированного решения», либо ПО все же сначала покупалось (выбираясь по описанию, без теста) — тогда, боюсь, могло все получиться не самым оптимальным образом. Вы, раз уж взялись, не проясните для меня эту ситуацию вместо автора?

0

Один вопрос.

Почему все-таки была выбрана vSphere, а не Hyper-V?

Может, Hyper-V получилось бы дешевле?

И вообще, какие затраты в целом на лицензии?

Почему все-таки была выбрана vSphere, а не Hyper-V?

Может, Hyper-V получилось бы дешевле?

И вообще, какие затраты в целом на лицензии?

0

>>а грузится с хранилища оно так и не умеет – если честно, я не понимаю, почему? Я может субъективно смотрю на вещи, но когда вы покупаете хранилище, которое как правило дороже любого сервера и у вас разумеется есть для неё поддержка и запасные винчестеры, зачем использовать локальные винчестеры на хостах? Для чего? Непонятно.

Потому, что гипервизор — вещь одноразовая. Т.е. если сдохнет железка с гипервизором — его настройки новой железке будут либо не нужны либо вредны. Плюс сторадж — вещь дорогая, использовать его для загрузки маленьких гипервизоров — в большинстве случаев просто дорого, т.к. нужно подключение к сторажду (iSCSI, SAS, FC, обеспечить загрузку с него), обслуживание самого стораджа (нарезать LUNы, задокументировать) ну и место на сторадже (а его никогда не бывает много). При этом установка на локальный носитель все эти проблемы решает, а стоимость — минимальна, можно как на один хард (рейд не нужен, часто бывает один хард уже в комплекте с сервером) так и на флешку (штатная возможность и у ESXi и Hyper-V Server, в современных серверах есть внутренний USB порт для таких вещей).

Потому, что гипервизор — вещь одноразовая. Т.е. если сдохнет железка с гипервизором — его настройки новой железке будут либо не нужны либо вредны. Плюс сторадж — вещь дорогая, использовать его для загрузки маленьких гипервизоров — в большинстве случаев просто дорого, т.к. нужно подключение к сторажду (iSCSI, SAS, FC, обеспечить загрузку с него), обслуживание самого стораджа (нарезать LUNы, задокументировать) ну и место на сторадже (а его никогда не бывает много). При этом установка на локальный носитель все эти проблемы решает, а стоимость — минимальна, можно как на один хард (рейд не нужен, часто бывает один хард уже в комплекте с сервером) так и на флешку (штатная возможность и у ESXi и Hyper-V Server, в современных серверах есть внутренний USB порт для таких вещей).

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

VMWARE vSphere 5.0: Опыт внедрения на примере муниципалитета г. Томска