Комментарии 194

Оптимистично :)

+4

Через чур. Пошла блин тенденция наращивать мощности и ядра, а телефоны (те которые умные) как работали сутки на заряде, так и работают. Хочу смартфон с одноядерным процом и работу в 3 суток при нагрузке. Мне хватает возможностей которые есть сейчас (и были год назад). Хочу лишь увеличения времени жизни, а не производительности!

Даешь увеличение время жизни а не увеличения мощности! Не хочу 100500 ядерный процессор!

Даешь увеличение время жизни а не увеличения мощности! Не хочу 100500 ядерный процессор!

+23

Да что процессор. Вы в свой смартфон поставьте экран 320х240 (желательно не более 256 цветов) и ходите с ним неделю спокойно. Хоть с четырехъядерным процессором. Если он вам будет нужен при таком сетапе.

+4

Я не хочу даунгрейд, я хочу улучшения в плане потребления энергии без увеличения мощности, которая эти улучшения сводит на нет.

0

Экран жрет в разы больше процессора. И делать энергоэффективные экраны пока не очень научились (в статье речь только про прогресс энергоэффективности вычислительных мощностей). Современные смартфоны жрут батарейку не потому, что там много ядер и большой процессор, а в основном из-за экранов, сравнимых по качеству с телевизионными панелями.

+13

Отчего же тогда одни смартфоны таки выживают дня два а то и более, а другие и 6 часов не могут? И это я не учитываю разрешения менее 800х480

+1

Емкость аккумуляторов разная, и чуть-чуть иная архитектура. При одинаковом аккумуляторе и равной нагрузке о разнице 6 часов против двух дней я не слышал.

+2

кстати у большинства телефонов, не зависимо от экрана обычно время ожидания одинаковое +- 50 часов в районе 250 часов

+1

Это как раз и подтверждает тезис о том, что главным потребителем является экран.

+1

дык независимо от экрана показания одинаковые. Я понимаю, если бы айфоновская ретина жрала бы батарею за сутки, а иксперия мини (320х480) держала бы неделю, но все не так очевидно. В айфоне ведь не стоит никакой супер-пупер огромной батареи, все в стандартных нормах ~1500 не более.

0

дык независимо от экрана показания одинаковые.В режиме ожидания экран выключен, не?

Я понимаю, если бы айфоновская ретина жрала бы батарею за сутки, а иксперия мини (320х480) держала бы неделюТак аккумуляторы же разные. Да и 320х480 это тоже нехило (по сравнению с обычными телефонами). Хотя уже даже они ощутимо дольше держатся, чем 800х480, хотя архитектура та же.

В айфоне ведь не стоит никакой супер-пупер огромной батареиАйфон внутри — это вообще одна большая батарейка с маленькими кусочками микросхемок вокруг нее. Погуглите статьи про вскрытие айфона. У него именно потому батарея и несъемная, что она таких размеров, что ее только впаять насмерть и можно, оптимизировав каждый миллиметр.

+2

вы слишком утрируете, у Айфонов как и у других современных телефонов батарейка занимает 50% места, а плата расспологается так потому что легче сделать плату «Г» или «П» образной формы чем изменить форму аккумулятора, про оптимизацию вы правы, делая не разборный корпус можно не хило выиграть в полезном объеме при одинаковом габаритном.

На счет энергопотребления главные потребители, это экран как вы и сказали, но ВТОРОЙ главный потребитель почему то остался не замеченным — Приемо-Передающие устройства — Wi-fi, GPS, GPRS, 3G и так далее

На счет энергопотребления главные потребители, это экран как вы и сказали, но ВТОРОЙ главный потребитель почему то остался не замеченным — Приемо-Передающие устройства — Wi-fi, GPS, GPRS, 3G и так далее

+1

Это в простых телефонах приёмопередающие устройства — второй потребитель после экрана. А в смартфонах — второй потребитель таки процессор.

-4

Появляются новые процессоры — требуеться большая скорость передачи — большее потребление приемо-передатчиком нет? модуль без 3G и с 3G потребляют разное количество энергии

-1

Что-то вы причину со следствием перепутали. Развитие коммуникаций более первично, и является событием само по себе, а процессоры лишь удовлетворяют потребность в обработке увеличивающегося количества данных. Смартфоны и со слабым, и с мощным процессором обрабатывают одинаковое количество данных, которое зависит не от процессора в смартфоне, а от времени, в которое мы живем, от плотности информационного поля вокруг.

-1

Растут экраны, это увеличивает потребление. Современные многоядерные cpu даже економнее мощного одноядерного. 90% потребления смартфона это свзязь (3g, gps, edge, mobile) и экран. И тут ничего нового пока не предвидится. Особенно учитывая тенденцию к увеличения экрана. И андроид здесь как в шутках особо не при чем. Просто современный топовый андроид это 4.5-4.8' Это действительно удобно. Стоит только попользовать — держать в руках 3.5 больше не захочется.

+1

Очень даже хочется, полагаю, потому мне и придется завязывать с android. Касательно батареи, опять-же, примерно одинаковые iPhone4 и Desire S, например, держат совершенно разное количество времени при одинаковом использовании. Разница явно не в экране и не в GSM, она именно в использовании процессора.

0

Для таких (и многих подобных) выводов достаточно почитать фантастическую литературу прошлого века. Больше энергии и вычмощности, меньше свобод и чистой воды.

+2

хмм… т.е. вы считаете, что в Москве 100 лет назад было чище и свободнее?

+1

Уверен, что в 1912 году такого смога над Москвой не было.

+6

А чем топили в Москве в 1912 году?

+8

Это не так важно. Труб было меньше на порядки.

-5

Я бы не спешил так утверждать. Нужно считать. Дрова и уголь и коптят на порядок сильнее метана.

+14

Дрова хотя бы экологически чистые. А Вы постойте часок-другой в пробке за камазом, у которого двигатель регулировали в прошлом веке, и необходимость считать отпадёт.

-10

Метан ещё экологически чище. Если вам нужно что-то понюхать у камаза, чтобы сделать количественные выводы, тогда считать необходимости действительно нет.

+6

А при чём тут метан? У нас бензин и дизтопливо используют. Человек, не нюхавший московского камаза, не способен оценить его влияние на здешнюю экологию.

0

Камазы везде камазы =) И я сомневаюсь что в москве они сильней загрязняют природу. А в целом согласен что автомобилестроение дало толчек городским туманам.

+2

Если считать, что пробки в Москве больше, чем в других городах, то московские КамАЗы всё же больше вредят экологии чем «провинциальные» — больше работают на холостом ходу, больше работают в неоптимальных режимах.

А вообще есть мнение, что проблеме «городского тумана» 700+ лет. Вернее столько лет прошло со времени первой официальной попытки борьбы с ним.

А вообще есть мнение, что проблеме «городского тумана» 700+ лет. Вернее столько лет прошло со времени первой официальной попытки борьбы с ним.

0

Потому что сейчас метаном москву отапливают. Камазы я не нюхаю.

+1

Нюх ал. Дизеля пахнут вкуснее, чем бензиновые. И по факту дизель тоже экологичнее, лучше условия сгорания топлива.

0

Почитайте заметку на Википедии Великий смог 1952 года.

0

Почитал. Вот и пример, как углём закоптили город.

0

Почитайте внимательней, автомобили там тоже сильно повлияли на этот туман.

0

по количеству — да, а по плотности?

0

наверно все промышленные предприятия того времени работали исключительно на солнечной энергии и в Москву-реку сливали исключительно фильтрованную воду

+7

И смог был и в добавок еще и канализация нормальная была только в элитных районах, а в остальных нечистоты по улицам текли.

0

Зато пахло лошадиным дерьмом и дымом от топок. 5-этажные дома были уже тогда в центра. А теперь вопрос: что дымит больше — тысяча проехавших по улице автомобилей и сотня квартир, в которых приготовили сначала обед, а потом и ужин на дровах, которые привезли на лошадях?

+2

Я правильно понимаю, что в местах отдалённых от цивилизации (где нет фоновых волн, типа радио), «беспроводные и не требующие батарей сенсоры» не будут работать в принципе?

+2

О! Наноданные! Нужно сообщить в Сколково!

+16

«Производительность компьютеров демонстрирует впечатляющий и устойчивый рост, удваиваясь каждые полтора года.»

Уже полтора? Почему-то раньше везде писали про 1 год. Теперь, видимо, новые платформы не так эффективны, по сравнению с платформами предыдущего поколения.

Уже полтора? Почему-то раньше везде писали про 1 год. Теперь, видимо, новые платформы не так эффективны, по сравнению с платформами предыдущего поколения.

-2

Не переживайте. Программисты найдут, чем занять новые мощности.

+9

да, будет виртуальная машина, написанная на джаве, исполняющая питон.

+12

Как бы уже есть: code.google.com/p/python-for-android/

Вот перепишут Angry Birds под неё — и не будет простаивать процессора зря.

Вот перепишут Angry Birds под неё — и не будет простаивать процессора зря.

+12

Уже есть.

+3

Я давно уже заметил такую фишку Хабра: какую чушь не сморозишь, обязательно в тебя бросят ссылкой и окажется, что такое уже есть. Я даже уже и не представляю, что такое бредовое можно было придумать, чтобы его еще не было.

+30

«Такое уже было в симпсонах» (с) южный парк

+19

Уйский?

+1

ну-ка, попробуем. виртуальная машина на джаве, исполняющая питон, на которой написана виртуалка, исполняющая брейнфак?

+1

лучше бы емкость аккумуляторов росла быстрее. скорости мне пока хватает

+12

Ну знаете, в большой ёмкости есть и минус. Взять тот же iPad 3, при тех же размерах батарейку увеличили почти вдвое, теперь заряжается всю ночь. С ноутбуком такая зарядка в порядке вещей, а с планшетом, как по мне, это перебор.

0

А вы ночью работаете с планшетом? Или пока он заряжается вы не можете спать?

0

Нельзя перед выходом куда-то поставить на зарядку на полчасика, это теряет смысл.

0

планшет работает 8 часов, заряжается 4 часа

планшет работает 16 часов, заряжается 8 часов

первый заряжаем пол часа, он работает час

второй заряжаем пол часа, он работает час

PROBLEM?

Или они поставили батарею больше, которая заряжается дольше, но работает столько же сколько и предидушая?

планшет работает 16 часов, заряжается 8 часов

первый заряжаем пол часа, он работает час

второй заряжаем пол часа, он работает час

PROBLEM?

Или они поставили батарею больше, которая заряжается дольше, но работает столько же сколько и предидушая?

+2

Они увеличили батарею для сохранения 10-часового времени работы при улучшенном железе, но заряжается она шесть часов вместо трёх.

+3

=) Ну тогда не повезло фанатам яблока. Вот он, прогресс! Скоро как в ералаше будем ходить с чемаданами www.youtube.com/watch?v=jZ7RSV8XH3k

+5

Именно так. Второй и третий айпады держат по десять часов. В третьем более мощная начинка и в четыре раза большее разрешение экрана.

+1

Батарею увеличили, а зарядное устройство — нет.

+1

Энергоэффективность должна расти. А то заправлять телфон прийдется на специальных высоковольтных станциях )

+1

И в руках каждого человека будет электронная бомба, и уничтожающие экологию электростанции, которые потребуются для зарядки мегабатарей.

0

При любом раскладе — работы у программистов не уменьшится и это радует.

+1

Ну теперь вы понимаете, почему даже самые передовые смартфоны «живут» всего примерно сутки?

0

Мне кажется, идея с зарядкой от радиоволн больше подходит для мобильников. А что, есть сеть — телефон работает, нет сети — не работает.

Было бы круто…

Было бы круто…

+1

Может следует рассуждать не об устройствах, а о процессорах?

Думаю, вряд ли мониторы смогут быть пассивными. Они, как минимум, обязаны потреблять энергию не меньшую, чем потребляют.

А устройства, сравнимые с современными ноутбуками не будут потреблять практически ничего.

Думаю, вряд ли мониторы смогут быть пассивными. Они, как минимум, обязаны потреблять энергию не меньшую, чем потребляют.

+1

про E-inc уже все забыли?

0

E-inc не излучает света, а лишь отражает его, вот в чем дело. Он в прямом смысле «газета» — тратит энергию только на формирование рисунка чернилами, и после этого переходит в состояние стазиса. Традиционный монитор, пушка ли, ЖК, LED или плазма в той или иной форме используют источник света.

0

кто-то же хотел пассивных мониторов?

0

E-ink непригоден для применения в качестве монитора. Традиционные ЖК или LED-экраны при динамическом изменении изображения гораздо более энергоэффективны.

0

Да, пока неприменим. Но вспомните быстродействие первых ЖК. Тогда тоже говорили «им никогда не порвать ЭЛТ». И где теперь ЭЛТ?

Заранее нельзя сказать какая технология окажется эффективной даже в следующем году. Не говоря уж о более длительных прогнозах.

Заранее нельзя сказать какая технология окажется эффективной даже в следующем году. Не говоря уж о более длительных прогнозах.

+3

Мы говорим о принципиально разных технологиях. ЖК и ЭЛТ так или иначе излучали свет. E-Ink лишь отражает поступающий извне. Их бессмысленно сравнивать в одной сфере применения.

0

Отчего же бессмысленно? Ключевой элемент ЖК по сути лишь управляет прозрачностью.

Если предположить (потенциально) равенство быстродействия и динамического потребления этих двух технологий, то единственное отличие ЖК будет в том, что лампа у него сзади и обязательна, а у E-link должна быть спереди и необязательна при наличии света.

Если предположить (потенциально) равенство быстродействия и динамического потребления этих двух технологий, то единственное отличие ЖК будет в том, что лампа у него сзади и обязательна, а у E-link должна быть спереди и необязательна при наличии света.

+3

E-ink потребляет при динамическом изменении картинки ещё больше обычных мониторов. Их плюс — в статичности картинки.

0

ну если видео смотреть, то да :) Современные телефоны без видеопроигрывателя продаваться не будут :)

0

Ну мож вам вообще будет достаточно «бабушкофона». ) В конце концов там дисплейчик врядли много жрёт, пусть и не E-Ink. Лично я достаточно активно использую телефон именно как видеопроигрыватель.

0

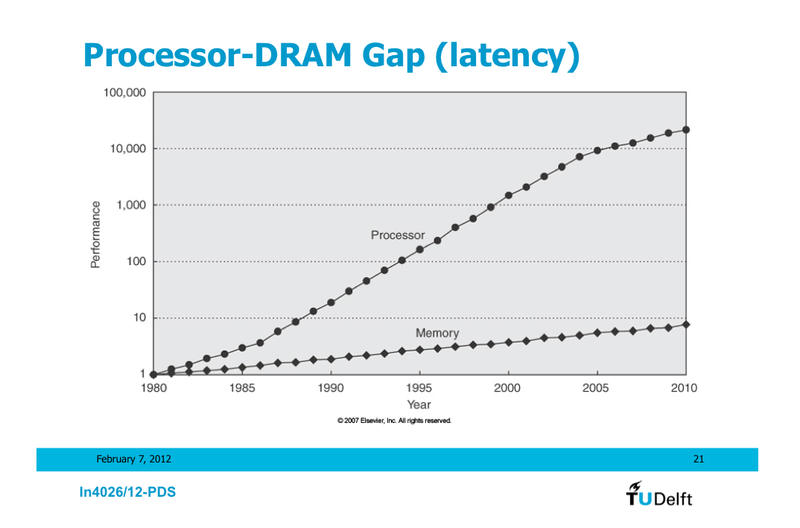

Мне кажется, что тренд о котором вы пишете, сейчас как раз таки переламывается. Если мы будем говорить об энергопотреблении и производительности процессоров на архитектуре интел, то они в последнее время замерли на месте. И если уменьшить энергопотребление каким-то образом еще и возможно, то наращивание производительности в пределах ядра уперлось в физические ограничения. Ваш график вмещает в себя очень много всего, а вот на подробную статистику за последние лет пять я бы с удовольствием посмотрел. Я кстати недавно приводил в комментариях к другой статье похожий график, но тоже не очень уж подробный, посмотрите:

habrahabr.ru/post/142734/#comment_4779434

Разумеется, будет расти емкость батарей, будут совершенствоваться прочие технологии, снижаться энергопотребление дисплеев, процессоры с арм-архитектурой возможно займут место интела, но боюсь что о дальнейшем рывке в производительности стэнд-элон машин пока говорить не приходится. Улучшения возможны только в кластерах и мультиядерных процессорах, но тут железячники пока сильно обставляют программистов, такие системы пока сложно продуктивно использовать для многих задач.

habrahabr.ru/post/142734/#comment_4779434

Разумеется, будет расти емкость батарей, будут совершенствоваться прочие технологии, снижаться энергопотребление дисплеев, процессоры с арм-архитектурой возможно займут место интела, но боюсь что о дальнейшем рывке в производительности стэнд-элон машин пока говорить не приходится. Улучшения возможны только в кластерах и мультиядерных процессорах, но тут железячники пока сильно обставляют программистов, такие системы пока сложно продуктивно использовать для многих задач.

+2

Да ладно вам, некоторые текущие процессоры интел ix, потребляющие 35 ватт, бьют по производительности core 2 duo которые тоже потребляют все те же 35 ватт. Не во всех тестах конечно, но в целом новые процессоры с тем же потреблением выигрывают у предидущих.

0

Производительность не удваивается, да, но очень далека от «замерло на месте». к примеру core i5 760 vs core i5 2500 (четырех-ядерники разных поколений в равной ценовой категории) различаются по производительности на 20-50%, но потребляют примерно одинаково электричества.

Дальше — новывшедший core i5 3570 vs core i5 2500 — одно поколение, но разный тех процесс. разница в производительности 10-20%+снижение энергопотребления на 20%+увеличени производительность встроенной видео вдвое.

Дальше — новывшедший core i5 3570 vs core i5 2500 — одно поколение, но разный тех процесс. разница в производительности 10-20%+снижение энергопотребления на 20%+увеличени производительность встроенной видео вдвое.

+2

«замерла на месте» отчетливо видно по уменьшению количества задач, для которых требуется эта мощность. Мощности 5-летнего Pentium dual core покрвает 95% задач среднестатистического пользователя.

Я подозреваю увеличение производительности уже не стоит в приоритетах для массового рынка и делается по принципу «ну, у нас есть эта технология. Давайте что ли увеличим производительность — маркетологи порадуются.»

Я подозреваю увеличение производительности уже не стоит в приоритетах для массового рынка и делается по принципу «ну, у нас есть эта технология. Давайте что ли увеличим производительность — маркетологи порадуются.»

0

Ну а для win98 достаточно вообще PIII. Повезло, что майкрософт завязал с трендом повышения требований в каждой новой версии. Виновата в этом мобилизация, в частности, легкие ноутбуки.

Но если соберетесь видео кодировать или большие файлы в фотошопе крутить или что-то еще подобного плана, то проникнитесь разницей между i7 и dual core в полной мере. Разрешение то у видео только растет, да и мегапиксели на месте не стоят.

Но если соберетесь видео кодировать или большие файлы в фотошопе крутить или что-то еще подобного плана, то проникнитесь разницей между i7 и dual core в полной мере. Разрешение то у видео только растет, да и мегапиксели на месте не стоят.

0

Остались ли задачи кроме обработки видео и фото, которые требуют роста мощностей?

Я подозреваю, что тренд с обработкой видео и фото вскоре сместится в сторону GPU. Благо у нас уже второе поколение интела с встроенным графическим ускорителем.

Я подозреваю, что тренд с обработкой видео и фото вскоре сместится в сторону GPU. Благо у нас уже второе поколение интела с встроенным графическим ускорителем.

0

Увеличение числа ядер вполне вкладывается в увеличение производительности. И установка 8-ядерного процессора даст двухкратный (почти) рост производительности десктопа по сравнению с 4-ядерным при использовании определенных методик замеров. То есть чисто по номинальным ТТХ рост производительности мы получим (даже не учитывая оптимизации). А вот будет ли она востребована обычным пользователем отдельный разговор.

0

Ну во-первых двукратного точно не даст — закон Амдаля никто не отменял. А во-вторых, давайте мы сначала на четыре ядра научимся безгеморройно параллелить все приложения. Или хотя бы на два.

Замерами конечно можно все что угодно показать, кто же спорит.

Замерами конечно можно все что угодно показать, кто же спорит.

0

в большинстве случаев нет особой необходимости заставлять приложения уметь параллелить задачи. Потому как достаточно, чтобы OS умела параллелить разные приложения на разные ядра.

+1

В большинстве случаев достаточно уже тех вычислительных мощностей, которые есть сейчас. Фаерфокс у подавляющего количества юзеров уже и так почти не тормозит. Стоит вопрос не как скайп с хромом на разные ядра развести, а как ускорить выполнение тяжелых задач — серверы, графика, моделирование и т.д. Задача решаемая, но далеко не тривиальная, со своими проблемами в каждом случае.

0

У меня сейчас 200 процессов крутится с LA 1,7. Как думаете увеличится время реакции системы на мои дйствия, если у меня будет 256-ядерный процессор? Мне почему-то кажется, что да. Хотя бы 50+ процессов хрома будут каждый на своем ядре.

0

Ну если бы да кабы. Если вы в два раза больше ядер, чем есть сейчас поставите, то в два раза точно время реакции не уменьшится.

Я кстати не против ни одноядерных 10-ГГц процессоров, ни 256-ядерников по четыре ГГц на ядро. Но это все лирика и теория, нужно работать с тем, что есть. Или переписывать вебкит на языке форт.

Я кстати не против ни одноядерных 10-ГГц процессоров, ни 256-ядерников по четыре ГГц на ядро. Но это все лирика и теория, нужно работать с тем, что есть. Или переписывать вебкит на языке форт.

0

А мне не надо в два раза, мне достаточно на 10 (условно) процентов за каждое двухкратное увеличение.

0

Так это и есть то, о чем я говорю. Если у вас два тяжелых приложения работает, которые не параллелятся (хром + флеш), что 4, что 8, что 128 ядер — все одно. Надо учиться параллелить любую задачу под любое количество процессоров, это сейчас приоритет. Кучку чипов вам интел напаяет, а нет, так гигабайт двухпроцессорную материнку всегда продаст с удовльствием.

0

НЛО прилетело и опубликовало эту надпись здесь

При этом средняя мощность блока питания для домашнего компа постоянно растет. Это значит, что требования к вычислительной мощности растут еще быстрее чем энергоэффективность. Да, растет в основном из-за видео, но это не сильно важно, видео это тоже машинка для обсчета данных.

0

НЛО прилетело и опубликовало эту надпись здесь

Вы не под тем углом смотрите. Я, например, писал, что замедление прогресса как раз не фигня, а объективная реальность, упирающаяся сейчас в физические законы. И с этим было бы неплохо что-то делать, но непонятно что и как. А проблема серьезная, и именно для тех 5% задач, которым недостаточно 640 кб памяти.

А если вы так любите ретроспекции, сравните «самыми натуральными и наглядными цифрами» прогресс за пять последних лет и за пять им предшествующих. Процессоры гораздо меньше вперед продвинулись (как был в макбуке 2006 года проц 2,4, так и сейчас та же частота в новые модели ставится), для топовых процев всего может 25-30% прирост тактовой частоты, и дальше некуда расти. В остальном пока двигаемся вперед, но с процессорами и памятью того дикого роста как раньше уже нет.

А если вы так любите ретроспекции, сравните «самыми натуральными и наглядными цифрами» прогресс за пять последних лет и за пять им предшествующих. Процессоры гораздо меньше вперед продвинулись (как был в макбуке 2006 года проц 2,4, так и сейчас та же частота в новые модели ставится), для топовых процев всего может 25-30% прирост тактовой частоты, и дальше некуда расти. В остальном пока двигаемся вперед, но с процессорами и памятью того дикого роста как раньше уже нет.

0

НЛО прилетело и опубликовало эту надпись здесь

Я про пять лет говорю неспроста. Вы еще по двадцать посчитайте, будет более наглядно.

Конкретно процессоры и память уперлись в потолок, эра последовательных вычислений уже подошла к концу, любые кардинальные изменения возможны только в сфере параллелизации, но там сложнее программировать. Вам нравятся графики? Посмотрите ссылку в моем комменте, вот о чем я говорю.

Винты, мониторы, вайфай — спору нет, растет и крепнет, ну дай им бог здоровья.

Конкретно процессоры и память уперлись в потолок, эра последовательных вычислений уже подошла к концу, любые кардинальные изменения возможны только в сфере параллелизации, но там сложнее программировать. Вам нравятся графики? Посмотрите ссылку в моем комменте, вот о чем я говорю.

Винты, мониторы, вайфай — спору нет, растет и крепнет, ну дай им бог здоровья.

+4

Если сравнить core quad 6600 и i7 2700K (примерно равные по цене), то производительность последнего выше в разы, даже на одном ядре. 20-30% это в тех задачах, где упирается в что-то другое. Так-же память может и не стала в разы дешевле, но ее стало в те-же разы больше. 5лет назад, собирая сервер для раздачи видео, было сложно из него гигабит выжать, сейчас с такой-же по уровню конфигурации, 6 выжимается (на десктопном железе в обоих случаях).

Реально проблема в том, что совеременный софт перестал жрать с каждым разом все больше и начали думать о производительности. Потому, обыватели и не знают, чем нагрузить i7 и говорят о том, что быстрее не стало после замены с core quad.

Реально проблема в том, что совеременный софт перестал жрать с каждым разом все больше и начали думать о производительности. Потому, обыватели и не знают, чем нагрузить i7 и говорят о том, что быстрее не стало после замены с core quad.

+1

6600 был первым десктопным четырехядерным процессором (так ведь?), там действительно было что улучшать еще. А вот двухъядерники 2007 года уступают по тестам i7 2600 в производительности ядра процентов тридцать (здесь быстренько прошелся по результатам: www.tomshardware.com/charts/x86-core-performance-comparison/benchmarks,128.html), брал E6850 и i7 2600K как самые подходящие в списке. Как-то не очень прогресс.

Насчет памяти. Больше — это хорошо, да. Но скорость тоже имеет значение. Темпы роста скорости памяти за процессорами все равно не успевают, и много лишних ядер на чипе приведет к проблемам памяти и шины.

Ну и пять лет назад еще был какой-то задел, не ограниченный физическими законами. Сейчас его практически и нет уже.

Насчет памяти. Больше — это хорошо, да. Но скорость тоже имеет значение. Темпы роста скорости памяти за процессорами все равно не успевают, и много лишних ядер на чипе приведет к проблемам памяти и шины.

Ну и пять лет назад еще был какой-то задел, не ограниченный физическими законами. Сейчас его практически и нет уже.

+2

Я не знаю, чем вы меряете, возможно не в тех задачах. Я использую такие процессоры для кодирования видео, для базы данных и фотошопа. Разница между E6850 (было у меня такое чудо) и 2700K была от 2 до 10 раз. Может попробуете новые процессоры в деле, а не будете читать какие-то непонятные тесты.

По поводу памяти, ее объем для большинства задач всегда был важнее скорости. Скорость важна в основном в играх, в остальных местах почти всегда затывается либо в процессор, либо в винт.

Потому и работают над наращиванием в первую очередь, объема.

По поводу памяти, ее объем для большинства задач всегда был важнее скорости. Скорость важна в основном в играх, в остальных местах почти всегда затывается либо в процессор, либо в винт.

Потому и работают над наращиванием в первую очередь, объема.

0

Спорить не буду, под руками их нет сейчас. Тесты есть по ссылке, они меряются на реальных приложениях — архивы, блендер там. Мифические PCMark я не смотрел.

У памяти объем важен, пока проблемы со скоростью незаметны. А сейчас скорость уже тоже на пределе. Если у вас процессор быстрее через себя данные пропускает, чем память ему их отдает, то он простаивать будет, а вы и не заметите. Затем кэши и придуманы. Но их тоже не хватает.

У памяти объем важен, пока проблемы со скоростью незаметны. А сейчас скорость уже тоже на пределе. Если у вас процессор быстрее через себя данные пропускает, чем память ему их отдает, то он простаивать будет, а вы и не заметите. Затем кэши и придуманы. Но их тоже не хватает.

0

Кэш это не совсем замена памяти. А производительность памяти наращивать вполне можно, но в ущерб объему. Учитывая, что современные задачи как раз к скороти памяти критичны условно, а к объему — очень даже, то для основного рынка делают больше объем, а не частоту.

0

Меня больше волнует не то, что выгодно для рынка прямо сейчас, а то, что похоже запаса роста у текущих систем нет. Оно бы хорошо ошибаться конечно.

0

Еще раз говорю — запас есть. Можно нарастить частоту за счет объема. Аналогично можно и в процессорах сделать. Просто ядер станет меньше в 2 раза, например, а частота вырастет на 30%. Потому, так и не делают. процессоры по 8-10 ядер, работают на мешьшей частоте, чем 4-6, чтобы не вылазить из допустимого тепловыделения.

0

Так это не запас, а выжимание последнего, идя на компромиссы. Запас — это равномерно добавлять по гигагерцу в год, желательно при этом уменьшая техпроцесс и энергопотребление. А пока получается что ну добавите вы еще 10-20% на имеющихся частотах за счет оптимизаций и архитектуры, и всё. А судя по иви бриджу, и этих 10-20% может уже и не быть.

0

Еще раз — почему вы меряете что-то гигагерцами? Процессоры с одинаковыми герцами могут отличаться по скорости в десятки раз. Наращивается производительность. А каким способом (разгоном или улучшением внутренней архитектуры, в том числе за счет кэша), это не столь важно.

Важна такая штука, как целесообразность. Если выгоднее наращивать частоту — так и будут делать. Если выгоднее на данном этапе пересмотреть архитектуру, то будут пересматривать и оптимизировать ее.

Прогресс заключается в уменьшении техпроцесса. Его явно видно. Уменьшение позволяет либо увеличить частоту, либо число транзисторов (либо и то и другое, но в меньшей степени). В случае, если большее число транзисторов дает лучший эффект, зачем наращивать гигагерцы? Чтобы маркетологам было чем меряться?

Важна такая штука, как целесообразность. Если выгоднее наращивать частоту — так и будут делать. Если выгоднее на данном этапе пересмотреть архитектуру, то будут пересматривать и оптимизировать ее.

Прогресс заключается в уменьшении техпроцесса. Его явно видно. Уменьшение позволяет либо увеличить частоту, либо число транзисторов (либо и то и другое, но в меньшей степени). В случае, если большее число транзисторов дает лучший эффект, зачем наращивать гигагерцы? Чтобы маркетологам было чем меряться?

0

Потому что я считаю, что (в отличие от мегапикселей) гигагерцы — основной показатель быстродействия процессора. Разница между разными процессорами с одинаковой частотой но разным техпроцессом и архитектурой существует, но боюсь, что не в десятки раз. Вы пишете, что выгоднее пересмотреть архитектуру, чем наращивать гигагерцы. А почему так? Почему раньше было выгодно делать по-другому? Вот в иви бриджах поменяли архитектуру, и что, они гораздо лучше стали? Во многом прогресс в последнее время обусловлен успехами в параллелизации, но не в архитектурных прорывах в пределах ядра, а ядро это уже выжато до максимума.

Я вашу точку зрения понял. Я тоже очень хочу, чтобы и далее прогресс в компьютерном железе не замедлялся.

Я вашу точку зрения понял. Я тоже очень хочу, чтобы и далее прогресс в компьютерном железе не замедлялся.

0

Ну вот берете и сравниваете в тестах селерон на базе P3, разогнанный с азотом до 3.5ГГц и одно ядро этого самого ivi bridge и получаете эти самые десятки раз. Или можно arm и топовые x86 сравнить. Не хочется азота — просто делите разницу в производительности на разницу в частоте.

ivi bridge стали лучше, конечно. Скорость кодирования (и декодирования) видео возрасла в несколько раз, благодаря новому набору команд. Увеличилась на 50% производительность встроенного видео. Уменьшилось энегропотребление. Вот сюда и ушла разница в архитектуре. А если бы сделали просто сделали 4ГГц аналог 2700K, то такого прироста в актуальных задачах не получили бы.

Для серверов актуальнее ядра — там добавили ядра. А просто старый проц с учеличенной частотой актуальным не показался, вот его и не сделали.

А раньше было выгодно делать по-другому, да. Небыло возможности встроить графику, небыло существенной необходимости кодировать видео определенным кодеком на десктопах, небыло необходимости снижать энегропотребление (а только держать его в рамках), потому и растили частоту. Рост частоты — экстенсивный путь.

Если считаете, что на десктопах не нужна многоядерность — попробуйте разогнать одноядерный проц по максимуму и поработать в системе, посерфить там, фильм фоном кинуть и сравнить с любым многоядерником по уровню комфорта. Вот сильно много ядер на десктопе не надо, потому больше 4 стараются и не делать. А на серверах делают.

Какая реальная практическая задача обычного покупателя мощного десктопного процессора, требует именно повышения частоты?

ivi bridge стали лучше, конечно. Скорость кодирования (и декодирования) видео возрасла в несколько раз, благодаря новому набору команд. Увеличилась на 50% производительность встроенного видео. Уменьшилось энегропотребление. Вот сюда и ушла разница в архитектуре. А если бы сделали просто сделали 4ГГц аналог 2700K, то такого прироста в актуальных задачах не получили бы.

Для серверов актуальнее ядра — там добавили ядра. А просто старый проц с учеличенной частотой актуальным не показался, вот его и не сделали.

А раньше было выгодно делать по-другому, да. Небыло возможности встроить графику, небыло существенной необходимости кодировать видео определенным кодеком на десктопах, небыло необходимости снижать энегропотребление (а только держать его в рамках), потому и растили частоту. Рост частоты — экстенсивный путь.

Если считаете, что на десктопах не нужна многоядерность — попробуйте разогнать одноядерный проц по максимуму и поработать в системе, посерфить там, фильм фоном кинуть и сравнить с любым многоядерником по уровню комфорта. Вот сильно много ядер на десктопе не надо, потому больше 4 стараются и не делать. А на серверах делают.

Какая реальная практическая задача обычного покупателя мощного десктопного процессора, требует именно повышения частоты?

0

Ну какие десятки раз. Я выше ссылку на тесты производительности ядра в реальных приложениях приводил. Е6850 отстает от ай5 2600 процентов на тридцать, а между ними четыре года. Селерон отстанет больше, так как они а) изначально урезаны б) идут с более старой инфраструктурой. Но не в десятки раз. Если в десятки — хотел бы посмотреть на эти замеры. Арм с х86 сравнивать тоже не вижу смысла. Если процессоры на разных наборах инструкций построены, нет смысла сравнивать скорость выполнения этих операций.

Иви Бридж выигрывает из-за нового видеочипа, энергопотребление упоминать в разговоре о производительности тоже не совсем корректно, по-моему. Производительность же основного вычислительного ядра если и улучшилась, то маргинально. В следующее поколение процессороы интеловцы может пылесос встроют, и эти процессоры будут убирать квартиру лучше, чем нынешние. Но это напрямую не будет означать автоматического увеличения производительности ядра.

С ядрами согласен, никакому пользователю больше640к 4 ядер не понадобится для обычных задач. Но думаю, что если бы и были нужны, не так просто разработать эффективную систему на их основе, так как возникнут проблемы с производительностью шины и памяти. Вполне возможно придется уходить от концепции полностью общей для всех ядер памяти.

Иви Бридж выигрывает из-за нового видеочипа, энергопотребление упоминать в разговоре о производительности тоже не совсем корректно, по-моему. Производительность же основного вычислительного ядра если и улучшилась, то маргинально. В следующее поколение процессороы интеловцы может пылесос встроют, и эти процессоры будут убирать квартиру лучше, чем нынешние. Но это напрямую не будет означать автоматического увеличения производительности ядра.

С ядрами согласен, никакому пользователю больше

0

Вот вам еще картинок для наглядности.

+5

Какие хорошие графики!

Не могли бы Вы дать ссылку на оригинальную презентацию, чтобы можно было посмотреть на остальную информацию?

Не могли бы Вы дать ссылку на оригинальную презентацию, чтобы можно было посмотреть на остальную информацию?

+2

Там на эту тему больше ничего нет, это из введения в параллельное программирование. Но если вам интересно, я спрошу завтра, можно ли полностью текстами лекций делиться, и дам ссылку. Хотя советую вам вместо этого почитать источники, указанные в слайдах.

Вот тут есть няшные картинки (предпоследний график)

isscc.org/doc/2011/2011_Trends.pdf

Вот статья — источник последнего графика:

web.ecs.baylor.edu/faculty/grabow/Summer2011/csi5345/secure/Refs/ComputingPerformance.pdf

И бонусом для самых любознательных целая книжка на тему:

books.google.nl/books?id=83eskZJmRoMC

Вот тут есть няшные картинки (предпоследний график)

isscc.org/doc/2011/2011_Trends.pdf

Вот статья — источник последнего графика:

web.ecs.baylor.edu/faculty/grabow/Summer2011/csi5345/secure/Refs/ComputingPerformance.pdf

И бонусом для самых любознательных целая книжка на тему:

books.google.nl/books?id=83eskZJmRoMC

+2

Хотя вот вам еще одна картинка, самая любимая.

+2

Спасибо за дополнительные ссылки на источники!

К сожалению, по достоинству оценить приведенные ссылки смогу лишь через пару дней, так как нахожусь сейчас в зоне плохого мобильного интернета…

По этой же причине, каюсь, сразу не стал искать по приведенным на слайдах ссылкам, а написал комментарий.

К сожалению, по достоинству оценить приведенные ссылки смогу лишь через пару дней, так как нахожусь сейчас в зоне плохого мобильного интернета…

По этой же причине, каюсь, сразу не стал искать по приведенным на слайдах ссылкам, а написал комментарий.

0

А там как раз и ссылка на презентацию подоспеет :)

Кстати, наш курс в TU Delft во многом основан на CS267 Berkeley. Вот их лекции 2007 года

www.cs.berkeley.edu/~yelick/cs267/

Ну и на ютубе записи лекций есть. Открывайте первую пдфку насчет кризиса жанра последовательных вычислений.

Кстати, наш курс в TU Delft во многом основан на CS267 Berkeley. Вот их лекции 2007 года

www.cs.berkeley.edu/~yelick/cs267/

Ну и на ютубе записи лекций есть. Открывайте первую пдфку насчет кризиса жанра последовательных вычислений.

0

Ха. Написано «Processing Power Trend», а на графике та же кукурузная частота в мегагерцах, что и на предыдущем.

Давайте для начала не путать тактовую частоту с фактической производительностью. Тактовая частота — это базовая физическая характеристика, у нее на кремнии есть предел. Производительность же — конечный эффект, который складывается и из частоты, и из количества ядер, и из архитектуры связей между ними, и из архитектуры ПО, которое на них запускается.

Существует некий аналог закона Мура для программных систем — например, известен случай, когда новый алгоритм на процессоре 1977 г. обогнал старый алгоритм на новом процессоре. Т. е. прогресс — штука многофакторная и к одним только гигагерцам не сводится, иначе бы вместе с гигагерцами застопорилось и все вышеперечисленное («винты, мониторы, вайфай»). Та же энергоэффективность — качественный показатель, от которого зависит, где именно в реальном мире можно применить этот самый гигагерц (или даже килогерц, если это будет, например, внутриклеточный нанокомпьютер) и какой результат он позволит получить.

В дальнейшем, очевидно, необходимо будет прыгать с кремния на что-то другое. Пока это отдельные транзисторы с космическими для кремния десятками и сотнями гигагерц, плюс квантовые вычисления — совершенно отдельная тема, плюс всяческая экзотика типа биосовместимых вычислительных устройств и т. д. Все это обладает почти неизученным сегодня потенциалом, который еще предстоит вывести из лабораторий в готовые продукты.

Так что правильнее говорить не о каком-то общем замедлении прогресса как такового, а об исчерпании текущей парадигмы (не первой и не последней) и необходимости поиска новых. Факт в том, что устройства, которые изначально предназначались для обработки информации (ПК), мутировали в своего рода машинки для ее приемопередачи пользователями (по мере распространения интернета), и вычислительные мощности все больше начали затачивать под обслуживание потребительских запросов (кодировка видео, кэширование стандартных операций в браузере и т. д.). Когда ПК попадал в руки к Человеку в 1982 г., он Творил. Когда ПК попадает человеку 2012 г., он преимущественно потребляет, общается, развлекается. Дело в общем-то не в том, что человек стал тупее или более падким на развлечения, а в том, что ПК растерял свой потенциал своего рода «окна в мир будущего» (а не в привычный веб с такими же юзверями).

В принципе, выход из этой проблемы есть — для начала необходимо признать ее факт и научиться оценивать реальный потенциал тех кажущихся новыми ИТ-решений, которые нам предлагают потреблять или создавать. ИТ, как и раньше, способны производить в мире качественные изменения даже без гигагерц (хотя в итоге принесут когда-нибудь и их), но для этого необходимо учиться отличать их от прочей ИТ-туфты, которой сейчас полна Сеть, от клонированных социалок-шмоциалок, пытающихся стать новым фейсбуком, до «инноваций» в рекламе, когда из видеоролика на потребителя внезапно выезжает машина. Это все способно легко отвлечь внимание, но это — не развитие ИТ, это их утилитарная эксплуатация, забивание гвоздей первым попавшимся девайсом. А двигать прогресс в ИТ — значит прекращать заниматься подобной маркетинговой хней и делать что-то, чему еще, возможно, и применения на «рынке» не нашли.

Давайте для начала не путать тактовую частоту с фактической производительностью. Тактовая частота — это базовая физическая характеристика, у нее на кремнии есть предел. Производительность же — конечный эффект, который складывается и из частоты, и из количества ядер, и из архитектуры связей между ними, и из архитектуры ПО, которое на них запускается.

Существует некий аналог закона Мура для программных систем — например, известен случай, когда новый алгоритм на процессоре 1977 г. обогнал старый алгоритм на новом процессоре. Т. е. прогресс — штука многофакторная и к одним только гигагерцам не сводится, иначе бы вместе с гигагерцами застопорилось и все вышеперечисленное («винты, мониторы, вайфай»). Та же энергоэффективность — качественный показатель, от которого зависит, где именно в реальном мире можно применить этот самый гигагерц (или даже килогерц, если это будет, например, внутриклеточный нанокомпьютер) и какой результат он позволит получить.

В дальнейшем, очевидно, необходимо будет прыгать с кремния на что-то другое. Пока это отдельные транзисторы с космическими для кремния десятками и сотнями гигагерц, плюс квантовые вычисления — совершенно отдельная тема, плюс всяческая экзотика типа биосовместимых вычислительных устройств и т. д. Все это обладает почти неизученным сегодня потенциалом, который еще предстоит вывести из лабораторий в готовые продукты.

Так что правильнее говорить не о каком-то общем замедлении прогресса как такового, а об исчерпании текущей парадигмы (не первой и не последней) и необходимости поиска новых. Факт в том, что устройства, которые изначально предназначались для обработки информации (ПК), мутировали в своего рода машинки для ее приемопередачи пользователями (по мере распространения интернета), и вычислительные мощности все больше начали затачивать под обслуживание потребительских запросов (кодировка видео, кэширование стандартных операций в браузере и т. д.). Когда ПК попадал в руки к Человеку в 1982 г., он Творил. Когда ПК попадает человеку 2012 г., он преимущественно потребляет, общается, развлекается. Дело в общем-то не в том, что человек стал тупее или более падким на развлечения, а в том, что ПК растерял свой потенциал своего рода «окна в мир будущего» (а не в привычный веб с такими же юзверями).

В принципе, выход из этой проблемы есть — для начала необходимо признать ее факт и научиться оценивать реальный потенциал тех кажущихся новыми ИТ-решений, которые нам предлагают потреблять или создавать. ИТ, как и раньше, способны производить в мире качественные изменения даже без гигагерц (хотя в итоге принесут когда-нибудь и их), но для этого необходимо учиться отличать их от прочей ИТ-туфты, которой сейчас полна Сеть, от клонированных социалок-шмоциалок, пытающихся стать новым фейсбуком, до «инноваций» в рекламе, когда из видеоролика на потребителя внезапно выезжает машина. Это все способно легко отвлечь внимание, но это — не развитие ИТ, это их утилитарная эксплуатация, забивание гвоздей первым попавшимся девайсом. А двигать прогресс в ИТ — значит прекращать заниматься подобной маркетинговой хней и делать что-то, чему еще, возможно, и применения на «рынке» не нашли.

+8

Я про это и говорю: текущий подход к архитектуре персональных компьютеров, основанный на одноядерных кремниевых интеловских процессорах, себя исчерпал (в условиях современных ОС и ЯП, если уж на то пошло). Ничего кардинально нового в обозримом будущем не предвидится, но конечно когда-нибудь придумается. Силы вкладываются в параллельные вычисления, но поскольку железячники программистов в этом пока обгоняют, спешить железячникам особо некуда. И социальные финтифлюшки тут совершенно не при чем. Гугл, амазон и тысячи других исследователей и промышленников формируют огромный устойчивый спрос на энергоэффективные мощные вычислительные устройства, так что инженеры интела штаны не просиживают, оптимизируя Ivy Bridge под музыкальный плеер из вконтактика. Да и обществу потребления только дай десятигигагерцевые процессоры — разметут, будьте уверены, уж постарается отдел маркетинга. Но их нет.

+1

Ну на процессорах еще сервера крутятся, там все очень хорошо параллелится, так что сидеть сложа руки нет смысла (на десктоп же идут те-же самые процессоры, по сути).

Кстати, активным двигателем прогресса процессоров вседа были игры. Как они ушли на видеокарты, рост характеристик, важных для рендеринга игр замедлился.

Кстати, активным двигателем прогресса процессоров вседа были игры. Как они ушли на видеокарты, рост характеристик, важных для рендеринга игр замедлился.

0

Общество потребления и сегодняшние процессоры с удовольствием схавало бы году этак в 1962, но для того, чтобы они стали реальностью, рынку ЭВМ необходимо было пройти через ряд фаз и смен парадигм и из научно-исследовательского превратиться сначала в коммерческий, затем привлечь частных пользователей-энтузиастов ПК и наконец добраться до домохозяек.

Я как раз о том, что когда ПК превратился в продукт для домохозяек, то именно они начали прежде всего диктовать, каким ПК должен быть и какие функции поддерживать. Это не фатальная проблема, если программистам удается найти способ продать домохозяйкам высокую производительность — например, подсадив их на какую-нибудь игрушку или приложение вроде Google Earth. Возможно, именно в этом программисты сейчас пока еще недорабатывают — но такие тренды, как big data, онлайн-образование и все, что связано с человеческим здоровьем, содержат внушительный потенциал для развития в ближайшие годы, а там, возможно, и железо совершит очередной востребованный скачок, особенно при успешном использовании параллельного программирования.

Я как раз о том, что когда ПК превратился в продукт для домохозяек, то именно они начали прежде всего диктовать, каким ПК должен быть и какие функции поддерживать. Это не фатальная проблема, если программистам удается найти способ продать домохозяйкам высокую производительность — например, подсадив их на какую-нибудь игрушку или приложение вроде Google Earth. Возможно, именно в этом программисты сейчас пока еще недорабатывают — но такие тренды, как big data, онлайн-образование и все, что связано с человеческим здоровьем, содержат внушительный потенциал для развития в ближайшие годы, а там, возможно, и железо совершит очередной востребованный скачок, особенно при успешном использовании параллельного программирования.

+1

> В дальнейшем, очевидно, необходимо будет прыгать с кремния на что-то другое. Пока это отдельные транзисторы с космическими для кремния десятками и сотнями гигагерц

Мдя, вы правда не понимаете, что современные кремниевые транзисторы, в процессорах, имеют граничную частоту в десятки-сотню ГГц? И запас на порядок совершенно необходим для их работы в переключательных схемах (вспоминаем про Фурье).

Существенно частоты уже не вырастут, ну а для параллельных вычислений есть закон Амдала.

Мдя, вы правда не понимаете, что современные кремниевые транзисторы, в процессорах, имеют граничную частоту в десятки-сотню ГГц? И запас на порядок совершенно необходим для их работы в переключательных схемах (вспоминаем про Фурье).

Существенно частоты уже не вырастут, ну а для параллельных вычислений есть закон Амдала.

+1

А зачем производительность мерять частотой?

+1

А какая простая метрика для этого подойдет лучше? Да, производительность зависит от многих факторов, но тактовая частота в ней все же фактор определяющий.

0

Бенчмарк подойдет лучше в типовых задачах (ваших). А гигагерцы еще со времени Athlon XP не показатель (потому, там и ввели рейтинг). Вы можете разогнать, допустим, старый селерон до 4Ггц (пусть и с азотом). Но по производительности в подавляющем большинстве задач он не догонит даже одно ядро 2.4 ГГц нового i7. Не то, что не догонит, но серьезно отстанет.

Вы еще фотоаппарат мегапикселями померяйте.

Вы еще фотоаппарат мегапикселями померяйте.

+3

Так старый селерон ведь со старой памятью, шиной и маленьким кэшем работает. Да и на винте небось потрепанном. Их же вы с семерки не перенесете, чтобы сделать им равные условия.

0

Шутку юмора с мегапикселями оценил, но при прочих равных лучше больше мегапикселей. А перед лицом маленькой матрицы, как и для маленького кэша, все равны.

0

при прочих равных лучше больше мегапикселей? Это неправда. Но тема для отдельного холивара.

Посмотрите качество фоток совеременных ультракомпактов с бешенным числом мегапикселей и подобных по размеру матрицы ульразумов прошлого поколения с меньшим числом пикселей, чтобы оценить разницу. Смотрите фотки в плохом освещении.

Посмотрите качество фоток совеременных ультракомпактов с бешенным числом мегапикселей и подобных по размеру матрицы ульразумов прошлого поколения с меньшим числом пикселей, чтобы оценить разницу. Смотрите фотки в плохом освещении.

0

Я сам на шестимегапиксельную зеркалку снимаю, не рассказывайте мне про ультракомпакты. Под «при прочих равных» я имею ввиду что не отказался бы от 10Мп с тем же качеством, но не променял бы на матрицу от 20Мп компакта размером с блошиный ноготь.

+1

При том-же размере матрицы, больше мегапикселей это меньше полезной площади. Между пикселями есть промежутки и процент площади, что эти промежутки занимают, растет с количеством пикселей.

Т.е. при прочих равных, светочувтствительность будет хуже. Другое дело, что это можно компенсировать, но это уже не «прочие равные».

Т.е. при прочих равных, светочувтствительность будет хуже. Другое дело, что это можно компенсировать, но это уже не «прочие равные».

0

суперПи посчитайте или что-то еще, что памяти особо не требует. Да и задержки, вносимые извне тоже вполне можно померять (чтобы убедиться, что виноваты не они).

+1

А есть готовые такие бенчмарки? Ради интереса. Да и все равно, там не все в регистрах будет происходить, в кэш/память что-то уйдет.

0

СуперПи это и есть бенчмарк, считает он просто Пи. Кэш процессора это часть процессора. Если часть производительности достигнута благодаря использованию этого кэша, то это полностью заслуга самого процессора.

+1

Это понятно, что он часть процессора, но я имею ввиду, что уже достигнут физический лимит на тактовую частоту, и какие-то дальнейшие улучшения возможны только играясь с инфраструктурой и архитектурой, ну и уменьшая техпроцесс. А это в сумме вряд ли сможет дать большой прирост.

0

НЛО прилетело и опубликовало эту надпись здесь

Наращивание частоты стало давать меньший эффект по сравнению с изменениями архитектуры. А еще, изменение архитектуры позволит делать быстрее процессоры в ноутбуках и ультрабуках, а повышение тактовой частоты — нет. Точнее, будет гораздо сложнее бороться с перегревом, чем в случае изменения архитектуры без повышения частоты.

Не делают не потому, что не могут, а потому, что на данном этапе это не выгодно.

Не делают не потому, что не могут, а потому, что на данном этапе это не выгодно.

0

Производительность, конечно, растет. Смартфоны, планшеты, ультрабуки, часофоны и всяческие сенсоры. А также серверы, суперкомпьютеры, датацентры и прочие облака.

Но вот то, что вытворяет в последнее время компания Intel на десктопном рынке, не лезет ни в какие ворота. Лет 5-6 назад было громко объявлено, что приоритетом в наращивании производительности процессоров становится количество ядер. Были анонсированы 48- и даже 100-ядерные процессоры к 2010 г. Ладно там 48, но где хотя бы 8-ядерные камни? Почему у меня уже 4 года пашет Q6600 и я не вижу чего-то такого, на что хотелось бы этот процессор поменять (при том что к апгрейду вынуждают нехватка памяти, отсутствие USB 3.0 и прочие общесистемные показатели). Это 65 нм. Сейчас они переходят с 32 на 22 нм, и что мы видим: новые процы с теми же 4 ядрами гонятся хуже, греются больше (!), а в номинале показывают прирост производительности на какие-то 5%. Более того, модель среднего уровня даже не может обойти своего предшественника:

www.ferra.ru/ru/system/review/Intel-Ivy-Bridge-processors-motherboard/

При том к абсурду в виде нах никому не нужного встроенного видео добавился единственный «экстремальный» проц, предназначенный для… ноутбуков.

Такое впечатление, что они всерьез восприняли слова горе-аналитиков от веба и мобильного рынка о том, что «ПК умер» и теперь «наше всё» — это смартфончики с аппликашками для социалок-шмоциалок. Где, сцуко, истинный смысл закона Мура? Где развитие ПК как платформы для хардкорных программистов и геймеров? Зачем нам ускорение потребительских функций вроде перекодировки видео проприетарными кодеками, чтобы домохозяйка Маша сказала «вау»? Что дальше — аппаратные DRM и TPM?

Похоже, маркетологи Intel слишком заигрались в имитацию будущего (это именно они, если кто помнит, придумали популярный сейчас закругленный шрифт, вариации которого дошли аж до официальной символики пресловутого Евро-2012) и забыли о том, что позволило этой компании продолжить дорогу из научных лабораторий на стол этих самых домохозяек. Что без промежуточного звена — программиста, оверклокера, ИТ-профессионала, в общем хакера в истинном смысле слова — ПК еще не скоро появился бы в каждом доме, а без ПК и прочая мобильная периферия также еще долго разделяла бы участь Apple Newton.

Пора образумить эту компанию долларом. Не покупайте Ivy Bridge! Это выброшенные на ветер деньги. Пусть они поймут, что это направление развития — тотальный фейл, кукуруза 2.0. Также я хотел бы напомнить о важности конкуренции как двигателя прогресса и поддержать находящуюся в нелегких условиях компанию AMD. Если сегодня кто-то и может образумить зажравшихся штеудов, так это черно-зеленые.

Чего я требую? Я требую, чтобы новое десктопное железо было максимально избавлено от никому не нужного мусора, внедренного в маркетинговых целях (вроде интегрированного видеоядра, место которого могла бы занять пара-тройка полноценных процессорных ядер) и ориентировано на предоставление качественно новых возможностей не только потребителям готового контента, но и в первую очередь его создателям — программистам, дизайнерам, хакерам. Потому что десктоп, особенно в наше время тотальной мобильности — это в первую очередь платформа Творца, который создает все то, что потом юзеры перелистывают жестами руки на своих айпадиках и айфончиках.

Сейчас я в упор не вижу, какие такие новые возможности мне даст Ivy Bridge, которых не дал бы Sandy Bridge, не говоря уже о том, что и на текущем Q6600 до сих пор вполне комфортно работается, и узкое место этой платформы, из-за которой с нее придется уйти — не процессор. А с другой стороны есть Bulldozer о 8 ядрах и задел на нечто качественно новое. AMD нас уже не раз радовала принципиально новыми шагами именно тогда, когда Штеуд топтался на месте или неадекватно задирал цены: Атлон против кукурузы, Бартон против обогревателей «Прескотт», 64 бита против убожества под названием Pentium D. Затем где-то лет 5 интел непрерывно наступал благодаря Core 2. Но сейчас, похоже, эта компания опять в тупике и лажанулась с новой архитектурой. Придется объявить ей бойкот на десктопах до тех пор, пока не разродится чем-то действительно новым.

Но вот то, что вытворяет в последнее время компания Intel на десктопном рынке, не лезет ни в какие ворота. Лет 5-6 назад было громко объявлено, что приоритетом в наращивании производительности процессоров становится количество ядер. Были анонсированы 48- и даже 100-ядерные процессоры к 2010 г. Ладно там 48, но где хотя бы 8-ядерные камни? Почему у меня уже 4 года пашет Q6600 и я не вижу чего-то такого, на что хотелось бы этот процессор поменять (при том что к апгрейду вынуждают нехватка памяти, отсутствие USB 3.0 и прочие общесистемные показатели). Это 65 нм. Сейчас они переходят с 32 на 22 нм, и что мы видим: новые процы с теми же 4 ядрами гонятся хуже, греются больше (!), а в номинале показывают прирост производительности на какие-то 5%. Более того, модель среднего уровня даже не может обойти своего предшественника:

www.ferra.ru/ru/system/review/Intel-Ivy-Bridge-processors-motherboard/

При том к абсурду в виде нах никому не нужного встроенного видео добавился единственный «экстремальный» проц, предназначенный для… ноутбуков.

Такое впечатление, что они всерьез восприняли слова горе-аналитиков от веба и мобильного рынка о том, что «ПК умер» и теперь «наше всё» — это смартфончики с аппликашками для социалок-шмоциалок. Где, сцуко, истинный смысл закона Мура? Где развитие ПК как платформы для хардкорных программистов и геймеров? Зачем нам ускорение потребительских функций вроде перекодировки видео проприетарными кодеками, чтобы домохозяйка Маша сказала «вау»? Что дальше — аппаратные DRM и TPM?

Похоже, маркетологи Intel слишком заигрались в имитацию будущего (это именно они, если кто помнит, придумали популярный сейчас закругленный шрифт, вариации которого дошли аж до официальной символики пресловутого Евро-2012) и забыли о том, что позволило этой компании продолжить дорогу из научных лабораторий на стол этих самых домохозяек. Что без промежуточного звена — программиста, оверклокера, ИТ-профессионала, в общем хакера в истинном смысле слова — ПК еще не скоро появился бы в каждом доме, а без ПК и прочая мобильная периферия также еще долго разделяла бы участь Apple Newton.

Пора образумить эту компанию долларом. Не покупайте Ivy Bridge! Это выброшенные на ветер деньги. Пусть они поймут, что это направление развития — тотальный фейл, кукуруза 2.0. Также я хотел бы напомнить о важности конкуренции как двигателя прогресса и поддержать находящуюся в нелегких условиях компанию AMD. Если сегодня кто-то и может образумить зажравшихся штеудов, так это черно-зеленые.

Чего я требую? Я требую, чтобы новое десктопное железо было максимально избавлено от никому не нужного мусора, внедренного в маркетинговых целях (вроде интегрированного видеоядра, место которого могла бы занять пара-тройка полноценных процессорных ядер) и ориентировано на предоставление качественно новых возможностей не только потребителям готового контента, но и в первую очередь его создателям — программистам, дизайнерам, хакерам. Потому что десктоп, особенно в наше время тотальной мобильности — это в первую очередь платформа Творца, который создает все то, что потом юзеры перелистывают жестами руки на своих айпадиках и айфончиках.

Сейчас я в упор не вижу, какие такие новые возможности мне даст Ivy Bridge, которых не дал бы Sandy Bridge, не говоря уже о том, что и на текущем Q6600 до сих пор вполне комфортно работается, и узкое место этой платформы, из-за которой с нее придется уйти — не процессор. А с другой стороны есть Bulldozer о 8 ядрах и задел на нечто качественно новое. AMD нас уже не раз радовала принципиально новыми шагами именно тогда, когда Штеуд топтался на месте или неадекватно задирал цены: Атлон против кукурузы, Бартон против обогревателей «Прескотт», 64 бита против убожества под названием Pentium D. Затем где-то лет 5 интел непрерывно наступал благодаря Core 2. Но сейчас, похоже, эта компания опять в тупике и лажанулась с новой архитектурой. Придется объявить ей бойкот на десктопах до тех пор, пока не разродится чем-то действительно новым.

+7

Ну возьмите вы IBM Cell, если так многоядерности хочется. Или Ксеон, если так уж Интел надо — там 8 ядер. Ну или требуйте невозможного дальше.

Сказано же — некуда расти больше, а для большинства пользователей пока от кучи ядер толку мало. Выпустят когда срок придет. А пока надо же маркетологов чем-то занять.

Сказано же — некуда расти больше, а для большинства пользователей пока от кучи ядер толку мало. Выпустят когда срок придет. А пока надо же маркетологов чем-то занять.

+1

Требования невозможного на данном этапе — это что-то вроде 5 ГГц в номинале, или 48 ядер с сегодняшними 2-3 ГГц.

А здесь речь о том, что новое распиаренное поколение процессоров «Плющовый мост», со всей его 3D-архитектурой с трудом обходит даже своих предшественников из поколения «Песчаный мост» и не дотягивает до якобы «лузерского» Бульдозера. И даже в вышеприведенных результатах тестирования зачем-то значительное место уделяется сравнению производительности встроенных видеоядер, в то время как, например, в WinRAR 3770K вообще отстает от 2500K, и об этом сказано как бы между прочим.

При этом технически произошел реальный переход на новый 22 нм техпроцесс, т. е. закон Мура сделал очередной полноценный шаг, да еще и в третье измерение, но влияние этого шага на реальную производительность, способность к разгону и тепловыделение почему-то отрицательное, из-за чего возникает вопрос — а где здесь вообще прогресс как таковой?

А здесь речь о том, что новое распиаренное поколение процессоров «Плющовый мост», со всей его 3D-архитектурой с трудом обходит даже своих предшественников из поколения «Песчаный мост» и не дотягивает до якобы «лузерского» Бульдозера. И даже в вышеприведенных результатах тестирования зачем-то значительное место уделяется сравнению производительности встроенных видеоядер, в то время как, например, в WinRAR 3770K вообще отстает от 2500K, и об этом сказано как бы между прочим.

При этом технически произошел реальный переход на новый 22 нм техпроцесс, т. е. закон Мура сделал очередной полноценный шаг, да еще и в третье измерение, но влияние этого шага на реальную производительность, способность к разгону и тепловыделение почему-то отрицательное, из-за чего возникает вопрос — а где здесь вообще прогресс как таковой?

+1

Не «зачем-то», а потому что надо же их как-то продавать. Понятное дело, что затормозился сейчас прогресс, но будем надеятся, что инженеры интела извернутся и придумают что-то кардинально новое. Слава богу, в сытые годы компания жирка накопила, еще долго сможет им зарплату платить, даже если и не будет сиюминутных результатов. Хотя и сейчас они не в убыток работают.

+1

Дык не затормозился же, если мерять его нанометрами! Да, затянули выпуск нового поколения на полгода, но все же выпустили — 22 нм после 32, это реальный прогресс в техпроцессе. А по конечному результату в архитектуре — минус: выше температура, хуже разгон, прирост по номиналу где минимальный, где вообще отрицательный. Зачем вообще тогда выпускать это убожество, иначе как по копеечной цене? Ученые и инженеры сделали свою работу на отлично — к ним претензий быть не может. А вот архитекторам и маркетологам — фак. Но даже при таком раскладе можно было извернуться и сделать фишку, ради которой хоть кому-то была бы от этого поколения реальная польза.

+1

То есть интел, по сути дела, продемонстрировал нам очередной образец кукурузы: не в гигагерцах, но в нанометрах. И именно после того, как они распиарили этот параметр закона Мура, что его начал узнавать даже гопник Вася, получился такой же фейл, как с гигагерцами в 2004. Я даже догадываюсь, для чего это: чтобы через пару месяцев выпустить «обновление» той же архитектуры с какой-то реальной фишкой (+ 2 ядра, разгонный потенциал, тепловыделение, кэш), и купившие фейл тут же побегут покупать новьё.

+1

для большинства пользователей пока от кучи ядер толку мало.

Есть такая довольно популярная программа Google Chrome. Она, по-моему, съесть всё что ей дадут в плане ядер. Особенно если научиться параллелить флэш (или дать ему умереть :) ).

И что невозможного в выпуске десктопного 8-ядерного процессора?

Есть такая довольно популярная программа Google Chrome. Она, по-моему, съесть всё что ей дадут в плане ядер. Особенно если научиться параллелить флэш (или дать ему умереть :) ).

И что невозможного в выпуске десктопного 8-ядерного процессора?

0

Ничего, берите и пользуйтесь. Но зачем? Мой хром и одно ядро загрузить не может (и это я еще флэш не резал).

Такие многоядерные процессоры будут нужны, когда появятся фреймворки, позволяющие программировать под них параллльные приложения на таких же простых принципах, как мы программируем сейчас для одного ядра. Чтобы любой толковый программист мог с их помощью написать параллельный архиватор, видеокодек, игрушку, рендерер, сервер или на чем он там специализируется, без того, чтобы большую часть времени отлаживать код, непосредственно не связанный с бизнес-логикой, а нужный исключительно для поддержки параллелизма. Но вот что-то я таких фреймворков не наблюдаю. А такие например параллельные и распределенные технологии как MPI, MapReduce, pthreads пригодны только для определенного круга задач и не то чтобы особо просты в освоении.

Такие многоядерные процессоры будут нужны, когда появятся фреймворки, позволяющие программировать под них параллльные приложения на таких же простых принципах, как мы программируем сейчас для одного ядра. Чтобы любой толковый программист мог с их помощью написать параллельный архиватор, видеокодек, игрушку, рендерер, сервер или на чем он там специализируется, без того, чтобы большую часть времени отлаживать код, непосредственно не связанный с бизнес-логикой, а нужный исключительно для поддержки параллелизма. Но вот что-то я таких фреймворков не наблюдаю. А такие например параллельные и распределенные технологии как MPI, MapReduce, pthreads пригодны только для определенного круга задач и не то чтобы особо просты в освоении.

+1

Речь об Интел всё же была. А на этот я да, нацелился. Потому что мой хром два ядра грузит (вернее одно флэш на 100%) и периодически я вынужден убивать вкладки, чтобы хотя бы скроллинг нормально работал.

0

Тогда берите сразу двенадцать, пусть и в виде двух физических чипов.

www.apple.com/macpro/

Флеш да, параллель-не параллель, проще пристрелить, чтобы ме мучился.

www.apple.com/macpro/

Флеш да, параллель-не параллель, проще пристрелить, чтобы ме мучился.

+1

НЛО прилетело и опубликовало эту надпись здесь

Кстати, вот где нужен хардкор graphics.cs.williams.edu/archive/SweeneyHPG2009/ или вот habrahabr.ru/post/126294/ Но проблема курицы и яйца, нет нужного софта, нет и нужных процессоров :) Так что Tim Sweeney призывает разработчиков начинать пилить софт, а хардкорщики подтянутся следом, может и правда запилят чего, да и мы может успеем поучаствовать :)

+1

А для бытовых задач прекрасно подходят несколько ядер

Как мне кажется, в идеале число ядер должно быть больше или равно числу процессов в системе. Увеличит это её производительность? Несомненно. Увеличит комфорт пользователя? Тоже.

Другой вопрос сколько будет стоить 256-ядерный процессор (глядя на свои 200+ процессов) и готов ли пользователь за него столько платить.

Как мне кажется, в идеале число ядер должно быть больше или равно числу процессов в системе. Увеличит это её производительность? Несомненно. Увеличит комфорт пользователя? Тоже.

Другой вопрос сколько будет стоить 256-ядерный процессор (глядя на свои 200+ процессов) и готов ли пользователь за него столько платить.

0

По цене самолета, конечно, не нужно. Но вот пара-тройка дополнительных ядер с умеренной производительностью даже на обычном ПК, чтобы скидывать на них фоновые задачи для более быстрого доступа по запросу, явно не помешает. Вместо этого нам предлагают встроенное видео. Зачем оно на десктопе при наличии дискретной видеокарты? Когда-то в прошлом мобильные процессоры делали из обычных десктопных, получалось не очень хорошо, ибо в мобильности как раз рулит та самая аппаратная поддержка типовых задач, в т. ч. и видео; а теперь наоборот — суют на десктоп сугубо мобильный функционал, и что нужно, и что не нужно, и превращают десктоп в большой такой стационарный ноутбук, в то время как у него принципиально другие задачи, это своего рода домашняя рабочая и игровая станция с функциями сервера (которые с нее постепенно выносятся на другие устройства).

Понятно, что сегодня есть быстрый и дешевый интернет, есть облака, куда можно оперативно сбрасывать задачи с особыми требованиями к производительности, по цене не самолета, а, скажем, билета на него. Суперкомпьютеры и датацентры и их железо — отдельная тема. Но речь идет прежде всего о юзер экспириенсе профессионального пользователя ПК, о тех задачах, которые оптимально выполнять локально. От рутинной компиляции, архивации, рендеринга и т. д. до времени запуска приложения. Здесь такое впечатление, будто все перевернулось вверх дном в угоду обывателю с рюшечками.

Понятно, что сегодня есть быстрый и дешевый интернет, есть облака, куда можно оперативно сбрасывать задачи с особыми требованиями к производительности, по цене не самолета, а, скажем, билета на него. Суперкомпьютеры и датацентры и их железо — отдельная тема. Но речь идет прежде всего о юзер экспириенсе профессионального пользователя ПК, о тех задачах, которые оптимально выполнять локально. От рутинной компиляции, архивации, рендеринга и т. д. до времени запуска приложения. Здесь такое впечатление, будто все перевернулось вверх дном в угоду обывателю с рюшечками.

0

Вам хватает q6600 или не хватает, я что-то не пойму? Если у вас загружены все ядра q6600, попробуйте тем-же самым нагрузить i7 2700К или 3770K, очень сильно удивитесь.

0

while(true){

println("Pwned by infinite loop");

}

Пока идиоты, клепающие дико кривой софт, не вымрут, любой процессор можно загрузить.

+2

Я говорю о реальной загрузке на практике, в той системе, что использует vxsw. Если у него процессор бывает нагружен процентов на 50-60 (все ядра), то замена его на i7 позволит существенно снизить загрузку и увеличить скорость выполенения задач. Если бесконечные пустые циклы гонять, то тут процессор не при чем, они будут и на 8086 выполняться с той-же скоростью.

0

Не все на компьютере играют в 3д-шутеры, для огромного количества машин зватает дешевого встроенного видео, для них это и делается. Кроме того, процессоры той же архитектуры идут в ноутбуки.

0

Вот именно что, если уже заговорили о вымирании десктопов, то их теснят прежде всего ноуты в низкопроизводительном сегменте, в офисах, а также неттопы и вообще тонкие клиенты. А десктопы где и остаются, то в основном благодаря высокой производительности и дискретному видео. А их наоборот поставили в зависимость от вымирающего сегмента бюджетных настольных ПК в громоздких, но дешевых коробках, где раньше видео интегрировалось по запросу в мамку.

0

Какая зависимость? Ставьте дискретную карту и играйтесь в удовольствие. Не хватает мощности игрушках, так макпро купите с двумя шестиядерными ксеонами, там встроенного видео нет. Если бы имело коммерческий смысл вместо видеочипа ставить еще одно ядро, так бы и делали. Но наверное это не оправдывает затрат на лишний R&D или просто интеловцы не видят смысла делать отдельную продуктовую линейку. Если бы сделали, то и те, и эти процессоры были бы банально дороже.

Я тоже сейчас за десктопом сижу с санди бриджем и дискретным видео, на матплате при этом выход для интегрированного чипа не разведен даже. Работаю, доволен, для всего хватает.

Я тоже сейчас за десктопом сижу с санди бриджем и дискретным видео, на матплате при этом выход для интегрированного чипа не разведен даже. Работаю, доволен, для всего хватает.

0

Макпро с двумя шестиядерными ксеонами… Похоже на заговор Intel и Apple:)))

Но мне как-то вспоминается история начала 00-х с кукурузными мегагерцами P4, когда тоже убеждали — подождите, четвертый пень проявит себя на совсем других частотах… Ага, проявил по всем заветам Никиты Сергеича:). Потом были пару лет неадекватного завышения цен и восхождения Athlon, что продолжалось аж до Core 2 Duo. Похоже, теперь снова наступает звездный час черно-зеленых.

Но мне как-то вспоминается история начала 00-х с кукурузными мегагерцами P4, когда тоже убеждали — подождите, четвертый пень проявит себя на совсем других частотах… Ага, проявил по всем заветам Никиты Сергеича:). Потом были пару лет неадекватного завышения цен и восхождения Athlon, что продолжалось аж до Core 2 Duo. Похоже, теперь снова наступает звездный час черно-зеленых.

0

НЛО прилетело и опубликовало эту надпись здесь

Я в курсе цен на рабочие станции и прямо сейчас, тем более по такой цене, они мне лично не нужны.

Я стремлюсь к другому — чтобы производительность продолжала как можно быстрее мигрировать от рабочих станций к обычным ПК, от суперкомпьютеров к рабочим станциям и серверам и т. д.

Лично я отдельно взятой покупкой или даже программной разработкой вряд ли могу сильно на это повлиять, тем более на разработку собственно процессорных технологий, но вот на маркетинговые факторы, что выпускать и в каком направлении разрабатывать, очень сильно способна повлиять конкуренция между Intel и AMD, а также голосование множества покупателей долларом в пределах ассортимента продукции одного производителя. Поэтому я — за конкуренцию и сегодня больше склоняюсь к продукции AMD, пора уже этой компании напомнить о себе, чтобы штеуд не почивал на лаврах монополии.

От этого в конечном итоге зависит, получит ли тот же потребитель через 10 лет только лишь улучшенную версию контактика с фильмами в UltraHD или что-то качественно новое (каким для минувшего десятилетия был тот же контактик и вообще веб 2.0).

Я стремлюсь к другому — чтобы производительность продолжала как можно быстрее мигрировать от рабочих станций к обычным ПК, от суперкомпьютеров к рабочим станциям и серверам и т. д.

Лично я отдельно взятой покупкой или даже программной разработкой вряд ли могу сильно на это повлиять, тем более на разработку собственно процессорных технологий, но вот на маркетинговые факторы, что выпускать и в каком направлении разрабатывать, очень сильно способна повлиять конкуренция между Intel и AMD, а также голосование множества покупателей долларом в пределах ассортимента продукции одного производителя. Поэтому я — за конкуренцию и сегодня больше склоняюсь к продукции AMD, пора уже этой компании напомнить о себе, чтобы штеуд не почивал на лаврах монополии.

От этого в конечном итоге зависит, получит ли тот же потребитель через 10 лет только лишь улучшенную версию контактика с фильмами в UltraHD или что-то качественно новое (каким для минувшего десятилетия был тот же контактик и вообще веб 2.0).

0

Какой вы категоричный. Встроенная в процессор видяха и аппаратное кодирование/декодирование это отличная вещь для недорогих ПК (хотя кодирование актуально для всех). И старую кору вам не надо менять не потому что процессоры стали не лучше, а потому, что программы стали оптимизировать. Вам бы спасибо сказать, что ваши деньги экономят=)

Если найдете чем загрузить процессор, то увидите, на сколько новое поколение опережает то, что есть у вас. Очень и очень неслабо. А HT дают почти 8 ядер, если так нужно. Где вы их планируете использовать, только?

Если найдете чем загрузить процессор, то увидите, на сколько новое поколение опережает то, что есть у вас. Очень и очень неслабо. А HT дают почти 8 ядер, если так нужно. Где вы их планируете использовать, только?

0

Недорогой ПК офисного применения — в наше время все чаще значит «ноут» (или что-то вроде неттопа). А десктопу не нужен компромисс, ему нужна максимальная оптимизация под производительность. Это все равно что в обязательном порядке снабжать все «Феррари» несъемными грузовыми прицепами.

0

Не нужно все мерять по себе. Офисные компьютеры в стандартных коробках — огромный рынок, и неттопы их не заменят, потому что их хотя бы сложнее ремонтировать. Да и десктоп с приличным монитором все лучше для многих офисов, чем ноут.

0

Десктоп, это чаще всего, игровая машина. В ноут просто видео дискретное не станет (такое, как станет в десктоп). И тут многоядерность, как и суперпроизводительность процессора не играет особой роли, упрется все равно в видеокарту.

Если применения другие, можно собрать себе все, что угодно. Современный десктопный процессор запросто уделает десяток серверных/профессиональных восьмилетней давности. А если вы хотите чтобы самое крутое _современное_ железо стоило пару сотен, то мотивы такого желания остаются непонятными. В таком случае, странно, что мерседесы пару тысяч не стоят, или 30" монитор нельзя за 300 баксов купить (я о новых и машинах и мониторах).

Если применения другие, можно собрать себе все, что угодно. Современный десктопный процессор запросто уделает десяток серверных/профессиональных восьмилетней давности. А если вы хотите чтобы самое крутое _современное_ железо стоило пару сотен, то мотивы такого желания остаются непонятными. В таком случае, странно, что мерседесы пару тысяч не стоят, или 30" монитор нельзя за 300 баксов купить (я о новых и машинах и мониторах).

0

Десктоп — в смысле, мощных десктоп, а не дешевый, который по каким-то причинам предпочли ноутбуку.

0

Причем здесь «самое крутое»?

Речь о текущих трендах в развитии десктопных и мобильных платформ. О том, что сегодня десктоп заставили плясать под мобильную дудку, и особой выгоды для его производительности это не дает. Что и показывают более чем скромные результаты тестирования Ivy Bridge по сравнению с Sandy Bridge. Десктопу просто не уделяют внимания так, как еще лет 10 назад. Если даже самая экстремальная «оверклокерская» модель проца теперь предназначена для… ноутбуков, о чем еще может быть речь. (Зачем она там и что она даст оверклокерам — хз.)

Речь о текущих трендах в развитии десктопных и мобильных платформ. О том, что сегодня десктоп заставили плясать под мобильную дудку, и особой выгоды для его производительности это не дает. Что и показывают более чем скромные результаты тестирования Ivy Bridge по сравнению с Sandy Bridge. Десктопу просто не уделяют внимания так, как еще лет 10 назад. Если даже самая экстремальная «оверклокерская» модель проца теперь предназначена для… ноутбуков, о чем еще может быть речь. (Зачем она там и что она даст оверклокерам — хз.)

0

Где мобильная дудка? Выпускать более быстрые процессоры осенью и более холодные с практически такой-же производительностью, весной, это стандартная схема работы intel.

О какой моделе проца вы говорите? Может просто еще не вышел экстемальный десктопный проц, а вышла в основном мобильная линейка потому, что apple давит по срокам? Мобильные процы сейчас намного слабее десктопных.