По мере того, как телескопы стали более совершенными, данные наблюдений за галактиками, квазарами и материей в межгалактическом пространстве стали более подробными и способными охватить все большие диапазон эпох Вселенной. Но ничего не возникает из практических наблюдений — для начала нужна гипотеза. Космологические симуляции — важная часть исследования природы Вселенной, та самая гипотеза, рождаемая в ходе наблюдения за моделью. Моделирование формирования галактик помогает предсказать поведение вселенной и ее компонентов в различных сценариях и решить проблемы темной материи как одну из задач современной космологии.

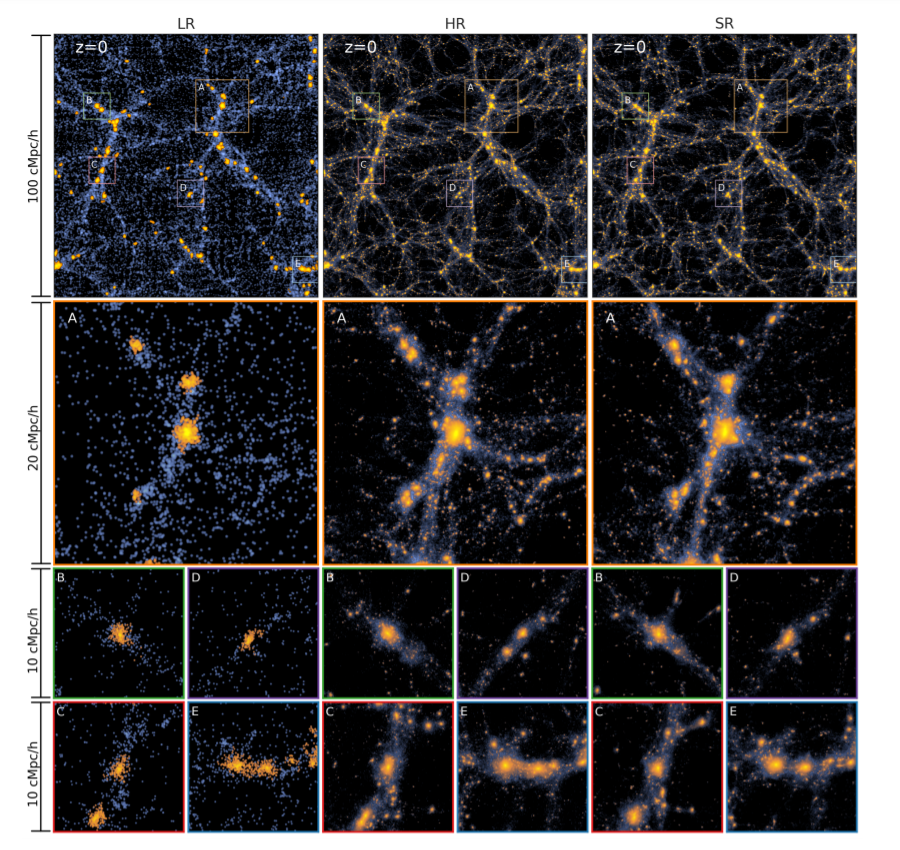

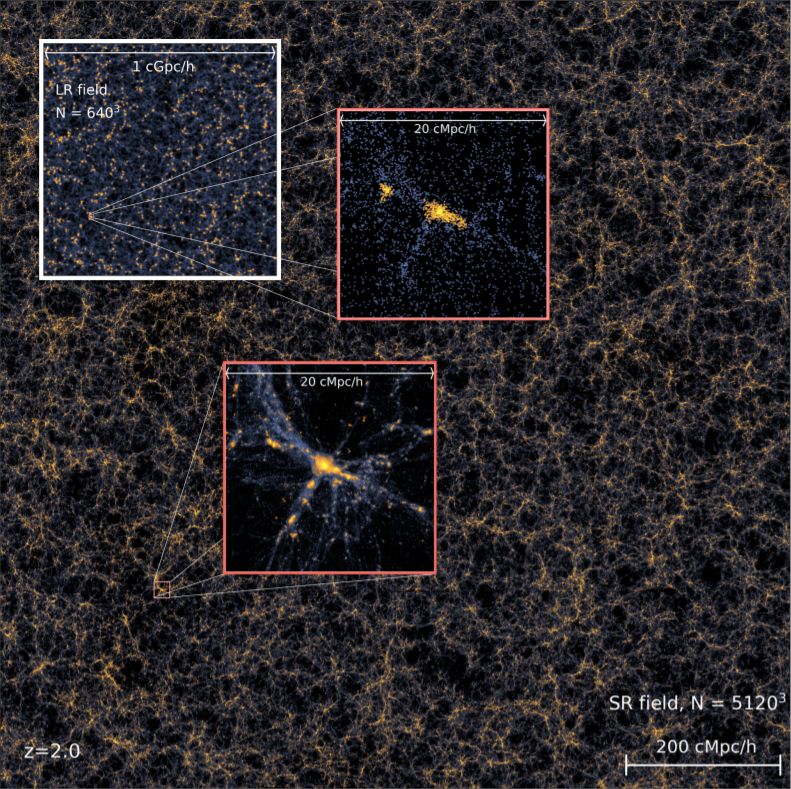

Проблема заключается в том, что любое моделирование ограничено конечными вычислительными ресурсами — исследователям приходится находить компромисс между степенью разрешения (количеством частиц) в модели и размерами пространства (box), в котором будет совершаться моделирование. Для ее решения профессорами университета Карнеги-Меллона, института Флэтайрон и Калифорнийского университета была создана программа, которая в связке с нейронными сетями и применением технологии Deep Learning на базе моделей низкого разрешения (LR) путем предсказания того, как гравитация влияет на частицы с течением времени, создает модели сверхвысокого разрешения (SR). Обучается она этому по уже имеющимся моделям высокого разрешения (HR). В результате создается SR-модель с количеством частиц, в 512 раз превышающим количество частиц в LR-версии модели, предсказывая их смещение от начальных позиций. Кроме того, процесс генерации является стохастическим, что позволяет исследовать мелкомасштабные моделирования.

Любой вопрос или замечания Вы можете написать в комментариях. Также я открыт для личного диалога в телеграме или даже беседы в нашем чате. А еще у меня есть телеграм-канал о космологии.

Подход команды исследователей использует DL-класс алгоритмов машинного обучения с участием нейронных сетей, что позволило предсказывать свойства галактик намного быстрее, чем в существующих моделях. В качестве условия для модели вводятся необходимые физические описания поведения частицы в гравитационном поле, а также смещение частиц в моделировании задачи N-тел. Для создания модели с высоким разрешением используется специфический подход, называемый генеративно-состязательной сетью, которая противопоставляет две нейросети друг другу. Одна сеть является LR-моделью, другая сеть — будущая SR-модель, пытается отличить эти модели от моделей, сделанных обычными методами. Со временем обе нейросети улучшаются до тех пор, пока не создадутся процедуры быстрого моделирования, которые будут создавать такую же модель, как модель сверхвысокого разрешения, созданная традиционными медленными методами. В качестве параметров сравнения нейросети используют спектр мощности плотности материи и функцию массы гало галактик.

Обученная система, как упоминалось ранее, создает Super-Resolution-модель с количеством частиц, превышающим в 512 раз количество частиц Low-Resolution-модели. Для области 500 млн световых лет это около 134 миллионов частиц, которые теперь моделируются за 36 минут вместо обычных 560 часов. А за 16 часов новый алгоритм сможет смоделировать поведение пространства со стороной 50 млрд световых лет и количеством частиц, достигающим 13,4 млрд. Несмотря на то, что нейросети обучались улучшению разрешения модели по небольшим участкам пространства, они отлично справились с моделированием крупномасштабной структуры — полученные данные хорошо сочетаются с наблюдениями и прошлыми моделированиями. Под вопросом остаются мелкомасштабные явления, такие как звездообразование, сверхновые звезд и эффекты черных дыр. Данный алгоритм пока заточен лишь под гравитационное взаимодействие материи, но, как говорит команда исследователей, она уже работает над созданием алгоритма для моделирования других процессов, происходящих во Вселенной.

Исследования проводились на суперкомпьютере Frontera в Техасском вычислительном центре (TACC) – самом быстром академическом суперкомпьютере в мире. Финансирование проводилось Институтом искусственного интеллекта и НАСА. Препринт работы от 3 мая доступен на arXiv.org по ссылке. Подробнее о моделировании физических процессов в межгалактических масштабах написано здесь и здесь.