Комментарии 18

Тема предвзятости не раскрыта. На всех картинках только белые. Чем они отличаются от чёрных непонятно.

+13

Нужно смотреть оригиналы в твиттере, картинки там интереснее:

pbs.twimg.com/media/EiT2SftUMAEjDRH?format=jpg&name=4096x4096

pbs.twimg.com/media/EiT2SftUMAEjDRH?format=jpg&name=4096x4096

+1

Я ни разу не эксперт, но, для чистоты эксперимента, нег Обаму надо было размещать сверху

-2

Так откройте сам твитт. Две длинных картинки — на одной Обама снизу, на второй — сверху. В обоих случаях Твиттер обрезает картинки так, что на превью виден белый человек. Причем, это спровоцировало целую волну «экспериментов» с разными параметрами, одеждой и контрастностью, и почти всегда показывают белого. Упс!

+2

Вон оно что!

Так и надо было в статью вставить эти длинные картинки и показать результат. В статье вообще ни слова про длинные картинки с двумя людьми и их обрезку до одного человека.

Так и надо было в статью вставить эти длинные картинки и показать результат. В статье вообще ни слова про длинные картинки с двумя людьми и их обрезку до одного человека.

+21

Я вот, честно говоря, тоже из статьи мало, что понял.

Только комментарии добавили ясности.

+14

Тут согласен, пока не открыл картинки в самих Твитах, то допереть не мог что тут не так — две одинаковые картинки с обоих сторон, лол. А теперь действительно возник вопрос к странности работы алгоритма. Интересно, по какому принципу вообще обрезка изображения производится?

+1

На самом деле не «Упс!», а все как обычно. Если долго ходить по всему этому хештегу и ретвитам можно заметить, что есть твиты, где делаются нормальные эксперименты: с большим количество данных, либо с самим изображением (размытость\четкость, яркость, цветовая гамма, масштаб), по которым можно сделать два вывода:

1) Очень легко манипулировать результатом. Можно достаточно просто делать расистские результаты перебирая фото или фильтруя изображения. (На тестовом аккаунте например)

2) На большой выборке соотношение ближе к 50 на 50

Но, естественно, из таких твитов хорошую новость не сделать, поэтому их нигде не тиражируют.

1) Очень легко манипулировать результатом. Можно достаточно просто делать расистские результаты перебирая фото или фильтруя изображения. (На тестовом аккаунте например)

2) На большой выборке соотношение ближе к 50 на 50

Но, естественно, из таких твитов хорошую новость не сделать, поэтому их нигде не тиражируют.

+3

Там далеко не всегда так, люди проводили эксперименты, и были фотографии, где наоборот показывались чёрные всегда.

Алгоритм не расистский, он просто кривой

Алгоритм не расистский, он просто кривой

0

Правильный алгоритм должен всегда выбирать случайное лицо, независимо от пола, расы (хотя тут будет правильнее использовать текущие принятые affirmative actions), возраста, контрастности, резкости, размера. Мало-ли что там снимающий хотел, может он расист. Алгоритм не должен поощрять расизм ни в каком виде.

+2

Как я понял, то загружались длинные изображения(высокие). А постольку поскольку твиттер не может их отображать целиком, выбирается наиболее «релевантная» часть изображения для отображения.

0

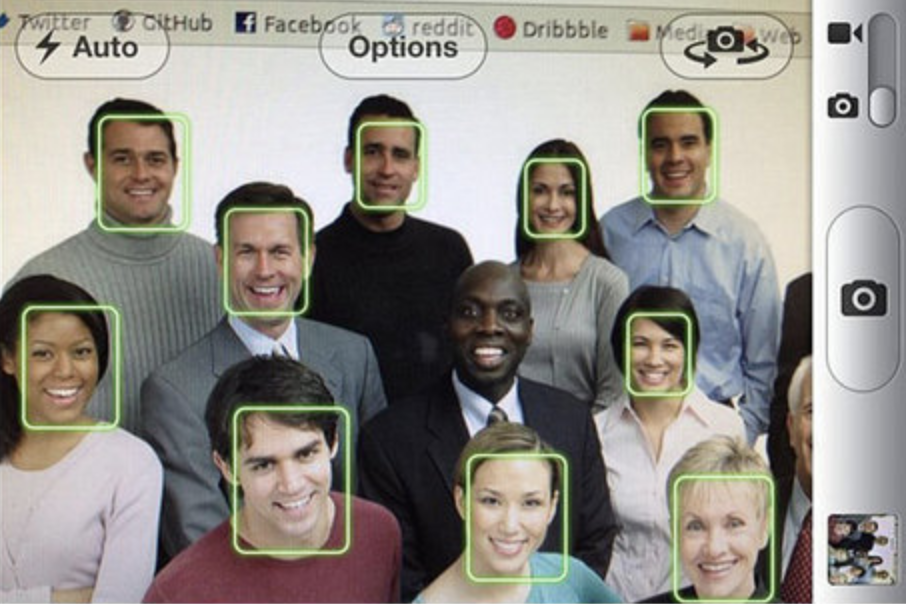

Думал, в примерах будет что-то подобное

+15

На месте Твиттера можно немного потроллить SJW — дать пользователю выбор при обрезке изображения — на ком акцентировать, а через некоторое время опубликовать статью — кого чаще выбирают пользователи ;)

+17

НЛО прилетело и опубликовало эту надпись здесь

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Другие новости

Изменить настройки темы

Twitter исправит алгоритм автоматической обрезки изображений после жалоб на его расовую предвзятость