NetApp AutoSupport On Demand (ранее этот функционал был в виде Remote Support Agent или RSA) — это агент в системах ONTAP, позволяющий в случае обращения к техподдержке, ей самой запускать команды на вашей СХД. Устроено это так: AOD конектиться к облаку NetApp и запрашивает команды на выполнение от техподдержки — всё секьюрно, дыр в файерволе открывать не нужно, соединение всегда происходит только от СХД на сайт support.netapp.com, а не наоборот.

Команды которые запрашивает техподдержка не могут что-то менять на СХД, а только просматривать состояние вольюмов, лунов, контроллеров и т.д. Естественно содержимое вольюмов и лунов не может быть скопировано в облако NetApp. В облако NetApp отправляются только логи системы.

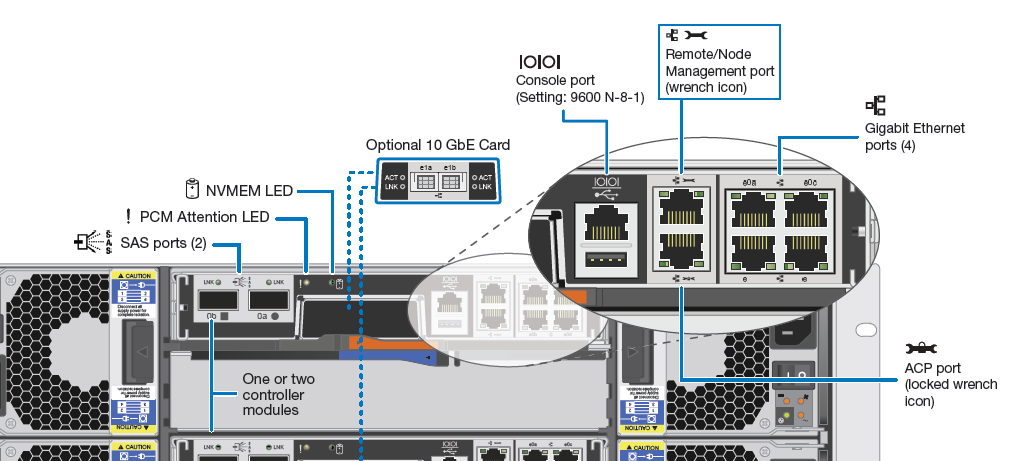

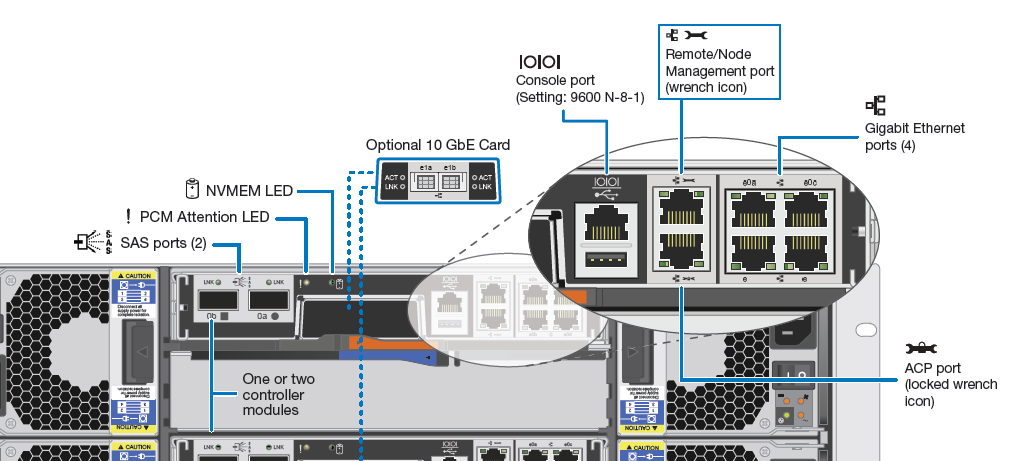

Каждый контроллер NetApp FAS имеет на борту менеджмент-порт с изображением ключика, который так и называется Wrench port. Не путать с ACP (ключик + замочек).

Команды которые запрашивает техподдержка не могут что-то менять на СХД, а только просматривать состояние вольюмов, лунов, контроллеров и т.д. Естественно содержимое вольюмов и лунов не может быть скопировано в облако NetApp. В облако NetApp отправляются только логи системы.

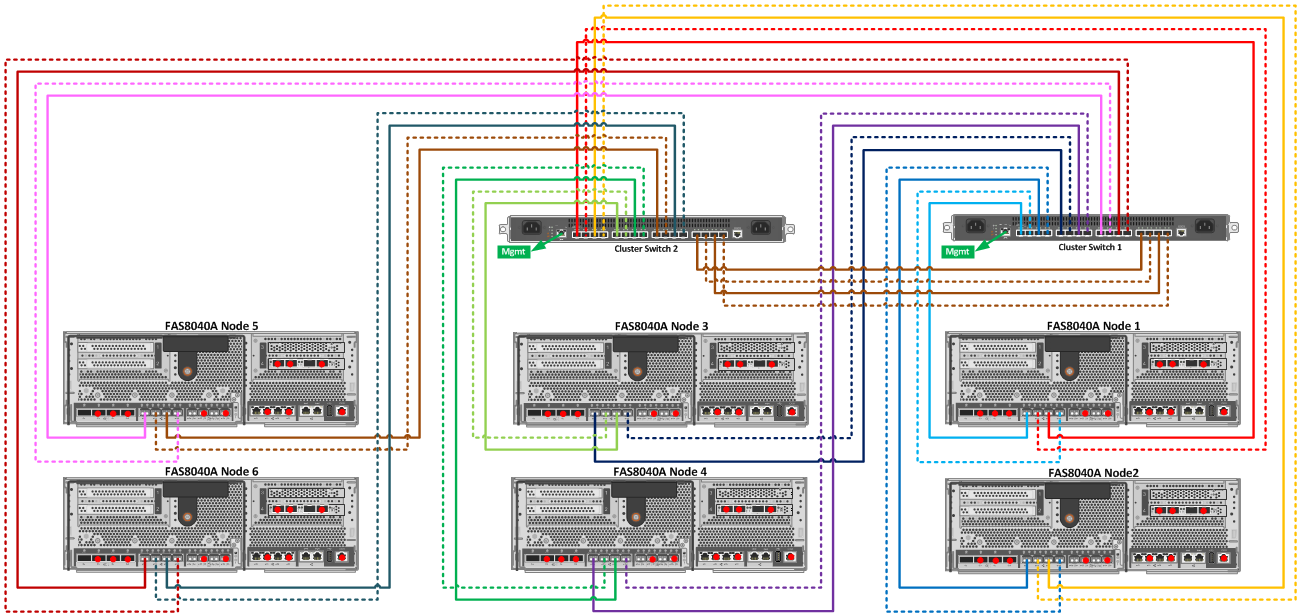

Внутреннее устройство Management подключения в FAS платформах

Каждый контроллер NetApp FAS имеет на борту менеджмент-порт с изображением ключика, который так и называется Wrench port. Не путать с ACP (ключик + замочек).