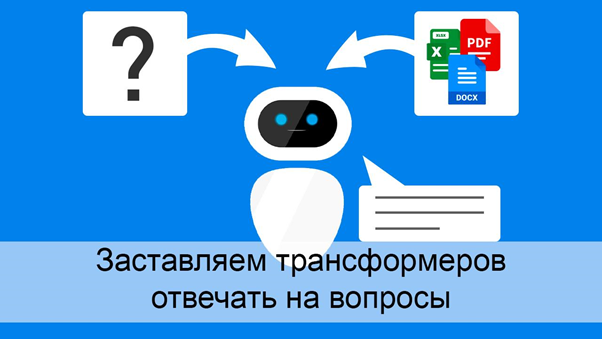

Объяснение GPT 3.5 и 4.0, почему женщины лучше мужчин, в марте и июне 2023 года, источник

В относительно короткой истории программного обеспечения немало примеров, когда разработчикам удавалось настолько ухудшить продукты, что теми переставали пользоваться. Например, Windows ME (2000) или RealPlayer. Возможно, сейчас на эти старые «грабли» наступила и компания OpenAi. В результате последних обновлений ChatGPT-4 стал работать объективно хуже, что подтверждается не только жалобами на Reddit, но и результатами научного исследования специалистов из Стэнфордского университета в Беркли. Одновременно с этим вышли новые версии альтернативных LLM, такие как FreeWilli2 (первая нейросеть, которая побила GPT 3.5 в отдельных бенчмарках) на базе LLaMA 2. О разработке аналогичной модели объявила Apple и другие компании.

Проблему отупения ChatGPT можно обойти, если переключиться на более ранние версии этой модели. Но не факт, что это поможет самой компании OpenAI, ведь в июне 2023 года количество пользователей ChatGPT уже снизилось (впервые с момента выпуска этого продукта).