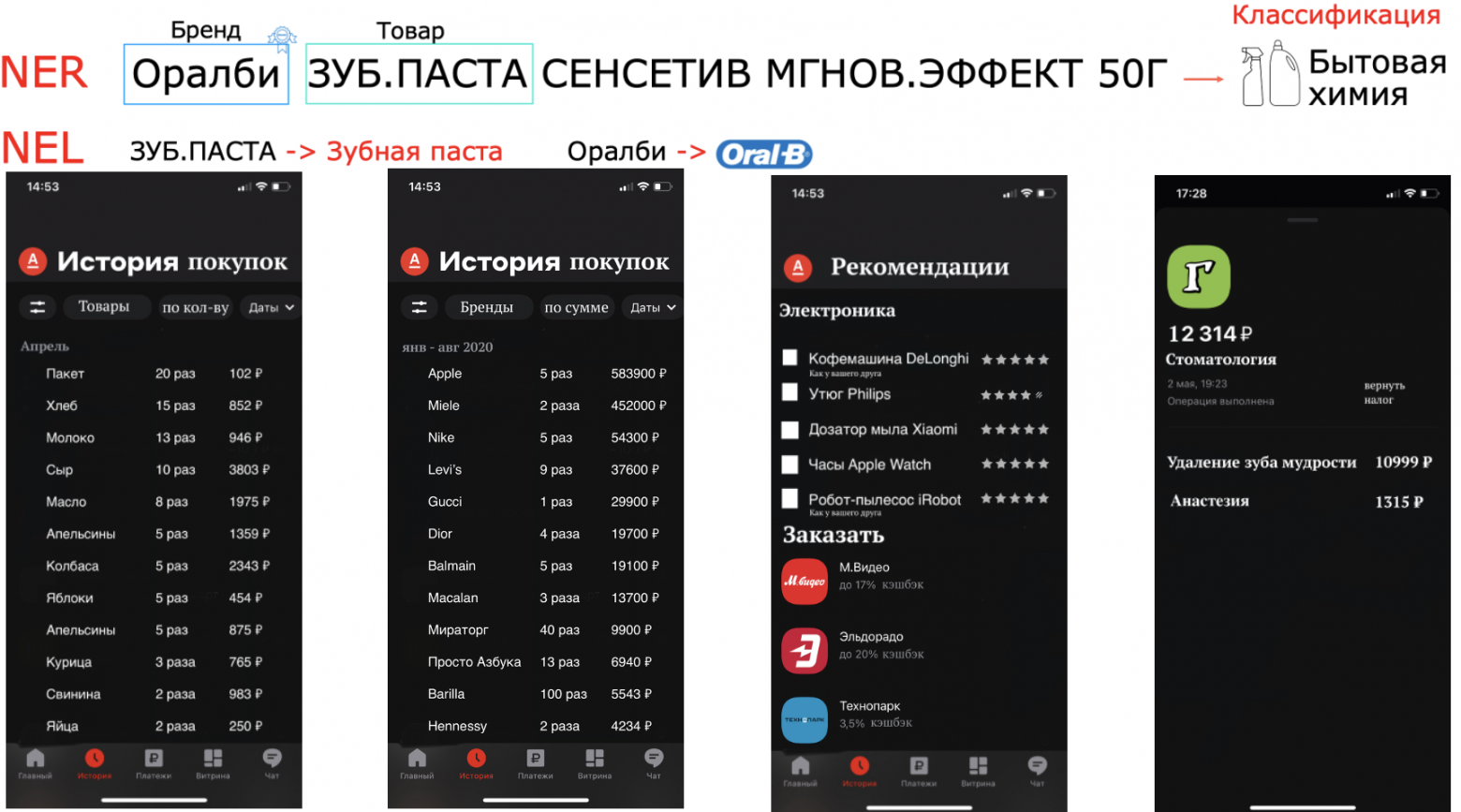

Подавляющее большинство инструментов глубокого обучения позволяет нам быстро создавать новые приложения с потрясающей производительностью, от программ компьютерного зрения, классифицирующих сложные объекты по фотографиям, до анализаторов естественного языка при помощи извлечения семантики из текстов. Однако самым серьёзным узким местом всех этих методик является огромное количество данных, необходимое для обучения моделей — обычно сотни тысяч примеров для обучения.

Если вы приступаете к созданию с нуля классификатора изображений, допустим, для распознавания несвежих продуктов на конвейерной ленте, для сбора и ручной разметки всех этих фотографий вам понадобятся недели или месяцы. К счастью, существует множество глубоких нейронных сетей, уже обученных на больших массивах данных фотографий с большим количеством классов. Они позволяют устранить проблему «холодного запуска». Идея, лежащая в основе

трансферного обучения заключается в использовании результатов работы этих моделей, фиксирующих высокоуровневую семантику изображений, в качестве входящих данных для новых классификаторов, решающих требуемую задачу. Это значительно уменьшает объём данных, которые нужно аннотировать вручную — с сотен тысяч до тысяч.

Однако аннотирование даже тысяч примеров может быть затратной задачей, особенно если для выполнения задачи по аннотированию требуется навыки специалиста в соответствующей области. В идеале достаточно было бы разметить только несколько сотен задач и позволить конвейеру машинного обучения самообучаться без контроля. Эта задача также называется

бюджетированное обучение (budgeted learning): мы выделяем сумму денег на приобретение набора данных обучения для создания модели с нужной производительностью. Ещё одна проблема связана с дрейфом концепции, при котором целевая задача со временем меняется (на линию распознавателя поступают новые продукты) и показатели прогнозирования без вмешательства человека деградируют.