Комментарии 38

Как у вас реализовано хранение (тройная репликация, в частности), очень интересно.

С охлаждением там проблемы понятные…

Во-первых, поток воздуха практически полностью перегорожен дисками и бэкплэйном. На корпусе есть "воздухозаборники" сверху, но их явно мало и воздух туда идет больше уже нагретый из "горячей" зоны стойки.

Во-вторых, зачем-то сдвинуты назад вертикальные направляющие в стойке… Даже на фото видна большая щель сбоку. Эта щель ни на что не влияет, пока в стойке 2-3 кВт тепловыделения. Когда в стойке больше 4 кВт тепловыделения — уже начинается рециркуляция горячего воздуха и оборудование начинает греться лишнего… Так что, начинать надо не с дополнительного охлаждения, а с устранения лишних щелей и юнитов без заглушек. (Как правило, просто устранения щелей хватает без дополнительных мер до 7-10 кВт на стойку. Дальше, если хватает мощности кондиционеров, изолировать горячий коридор… или холодный, если воздух раздается из под фальшпола. Что важно — это почти бесплатно по сравнению со всякими охлаждающими дверями, "активными фальшполами" и т.п.)

Если вас интересует выхлоп какой-либо другой утилиты, мы можем в будущем провести такие тесты.

Чё то я не понял. Какой рейд контроллер используется в проблемных серверах? Поддерживает ли он HBA? Кроме того, у Vmware уже давно в моде гиперконвергентные решения. Это проще, плюс легко горизонтально масштабируется.

Раньше супермикро плотно сидел на адаптеке, и нужно было подобрать прошивку контроллера и драйвер vmware, и все отлично работало годами. Но если не заморачиваться, то да. Были проблемы.

Развертывать кучу сервисов вредит правилу «один сервер, один сервис».

В эпоху kubernetes странное какое-то правило. Один сервер может и должен держать тучу сервисов и виртуалок.

Даже сталкивался с тем что существуют сервисы, которым необходимо быть установленными только под железо, а при их виртуализации поддержка отказывается на обработку, говоря «да это у вас виртуализация небось криво настроена».

Ладно, не буду о грустном

Если бизнес расписал бизнес-план, выделил бюджет, вложился в самое современное на момент вложений железо, и весьма дорогое на тот момент, то просто так, через год, только из-за выхода более новой версии процессора или СХД, не будет пускать всё под снос и закупать и настраивать новое железо. И ленты для архивного хранения не так уж дорого стоят, если ими пользоваться с умом. И запрет на запуск чего-то в виртуализации не просто так, а обусловлен или лицензионными требованиями (читай: хотим бабла), или чтоб своей же техподдержке упростить работу: одно дело когда у Вас не грузится физический сервер и всем более-менее понятно куда копать, другое дело когда в виртуалке что-то валится, держать высококвалифицированных (читай: дорогих) спецов в первой линии техподдержки никто не будет.

Ну и есть случаи, когда необходимо соблюдать требования безопасности и не то, что у кого-то там, в чужом облаке, не захостишь, а еще и в датацентре комната со своми серверами дополнительно ограждается сетками и сигнализациями, чтоб мышь не проскочила!

В качестве Bare Metal такой конфиг тоже интересен, для чего-то дико нагруженного и что не стоит выносить на CIDA ядра — можно соблюсти правило 1 сервер — 1 приложение.

Мне очень сильно интересно, сколько шасси на 4 ноды потребляет электричества при полной забивке.

Даже при нагрузке процессоров 30% на ноде, температура подбиралась к отметке 95 градусов

и сразу же

В результате, сервер более чем оправдал наши ожидания, процессор AMD EPYC 7742 кажется нам неубиваемым в нагрузке. Схема, построенная на подобных решениях, будет дальше

масштабироваться, со временем планируем запустить эту услугу в Нидерландах.

Это как??? Вы серьезно хотите строить решение на базе железа, которое может работать только со снятой крышкой, а при норм нагрузке при, например, трейне нейросети на всех ядрах, или, например, тяжелых отчетах на колоночной СУБД, вообще расплавится? После первой цитаты ожидал что-то вроде «теперь мы всем офисом думаем кому бы это впарить»

На эту тему слушал спич человека из Амазона. Он показывал их железо, спрректированное под заказ для aws. И прямо сказал, мол, мы имеем плотность 2 проца на 1 юнит, и у нас в сервере гуляет куча места, и в масс маркете вы запросто найдёте железо с 3-5 раз большей вычислительной плотностью.

Но нам несложно построить дата центр на больше квадратных метров. Зато мы получаем серьёзную экономию на затратах на охлаждении, и энергоэффективность, которую не получишь на публично доступном железе.

Системный диск: 1x INTEL SSDSC2KB240G8

Ну почему, почему везде вендоры экономят на спичках и закладывают под систему (а то и в самом железе) одиночный носитель вместо пары под зеркало? Да, я понимаю что износ системного диска минимальный; да, я понимаю что тут кластер. Но, блин, такое везде.

Особенную боль вызывают материнки для встраиваемых и промышленных решений с поголовным наличием только одного m.2 разъёма/одним слотом для карты памяти/одним sata dom.

За время гарантии мы успели в примерно таком поменять 4 контроллера и 3 ноды. Хотя может конечно именно нам просто не повезло.

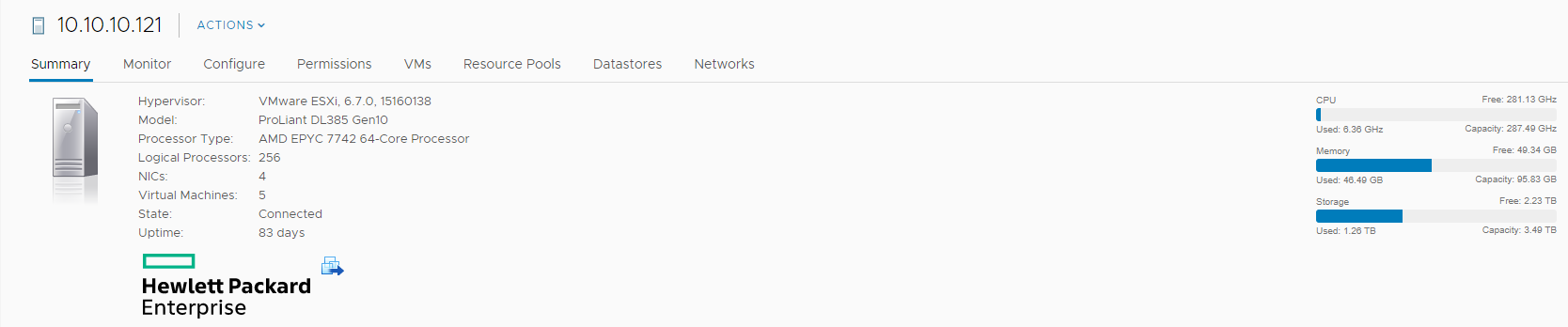

Самый мощный сервер Supermicro в Москве на основе AMD Epyc