Голос — это будущее. Мировые технологические гиганты требуют жизненно важной доли рынка, а ComScore прогнозирует, что «до 50% всех поисковых запросов будут выполняться голосом уже к 2020 году».

Однако исторические антецеденты, которые привели нас к этому моменту, столь же важны, как и удивительны. В этом отчете мы отправляемся в путешествие по истории технологии распознавания речи, прежде чем предоставлять всеобъемлющий обзор текущего ландшафта, и даём советы, которые должны учитывать все маркетологи, чтобы подготовиться к будущему.

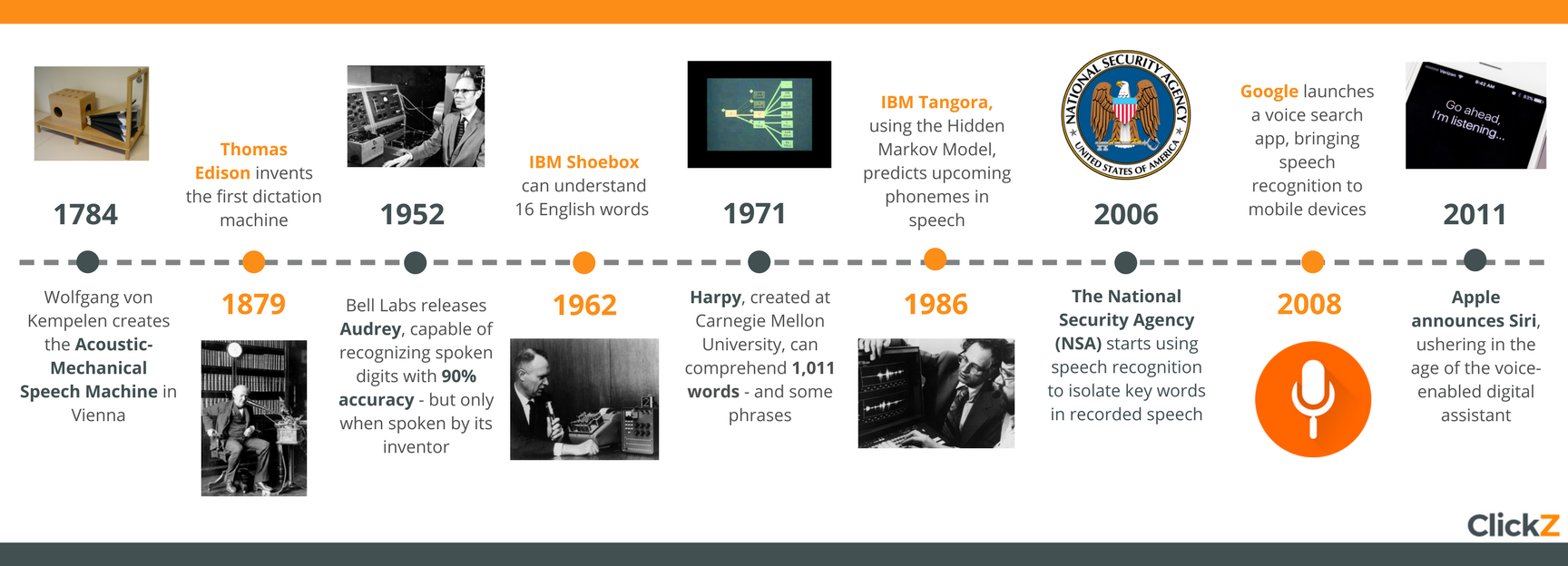

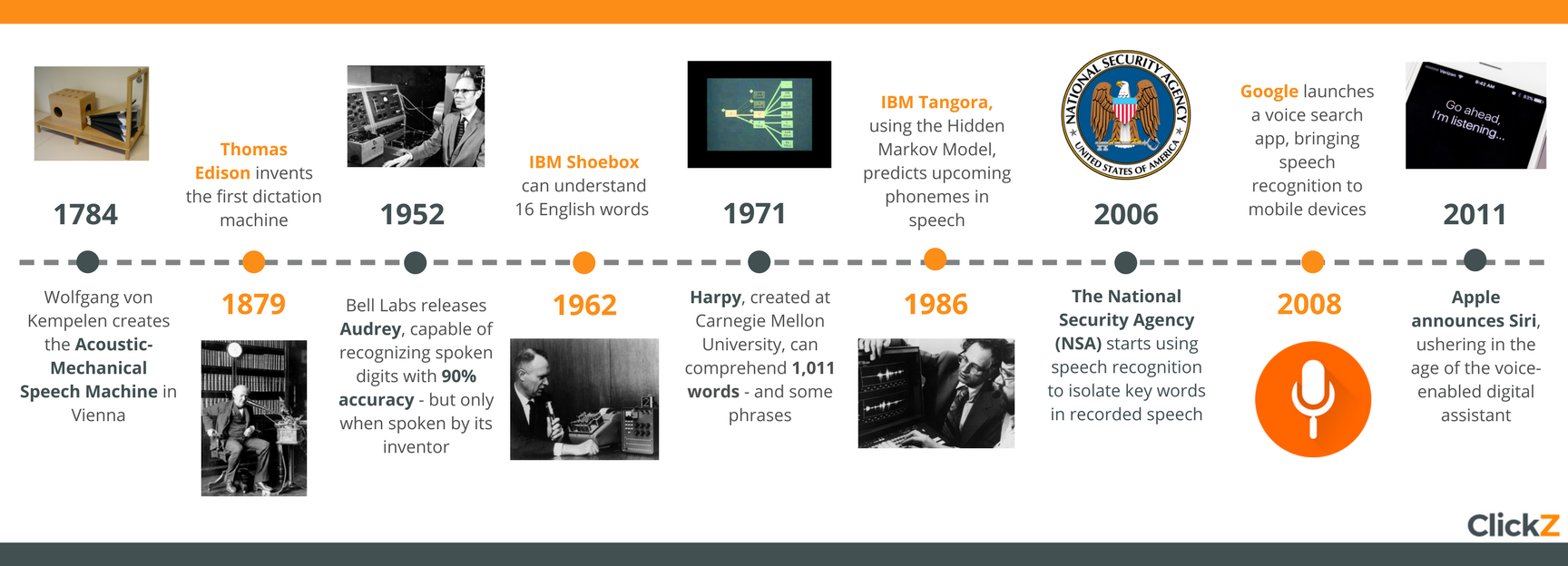

История технологии распознавания речи

Технология распознавания речи вошла в общественное сознание сравнительно недавно, с блестящими событиями запуска от высокотехнологичных гигантов ведущих мировых трендов.

Наше восхищение является инстинктивным: мы очарованы машинами, которые могут понять нас.

С антропологической точки зрения, мы разработали произносимое слово задолго до его письменного аналога, и мы можем говорить по 150 слов в минуту, по сравнению с ничтожными 40 словами, которые среднестатистический человек может написать за 60 секунд.

Фактически, общение с технологическими устройствами с помощью голоса стало настолько популярным и естественным, что мы оправдано задаемся вопросом, почему самые богатые компании в мире только сейчас начали предоставлять нам эти услуги.

История технологии показывает, что распознавание речи далеко не новая озабоченность, даже если темпы развития не всегда соответствовали уровню интереса к этой теме. Как мы видим впоследствии, крупные прорывы, относящиеся к XVIII веку, обеспечили платформу для цифровых помощников, о которых мы все сегодня знаем.

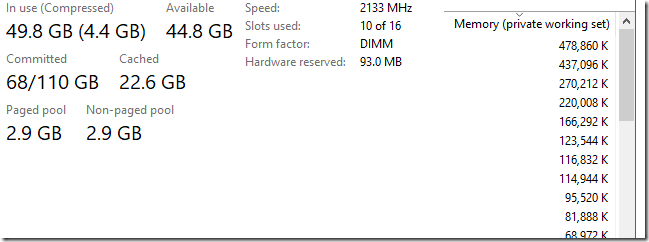

Иногда бывает нужно перечислить все процессы или потоки, которые в данный момент работают в ОС Windows. Это может понадобиться по разным причинам. Возможно, мы пишем системную утилиту вроде

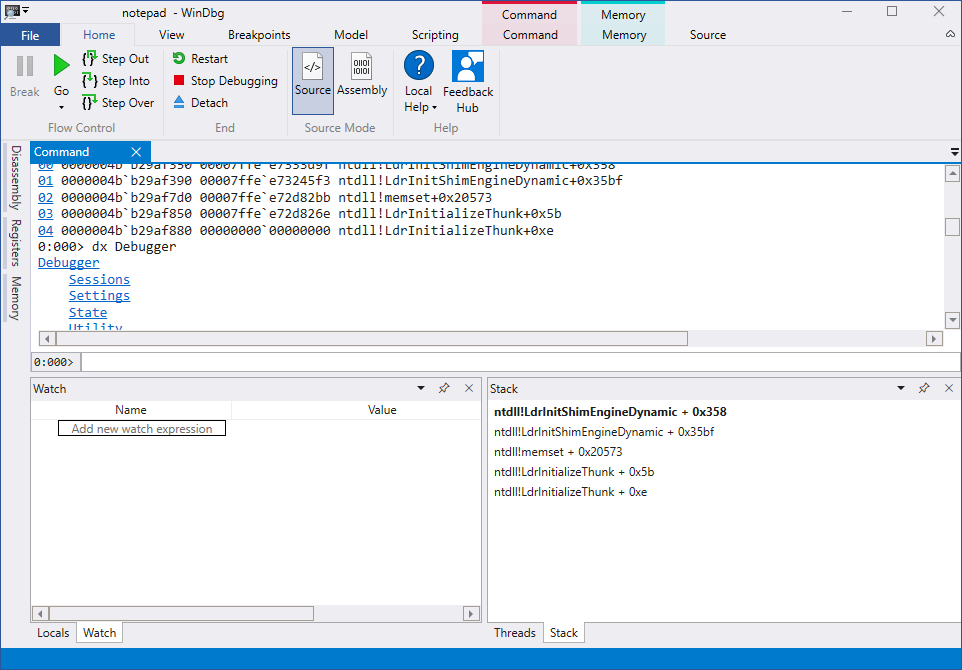

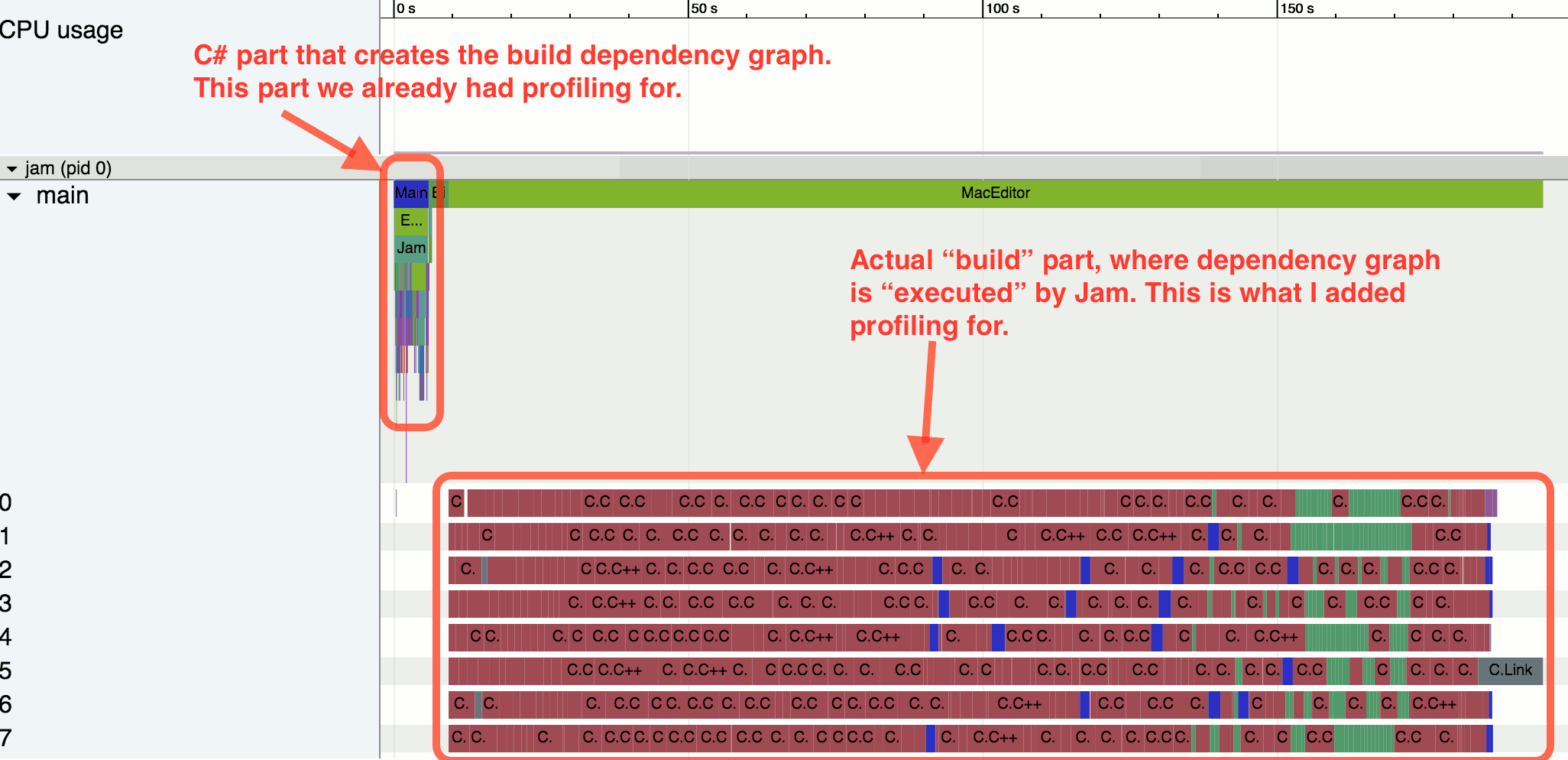

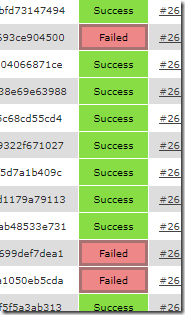

Иногда бывает нужно перечислить все процессы или потоки, которые в данный момент работают в ОС Windows. Это может понадобиться по разным причинам. Возможно, мы пишем системную утилиту вроде  Гейзенбаг — это худшее, что может произойти. В описанном ниже исследовании, которое растянулось на 20 месяцев, мы уже дошли до того, что начали искать аппаратные проблемы, ошибки в компиляторах, линкерах и делать другие вещи, которые стоит делать в самую последнюю очередь. Обычно переводить стрелки подобным образом не нужно (баг скорее всего у вас в коде), но в данном случае нам наоборот — не хватило глобальности виденья проблемы. Да, мы действительно нашли баг в линкере, но кроме него мы ещё нашли и баг в ядре Windows.

Гейзенбаг — это худшее, что может произойти. В описанном ниже исследовании, которое растянулось на 20 месяцев, мы уже дошли до того, что начали искать аппаратные проблемы, ошибки в компиляторах, линкерах и делать другие вещи, которые стоит делать в самую последнюю очередь. Обычно переводить стрелки подобным образом не нужно (баг скорее всего у вас в коде), но в данном случае нам наоборот — не хватило глобальности виденья проблемы. Да, мы действительно нашли баг в линкере, но кроме него мы ещё нашли и баг в ядре Windows.