Комментарии 296

Современный процессор Intel выполняет до 180 инструкций одновременно (в отличие от

последовательной абстрактной машины C

А точно эта и куча перечисленных сложностей из-за С?

Мне всегда казалось, что из-за обратной совместимости "ассемблера" (если мы уж говорим о языках программирования). Иными словами уже написанные и скомпилированные программы

нужно с каждой ревизией процессора выполнять все быстрее и быстрее. А никак не для того,

чтобы облегчить разработчикам С компилятора жизнь.

Ассемблер в x86 — это тоже высокоуровневый язык. Автор оригинальной статьи нацеливается на C (один из двух-трех языков, которые дожили от 70х до наших времен, и наверняка самый из них популярный), но большинство аргументов применимы ко всем языкам подобной идеологии, включая даже ассемблер и машинный код. В современном x86 процессоре есть встроенный оптимизирующий компилятор, который преобразует "высокоуровневый" ассемблер во внутренний низкоуровневый — включая SSA (переименование регистров) и параллелизацию. Посыл статьи (если отбросить C-специфичные вещи про выравнивание, неопределенные биты и тд) в том и был, что C (и все другие похожие языки) был простым языком, который напрямую ложился на реальное железо, а теперь инженеры пытаются всячески вбить новое железо (которое имеет принципиально другие допущения!) в видение мира старого языка (а разработчики компиляторов в то же время пытаются как-то приспособиться к новому железу, которое пытается выглядеть старым). Строго та же фигня происходит и с, к примеру, архитектурой ОС — до сих пор программы притворяются, что весь компьютер принадлежит им, а ОС всячески им в этом потворствует ценой приличных накладных расходов. Обратная совместимость — главное зло мира...

Правильно, нечего их делить, но делят же. Тут вот ниже про микроконтроллеры упомянули правильно — они примерно соответствуют тем машинам, для которых разрабатывался C. В прицеле на них C будет низкоуровневым, а Java — не очень. В прицеле x86/ARM/POWER — какой-то большой разницы между С и Java уже нет.

Про фортран -он такой же, как и C, просто автор еще и выискивает в C любые вещи, которые мешают компилятору делать переход 1-1 из исходного кода в машинный (как то выравнивание и алиасинг). Эрланг же был упомянут как пример принципиально другой идеологии (многопоточного) программирования, которая может казаться странной и сложной для приверженца С-подобных языков и POSIX-подобной share-everything многозадачности, но современное железо может оказаться больше заточенным под модель эрланга, чем под модель C.

Большая часть этой статьи — это вопль в пустоту о том, что если делать все с нуля — включая парадигму программирования, которая учитывает текущие реалии в железе — то можно сделать процессор значительно проще, дешевле, холоднее и быстрее тех, что есть сейчас. Но такой процессор не сделают, потому что программы на C на нем будут работать медленно.

Еще и мир устроен лентяями — стоит попробовать спросить J-скриптера, во сколько тактов развернется его лямбда?

Как раз об этом думал по время прочтения статьи. Какой-нибудь .map() по массиву в JS теоретически может быть быстрее обычного цикла с вызовом функции, так как, все эти лямбды могут выполняться параллельно над всеми элементами массива сразу.

Иначе язык отдает это на откуп компилятору, который ...., дом который построил Джек

Только не в JS. В этом языке функция map явно однопоточна: стандарт предписывает вызывать переданную функцию строго последовательно...

Кстати сегодня он мне сэкономил тучу времени. Получать культуру в цикле было плохой идеей.

var ci = (CultureInfo)CultureInfo.CurrentCulture.Clone();

Потому что если я правильно понимаю, сейчас ФП сильно проигрывает в производительности, а с учетом оптимизаций процессора для С – даже в задачах, которые легко распараллелить.

задач, где имеет смысл использование shared памяти на gpu не так уж многоРасскажите, пожалуйста, по-подробнее с этого места. Какого типа операции или задачи над данными на GPU не имеет смысла выполнять с использованием shared memory? И какие имеет смысл?

Классическим примером, где нужно использование shared, является перемножение матриц, там это дает большое ускорение, но это весьма специфический пример.

В своих задачах я использую shared memory в основном при всякой редукции, тут она нужна чисто для обмена данными между потоками в блоке. Но для этого в той же CUDA есть и другие механизмы, можно обойтись и без нее.

Еще shared memory нужна, когда каждому потоку нужен какой то локальный буфер для своих вычислений. Но здесь размер буфера получается весьма ограничен, да и честно сказать это не очень эффективно. Если в задаче требуется буфер, то обычно ее достаточно сложно реализовать на gpu.

Больше что-то ничего не приходит в голову, для чего может shared memory понадобиться. Скорее в остальном это специфические задачи.

>> Скорее в остальном это специфические задачи.

Да.

Обратная совместимость — продукт нежелания миллионов программистов переписывать миллиарды строк кода(знаменитое Java-вское «написано однажды — работает всегда»). Каждому из нас не хочется этого делать… Но проблема тут не в программисте, а в языке, на котором написан код.

Язык С, как и все его компилируемые наследники(C++, Java, ..., но не Python, хотя там свои проблемы) в нынешние дни имеют ряд коренных недостатков, которые были не видны людям из далеких 70-x. Например, в С/C++ нельзя просто взять и написать ассемблерные вставки или функции. Это просто отсутствует в стандарте. И что прикажете с этим делать? А ведь даже такая малая стандартизируемая возможность в корне может ускорить выполнение кода…

Обратную совместимость я бы лучше заменил банальным словом «лень»А когда этим заниматься миллионам программистов, если им надо работать по 8+ часов в день, что бы семью кормить?

Но проблема тут не в программисте, а в языкеНет, проблема в суровой реальности — людишкам, которые не бум-бум в компуктерах, нужны новые интернет-магазинчики, а не стоп-кадр на 10 лет, что бы переделать все по-нормальному.

Например, в С/C++ нельзя просто взять и написать ассемблерные вставки или функции.Можно практически во всех популярных реализациях.

А ведь даже такая малая стандартизируемая возможность в корне может ускорить выполнение кода…В 0.001% случаев, потому что компиляторы уже давно умнее нас.

deleted

Нет, проблема в суровой реальности — людишкам, которые не бум-бум в компуктерах, нужны новые интернет-магазинчики, а не стоп-кадр на 10 лет, что бы переделать все по-нормальному.

Ну, может и без стоп-кадра возможно… Например, начать с серверов… Сделать ЯП мимо C, под современный проц, и переписать на нём BEAM (виртуальную машину Erlang). Кто бы это только профинансировал?..

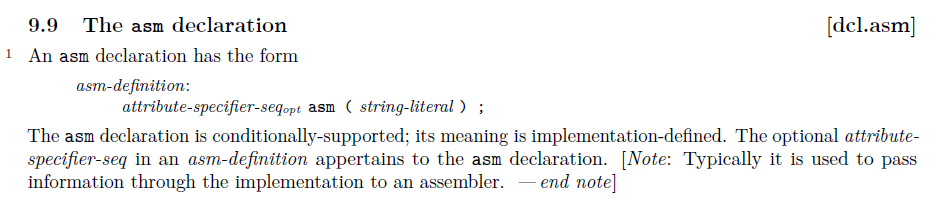

Например, в С/C++ нельзя просто взять и написать ассемблерные вставки или функции. Это просто отсутствует в стандарте.Стандарт описывает и разрешает ассемблерные вставки. Единственное что он не описывает, так это синтаксис внутри самой вставки.

Обратная совместимость — продукт нежелания миллионов программистов переписывать миллиарды строк кода(знаменитое Java-вское «написано однажды — работает всегда»).

Да не, у программистов никакого нежелания нет. платите деньги — и вам все перепишут.

до сих пор программы притворяются, что весь компьютер принадлежит им, а ОС всячески им в этом потворствует ценой приличных накладных расходов

А как надо?

Видимо, автор имеет в виду вытесняющую многозадачность, при которой программы ничего не знают о параллельно выполняющихся других программах, а переключением между потоками управляет ОС, насильно останавливая выполняющийся поток и передавая управление следующему. На такое переключение расходуются ресурсы, которые можно было бы сэкономить, но зато зависшая программа не подвешивает весь компьютер.

Я имел в виду и саму вытесняющую многозадачность с внезапным прерыванием выполнения и сбросом контекста выполнения куда-то в память, и раздельные адресные пространства для приложений, которые влекут за собой еще большие накладные расходы на переключение, и переходы в ядро и обратно, и прочие "особенности" привычных нам ОС.

Как надо? Не знаю, я сам заядлый C++ программист ) Но подозреваю, что куда-то в сторону managed языков и кооперативного шедулинга мелких задач/вытесняющей многозадачности, но не в любой точке кода, а в определенных точках останова (VM может гарантировать, что одна программа не перетрет другую и не захапает себе все время)

Встречное предложение — оцените ресурсы, потраченные на борьбу с имеющимися ОС. Сколько человеко-лет ушло на написание TBB и всех ему подобных диспетчеров (включая что-то похожее в каждом первом игровом движке), которые суть подменяют встроенный в ОС диспетчер потоков на свой диспетчер задач — потому что встроенный механизм переключения потоков слишком накладный? Сколько ушло на разработку lockless структур — потому что локи/спинлоки использовать нельзя, потому что а вдруг вытеснят в критической секции?

Неважно сколько человеко-лет ушло на написание того, что вы перечислили. Важно, что априори оно много меньше того, сколько человеко-лет понадобится на реализацию ваших предложений.

Когда действительно большому количеству пользователей (в данном случае программистов) что-то становится действительно необходимым, то появляется библиотека, фреймворк и т.п. Этот ваш intra-app «диспетчер задач» по сути реализация user-level threads, давно известной концепции. Раз нет одной или нескольких популярных реализаций такой концепции, следовательно это проблемы явного меньшинства, которое и вынуждено строить свои велосипеды. А менять ВСЁ ради решения проблем меньшинства как-то нерационально.

Реальный пример — наивная реализация flow based programming, где каждая нода — это поток, обмен друг с другом сообщениями через очереди. Делаем несколько тысяч нод-потоков, запускаем на большой машине с кучей ядер, набрасываем миллионы сообщений в секунду и получаем >50% накладных расходов чисто на переключение потоков.

Про явное меньшинство — TBB, Cilk, часть OpenMP, Microsoft's PPL/Concurrency, встроенный в OS X GCD, встроенный в Go goroutines, встроенные в Erlang процессы, TAP в .NET, десятки самописных для разных приложений и библиотек. Как только мы переходим от use case "несколько долгоживущих независимых потоков, которые долго-долго долбят числа или висят в I/O" — т.е. однопоточной программы x N, к параллельному решению относительно маленьких задач, как абстракция "бесконечного количества потоков" становится нежизнеспособной. Все эти "библиотеки и фреймворки" позволяют обойти накладные расходы от ОС путем отказа от этой абстракции; вместо этого создается один или несколько потоков (но не больше количества процессоров!), иногда они еще прибиваются жестко к процессорным ядрам, и все задачи кооперативно выполняются в них.

Интересно, что любой чисто асинхронный код естественным образом порождает задачи, а не потоки; если не ошибаюсь, то, например, все UWP программы такие.

Да-да, все так и есть. Никто не будет делать новые ОС по другим принципам, раз уже есть старые и привычные. Никто не будет делать новые процессоры по другим принципам, раз уже есть старые и привычные. Пусть неоптимальные, но мы к ним привыкли, кода понаписали… Я уже говорил про обратную совместимость, и вы подтверждаете мою точку зрения ))

На самом деле иногда пытаются — Itanium должен был давать лучший доступ до "настоящего" железа, чем текущие лидеры, Project Singularity пытался избавиться от накладных расходов на изоляцию ядра ОС — увы, они не выжили.

Никто не будет делать новые ОС по другим принципам, раз уже есть старые и привычныеДелали, делают и будут делать.

Никто не будет делать новые процессоры по другим принципам, раз уже есть старые и привычныеДелали, делают и будут делать.

Вот только рынок всё это не принимает и не примет, пока не сделают что-то, что действительно лучше, а не только с одной стороны и то теоретически или со значительными оговорками или ограничениями

Сколько человеко-лет ушло на написание TBB и всех ему подобных диспетчеров (включая что-то похожее в каждом первом игровом движке)

У меня — пара дней, причём я ещё получил до кучи выигрыш в виде сокращения накладных расходов по сравнению с TBB: универсальные средства не являются оптимальными для каких-то определённых задач.

Языковые VM тут ничего принципиально не меняют: с точки зрения пользовательского кода, работающего в песочнице, многозадачность всегда будет вытесняющей. Независимо от того кто это самое вытеснение будет обеспечивать — ОС или среда исполнения.

Вытесняющая многозадачность необязательна, если код jit-ится виртуальной машиной, которая может ставить yield в нужные места (а они проверят флажок, что пора отдать поток, ставящийся прерыванием от таймера). Компилятор может ставить этот yield во все внутренние циклы, кол-во итераций которых выше некоторой величины или его невозможно вывести математически.

Также, ради оптимизации, jit-компилятор может разбивать цикл по 1e6 итераций на 1e2 циклов по 1e4 итераций и между ними ставить yield, что минимально затронет производительность.

И речь не о том, что общее адресное пространство невозможно, а о том, что оно небезопасно. Поэтому если есть недоверенный код (а он есть всегда), то изоляция адресных пространств обязательна.

2. В чем смысл передачи функций ОС компилятору? И когда появится универсальный компилятор для любого языка?

В чем смысл передачи функций ОС компилятору?А в чем смысл идеи VLIW, отдать шедулинг команд компилятору, когда и процессор неплохо справляется. Моё замечание о том, что такая реализация в принципе возможна. Может, с какими-то дополнительными факторами она станет выгодной.

2. Среди процессоров общего назначения VLIW-разновидностей как-то не очень много. Все-таки это скорее для специализированных процессоров.

В то же время вопрос зачем отдавать scheduling компилятору не лишен смысла и для «обычных» процессоров. «Окно», в пределах которого способен манипулировать исполнением процессор, минимально. В то же время компилятор может делать это в масштабах всей программы, к тому же это снижает сложность, а соответственно, стоимость и энергопотребление процессора.

Но одно дело переносить функции железа на софт, и совсем другое функции софта на тот же софт. Причем ваш вариант однозначно ухудшает результат и вот почему.

В случае с переносом планирования инструкций из процессора в компилятор мы один раз оптимизируем и неограниченное количество раз исполняем уже оптимизированный двоичный код. Миллиарды процессоров экономят при этом буквально гигаватты мощности.

А в случае с переносом вытесняющей многозадачности из ОС, которая исполняет готовый машинный код, в VM, которая исполняет байт-код, мы, наоборот, получаем миллиарды лишних компиляций. И, поскольку такая jit-компиляция должна быть достаточно быстрой, то она, однозначно, будет хуже, чем традиционная aot-компиляция. Т.е. мы будем тратить лишние гигаватты и на саму компиляцию и на хуже оптимизированный код.

И вы не убедите меня, что современные jit-компиляторы очень быстрые и выдают отличный машинный код, пока я наблюдаю ужасные тормоза на многих сайтах, завязанных на js.

«Окно», в пределах которого способен манипулировать исполнением процессор, минимально. В то же время компилятор может делать это в масштабах всей программы, к тому же это снижает сложность, а соответственно, стоимость и энергопотребление процессора.

Вот только эти оптимизации будут статическими, и особого выигрыша вы, скорее всего, не получите.

Дело в том, что огромный выигрыш в производительности достигается с помощью динамических оптимизаций предсказателя условных переходов в реальном времени:

И вы не убедите меня, что современные jit-компиляторы очень быстрые и выдают отличный машинный код, пока я наблюдаю ужасные тормоза на многих сайтах, завязанных на js.

Языки с динамической типизацией не могут быть быстрыми.

И, кстати, тормоза обычно вызваны не интерпретацией JS, а сложностью обработки DOM самим браузером, пересчёта расположения элементов и отрисовкой графики.

Вот только эти оптимизации будут статическими, и особого выигрыша вы, скорее всего, не получите.

Мы его уже получаем.

Дело в том, что огромный выигрыш в производительности достигается с помощью динамических оптимизаций предсказателя условных переходов в реальном времени

Предсказание переходов — это не оптимизация кода.

Скажем вынесение констант из цикла, обычно увеличивает работу вне цикла и уменьшает внутри. Чтобы понять — стоит ли овчинка выделки нужно знать сколько раз цикл будет исполняться.

То же самое — встраивание функций. И далее везде.

Другое дело, что компилятор может организовать код таким образом, чтобы уменьшить количество переходов вообще (как в случае с встраиванием функций) либо сделать переходы более предсказуемыми для аппаратных предсказателей. Но непосредственно «динамическим предсказанием переходов», о чем шла речь в комментарии, на который я отвечал, компилятор, повторюсь, не занимается и заниматься принципиально не может. Я за точность и однозначность терминологии.

Даже с точки зрения языка невозможно считать, что кто-то занимается «предсказанием», если этот кто-то «знает».

Я читал Intel® 64 and IA-32 Architectures Optimization Reference Manual, да.

The predictors are defined inpredict.def(some of the definitions seem reversed due to how the rules are implemented, e.g.PROB_VERY_LIKELYmay mean “very unlikely”, but the comments describing each heuristic are correct). You can see how GCC is estimating the branch probabilities by passing-fdump-tree-profile_estimateto the compiler, which writes a file containing the output from the predictors for each basic block

Predictions for bb 2 DS theory heuristics: 1.7% combined heuristics: 1.7% pointer (on trees) heuristics of edge 2->4: 30.0% call heuristics of edge 2->3: 33.0% negative return heuristics of edge 2->4: 2.0%

as well as (when using GCC 7.x) the IR annotated with the estimated probabilities.

Не, ну формально он прав, это не предсказание переходов (в том смысле в котором их предсказывает процессор — для конкретного перехода), это оценивание вероятностей переходов.

Именно это я и имел в виду.

Я лишь говорил, что перенос значительной степени оптимизации в компилятор из железа имеет смысл не только для VLIW (которые мой оппонент привел как пример), но и для более популярных архитектур, таких как x86/x64.

Но это было сказано не потому, что я горячий сторонник такого переноса самого по себе, а как пример именно оправданности в противовес неоправданности переноса функций ОС к ВМ.

Видимо из-за этого вы и начали со мной спорить, хотя, судя по другим комментариям, вполне разделяете мое мнение о явном преимуществе качества aot-компиляции перед jit-компиляцией, например.

Вполне разделяете мое мнение о явном преимуществе качества aot-компиляции перед jit-компиляцией, например.

Конечно. AOT-компиляция позволяет получить более быстрый код, а JIT-компиляция — упростить распространение приложения.

И я вообще не рассматриваю архитектуру x86/x64 как удачную. За ней тянется ужасный шлейф обратной совместимости.

Мы его уже получаем.

Вы его получаете для конкретной конфигурации системы. Причём значение будет иметь не только модель процессора, но и тайминги доступа к кэшу, памяти и т.д., иначе код получается неоптимальным.

То есть программы придётся распространять не в виде бинарников, а в исходниках, возможно, предкомпилированных в LLVM-код, а конечному пользователю придётся компилировать эти программы.

А учитывая, что сложность компиляции вырастет в разы, либо компиляция программ будет занимать несколько суток, либо придётся отказываться от оптимизаций, что не лучшим образом скажется на производительности.

Я сталкивался с таким только при запуске программ на суперкомпьютерах на нестандартной архитектуре, когда компиляция небольшой программы занимала несколько часов — неудобно, знаете ли.

Предсказание переходов — это не оптимизация кода.

Ничего себе заявление. А profile-guided optimization — это что, по-вашему?

рограммы придётся распространять не в виде бинарниковВозможно, маркетинг просто перейдёт от загрузки/поставки носителя к on-demand compilation: пользователь скачивает аналог CPU-Z, отправляет отчёт, платит, скачивает программу, скомпилированную под данную конкретную конфигурацию систему.

Сменил систему — переклмпилируй всё заново.

И тогда ещё большие гигаватты электроэнергии будут тратиться на индивидуальную компиляцию программ под каждого пользователя.

Сменил систему — перекомпилируй всё заново.И плати повторно, или оплачивай поддержку. Как вариант — дефальтная компиляция, универсальная, но неоптимальная.

ещё большие гигаватты электроэнергии будут тратитьсяКогда это кого останавливало, если отбивается по деньгам?

Не взлетело (за исключением банков и тому подобных заведений почему-то).

То есть программы придётся распространять не в виде бинарников, а в исходниках, возможно, предкомпилированных в LLVM-код, а конечному пользователю придётся компилировать эти программы.

Как насчёт «распространять в виде переносимого байт-кода, компилировать в машинный код при первом запуске»? Как-то так делается на Андроиде, емнип.

Потому что JIT-компиляция, работающая в реальном времени, никогда не будет насколько же эффективной, что и оффлайн-компиляция.

Правда я не часто вижу его использование. Похоже всем плевать…

И сколько займет jit-компиляция какого-нибудь «Хрома» или «Офиса»?

Ничего себе заявление

Смотрите комментарий выше.

Ключевой момент в том, что в одном процессе. Разные процессы обязательно должны быть изолированными.Я потерял мысль, которую вы хотите донести. Мой ответ был возражением на

раздельные адресные пространства и прочее — это единственный вариант в мире где возможно исполнение недоверенного кодаВ качестве контрпримера — vm .net, когда недоверенный код загружается в общее адресное пространство.

В Windows нет никакого «общего адресного пространства», адресное пространство (АП) каждого процесса отделено от АП любого другого процесса.

То, что вы можете загрузить недоверенный код внутри АП вашего же процесса неудивительно и естественно. Но получить доступ к АП других процессов (без помощи ОС) вы не можете.

И это

раздельные адресные пространства и прочее — это единственный вариант в мире где возможно исполнение недоверенного кодавы просто не поняли. Естественно, что можно сделать систему, в которой АП будет общим. С этим никто и не спорит. Только по соображениям безопасности этого делать никто просто не будет. Поэтому, если из контекста для вас неочевидно, то я чуть-чуть переформулирую «раздельные адресные пространства и прочее — это единственный разумный вариант в мире где возможно исполнение недоверенного кода»

это единственный разумный вариантНе слишком ли категорично? Какие фундаментальные проблемы с безопасностью есть у Application Domains в .net?

Я тоже не совсем понимаю с чем именно вы споритеС тем, что общепринятые способы разделения доступа и ресурсов единственно верные и всегда будут эффективнее.

А в чем смысл идеи VLIW, отдать шедулинг команд компилятору, когда и процессор неплохо справляется.

Там смысл в том, что компилятор обрабатывает программу один раз (и может работать хоть час), а процессор — при каждом запуске (и должен делать это очень быстро).

При передаче функций ОС компилятору такой мотивации нет.

Мне попалась на глаза статья Дэвида Чизнэлла, исследователя Кембриджского университета, в которой он оспаривает общепринятое суждение о том, что С — язык низкого уровня, и его аргументы мне показались достаточно интересными.

Ну, в те годы, когда я учил Си — его называли языком высокого уровня, изредка говоря "среднего" за некоторые низкоуровневые фишки типа адресной арифметики.

2. Кроме PDP-11 было ещё много архитектур, на которые C ложился «достаточно прямо». В том же 8086 была сломана только адресация (сегмент-смещение, нигде больше не видел подобного ада), но она была сломана для всех языков. Зато были базовые регистры, в частности регистр BP, в который копировался SP — т.е. нормальная поддержка стек фреймов, что очень ценно для наивной реализации компилятора Си. И никакого предсказания переходов.

Или hitachi sh3 — на котором я впервые увидел, как компилятор Си выдаёт предельно оптимизированный код. С delayed branches вместо предсказания переходов — гениальное решение.

P.S. И ведь статья-то на итог вообще не об этом, и гораздо интереснее темы из заголовка…

There is no official definition, but historically assembler/machine code was considered low-level and any language more abstracted was high-level. But C is one of the high-level languages which is closest to the machine level, which is why it is sometimes designated «mid-level», while scripting languages like Python have sometimes been designated «very high level». But these are all informal categories and somewhat subjective.++ www.quora.com/Why-is-C-considered-a-low-level-language

Не можете понять как компилируется ваш С-шный код? Включите трансляцию в ассемблер и читайте. Придется правда в C ABI разобраться, но то такое.

Не нравится что компилятор слишком умный? Поставьте -О0 и вперед — оптимизируйте руками.

Суперскалярная архитектура, конвеерное выполнение, предсказание переходов, предсказание промахов трансляции страниц, спекулятивное выполнение — все это появилось не вчера и даже не позавчера. В 95-м С-шный компилятор был вполне себе низкоуровневым, то что он вырос в плане оптимизаций в 2018 не делает его высокоуровневым.

>>Эта информация в C гораздо более ограниченна, чем в таком языке, как Fortran, что является основной причиной того, что C не сумел вытеснить его из сферы высокопроизводительных вычислений.

Фига с два. Основной причиной является то, что на фортране дочерта и больше Legacy кода, который тянется с мохнатых 80-х или 70-х, в том что в тех же годах математики и физики очень привыкли фигачить все на фортране. Практически до 2000-х, когда видимо начинать новый проект на фортране стало уж совсем моветон. Реализация С-шных и С++ вещей на фортране часто вызывает улыбки. Например чтобы преобразовать 2-д в 1-д массив без вызова решейпа (затратной операции, которая реально перекладывает данные) — фиганем его через функцию, в которой массив определим «как придет» — потеряем дескриптор, но зато можем заюзать его как угодно. Или реализация полиморфных объектов через интерфейсы…

Короче не от хорошей жизни там извращаются.

Мне кажется, что главный посыл автора не в том, что все сишники на самом деле джависты (не в обиду последним), а в том, что возможности современного железа очень сильно упираются в сишное представление вычислительной системы. Поэтому автор предлагает взглянуть на мир под другим углом. Мне вот понравились мысли про кеш — хоть я еще не залезал в его когерентность, я слышал, что там все плохо, и возможно то, что предлагает автор, действительно улучшило бы ситуацию. Но, как уже писали выше, легаси есть легаси…

С другой стороны, про параллельные системы я не согласен. Видеокарты, которые так восхваляет автор, хороши в своих задачах, но если попробовать реализовать на них какую-то бизнес-логику, то, мне кажется, получится что-то страшное и непонятное, и оно будет медленнее, чем простой C на обычном процессоре.

P. S. Про Фортран — полностью с Вами согласен.

Не можете понять как компилируется ваш С-шный код? Включите трансляцию в ассемблер и читайте. Придется правда в C ABI разобраться, но то такое.

А если не можем понять, как (и сколько времени) выполняется наш ассемблерный код, потому что внутри процессора он транслируется в нечто недокументированное, тогда что читать? :-Р

Я не припомню процессора для которого не было таблицы с латентностями-трупутами, а занимаюсь я оптимизацией ПО уже более 10 лет.

Вот вам по скайлейку несуществующая табличка от производителя:

software.intel.com/sites/default/files/managed/ad/dc/Intel-Xeon-Scalable-Processor-throughput-latency.pdf

Все эти описания, увы, это не чёткое, точное и жёсткое описание, как для 8086 или 80486, а, скорее, некоторые эвристики, позволяющие с некоторой точностью сравнивать куски ассемблерного кода. Для окончательной оценки — всё равно нужно запускать на железе и мерить. Ибо… «возможны варианты».

Еще бы эти значения гарантированы были, да. Вы же должны быть в курсе в каких условиях и как они считались. Что это был отдельный урезанный линукс и часть функций процессора была отключена. Эти значения не дают вообще ничего, на реальной системе они будут практически всегда выше, а отношения между ними сохраняться не будут. То есть то, что по этой таблице выполняется в три раза быстрее может легко оказаться медленнее на реальной задаче.

Впрочем я не нашел конкретно в этом документе замечаний об этом, что странно. Я занимался этой темой последний раз вроде бы в 2014 году, возможно что они нашли способ что-то гарантировать за последние годы, но как-то это сомнительно.

Тогда нужно устраиваться в компанию разработчик процессора и читать внутреннюю документацию. Или сломать их систему и достать доки нелегально. Или реверснуть логику процессора. Какой вариант вам больше нравится? =)

Самое низкоуровневое, что доступно программисту — это машинные коды. Машинные коды можно хоть по бумажной таблице перевести в ассемблер (и обратно) даже вручную.

При этом компиляторы C выдают соответствующий ассемблерный код такого качества, что даже если бы я переделывал эти задачи вручную на ассемблере, доля совпадений была бы порядка 90%, если не более.

Проще говоря, программист на С и программист на машинных кодах выдадут исполняемый бинарник с совершенно минимальными отличиями.

Куда же низкоуровневее?

Куда же низкоуровневее?Так вы же сами и ответили:

Самое низкоуровневое, что доступно программисту — это машинные коды. Машинные коды можно хоть по бумажной таблице перевести в ассемблер (и обратно) даже вручную.

Вполне реальная идея, чтобы компилятор генерил микрокод (мне даже кажется, что LLVM затачивался в т.ч под это). Но по ряду каких то причин (я бы предположил ноухау/патенты, невозможность разделения ответственности итп), этого делать не дают.

Микрокод это неотъемлемая часть конкретного ЦПУ, меняя микрокод вы меняете ЦПУ а не программируете его.

Микрокод не является неотъемлемой частью процессора, потому что относительно легко заменяется. (Без физических манипуляций).

WARNING: apt does not have a stable CLI interface. Use with caution in scripts.

amd64-microcode/bionic-updates,now 3.20180524.1~ubuntu0.18.04.2 amd64 [installed,automatic]

intel-microcode/bionic-updates,now 3.20180425.1~ubuntu0.18.04.2 amd64 [installed,automatic]

microcode.ctl/bionic 1.18~0+nmu2 amd64Один чешский деятель, сейчас не вспомню университета и регалий, реализовал это году в 2008 — трансляция С в микрокод (не помню, какой именно, не суть).

Моя дипломная работа посвящена в чем-то аналогичной идее — доступу напрямую к микрокоду.

Зависит от процессора и от программиста.

Весной к нам в контору приезжали представители МЦСТ и рекламировали помимо своих VLIW Эльбрусов свой же компилятор С.

Так вот судя по их словам, обогнать себя самого на VLIW-ассемблере либо нельзя, либо на считанные проценты, относительно того же грамотно написанного С-кода в связке с оптимизирующим компилятором.

Так что будь то ARM, SPARC или что-либо ещё — суть не меняется.

Ниже машинных кодов ни в одной архитектуре не опустишься. И С даёт результат чрезвычайно близкий к вручную написанным машинным кодам.

Ниже машинных кодов ни в одной архитектуре не опустишься.

Ну так речь и идёт про то, что надо

И С даёт результат чрезвычайно близкий к вручную написанным машинным кодам.

Но это не точно. (с) По крайней мере в тех кусках, с которыми я ковыряюсь на предмет оптимизации на asm-е.

Ложь скрывается в том, что это только для программ написанных квалифицированными программистами, знающими архитектуру для которой пишут, как минимум на уровне ассемблера. Код скопированный со «стековерфлоу» без «творческой» обработки на 100%, или из-за не знания алгоритмов, или неадекватности алгоритма под конкретную архитектуру (где важны учет операций пересылки, ветвления, а не количества арифметики или количества сравнений, и прочая, и прочая...).

Ложь заключается в том, что си низкоуровневый только в том, что он не предоставляет инструментария, доступного в языках высокого уровня: он не дает никаких гарантий; код на ассемблере или блисе, чуть более низкоуровневый, только потому, что там работа с типом еще менее ограниченна (есть, но никто, ничего гарантировать не может!).

Языки низкого уровня — это языки которые выбирают ССЗБ, разменивая простоту и ограничения абстрактных машин ( DSL[language] -языков ) на максимальную доступность функциональности архитектуры на текущих ЦПУ, минимизируя ответственность за качество кода, выразительность, обозримость, управляемость коллективной разработки (всем все доступно, можно трюкачить, зная «что внутри»; как результат было больше ограничений встроено в си++, java… языках высокого уровня и ООП, с их инкапсуляцией… правда с тех пор мы потеряли Пакеты Прикладных Программ(этакий сорт библиотек, которые мы тоже потеряли)… ССЗБ).

Язык — это всегда! система ограничений [как и языки человеческого общения], я говорю не только о синтаксисе/семантике (да, и они входят в эту систему), но о том, что эта система строится для удобства получения конкретного! результата, через высокоуровневую систему типов (функциональность, в си реализовано только покрытие модальных целых, реализованных в ЦПУ, даже с float/double принято решение в пользу усеченных, в сравнении с фортрановскими или ди, SIMD — чисто архитектурные, а матрицы реализованы только в языках-матпакетах, работа с временем, цветом, видео… скоро (видимо) будет только через #nodejs, на amazon cloud, а пользователю будет отсылаться только картинка со звуком, получая управленческие импульсы прямо из мозга человека-обезьянистого [сарказм] ). Си — это язык unix, как было задумано, использование его иначе чревато овердрайвом, OS обязаны (теперь!) предоставлять всю (открытую) функциональность операционки из конца 60х, ее безответственность по отношению к пользователям, требуя высокой квалификации и обоймы программ накладывающих ограничения на это пиршество свобод…

Конечно, идеалом не является программа с единственной кнопкой «сделай мне хорошо», но язык не определяется свободами, язык — это средство общения, как идеал, си не подходит более чем полностью, он не может даль ничего более (в сравнении с ассемблерами, тем более с макро-… или тем же occam-2, а тем более с ada или c++). Единственное, что дает си — это качественные (на текущий момент) оптимизирующие компиляторы, и легаси, накопившееся с доисторических времен, когда компьютеры были большими.

Так вот судя по их словам, обогнать себя самого на VLIW-ассемблере либо нельзя, либо на считанные проценты, относительно того же грамотно написанного С-кода в связке с оптимизирующим компилятором.

А самое интересное еще впереди — интернет-гиганты пытаются применять машинное обучение к построению hardware. То же самое происходит и по направлению к компиляторам. К сожалению, быстрое гугление пока не дало результатов. На мой взгляд, стоит ждать скорого сокращения разрыва между лучшими оптимизаторами в лице человека и оптимизаторами компилятора.

В своё время нам так разъясняли, чем отличаются языки высокогоуровня от низкого — наличием абстракции. По скольку типы данных и операции языка С абстрагированы от архитектуры — он является языком высокого уровня по определению. Например, такие вещи, как операции с плавающей точкой, являются частью стандарта языка С, однако некоторые архитектуры имеют только целочисленные АЛУ, но благодаря компилятору, программисту не надо об этом заботиться. Разработчики, использующие языки с бОльшим уровнем абстракции, как GO, например, считают С языком низкого уровня, но это не так.

Не нужно путать мнемокод ассемблера и машинный код. Машинный код это двоичные данные, которые непсредственно исполняет процессор, и ничего там уже не переименовывается и не изменяется. Есть ещё байт-код, например Java, но он исполняется не непосредственно процессором, а run-time интерпретатором — специальной программой, которая превращает байты этого кода в вызовы специальных подпрграмм — он так же не является машинным кодом!

Если Вы на assembler напишете программу, то каждая инструкция будет однозначно преобразована в машинный код, и если дезассемблировать полученный дамп данных, вы получите практически тот же исходный код, единственное — это символические имена меток и адресов памяти будут в виде цифр. Поэтому assembler и является языком низкого уровня. Вам нужно знать все спецификации процессора, для которого пишетсчя программа — никакой абстракции, bare metal!

Чтобы пояснить наглядно разницу низкоуровневого ассемблера и высокоуровнего С, приведу маленький пример из жизни 8-битных микропроцессоров AVR. В серии megaAVR есть блок умножения и соответствующая инструкция mul, а в tinyAVR такого блока и инструкции — нет. То есть, написанная программа на ассемблере, для megaAVR с использованием инструкций mul не может быть скомпиллирована для tinyAVR. Все операции умножения прийдется заменить подпрограммой умножения, которая использует, допустим, сложение в цикле. Это говорит о том, что программист должен знать сиецификацию целевого процессора, набор команд, регистров итд. В С можно просто написать a=b*c; и это без переделок можно скомпиллировать для любого процессора, даже не задумываясь, может ли его АЛУ перемножать числа или нет. Компилятор языка С сам заменит умножение на нужрую инструкцию или подпрограмму, в зависимости от используемого целевого процессора.

Машинный код это двоичные данные, которые непсредственно исполняет процессор, и ничего там уже не переименовывается и не изменяется.На календарь смотрели? Последний x86 процессор, где ничего не переименовывалось и не изменялось (хотя кеши были уже и там) — это Pentium! Вышедший четверть века назад!

И для ARM-процессоров — это тоже уже не так (про Denver почитайте, что ли).

Да, в embedded это ещё временами так, ну так в статье не про это речь…

Мне кажется автор имеет весьма смутное понимание о машинах PDP-11.

Мало того что ассемблер на интелле несколько другой, но и аппаратная часть разительно другая: IO порты маппируются на адресное пространство, одной командной данные с одного устройства, например, копируются на другое без участия в этом процессора.

Интел тут со 180 коммандами в паралель выглядит бледно.

Слово эмуляция, мне кажется, неуместно.

И С даёт результат чрезвычайно близкий к вручную написанным машинным кодам.

Вы не читали статью. Современные компиляторы делают массу трансформаций, в т.ч. выворачивают циклы наружу и меняют порядок операций. Т.е. получается код и близко не похожий на то что вы написали.

Современные компиляторы выдают машинный код практически идентичный по качеству тому машинному коду, который я могу написать вручную, зная все особенности данной архитектуры.

Я нигде не говорил, что С-код впрямую транслируется в машинные коды. Я говорил о том, что компилятор выдаёт машинный код, который мне очень сложно обогнать, решая ту же задачу на ассемблере (или в машинных кодах). Мой машинный код получится на 90% идентичный тому, что сгенерировал компилятор.

А Эльбрус — это ещё и R-серия, которая чистый SPARC.

практически идентичный по качеству тому машинному коду, который я могу написать вручную, зная все особенности данной архитектуры.

Но, увы, не всегда. Как человек, вручную оптимизировавший обработчик прерывания на C2000, сокращая его на пару микросекунд, скажу, что компилятор, безусловно, умный, но иногда допускает пикантные деградации (об одной даже получилось отрепортить разработчику компиля).

Что же до "90% идентичный", то компиль обладает замечательной возможностью перемешивания инструкций на конвейере, что позволяет выполнять код быстрее его прямолинейного составления и в итоге он должен стать даже быстрее того, что пишет человек

Когда эту классификацию придумывали, был зоопарк ассемблеров и машинных кодов, и было лишь небольшое количество языков (один из которых — С), которые абстрагировались от железа, и которых стали относить к языкам высокого уровня.

С тех пор было создано огромное множество языков, и все они — одинаково высокоуровные согласно этой классификации. C, C++, C#, JavaScript, Python, да даже LLVM — всё это высокоуровневые языки. В этом случае подобная классификация не имеет никакого смысла.

То есть имеет смысл в относительной классификации, а не в абсолютной, или в нескольких уровнях градации высокоуровневых языков:

— абстрагирование от работы с регистрами и машинным представлением данных (C);

— наличие структур данных: объектов, функций высших порядков (C++)

— абстрагирование от прямой работы с памятью (.NET, JVM);

— абстрагирование от операционной системы (JavaScript).

Как минимум один раз решил — моё приложение одинаково работает на айфоне, андроиде, в файрфоксе на убунту, в сафари на маке и хроме на винде.

Так что ваше заявление ложно.

Для точекнету и жабомашины ОС — виртуальная машина. Всё было круто и однородно чуть ли не до омерзения, когда мобильные апплеты можно было запускать на пеке. А потом появились OpenJDK и Mono — и ряд программ перестал нормально работать в одной из реализаций. Не говоря уж о том, что не только язык, но и байткод обоих терял обратную совместимость в ряде аспектов.

Для бинариков тоже есть разные приблуды. Вроде WINE, которые симулируют x86 и x64 окружение Windows, сохраняя весьма приличную производительность. Или обратную фишку для POSIX от мелкософта. Всё вроде работает, но нет совместимости баг-в-баг.

Для жабоскрипта ОС — это среда выполнения, обычно, браузер. Внезапно в хроме, огнелисе, сафари и эдже есть куча собственных костылей, которые нужно учитывать, а ведь есть ещё node и другие ребята. Дабы далеко не ходить, как давно в них во всех появилось общее имя для корневого элемента? У вас одинаково — или у меня вся вёрстка рассыпется на левом браузере с кастомной темой? Да ладно, у меня в Вивальди или, ть, Амиго точно всё работать будет?

Да ладно, у меня в Вивальди или, ть, Амиго точно всё работать будет?А что это за операционные системы такие? Я таких не знаю.

Зависимости от операционной системы таки больше нет. А от браузера — да, таки есть. Что вас удивляет?

А что это за операционные системы такие? Я таких не знаю.Я надеюсь, это сарказм. А так, нет, не удивляет — забавляет. Люди говорят об избавлении от зависимостей, а потом пишут многотомные проверки на версии браузеров и поддержку фич. Нуок, «везде всё одинаково», «вёрстка почти не поехала».

Люди говорят об избавлении от зависимостей, а потом пишут многотомные проверки на версии браузеров и поддержку фич.Увы, избавиться от зависимости нельзя, если ты хочешь общаться с реальным миром. Можно только передвинуть их. JS успешно заменяет зависимость от операционки на зависимость от браузера. Это всё равно большой шаг вперёд, так как, к примеру, на мобильнких и PC есть одинаковые браузеры, а одинаковых операционок — нету.

Для точекнету и жабомашины ОС — виртуальная машина.

Но и там, и там есть возможность взаимодействия с нативным кодом, возможность вывоза функций системы и взаимодействие с её сущностями.

А в JavaScript и этого нет, взаимодействие идёт только с браузером.

Для жабоскрипта ОС — это среда выполнения, обычно, браузер. Внезапно в хроме, огнелисе, сафари и эдже есть куча собственных костылей, которые нужно учитывать, а ведь есть ещё node и другие ребята.

Если бы существовала серебряная пуля, было бы легче, правда?

*Hе касается Вивальди.

С тех пор было создано огромное множество языков

Но и классификация языков не стояла на месте. Все перечисленные вами языки вполне классифицируются без необходимости введения нового способа классификации.

- Вообще не понятно причет тут язык в частности C. Это проблемы другого плана.

Современные программы тормозят совсем по другим причинам. Компилятор тут вообще не причем. Главная причина экономическая. Надо получать прибыль быстро, поэтому разработчики имеют топовое железо, что бы быстрее выкатить хоть как-то рабочую версию. У них работает приемлемо и ладно. То что у пользователя тормозит — это проблемы негров. Пусть покупают новое железо. Взгляните на java — академически правильный язык, быстрый, хорошо структурированный автоматически следит за память… всё шикарно. Но программы на java приобрели славу тормозного, жрущего ресурсы по. Почему да потому что там тысячи абстракций, куча библиотек обёрнутых в другие библиотеки да еще всё это разных версий.

Если старый word 2003 запустить на новой машине. Всё работает просто мгновенно по стравнению с word 2016, хотя решают они одинаковые задачи набор и печать текста и компиляторы стали лучше и делают массу трансформаций, и операционка новее и ядер больше. Но когда курсором мигают через javascript это всё коту подхвост - Паралельный код писать очень сложно и поддерживать дорого. Особенно на языках к жтому не приспособленных. А использовать всю вычислительную мощность конкретной системы иногда вообще невозможно. Плюс массивно паралельных систем сейчас очень много видов. Поэтому приходится использовать абстракции openmpi,opencl,openal,… и готовые готовые библиотеки IPP, gpu-accelerated-libraries… Более того некоторые алгоритмы не имеют общих рецептов распараллеливания.

- В модель акторов не панацея она создаёт больше проблем чем решает.

- Высокоуровневый язык это sql вы ему пишете что хотите, а он уже сам строит план выполнения, выполняет и возвращает вам результаты.

- Язык C полный по тюрингу и на нём теоритически можно написать что угодно. C компилятор есть почти под любую платформу. Если нет то его просто написать, т.к. сам язык простой.

- Сам язык прост в изучении. Главное отличие C от C++. C необходим для написания маленьких утилит которые потом объеденяются в рабочую систему языками склейки (bash,python,lua,java...). C в отличии от C++ имеет вменяемый бинарный интерфейс. С другой стороны C++ претендует на то чтобы писать огромные «титаники» в которых весь функционал пихают в одну программу.

- Постоянное развитие C++ ведёт его в сторону усложнения, как для изучения так и для написания компиляторов. И к сужению количества платформ под которые можно компилировать. При этом не решая практических задач. (например php из коробки умеет общаться с базами данных, работать с архивами и т.п.)

- Более того не всегда ясно какое наречие языка C++ надо использовать, что бы не огрести проблем.

- Для решения задач распараллеливания есть экспериментальные языки типа halide-lang.org которые пытаются дать инструмент для анализа и поиска компромисса локальности, параллельности и порядка вычислений.

ps: Главная нерешенная задача в программировании это борьба со сложностью.

Высокоуровневый язык это sql вы ему пишете что хотите, а он уже сам строит план выполнения, выполняет и возвращает вам результаты.

увы от этого часто ещё больше проблемм т.к. для того что бы построить верный план нужно знать точную статистику по таблицам а это часто гораздо более затратно чем сам запросс либо приемлеммая точность невозможна (особенно когда по двум и более таблицам).

1.2. Очень красивый пример с вордом. Но давайте ближе к нашим тушкам. Давайте сравним студию 2003 и 2017. Начните с тормозной новой, а потом перейдите на быстролётную старую. Только попытайтесь не блевать в процессе.

2. Да и нет. MPI и прочие — они не про параллельность выполнения операций. Они о командной работе. Про параллельность — OpenMP. ИМХО, там достаточный набор команд для нормального распараллеливания задачи. Если вам нужно больше — вы пытаетесь решать несколько задач одновременно.

Остальные пункты вообще непонятно о чём. Вы не расчёсывайте плюсы — они и чесаться у вас не будут.

Настоящая проблема в том, что разработчики процессоров не дают программистам прямого доступа к управлению процессором. Да что там, даже косвенного не дают. Понятное дело, безопасность, все дела… Но в чём проблема добавить определение расположения переменной в памяти на уровне прагм и деклараторов?

int __declspec(allocate(L3Cache)) bigRoutineCounter; Но нам, почему-то, не доверяют делать вот такие советы. Вот это, на самом деле, печально и обидно.

К тому же, что это за аргументация? Это ж бред! Как минимум, разработчики компиляторов, игр и высоконагруженных систем кровно заинтересованы в каждой доле процента производительности. Если размещение простых ничего не обязывающих прагм работы с кешем позволит повысить производительность на 1% — это уже серьёзно. Если дать возможность программисту задавать вероятности выполнения условий — и передавать их прямо в процессор, можно ожидать огромный скачок производительности всего кода, особенно, JIT.

Пускай это будет расширение Intel или AMD. Пусть это будут «рекомендации» типа inline. Пускай 99% кладут на оптимизацию. У оставшегося процента программы будут значительно быстрее, а зарплаты — выше. И это прекрасно, даже если меня в этом проценте нет и не будет.

Кстати предпочитаю использовать Visual Studio 2005, а не 2017 (там где требуется старый уровень С++). Заметно быстрее работает и все что надо в основном есть (отладка, редактирование, навигация). Там где можно использовать новый С++, там понятно лучше новая студия (ибо старая перестает работать как IDE), но каких-то особых плюсов я не вижу (кроме «Rename» — может чего не нашел?), а минусы в виде пониженной производительности и повышенного потребления ресурсов я замечаю.

Нет, меня самого радует сверхотзывчивая среда разработки. Но меня так же радует комфорт. Если отключить все подсветки и украшательства, окажется, что новая студия быстрее старой и может оперировать бОльшими файлами. Вот только зачем нам нужен очередной блокнот?

1.2. Очень красивый пример с вордом. Но давайте ближе к нашим тушкам. Давайте сравним студию 2003 и 2017. Начните с тормозной новой, а потом перейдите на быстролётную старую. Только попытайтесь не блевать в процессе.Блевать может захотеться от ограничений старых версий компилятора, но вот UI у старой версии — таки приятнее и удобнее.

Я эту старую песню о главном слышу с 2003 года. «Процессоры стали сильно мощные, их нужно замедлять искусственно, чтобы покупали новые.» Это очень красивые слова, которые нужно доказать метриками.

Я пишу софт на Паскале для большого зоопарка систем от первых Селеронов и Атлонов (даже без SSE) до современных 18-ядерных. Который должен работать годами без остановки. И так получается, что если отвязать логику от гуя и от ввода-вывода (через очереди команд), то многое можно сделать асинхронным и легко распараллелить. И тогда проблем с быстродействием процессора практически не возникает, все начинает упираться в диск, сеть и память. И разница между системами 15-летней давности и современными оказывается не столь велика — везде есть какие-то узкие места, то в рейд-контроллере через неделю работы деградирует кеширование запись, то запись в SSD деградирует, то вдруг ОС решит дисками пошуршать по своим делам, то память фрагментируется до неприличия, не может найти непрерывный кусок в десяток мегабайт при свободном десятке гигабайт… А у процессора на самом деле моща гигантская, сотни миллионов операций в секунду. И эта моща может легко уйти в свисток в каком-нибудь банальном цикле поиска или сравнения строк, выполняемого для каждой ячейки таблицы. Для которых есть специальные команды процессора, но компилятор и библиотеки языка программирования решили, что для уникода это не годится.

И, вы серьёзно? То, что вы описываете — отсутствие гигиены, причём, принудительное. Та же дефрагментация по умолчанию выполняется по расписанию еженедельно. Если перестать убирать пыль, любой ПК вышедший после 1996 года рано или поздно вызовет пожар. То же в ОС. У меня на моих задачах даже между Core2Duo 2008 года и Athlon2x4 2011 года разница ощущается весомая. Если вы i9 увайдохиваете в днище… Остаётся только снять шляпу перед вашим мастерством!

И, вы серьёзно? То, что вы описываете — отсутствие гигиены, причём, принудительное. Та же дефрагментация по умолчанию выполняется по расписанию еженедельно.

Как дефрагментировать память в Windows без перезапуска приложения? =)

На процессоре i3 обычно нагрузка 1-3%, на старых 10-20%. Там просто данные из разных портов обрабатываются и отправляются в сеть + кладутся на диск в виде логов и БД. Но данных много, в сутки до 2 Гб логов.

Ну и зачем заниматься дефрагментацией на 64 битах, скажем, я не очень понимаю. Да, есть TLB, есть page cache, но это уже всё эффекты следующего порядка малости.

Это в теории на 64 битах все должно быть шоколадно, а на деле оно вафельно. Вот у чувака похожие проблемы: habr.com/post/420579

Ну и зачем заниматься дефрагментацией на 64 битах, скажем, я не очень понимаю

Каким образом разрядность ОС влияет на проблему фрагментации памяти?

Размером виртуального адресного пространства процесса.

В случае 64-битного процесса вы всегда можете выделить непрерывный кусок памяти любой разумной длины, в случае 32-битного — не можете.

Если вы внимательно прочитаете комментарий, то увидите, что речь там идет о мегабайтах, для чего 32 бит вполне достаточно.

то память фрагментируется до неприличия

При частом выделении/освобождении памяти обычно применяют пулы объектов вместо кучи, не?

в каком-нибудь банальном цикле поиска

Ну, к примеру, если у вас размер структуры больше размера кэша, то вы рискуете каждый раз "промазывать" мимо, тормозя выполнение ПО на порядки. Там, где это критично, начинают размышлять о физической топологии кеша и загрузке из памяти.

для уникода это не годится.

Ну, в общем и целом, если вы не сравниваете две строки юникода как последовательность октетов, то там действительно может быть сложно.

Который должен работать годами без остановки

ОС решит дисками пошуршать по своим делам

У меня возникает ощущение, что где-то взяли не подходящий инструмент для решения задачи.

При частом выделении/освобождении памяти обычно применяют пулы объектов вместо кучи, не?

Так и есть, но случаи разные бывают, всего не предусмотреть. А еще часто вызываются системные функции IpHelper, а у них, похоже, что-то не так с управлением ресурсами в некоторых версиях виндов.

Ну, к примеру, если у вас размер структуры больше размера кэша, то вы рискуете каждый раз «промазывать» мимо, тормозя выполнение ПО на порядки. Там, где это критично, начинают размышлять о физической топологии кеша и загрузке из памяти.

В моем случае это не критично, там больше проблемы с ОСью.

У меня возникает ощущение, что где-то взяли не подходящий инструмент для решения задачи.

А какой инструмент поможет, если слабым звеном оказывается ось и ввод-вывод? Пробовали свою железку делать, на микроконтроллере со своей прошивкой и на нее переложить часть забот, так там свои проблемы — то флеш глючит, то памяти мало, то пропускной способности не хватает.

openal— это библиотека для работы со звуком.

java — академически правильный языкОй, ну скажите еще, что С — не низкоуровневый язык))) Чем java «академически правильная»?

А вообще все Ваши пункты никак не опровергают и не подтверждают сказанного автором.

Изначально был высокоуровневым и им и остался.

То, что за годы компиляторы для С/С++ сделали качественный скачок, не означает, что язык как-то изменился.

Я вообще не понял что хотел сказать автор. Но категорически с ним не согласен.

На современных плюсах легче писать, чем на плюсах 10-летней давности. И выучить современное подмножество, наверное, проще.

Ну кроме тех случаев, когда на собеседованиях спрашивают про фичи, которые скорее всего, никогда не придётся использовать на практике.

2. Вторая сразу станет искать конструктор, а первая поищет оператор приведения.

3. Думаю, не определено.

Уверен, что ошибся минимум в двух пунктах из трех. Так что, учим Go?

3. Не знаю, у меня три варианта и все «равноправные»))

Но опять же, наличие такой вот фишки, которую никто не использует дальше инициализации константной plain-даты, не создает мне головной боли. А вот от Rust'а, я уверен, голова заболела бы еще до попытки что-либо скомпилировать (я про синтаксис).

Но опять же, наличие такой вот фишки, которую никто не использует дальше инициализации константной plain-даты, не создает мне головной боли. А вот от Rust'а, я уверен, голова заболела бы еще до попытки что-либо скомпилировать (я про синтаксис).

Почему-то в каждой статье где вспоминают раст говорят про его ужасный синтаксис. Я последний год его изучаю, полгода пишу всякий опенсорс, и никакого отличия от синтаксиса того же C# не вижу, за исключением сокращений типа function -> fn (хотя в том же F# fun)… Можете рассказать?

А если чуть серьёзнее, если я на раст смотрю как сиплюсплюсист, то там слишком много всяких закорючек.

А можно пример? Основные претензии, что я видел, связаны с лайтаймами и ассоциированными типами. Только там аргументация в стиле «вот в расте лайфтайм есть, а вот в С++ нет, лишняя писанина». Хотя если мы передаем компилятору одинаковое количество инфы (например, гарантируем, что параметр функции А должен пережить параметр функции Б) то оказывается, что синтаксис вполне компактный и понятный.

Раст требует как синтаксиса для высокоуровневых деталей, так и более низкоуровневых. Получается слегка перегружено как для тех, так и для других.

Но для меня освобождение от GC просто как глоток свежего воздуха, ибо работа с любыми ресурсами сводится к соглашениям семидесятых в стиле «caller обязуется освободить ресурс». Автоматизация — наше все. Пусть приходится описывать отношения времен жизни, всё же это декларативное описание, достаточно высокоуровневое.

Clean, например, в отличие от хаскелевских монадок линейными типами (которые суть обобщение лайфтаймов) решает проблему IO, например. В хаскель потихонечку завозят линейные типы. Линейные типы позволяют гарантировать, что вы закроете файл, но сделаете это не более одного раза. Линейные типы позволяют статически определять всякие интересные вещи об использовании данных и генерировать более оптимальный код (например, мутирующий структуру in-place вместо порождения копии даже в чистом ФП). Короче, оно везде полезно.

Круто. Правда, в работающем коде пока не встречал.

Но ведь GC — это только про память, а ресурсы — это далеко не только она!

Но это в каком-то смысле просто ещё раз мой тезис выше.

О чем и речь. Растовые лайфтаймы на моей памяти первый удачный механизм автоматической работы с любыми ресурсами, а не только с памятью. После всех этих try-with-resource и IDisposable радует до невозможности.

Вот расширенный пример, показывающий разницу:

$ ./clang++ -std=c++14 -fno-elide-constructors tst.cc -o tst && ./tst

Foo() constructor called!

Foo() constructor called!

Foo(const Foo&) constructor called!

$ ./clang++ -std=c++17 -fno-elide-constructors tst.cc -o tst && ./tst

Foo() constructor called!

Foo() constructor called!

$ cat tst.cc

#include <stdio.h>

class TraceFoo {

public:

TraceFoo() { printf("Foo() constructor called!\n"); }

TraceFoo(const TraceFoo&) { printf("Foo(const Foo&) constructor called!\n"); }

};

template<typename T>

T mkFoo1() { return {}; }

template<typename T>

T mkFoo2() { return T {}; }

int main() {

mkFoo1<TraceFoo>();

mkFoo2<TraceFoo>();

}

2. Ответ зависит от версии компилятора.

3. Вообще дичь какая-то.

- Нет, пока что ответ от версии компилятора не зависит. Это aggregate initialization, поэтому соберётся во всех conforming-компиляторах для всех С++11, 14 и 17.

Абсолютно нелогичное поведение, кстати. И хорошо, что в С++20 это пофиксят.

P.S. Не удивлюсь, если скоро в первой строчке файла придётся писать директиву типа #language c++20.

> На современных плюсах легче писать, чем на плюсах 10-летней давности

Точно берёшь какую нибудь библиотеку и хочешь её собрать и тут выяснятся что она требует только определённую версию компилятора иначе она или не собирается или не проходит тесты. Еще прикольней когда компилятор сообщает что у вас префис Q не поддерживается и 128битные флоаты (которые вы не используете) не работают. Да и раздел depricated постоянно растёт. Если вы пишете на современном C++ оно через пару лет может уже не собираться на новых компиляторах. Современные плюсы это страх и ужас. Вместо того что бы выкатить новый язык они пытаются сделать из говна конфетку сохраняя обратную совместимость с переменным успехом. Вспомните с чего начинался C++. Это был препроцессор языка C. Так вот эти препроцессоров могло быть сколько угодно. И обычные скриптовые языки элементарно справляются с подобной задачей (генерацией из DSL C кода). И в отличии от C++ не надо ждать выхода нового стандарта, что бы получить например обычную рефлексию кода или аспекты.

>Пхп-код уже можно компилировать под attiny?

дело не в php. А в инструменте который из коробки позволяет просто решать типовые задачи и разбивать на простые сложные. Что C++ из коробки умеет парсить аргументы командной строки как gargs или читать конфигурационные файлы, или упаковывать логи, работать с изображениями, звуком, сетью, базами данных, печатать на принтер, gui и т.п. даже работа с микрософтовскими COM интерфейсами IDispatch для C++ это грусть, печаль и насилие над здравым смыслом.

Вместо решения проблем которые возникают при реализации практических задач C++ предоставляет разнообразные инструменты программирования ради программирования.

Вот например какое отношение к реальным задачам имеет stric aliasing? Даже сам термин UB для стандарта, которого все должны придерживаться, выглядит как издевательство. Вместо нормального языка запросов для анализа и преобразования кода использовать метапрограммирование на плюсовых шаблонах это вообще садизм.

Cи гарантирует, что структуры с одинаковым префиксом могут использоваться взаимозаменяемо, и предоставляет доступ к смещению полей структур в языке. Это означает, что компилятор не может изменить очерёдность полей в структуре или добавить выравнивание для улучшения векторизации (например, трансформировав структуру из массивов в массив структур или наоборот).

Что такое «одинаковый префикс» и куда нельзя добавлять выравнивание (в оригинале там «compiler is not free», то есть всё таки можно, но ограниченно)? Я сломал голову, пытаясь понять этот отрывок.

#include <stdio.h>

#define N 1000

struct StructA {

int a;

char b;

};

StructA VectorA[N];

struct StructB {

int a [N];

char b [N];

};

StructB VectorB;

int main(void)

{

printf("VectorA: %lu \n", sizeof(VectorA));

printf("VectorB: %lu \n", sizeof(VectorB));

}

VectorA: 8000

VectorB: 5000

Как видим, по памяти аккуратней может выйти. Также, например, найти сумму полей a будет быстрее в альтернативной структуре данных. Однако, компилятор не имеет права так поступить.

Последний абзац про потоки и GPU это бред какойто… очень много алгоритмов невозможны без операций над шаред памятью даже пресловутые lock-free.

А в GPU вообще всё иначе.

А «заигрались»… вся индустри заигралась. Процессоры можно сделать в 10 (если не 100 раз) проще, если не пытаться делать вид, что вы работает на «очень-очень быстрой PDP-11»… об чём и статья…

Он идеален для небольших проектов, общающихся с системой на низком (аппаратном) уровне, требующих выжимать проценты быстродействия, экономить ресурсы с помощью хитрых структур данных, рассчитанных до байта памяти.

Бизнес-логику, веб, утилиты, на сегодняшний день, на нём писать нелогично, существуют более эффективные, более высокоуровневые языки.

Его уровень может быть можно мерять относительно других языков программирования, например с java/python/javascript.

То есть да, можно считать, что Си — менее ровный, чем многие другие компилируемые и транслируемые языки. Можно даже считать, что из всех живых/популярных языков, он один из самых близких к низкоуровневым языкам. Но при этом он никогда не был и не станет просто низкоуровневым.

Что такое язык низкого уровня?Ну, я бы определил уровень языка по тому, сколько сил надо для портирования программ на другую платформу. Ассемблер — низкий, т.к. требует много работы при портировании на другой процессор. ABI для работы с периферией («программирование контроллеров») — пожалуй, ещё более низкоуровневый, т.к. требует много работы при смене периферии (например, при смене сетевой карты).

Язык Си — низкоуровневый из-за того, что там масса случаев неопределённого поведения. Из-за этого возможны проблемы при смене компилятора (на том же процессоре и операционке); и возможны ещё более другие проблемы при смене платформы, особенно процессора (например, при переходе от плоской адресации к сегментной).

«Язык программирования является низкоуровневым, если написанные на нём программы требуют внимания к несущественному».Ну, это зависит от того, что считать существенным.

Легко доказать, что С был низкоуровневым языком в PDP-11.Ну так большинство языков того периода — были низкоуровневыми языками платформы, на которой разрабатывались. Например, в Фортране был «условный арифметический оператор» — явная калька с ассемблерной команды.

Ключевая причина появления уязвимостей Spectre и Meltdown в том, что создатели процессоров не просто делали быстрые процессоры, а делали быстрые процессоры с интерфейсом PDP-11.Чтобы доказать это — надо привести пример более другого процессора, на котором хорошо исполняется более другой язык программирования. Ну и оценить перспективу применения этого процессора с традиционными (широко распространёнными) языками программирования; и этого языка программирования с другими процессорами. Прикинуть стоимость портирования на этот процессор существующих операционок и программ.

Лично мне кажется, что гораздо более неприятную проблему представляет необходимость выполнять программы, скомпилированные для *86-й архитектуры, и прежде всего — Windows, которую MicroSoft сама не портирует на другие процессоры и другим не позволяет.

Это значительно усложняет процессоры и приводит к увеличению потребления энергии, но позволяет программистам писать по большей части последовательный код.Т.е. альтернатива — это приучить программистов писать непоследовательный код. Интересно, а сколько программистов, готовых писать такой код, есть в мире; желательно дешёвых индусов? Если их не хватает — то сколько времени и денег потребуется для подготовки таких программистов? А есть ли готовые учителя и учебники для обучения программистов, опять же желательно индусов?

(Если кому-то не ясно про индусов — корпорации предпочитают именно их. Эту тенденцию можно переломить — но тогда давайте оценку стоимости этого перелома).)

В противоположность этому графические процессоры (GPU) достигают высокой производительности другим путём: они требуют написания параллельных программ.Интересно было бы узнать, на каких языках пишут эти программы…

Типичная эвристика кода на С показывает, что есть одно ветвление в среднем на каждые семь инструкций.В процессоре ARM есть возможность сделать любую команду условный — т.е. резко снизить количество условных переходов. Вроде, и в других процессорах есть разные аналогичные хитрости.

Эти выброшенные данные имеют видимые косвенные результатыУжасная формулировка.

1) Косвенные результаты — имеют не выброшенные данные, а совершённые действия (вычисления), которые оказались ненужными.

2) Косвенные результаты всё-таки являюся скрытыми; но при этом их можно разглядеть.

Переименование регистров потребляет много энергии и площади кристалла в современных процессорах.Очевидно, необходимость переименования регистров вызвана неудачной архитектурой набора команд процессора. Если предусмотреть много регистров (столько, сколько их будет реально в процессоре) — то программа (сформированная человеком или компилятором) будет обращаться к тем процессорам, которые есть — а не к виртуальным, которые используются ради совместимости тридцатилетней давности.

Кеш скрыт от программиста и потому недоступен из C.Если сделать кэш доступным программисту (например, расположить егно на определённых адресах адресного пространства) — то мы получим массу проблем при попытке внедрения кэша другой архитектуры. Т.е., гляда на нынешнюю компьютерную индустрию, я могу сказать, что при Вашем подходе — ради совместимости будет зафиксирована ещё и архитектура кэша. Спасибо, нам более чем хватает проблем с фиксацией системы команд процессора!

Если Вам так хочется иметь быструю память — то для этого есть регистры и регистровый файл. Однако, для этого надо менять систему команд процессора — и получить невозможность запуска Windows на этой архитектуре.

Одна из общих характеристик, приписываемых языкам низкого уровня, — скорость.Совершенно очевидно, что данная сентенция относится к той эпохе, когда ещё не была освоена технология оптимизации кода, а компилятор тупо преобразовывал текст программы в машинный код — так, что по машинному коду можно было весьма точно восстановить исходную программу (разумеется, с потерей имён переменных и некоторой другой информации). В наше время — наивысшую скорость скорее можно ожидать от декларативных языков программирования, ибо там компилятор может менять очерёдность исполнения операций совершенно свободно.

Архитекторы процессоров прикладывают героические усилия для создания чипов, которые могут выполнять код на С быстро.Если бы это было правдой — то с каждым новым чипом выпускался бы новый компилятор, предназначенный именно для этого чипа.

В реальности же — архитекторы процессоров ориентируются на быстрое выполнение ранее откомпилированных программ. И им не особо важно, с какого языка получен исполняемый код.

Например, для обработки большого количества данных в C нужно написать цикл, который обрабатывает каждый элемент последовательно.А в каом языке это не так?

во FreeBSD реализация malloc() сообщает системе, что страницы более не задействованы, а система использует первую запись в страницу как доказательство того, что это не такЭто что вообще значит?

Представьте оптимизацию по размыканию цикла, где цикл выполняется ноль раз. В оригинале весь цикл является мёртвым кодом. В разомкнутой версии теперь есть условие с переменной, которая может быть не инициализирована.Ну и что? Цыкл внутри условия всё равно не выполняется!

Одним из базовых атрибутов языка низкого уровня является то, что программисты могут легко понять, как абстрактная машина языка переносится на физическую машину.Но это определение несовместимо с принципом переносимости программ — ибо программист не знает, на какую именно физическую машину будет переноситься его программа. Он может вообще не знать этой физической машины.

Если вы заполните эту структуру нулями и потом укажете значение некоторым полям, будут ли в битах выравнивания нули?1) Как кименно я заполню структуру нулями?

2) Обращаться к битам выравнивания — запрещено. А если туда не обращаться — то их содержимое неважно.

GCC и Clang, например, отличаются в том, сохраняет ли своё происхождение указатель, который конвертировали в целое и назад.А разве так разрешается делать?

Компиляторы могут решить, что два указателя на результаты malloc() при сравнении всегда дают отрицательный результат, даже если они указывают на один и тот же адрес.А можно пример?

При наличии подобных проблем сложно ожидать от программиста полного понимания того, как программа на C транслируется на соответствующую архитектуру.А программист и не должен знать архитектуру.

Есть множество примеров архитектур, которые не были сфокусированы на традиционном коде C и из которых можно черпать вдохновение. Например, такие ориентированные на многопоточность процессоры, как Sun/Oracle UltraSPARC Tx, не требуют столько кеша, чтобы держать занятыми свои исполнительные устройства.1) Что такое «традиционный код C»?

2) Почему Вы считаете, что архитектура *86 фокусировалась именно на C? Мой опыт изучения истории *86 говорит о том, что она формировалась в первую очередь ради совместимости; а C и типа того были не столь важны, ибо в начале существования *86 C не играл на ней особо важной роли.

3) Мне кажется, что главное отличие Sparc — в большом количестве регистров и в наличии регистрового файла.

Исследовательские процессоры расширили этот концепт до очень большого количества аппаратно-планируемых потоков. Ключевая идея состоит в том, что с достаточным количеством потоков процессор может приостановить те потоки, которые ожидают данных, и наполнить исполнительные устройства инструкциями из других потоков.Это же HyperThreading!

Проблема же состоит в том, что программы на C обычно имеют очень мало потоков.А что мешает программисту вызывать подпрограммы (процедуры, функции) с указанием «эту подпрограмму можно выполнять в отдельном потоке»?

Использовать это в C сложно, потому что автовекторизатор должен рассчитать параллелизм на основании циклов в коде.А где просто — в Паскале, в Фортране, в Питоне?

Протокол поддержки когерентности кеша — одна из сложнейших составляющих современного процессора.Это — проблема не процессора, а общей архитектуры компьютера. Производители почему-то считают, что надо обязательно обслуживать ситуацияю «один процесс раскидал вои потоки по всем ядрам сразу». При этом на практике — обычно на мощном процессоре запускают много вирт.машин, которые разделяемые данные вообще не используют.

От языка программирования тут вообще ничего не зависит.

Я полагаю, что производителям вообще надо смотреть в сторону архитектуры «у каждого процессора — своя собственная память». При этом между процессорами д.б. очень быстрая шина — примерно как PCI-X по скорости, но без её глупых заморочек.

В качестве обратного примера можно привести абстрактную машину в стиле Erlang, где каждый объект или локальный, или неизменяемый.Тогда надо придумывать отдельный протокол обмена данными — основанный не на общей памяти.

В сфере разработки программного обеспечения есть миф о том, что параллельное программирование — это сложно.Да вопрос даже не в сложности. А в существовании массы готовых программ и алгоритмов (алгоритм — это как бы неготовая программа), написанных в парадигме последовательного программирования. И переделать это всё на параллельное программирование — реально сложно.

Алан Кэй был бы очень удивлён, услышав это: он научил детей использовать модель акторов, с помощью которой они писали программы на более чем 200 потоков.Замечательно. А что делают эти программы? Может, там есть какие-то новые алгоритмы?

Написать программу на 200 потоков — мало. Надо, чтобы эта программа ещё и делала что-то полезное. Ну, хорошо бы написать офисную программу (Word, Excel), графический редактор (PhotoShop), браузер или Web-сервер — и сравнить с существующими. Даже не обязательно воспроизводить полностью функциональность — хотя бы основную.

Стандарт в этом месте не очень понятен, насколько я понимаю.Достаточно понятен:

The following type designates a signed integer type with the property that any valid pointer to void can be converted to this type, then converted back to pointer to void, and the result will compare equal to the original pointer:Если типа, куда «влазит» указатель нет — тогда нет и соотвествующих типа

intptr_t

The following type designates an unsigned integer type with the property that any valid pointer to void can be converted to this type, then converted back to pointer to void, and the result will compare equal to the original pointer:

uintptr_t

These types are optional.

intptr_t/uintptr_t, но если они есть… то да, можно преобразовывать. На этом разработчики E2K обожшлись, так как эта «фича» всё тегирование им поломала…Язык Си — низкоуровневый из-за того, что там масса случаев неопределённого поведения. Из-за этого возможны проблемы при смене компилятора (на том же процессоре и операционке); и возможны ещё более другие проблемы при смене платформы, особенно процессора (например, при переходе от плоской адресации к сегментной).Что за бред? Неопределённое поведение существует только и исключительно для того, чтобы облегчить перенос на другую платформу. В том числе на платформу с сегментной адресацией, если нужно.

Если ваша программа вызывает неопределённое поведение, то не нужно искать «правильный» компилятор или «подходящую» версию. Нужно программу исправить — только и всего. И тогда никаких проблем с портированием у вас не будет.

Лично мне кажется, что гораздо более неприятную проблему представляет необходимость выполнять программы, скомпилированные для *86-й архитектуры, и прежде всего — Windows, которую MicroSoft сама не портирует на другие процессоры и другим не позволяет.Проблема курицы и яйцы, на самом деле. Windows за время своего существования была портирована на полдюжины платформ точно. Только никому это оказалось не нужно, потому что программы все скомпилированы под x86.

В процессоре ARM есть возможность сделать любую команду условный — т.е. резко снизить количество условных переходов.В AArch64 уже нет.

Очевидно, необходимость переименования регистров вызвана неудачной архитектурой набора команд процессора. Если предусмотреть много регистров (столько, сколько их будет реально в процессоре) — то программа (сформированная человеком или компилятором) будет обращаться к тем процессорам, которые есть — а не к виртуальным, которые используются ради совместимости тридцатилетней давности.И снова «мимо». Проблема в том, чтобы сделать много архитектурных регистров не в том, что поломается совместимость, а в том, что их нужно будет адресовать — то есть увеличивать размер программ. Что приведёт к тому, что вместо того, чтобы тратить место на железо, осуществляющее переименование регистров вы будете тратить его на кеш.

Если бы это было правдой — то с каждым новым чипом выпускался бы новый компилятор, предназначенный именно для этого чипа.Интел примерно это и делает. У остальных разработчиков чипов нет на это денег.

В наше время — наивысшую скорость скорее можно ожидать от декларативных языков программирования, ибо там компилятор может менять очерёдность исполнения операций совершенно свободно.Он может делать всё, что угодно, но результат его работы — всё равно байткод для виртуальной машины, заточенной под C!

2) Обращаться к битам выравнивания — запрещено. А если туда не обращаться — то их содержимое неважно.Как это запрещено? Вы всегда можете сделать

memcpy!Есть в реализации есть опциональный типGCC и Clang, например, отличаются в том, сохраняет ли своё происхождение указатель, который конвертировали в целое и назад.

А разве так разрешается делать?