Комментарии 23

Чуть более подробно можно почитать в первой части нашей первой статьи: habr.com/ru/company/tssolution/blog/425309

Полоса 6GB на 4x 16G FC очень достойно. Расскажите про свой Multipath, он все линки утилизирует даже с соседнего контроллера? Или я не разобрался и это с двух лун, каждая под своим контроллером?

Спасибо, старались :-).

Используется обычный асимметричный acitve-active (ALUA). Линки второго контроллера до LUN-а, который зацеплен за первым контроллером используются, но только "по праздникам", поскольку это не оптимальный путь. И да вы правы, LUN-ы мы тут раскидали по двум контроллерам, чтобы оптимально утилизировать контроллеры, поэтому к сожалению никакой магии :-) просто корректная настройка.

Вы классическую ошибку заказчиков совершаете. Люди складывают номиналы и цены дисков, на основе этого ТЗ выставляют. Даже в случае локального RAID все будет уже не так радужно. А в случае сетевой СХД и подавно?

В нашей практике заказчики указывают требования к производительности по-разному, бывают сразу оба варианта (номинал и при условиях настроенной СХД).

При этом проверяются на приёмке оба варианта тоже по-разному.

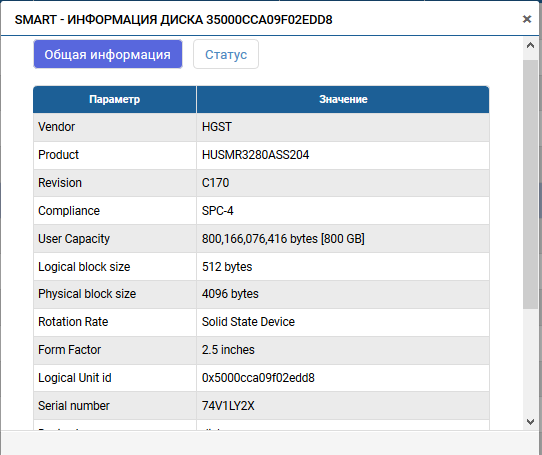

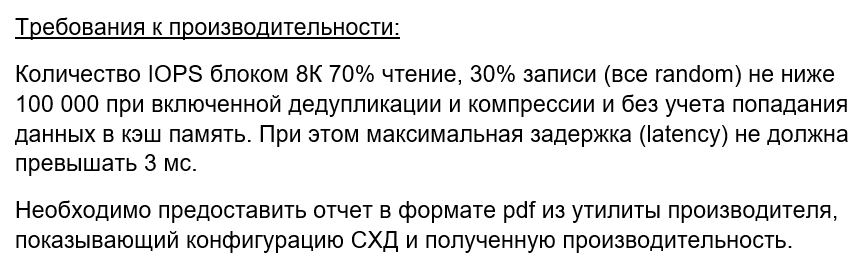

Сумму номинальных IOPS-ов в ТЗ пишут, как требования к именно носителям (это гарантия чтобы производитель плохие диски не поставил, т.к. не все ССД одинакового объема и DWPD одинаково полезны). Это подтверждается с помощью оригинального описания изготовителя диска, ну и при желании заказчика, с помощью запуска теста на один диск без прослоек.

IOPS-ы в ТЗ, которые получаются с самой СХД, обычно пишут отдельно, указывая соотношение чтения и записи, размер блока и прочие условия.

Частный пример ниже:

Этот вариант уже проверяется в живую на настроенной СХД.

Интересуют следующие сценарии

1) Файловый сервер CIFS/SMB с клиентами на Win и Lin

2) Хранение виртуальных машин с доступом по NFS + какая нибудь отечественная виртуализация на OS+KVM

1)Производительность файлового доступа обязательно покажем в одной из следующих статей. Только наверное лучше сделаем связки SMB>Windows, NFS>Linux

2)Этот сценарий мы тоже покажем, но на другом продукте. У нас есть гиперконвергентная система AERODISK vAIR, в которой есть свой облагороженный KVM.

Уперлись в 4 порта 16G на хосте (на СХД можно ещё 4 добавить).

16Гбит\сек = 1,6 ГБ\сек * 4 = 6,4 ГБ\сек максимум. У нас 6,28.

на всякий случай источник

https://fibrechannel.org/wp-content/uploads/2017/04/FCIA-SpeedMap-Final.pdf

Спасибо. Как раз на следующий тест ENGINE (и не только) для Хабра мы добавим дополнительных серверов.

Сейчас есть проблема в свободных мощностях.

В данный момент у нас все вычислительные мощности задействованы в разработке и внутренних тестах и мы категорически не хотим их оттуда выдергивать (пробовали, плохо заканчивается).

Как раз сейчас появился свободный хороший сервер, поэтому решили не ждать, задействовали, показали результат.

Сейчас как раз готовим большой дополнительный стенд внешнего нагрузочного тестирования (для заказчиков, партнеров и чтобы статьи тут писать :-)), думаю через месяц — полтора он будет готов и как раз на нем уже получиться развернуться на полную.

Сможете написать результат или запилить статью где будет тоже самое, но не raid-10.

Интересен результат для двух raid-6 10+2 или аналогичный raid-60

Российская СХД AERODISK: нагрузочное тестирование. Выжимаем IOPS-ы