Часть 1: 1976-1995 годы

Часть 2: 3Dfx Voodoo

Часть 3: консолидация рынка, начало эпохи конкуренции Nvidia и ATI

До прихода DirectX 10 не было смысла добавлять в чипы необязательную сложность, расширяя площадь кристалла, что повышало функциональность вершинных шейдеров, а также точность обработки чисел с плавающей запятой для пиксельных шейдеров с 24 до 32 бит для соответствия требованиям операций с вершинами. После появления DX10 вершинные и пиксельные шейдеры сохраняли высокий уровень общей функциональности, поэтому переход к обобщённым шейдерам избавил от большой части ненужного дублирования блоков обработки. Первым GPU, в котором применялась такая архитектура, стал легендарный G80 компании Nvidia.

Благодаря четырём годам разработки и 475 миллионам долларов был изготовлен монстр с 681 миллионом транзисторов и площадью 484 мм², впервые выпущенный на флагманской карте 8800 GTX и на 8800 GTS 640MB 8 ноября 2006 года. Разогнанный GTX под названием 8800 Ultra был вершиной мощи G80; он был выпущен в промежутке времени между двумя менее важными продуктами: 320MB GTS в феврале и GTS 640MB/112 с ограниченным тиражом 19 ноября 2007 года.

GTX, оснащённый новым алгоритмом Coverage Sample anti-aliasing (CSAA), благодаря своей несравненной производительности победил всех конкурентов как с одним, так и с двумя чипами. Несмотря на этот успех, в четвёртом квартале компания потеряла три процента рынка дискретной графики, которые благодаря силе OEM-контрактов перешли к AMD.

GeForce 8800 GTX в версии компании MSI

Оставшиеся компоненты бизнес-стратегии Nvidia относительно G80 воплотились в реальность в феврале и июне 2007 года. В виде бета-версии был выпущен основанный на языке C SDK (Software Development Kit) платформы CUDA, позволяющий экосистеме использовать высокопараллелизированную природу GPU. Платформу CUDA используют физический движок Nvidia PhysX, а также проекты распределённых вычислений, профессиональная визуализация и OptiX — движок рейтрейсинга Nvidia.

И Nvidia, и ATI (теперь AMD) занимались интегрированием постоянно расширяющейся вычислительной функциональности в графический конвейер. ATI/AMD решила положиться на разработчиков и комитеты, выбрав путь OpenCL, в то время как Nvidia имела более близкие планы, намереваясь использовать CUDA и высокопроизводительные вычисления.

Для этого в июне Nvidia выпустила линейку математических сопроцессоров Tesla, изначально основывавшихся на том же ядре G80, которое применялось в GeForce и Quadro FX 4600/5600. После длительной разработки, в процессе которой было проведено не менее двух (а возможно и трёх) серьёзных этапов отладки, AMD выпустила в мае R600.

Ажиотаж в медиа привёл к тому, что от AMD ожидали ответа на 8800 GTX, но выпущенная HD 2900 XT оказалась разочарованием. Это была карта верхней части среднего ценового сегмента с энергопотреблением на уровне профессионального продукта: она потребляла больше мощности, чем все современные ей системы.

Масштаб ошибки R600 сильно повлиял на ATI, заставив компанию сменить стратегию для более строгого соблюдения сроков и максимального использования возможностей при выпуске новой продукции. Производительность улучшилась в RV770 (Evergreen), а также в сериях Northern и Southern Islands.

Наряду с тем, что R600 стала самым большим на то время GPU ATI/AMD (420 мм²), она установила и другие рекорды среди GPU. Это был первый чип AMD с поддержкой DirectX 10, первый и единственный GPU с 512-битной шиной памяти, первый десктопный чип с блоком тесселяции (который в результате почти не использовался из-за равнодушия разработчиков игр и отсутствия поддержки DirectX), первый GPU с интегрированной поддержкой аудио через HDMI, а также первый продукт с использованием архитектуры VLIW. Также впервые с выпуска Radeon 7500 ATI/AMD не вышла на рынок самых мощных карт, сравнимых по цене и производительности с конкурентами.

AMD модернизировала R600 до RV670, уменьшив 80-нанометровый техпроцесс TSMC до 55-нанометрового, а также заменив 512-битную двунаправленную кольцевую шину памяти более стандартной 256-битной. Это вдвое уменьшило площадь кристалла R600, который при этом содержат примерно столько же транзисторов (666 миллионов по сравнению 700 миллионами R600). Также AMD модернизировала GPU для поддержки DX10.1 и добавила поддержку PCI Express 2.0; всего этого было достаточно, чтобы завершить серию HD 2000 и конкурировать с мейнстримными GeForce 8800 GT, а также менее мощными картами.

В условиях отсутствия GPU уровня high-end AMD выпустила в январе 2008 года две карты со сдвоенными GPU, а также бюджетные карты на основе RV620/635. HD 3850 X2 появилась в продаже в апреле, а последняя карта под брендом All-In-Wonder — HD 3650 — в июне. Карты со сдвоенными GPU, выпущенные в комплекте с качественными драйверами, мгновенно произвели впечатление на критиков и покупателей. HD 3870 X2 стала самой быстрой одиночной картой, а HD 3850 X2 была ненамного медленнее её. В отличие от системы SLI компании Nvidia, AMD реализовала поддержку карт Crossfiring со стандартными ASIC.

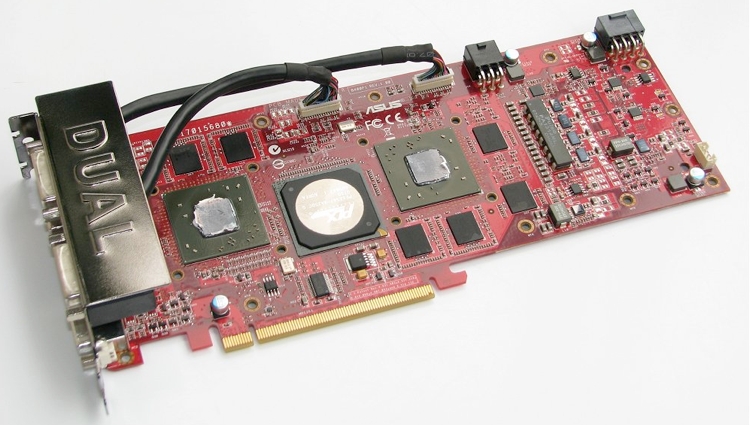

Radeon HD 3870 X2 с двумя GPU на одной карте

Развивая успех G80, 29 октября Nvidia выпустила G92 на карте 8800 GT, отлично воспринятой многими техническими сайтами, в основном благодаря очень конкурентоспособным ценам. Оказавшись в ценовом диапазоне 199-249 долларов, эта 512-мегабайтная карта обеспечивала производительность, из-за которой покупка 8800 GTS на основе G80 становилась бессмысленной. В основном она обгоняла HD 2900 XT и HD 3870, выпущенные спустя три месяца после GT и достигавшие приблизительно 80% скорости GTX. Неудивительно, что спустя считанные недели рынок стал испытывать дефицит 8800 GT. Большой спрос на новый продукт Nvidia и его «братьев» 8600 GS/GT позволил компании к концу года завоевать 71% рынка дискретных карт.

Сразу вслед за GT, 11 декабря Nvidia выпустила 8800 GTS 512MB на основе G92. Хотя в целом карта по сравнению GT соотношение «цена/производительность» была хуже, спасало GTS использование более мощных GPU, что по сути уравнивало при разгоне GTX с дорогими 8800 Ultra.

История серии GeForce 8 была бы неполной без неприятного постскриптума, а именно использования припоя с высоким содержанием свинца в BGA некоторых GPU G86, G84, G73, G72/72M, а также графических чипсетов C51 и MCP67. Это, наряду с низкотемпературной подзаливкой, неадекватным охлаждением и интенсивным режимом нагрева-охлаждения, вызвало необычно большое количество сбоев карт.

В середине 2008 года Nvidia переключилась на эвтектический припой Hitachi (с высоким содержанием олова), который использовался AMD, и изменила дизайн кулера 8800 GT, добавив больше лопастей и модернизировав корпус для улучшения обдува. G92 тоже подозревали в том, что на него повлияла проблема подзаливки, хотя сдвоенных устройства на основе 8800 GTS 512M и карт с нереференсными кулерами это не очень сильно касалось.

Из-за этой проблемы компания потеряла в сумме 475,9 миллиона, что вызвало сильную негативную реакцию со стороны потребителей по отношению к OEM-партнёрам Nvidia, производящим ноутбуки — они знали о проблеме задолго до того, как она стала публичной. Место Nvidia в отрасли навсегда будет связано с этим худшим моментом в её истории.

Если серия 8 стала для Nvidia технологическим триумфом, то серия 9 возвестила о периоде стагнации. Ярким пятном в линейке стала первая модель, выпущенная в феврале 2008 года. 9600 GT была основана на «новом» G94, который на самом деле был урезанным прошлогодним G92, построенным по тому же 65-нанометровому техпроцессу TSMC.

Агрессивное снижение цен AMD на HD 3870 и HD 3850 наряду с падающей стоимостью 8800 GS и GT самой Nvidia заставили выполнить ребрендинг оставшейся части серии 9.

Первые 9800 GT были модифицированными 8800 GT, а 8800 GTS (G92) превратилась в 9800 GTX. Переход на 55-нанометровый техпроцесс TSMC снизил площадь кристалла на 20% и позволил слегка увеличить тактовую частоту для создания 9800 GTX+, идентичной ей OEM GTS 150, а также GTS 250, которые попали в каналы розницы спустя пятнадцать месяцев после первой карты серии 8.

Из-за позднего появления флагманской GT200 и того факта, что AMD HD 3870 X2 теперь была лидером в гонке одиночных карт, Nvidia снова вернулась к своей давней традиции и удвоила количество GPU, разместив сэндвичем две 9800 GT, создав таким образом 9800 GX2. Хотя продукт выигрывал соревнование в бенчмарках, большинство наблюдателей быстро заметило, что продажа сдвоенной 9800 GT по цене трёх отдельных 9800 GT не особо привлекательна для покупателя.

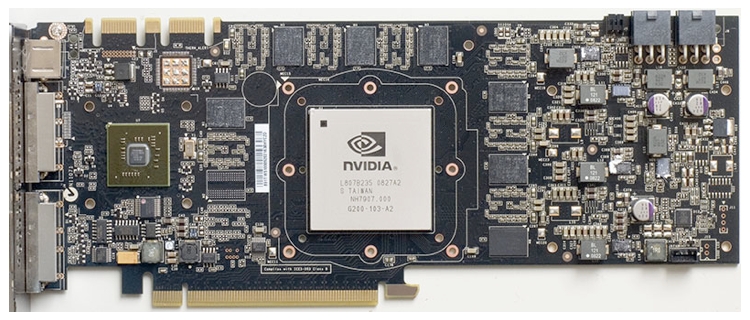

Nvidia G200 GPU на плате GTX 260

К июню Nvidia выпустила GTX 260 и GTX 280 с GPU GT200 (576 мм²) — самым большим кристаллом GPU на тот момент (Intel Larrabee имел площадь примерно 600-700мм²) и самым большим производственным чипом среди всех, произведённых TSMC.

GT200 стала ещё одной попыткой Nvidia привлечь внимание к GPGPU: в ней было реализовано выделенное оборудование для с двойной точностью (FP64) и вычислений. Архитектурные изменения, направленные на игры, были более скромными, но это не помешало Nvidia установить цену за 280 в 649 долларов и выпустить драйверы 3D Vision (для 3D-игр и видео) вместе с 3D-очками и ИК-излучателем — очень дорогостоящий комплект.

Технологическое демо серии Nvidia GTX 200

Цены значительно снизились после выхода HD 4870 и 4850 — GTX 280 подешевел на 38% и стал стоить 400 долларов, а GTX 260 — на 25% (299 долларов).

AMD отреагировала на GT200 и G92 выпуском RV770. Первая карта (нацеленная на нижний мейнстримный сегмент HD 4730) была выпущена 8 июня, а 25 июня за ней последовали HD 4850 и 4870, предназначенные для мейнстримного и высокоуровненого рынков. Выпуск карт произвёл не такой большой фурор, потому что спецификации «утекли» раньше и магазины начали продавать HD 4850 за неделю до истечения срока NDA — такое часто происходит сегодня, но не в 2008 году.

4870 и 4850 стали первыми потребительскими графическими картами с памятью GDDR5, которую Nvidia реализовала спустя восемнадцать месяцев в GT 240, основанном на GT215.

HD 4870 и 4850 заслужили очень положительные обзоры, причиной которых стал широкий список особенностей — звук 7.1 LPCM по HDMI, общая производительность и масштабирование при нескольких GPU, а также, разумеется, цена. Единственным недостатком карты стала её склонность к созданию высоких локальных температур в областях компонентов регулировки напряжения на эталонных платах, что вызывало непропорционально высокие показатели сбоев и зависания, особенно при выполнении таких высоконагруженных приложений, как Furmark.

Сохраняя традицию предыдущих поколений и ощущая необходимость прекращения двухмесячного лидерства GTX 280, AMD выпустила в августе HD 4870 X2. Карта быстро оказалась в верхних строчках бенчмарков по различным катерогиям, в том числе по производительности. В то же время из-за дизайна нагнетательного вентилятора она, к сожалению, лидироваа в категории шумогенерации и тепловыделения.

Radeon HD 4870 X2 (сверху) и Radeon HD 4870

В январе 2009 года линейка Nvidia получила незначительный рост благодаря переводу GT 200 на 55-нанометровый техпроцесс TSMC. 55 нанометров использовались в чипах версии B3, которые впервые появились в сентябре предыдущего года в виде версии Core 216 карт GTX 260. Компания выпустила GTX 295, в которой использовались две урезанные GT200-B3.

Вариация карты с одним GPU была выпущена в апреле под названием GTX 275. Ответ AMD был таким: модернизированная HD 4890 на основе RV790XT и HD 4770 (RV740), которая также стала первой 40-нанометровой картой AMD.

HD 4770, хотя сама по себе не являлась особо важным продуктом, дала AMD неоценимый опыт работы с проблемным 40-нанометровым техпроцессом TSMC, создававшим большую вариативность утечек тока, а также высокий уровень брака из-за незавершённых соединений между слоями металла в кристалле GPU. Благодаря этому опыту AMD смогла улучшить процесс изготовления и устранить проблемы, с которыми столкнулась Nvidia при разработке архитектуры Fermi — проблемы, которые не проявлялись в первых 40-нанометровых GPU Nvidia.

Nvidia выпустила свои первые 40-нанометровые продукты в июле. GT216 и GT218 нижнего ценового уровня применялись в GeForce 205, 210 и GT 220, которые были OEM-продуктами до октября, когда последние две вышли в розницу. Примечательны они только тем, что стали первыми картами Nvidia с поддержкой DX10.1 — эту вершину AMD взяла ещё в HD 4870/4850; кроме того, они имели улучшенные звуковые функции со звуком 7.1, lossless LPCM, битовой потоковой передачей Dolby TrueHD/DTS-HD/-HD-MA, и передачей звука через HDMI. Серия была нацелена на рынок домашних кинотеатров, а в феврале 2010 года была ребрендирована как серия 300.

За четыре месяца с сентября 2009 года по февраль 2010 года AMD выпустила полную линейку из четырёх GPU (Cypress, Juniper, Redwood и Cedar), составивших семейство Evergreen. Линейка началась с HD 5870 сегмента high-end, за которой неделю спустя появилась HD 5850 для верхней части среднего ценового уровня.

Проблемный 40-нанометровый техпроцесс TSMC помешал AMD воспользоваться отсутствием Fermi компании Nvidia, потому что большой спрос превысил предложение. Это в большой мере было вызвано способностью AMD приурочить выпуск Evergreen к появлению Windows 7 и популяризации DirectX 11.

Хотя DX11 потребовалось время, чтобы показать на Evergreen значительный рост производительности, ещё одна функция, появившаяся в HD 5000, сразу же оказала влияние в виде Eyefinity, которая целиком полагается на гибкость DisplayPort, позволяющую обеспечить до шести конвейеров дисплеев на одну плату. Они перенаправлялись на стандартный ЦАП или на комбинацию внутренних передатчиков TMDS и DisplayPort.

В предыдущих графических картах обычно использовалась комбинация из VGA, DVI и иногда HDMI, и при этом для каждого выхода требовался отдельный источник тактовой частоты. Это повышало сложность, размер и количество контактов GPU. DisplayPort избавил от необходимости недависимых тактовых частот и открыл AMD возможность интегрировать в оборудование до шести конвейеров дисплеев, не снижая производительность пользовательского ПО. При этом выполнялась компенсация рамок по краям и растягивание отображения по дисплеям с оптимальным разрешением.

Eyefinity: масштабируемая многодисплейная технология ATI

Серия Evergreen стала ведущей в своём классе среди всех плат (если не вспоминать проблемы с фильтрацией текстур): HD 5850 и HD 5770 привлекли большой процент бюджетных геймеров, а HD 5870 и HD 5970 со сдвоенным GPU обеспечивали несравненный уровень производительности.

Спустя шесть месяцев, 12 апреля Nvidia наконец-то выпустила свои первые платы Fermi под названиями GTX 470 и 480. Ни один из кристаллов компании не был полностью функциональным (то же самое повторилось и с последующим GF104), поэтому скорости ядер Fermi ради снижения энергопотребления были сделаны достаточно консервативными, а пропускная способность памяти оказалась ниже из-за нехватки у Nvidia опыта работы с вводом-выводом GDDR5.

Далеко не оптимальные результаты 40-нанометрового техпроцесса TSMC, уже вылившиеся в проблемы с поставками для AMD, значительно приумножились из за размера кристалла GF100 Fermi (529 мм²). С размером кристалла связаны объём брака, требования к питанию и тепловыделение, поэтому серия 400 компании Nvidia по сравнению с линейкой AMD заплатила за производительность в играх.

GF100 в вариациях Quadro и Tesla пострадали значительно меньше благодаря уже сложившейся на профессиональных рынках экосистеме. Одним из хороших аспектов выпущенных карт стало появление технологии сглаживания transparency supersampling antialiasing (TrSSAA), которая должна была использоваться наряду с уже существовавшей coverage sampled AA (CSAA).

Хотя GTX 480 встретили довольно холодно, второй чип Nvidia Fermi — мейнстримный GF104 на карте GTX 460, получил огромный успех. Он обеспечивал хорошую производительность по отличной цене, модель 192bit/768MB продавалась за 199 долларов, а 256bit/1GB — за 229 долларов. Компания выпустила множество нереференсных и разогнанных на производстве карт со значительными возможностями для разгона благодаря консервативным частотам, которые Nvidia для снижения энергопотребления.

Частично тёплый приём 460 был вызван сдержанными ожиданиями после выхода GF100. Говорили, что GF104 будет не больше половины GF100 и окажется бледной по сравнению с GPU Cypress компании AMD. Но это было не так. Блогеров-«экспертов» и AMD ожидал и второй сюрприз: в ноябре Nvidia выпустила обновлённую версию GF100 — GF110.

Модернизированному продукту удалось достичь того, с чем не справился её предшественник — использовать всю площадь чипа. Получившиеся GTX 570 и 580 стали тем, чем и должна была оказаться первоначальная серия 400.

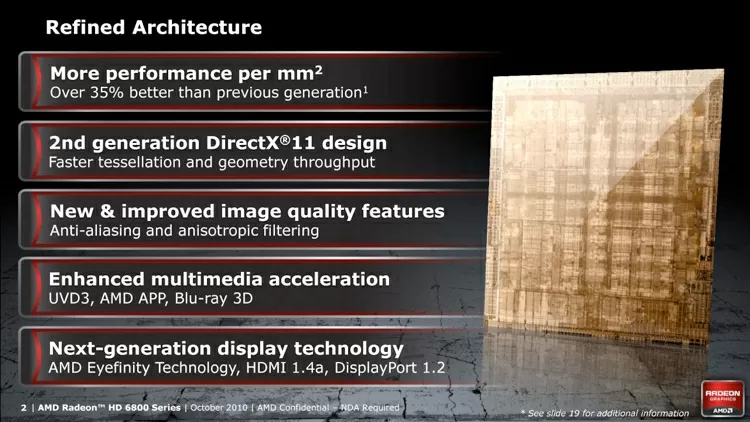

В октябре появился Barts — первый GPU из серии AMD Northern Islands. Он был ближе к эволюционному развитию Evergreen и проектировался для снижения производственных затрат чипа Cypress. Он не обеспечил значительного повышения производительности: GPU был приблизительно равен предыдущим HD 5830 и HD 5850, но существенно уменьшил размер. AMD урезала количество потоковых обработчиков (шейдеров), переделала контроллер памяти и изменила его физический размер (соответственно, снизив скорость памяти), и отказалась от возможности выполнения вычислений с двойной точностью. Однако Barts по сравнению с Evergreen имел улучшенную тесселяцию.

Хотя рост производительности был не таким заметным, AMD улучшила технологию работы с дисплеями. DisplayPort был усовершенствован до версии 1.2 (появилась возможность управлять несколькими мониторами с одного порта, обновление с частотой 120 Гц для дисплеев высокого разрешения и битовая потоковая передача аудио), HDMI — до версии 1.4a (воспроизведение 3D-видео в 1080p, экранное разрешение 4K). Также компания добавила обновлённый декодер видео с поддержкой DivX.

Кроме того, AMD усовершенствовала возможности драйверов, добавив morphological anti-aliasing (MLAA) — фильтр размытия постообработки, функциональность которого (особенно на момент выпуска) была далека от идеала.

HD 6970 и HD 6950 добавили в драйвер Catalyst режим сглаживания под названием EQAA (Enhanced Quality AA); кроме того, AMD также реализовала зачаточную поддержку HD3D, которая в лучшем случае была капризной, и динамическое энергопотребление, на этот раз профилируемое при помощи PowerTune.

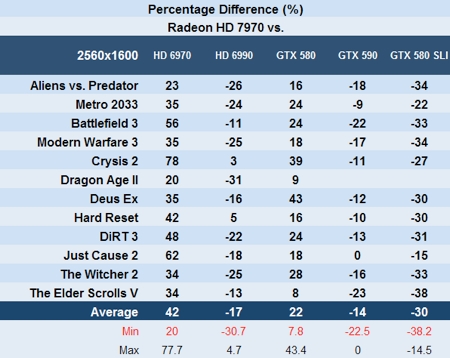

В целом, продукты Cayman были лучше, чем первое поколение чипов Fermi. Они должны были побить их, но на несколько процентов отставали от второго поколения (серии GTX 500), а последующий выпуск драйверов обеих компаний усилил колебания.

Ноябрьский выпуск Cayman был отложен на месяц, и 15 декабря появились HD 6970 и 6950, отошедшие (временно) от архитектуры VLIW5, которую ATI/AMD использовали начиная с серии R300. Вместо неё компания использовала VLIW4, где не было пятого блока выполнения Special Function (или Transendental) в каждом блоке обработки потоков.

Это потребовалось для того, чтобы убрать переизбыток ресурсов, предназначенных для игр под DX9 (и более старых), и в то же время реорганизовать графический конвейер.

Единственными другими продуктами на основе VLIW4 стали интегрированные графические чипы серий APU Trinity и Richland; самая новая графическая архитектура AMD была основана на GCN (Graphics Core Next), а VLIW5 оставалась в серии HD 8000, ребрендированной как GPU Evergreen самого нижнего уровня.

Повторяя историю развития GF100/GF110, потомок GTX 460 — GTX 560 Ti — появился в январе 2011 года. Основанная на GF114 карта содержала в себе полнофункциональный модернизированный GF104, и оказалась столь же надёжной и универсальной, как и её предшественник. На её основе было выпущено множество нереференсных версий с фабричным разгоном и без него.

AMD мгновенно отреагировала на это, снизив стоимость своих HD 6950 и 6870, из-за чего преимущество GTX 560 Ti по соотношению цена-производительность исчезло. Благодаря скидкам, предлагаемым большинством партнёров-производителей плат, HD 6950, и особенно её версия с 1 ГБ памяти, стала более привлекательной покупкой.

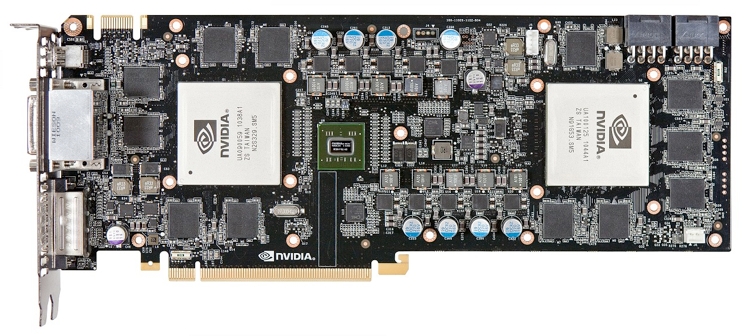

Референсная плата Nvidia GeForce GTX 590

Второй масштабный выпуск продуктов Nvidia в 2011 году, а именно 26 марта, начался со взрыва. В GTX 590 на одной плате были объединены два полнофункциональных GF110.

Платы управлялись драйвером, который недостаточно правильно реализовал ограничение мощности, и имела BIOS, позволявшим подавать высокое напряжение. Этот недочёт привёл к агрессивному избытку напряжения, вызывавшему неисправности MOSFET. Nvidia исправила ситуацию, создав более строгий BIOS и драйвер, но момент выпуска сопровождался уничижительными обзорами. По производительности GTX 590 всего лишь достигла равенства со сдвоенной картой AMD HD 6990, выпущенной за две недели до этого.

9 января начался плановый выпуск потомков AMD Northern Islands — процессоров Southern Islands, первым из которых стал флагманский HD 7970. Это была первая карта для PCI-E 3.0, в которой впервые использовалась архитектура GCN компании AMD, построенная на 28-нанометровом техпроцессе TSMC. Всего спустя три недели к 7970 присоединилась вторая карта на основе Tahiti — HD 7950, за которой 15 февраля последовали мейнстримные карты на Cape Verde. Производительные карты на основе GPU Pitcairn попали на полки розницы в марте.

Карты оказались хорошими, но не обеспечивали значительных улучшений по сравнению с предыдущими 40-нанометрвыми платами. Это, а также менее конкурентоспособные цены, ставшие для AMD стандартом с серии HD 2000, отсутствие в течение двух месяцев драйверов WHQL и неработающий Video Codec Engine (VCE) умерили энтузиазм множества потенциальных пользователей и рецензентов.

Бонусом продуктов Tahiti стало подтверждение того, что AMD оставила большой запас производительности, который можно было получить благодаря разгону. Это был компромисс между энергопотреблением, теплоотводом и тактовой частотой, но он привёл к консервативным частотам ядра и памяти. Возможно, на это также повлияли необходимость снижения брака и недооценка Nvidia GTX 680/670 на основе Kepler.

Nvidia продолжила расширять набор возможностей GPU, выпустив архитектуру Kepler.

В предыдущих поколениях Nvidia начинала с самого сложного чипа, чтобы удовлетворить потребителей-игроков в нише high-end, а затем продолжала длительный процесс тестирования для профессиональных моделей (Tesla/Quadro). В нескольких последних поколениях такой подход был не очень удобным, поэтому приоритет над мощным GK110 получили более скромный GK107 и ориентированный на производительность GK104.

Предположительно, GK107 требовался Nvidia, потому что компания имела масштабные контракты с мобильными OEM-производителями, а GK104 ей был нужен для верхнего десктопного сегмента. Оба GPU поставлялись в виде чипов версии A2. Мобильные GK107 (GT 640M/650M, GTX 660M) начали поставляться OEM-партнёрам в феврале, а официально о них было заявлено 22 марта — в тот же самый день, когда Nvidia выпустила свою GTX 680 на основе GK104.

Ещё одно отличие от последних архитектур GPU Nvidia заключалось в том, что шейдерные блоки работали на той же частоте, что и ядро. Начиная с серии GeForce 8 шейдерные блоки работали с частотой, вдвое или больше превышавшей частоту ядра — в 2,67 раз больше, чем ядро, в сериях 9, и ровно в два раза больше в 400 и 500.

Смысл этой перемены заключался в том, что Nvidia сместила фокус (на десктопном/мобильном рынках) с сырой производительности на соотношение «производительность на ватт». Большее количество ядер, работающее с меньшими скоростями — это более эффективно при параллельных вычислениях, чем меньшее количество ядер с удвоенной частотой. По сути, это стало дальнейшим развитием отличия парадигм GPU и CPU (множество ядер, низкие частоты, высокая пропускающая способность и задержки против малого количества ядер, высокой частоты, меньшей пропускающей способности и задержек).

Кроме того, снижение частоты шейдерных блоков привело к снижению энергопотребления; к тому же, Nvidia ещё больше сэкономила на дизайне, значительно снизив количество блоков с двойной точностью на кристалле, а также сузив ширину шины до более мейнстримных 256 бит. Эти изменения, наряду с относительно скромной базовой скоростью ядра, усиливались функцией dynamic boost (разгона по требованию), что привело к появлению гораздо более сбалансированного продукта, хотя и ценой снижения вычислительных возможностей. Однако если бы Nvidia сохранила вычислительную функциональность и дизайн полосы пропускания Fermi, то в результате получилась бы большая, горячая конструкция с высоким энергопотреблением. Законы физики снова превратили проектирование чипов в искусство компромиссов.

Nvidia опять разработала плату с двойным GPU. GTX 690 по сути оказалась двумя GTX 680, соединёнными SLI. Единственное отличие в том, что максимальная частота ядра 690 (при разгоне) на 52 МГц ниже. Хотя производительность по-прежнему зависела от профилирования SLI драйвером, функциональность карты оказалась на отличном уровне, а её внешний вид стоил бренда limited edition, который она носила.

Чип GK 110 ознаменовал отход от обычной практики Nvidia по выпуску первых GPU в серии под знаменем GeForce. Карта Tesla K20, на которой впервые появился этот чип, имела большой спрос в нише суперкомпьютеров: более 22 000 единиц было необходимо для ORNL Cray XK7 Titan, NCSA Blue Waters, систем Swiss CSCS Todi и Piz Daint.

Обычным потребителям пришлось ждать появления GK110 на карте GeForce ещё полгода. Карта была названа GTX Titan — отсутствие числового номера модели упрочило желание Nvidia видеть этот продукт как модель, отдельную от существующие (и будущей) серии Kepler. При цене в 999 долларов Titan был нацелен на рынок энтузиастов графики. Также Nvidia повысила привлекательность своей линейки для исследователей и специалистов с ограниченным бюджетом — впервые компания позволила карте GeForce сохранить ту же вычислительную функциональность, что и у профессиональных Tesla и Quadro.

Nvidia GeForce GTX Titan

Карта быстро завоевала статус лидера игровых бенчмарков, особенно очевидный в многомониторных разрешениях со включенным super-sampled antialiasing. Однако равнодушие Nvidia к поддержке драйверов OpenCL и появление новых игр в партнёрстве с программой Gaming Evolved компании AMD наряду с огромной ценой снизили влияние Titan.

В июне AMD подготовила свой ответ, выпустив HD 7970 GHz Edition, повысившей на 75МГц частоту ядра с дополнительной возможностью разгона ещё на 50МГц (в противовес динамическому изменению частоты, предложенной Nvidia). GHz Edition имела ту частоту, с которой карта, вероятно, должна была и выпуститься в январе.

К несчастью для AMD целевая аудитория этого продукта уже определила, что стандартная модель благодаря разгону обычно была способна на такой же (если не лучший) уровень производительности, и при этом имела значительно меньшую цену и напряжение ядра. За HD 7970 GHz Edition компания AMD выпустила HD 7950 Boost.