Если вы интересуетесь системами хранения данных, то сайт Storage Performance Council (SPC) вам наверняка знаком. Многие производители, в соответствии с принятыми методиками, проводят тесты своих систем и публикуют их результаты. Конечно, как в любых других синтетических тестах, можно критиковать и методику, и точность опубликованных ценовых характеристик, но на текущий момент это, пожалуй, наиболее объективный открытый источник данных о производительности СХД.

Недавно опубликованные результаты тестов системы DataCore SANsymphony-V 10 демонстрируют серьезный прорыв программно-определяемых СХД (Software Defined Storage).

Речь идет даже не об абсолютных значениях интегральной производительности — протестированная система оказалась позади первой десятки победителей с результатом порядка 450тыс IOPs, хотя и это далеко не самый плохой результат. Прорыв случился в таком важном показателе, как стоимость одной операции ввода-вывода ($/IOPs) — производитель сумел достичь величины в 0.08$/IOPs (8 центов(!) за IOPs). Это действительно великолепный результат, учитывая, что ближайший конкурент (Infortrend EonStor DS 3024B) демонстрирует результат в 3 раза худший — только 0.24$/IOPs. Для большинства же классических систем хранения, результат оказывается еще в несколько раз больше.

Кроме того, при 100% нагрузке время отклика составило 0.32мс, что тоже является замечательным показателем — для многих All Flash СХД вполне приемлемым считается результат меньше 1мс.

Низкая стоимость IOPs достигнута, разумеется, за счет того, что система имеет весьма демократичную цену — весь комплект из железа и лицензий стоит 38400$ (с учетом не очень большого дисконта). Детально стоимость решения расписна в самом отчете и любой желающий может с ней ознакомиться.

Что же, пришла пора новых технологий и уже нужно выводить из обслуживания все старые СХД, заменяя их на SDS?

Да, на первый взгляд, получить схожий результат конкурентам будет очень сложно (если вообще возможно в рамках имеющихся технологий). Дело в том, что SANsymphony-V это программное решение, которое работает внутри сервера и, как следствие, ему не требуется никакая коммутация (FC/Ethernet) со всеми связанными задержками. Кроме того, в версии 10 реализована технология многопоточного параллельного доступа (parallel I/O) к данным и здесь современные многоядерные процессоры дают заметное преимущество. (Почему многопоточный доступ становится актуальным можно прочитать здесь)

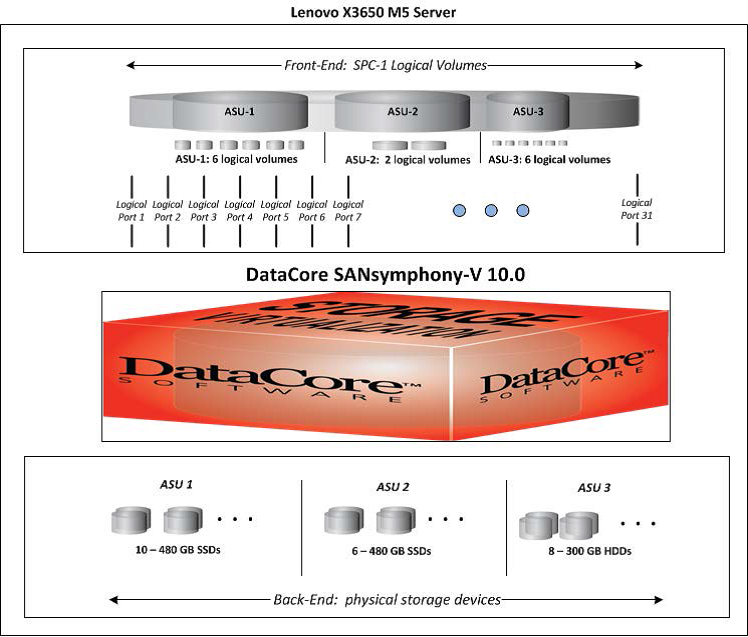

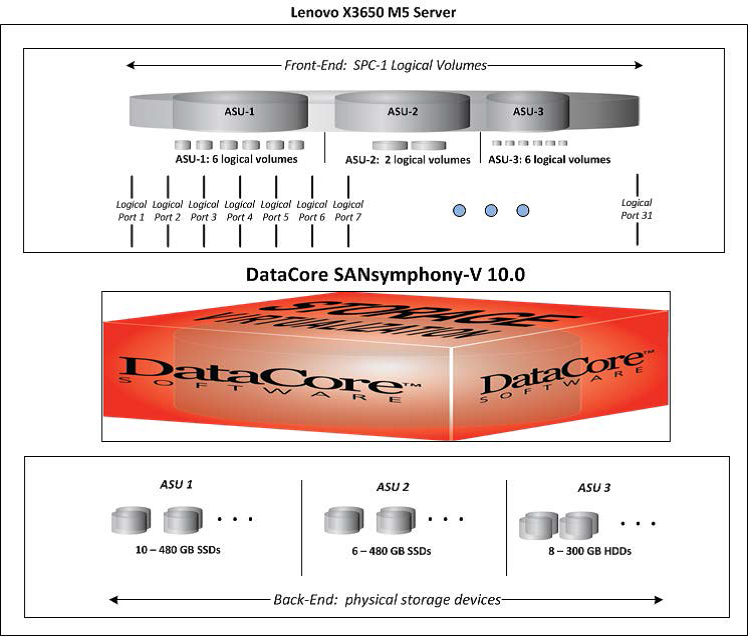

Но давайте более внимательно посмотрим на конфигурацию системы, которая участвовала в тестах. Это всего один сервер Lenovo x3650M5 с двумя процессорами Intel Xeon E5-2695v3 и 544GB оперативной памяти (из которой чуть меньше 409GB было выделено для работы SANsymphony-V). Для размещения данных использовались 16 SSD и 8 HDD общим объемом 10TB. Реальный полезный объем составил 2.9ТБ (29% от общей “сырой” емкости).

Довольно интересно отметить полученные величины производительности для раздела ASU-3 (он размещался на обычных HDD дисках) — более 120тыс IOPs, что однозначно свидетельствуют о том, что данные реально отдавались из кэша (которого в системе было очень много). Поэтому я не очень понимаю, зачем эти диски вообще поставили в систему — если только показать возможность создания гибридного решения.

Что касается архитектуры, то конечно бросается в глаза отсутствие какой-либо отказоустойчивости на уровне всей “системы хранения”. Сами данные зеркалируются внутри одного сервера, но сам сервер не защищен ничем. Насколько изменится производительность, когда мы захотим обеспечить нормальную отказоустойчивость? Вот здесь и начнут играть сетевые протоколы, от которых мы так удачно избавились раньше, и вопрос задержек вернется на повестку дня.

Не использовались “фичи” по оптимизации хранения — компрессия, дедупликация. Конечно, никто в здравом уме не будет их включать во время тестов, но стоит помнить, что в реальной жизни они могут пригодиться. Хотя конечно и без того низкая стоимость как одного IOPs, так и всей системы в целом может позволить отказаться от этих возможностей.

А что предлагают конкуренты? Возьмем тоже не так давно опубликованный результат для IBM FlashSystem 900 — 440тыс IOPs, 0.49ms время отклика при 100% нагрузке (почти на 50% хуже, чем у DataCore) и целый 1.61$/IOPs (в 20 раз больше, чем у DataCore). Но что мы имеем с точки зрения заказчика? Полноценную СХД, подключаемую по FC (один файберный коммутатор даже входит в расчетную стоимость), которая обладает базовым функционалом по отказоустойчивости — не только по отношению к дисковым модулям, но и к контроллерам. Используя такую классическую СХД, заказчику не нужно настраивать и следить за работоспособностью операционной системы в системе хранения (в случае с DataCore использовался Windows Server 2008R2). Немаловажный фактор для пользователя это объем системы — в FlashSystem 900 использовалось 34ТБ (50% от полной емкости). А это в 10 раз больше, чем для теста SANsymphony-V. Сейчас, когда сотни тысяч IOPs перестали быть недостижимым пределом, для ряда решений полезная емкость системы снова выходит на первый план. И разница в цене гигабайта получается совсем не такая большая. Конечно, можно начать спорить, что производительность SANsymphony-V вырастет вместе с объемом, но есть определенные сомнения — кэш системы не получится пропорционально увеличить, а использование параллельно нескольких серверов с ПО DataCore вызовет снижение производительности за счет все тех же проблем с задержками в сетевых протоколах и интерфейсах.

Решение DataCore безусловно интересное и может быть успешно использовано для построения программно-определяемых систем хранения для задач, требующих максимальную производительность. Стоимость решения, особенно в эти непростые дни, может стать определяющим фактором для многих заказчиков. Но при проработке решения не стоит забывать про отказоустойчивость системы и правильно сравнивать цены различных вариантов, учитывая все особенности системы целиком, а не только абстрактную производительность или стоимость IOPs.

Сделать сайзинг системы, подобрать и сравнить варианты реализации и, конечно, подготовить проект всегда рады специалисты Тринити. Наша цель — помочь заказчику выбрать наиболее подходящее решение стоящих перед вами задач.

Другие статьи Тринити можно найти в блоге и хабе Тринити. Подписывайтесь!

Недавно опубликованные результаты тестов системы DataCore SANsymphony-V 10 демонстрируют серьезный прорыв программно-определяемых СХД (Software Defined Storage).

Речь идет даже не об абсолютных значениях интегральной производительности — протестированная система оказалась позади первой десятки победителей с результатом порядка 450тыс IOPs, хотя и это далеко не самый плохой результат. Прорыв случился в таком важном показателе, как стоимость одной операции ввода-вывода ($/IOPs) — производитель сумел достичь величины в 0.08$/IOPs (8 центов(!) за IOPs). Это действительно великолепный результат, учитывая, что ближайший конкурент (Infortrend EonStor DS 3024B) демонстрирует результат в 3 раза худший — только 0.24$/IOPs. Для большинства же классических систем хранения, результат оказывается еще в несколько раз больше.

Кроме того, при 100% нагрузке время отклика составило 0.32мс, что тоже является замечательным показателем — для многих All Flash СХД вполне приемлемым считается результат меньше 1мс.

Низкая стоимость IOPs достигнута, разумеется, за счет того, что система имеет весьма демократичную цену — весь комплект из железа и лицензий стоит 38400$ (с учетом не очень большого дисконта). Детально стоимость решения расписна в самом отчете и любой желающий может с ней ознакомиться.

Что же, пришла пора новых технологий и уже нужно выводить из обслуживания все старые СХД, заменяя их на SDS?

Да, на первый взгляд, получить схожий результат конкурентам будет очень сложно (если вообще возможно в рамках имеющихся технологий). Дело в том, что SANsymphony-V это программное решение, которое работает внутри сервера и, как следствие, ему не требуется никакая коммутация (FC/Ethernet) со всеми связанными задержками. Кроме того, в версии 10 реализована технология многопоточного параллельного доступа (parallel I/O) к данным и здесь современные многоядерные процессоры дают заметное преимущество. (Почему многопоточный доступ становится актуальным можно прочитать здесь)

Но давайте более внимательно посмотрим на конфигурацию системы, которая участвовала в тестах. Это всего один сервер Lenovo x3650M5 с двумя процессорами Intel Xeon E5-2695v3 и 544GB оперативной памяти (из которой чуть меньше 409GB было выделено для работы SANsymphony-V). Для размещения данных использовались 16 SSD и 8 HDD общим объемом 10TB. Реальный полезный объем составил 2.9ТБ (29% от общей “сырой” емкости).

Довольно интересно отметить полученные величины производительности для раздела ASU-3 (он размещался на обычных HDD дисках) — более 120тыс IOPs, что однозначно свидетельствуют о том, что данные реально отдавались из кэша (которого в системе было очень много). Поэтому я не очень понимаю, зачем эти диски вообще поставили в систему — если только показать возможность создания гибридного решения.

Что касается архитектуры, то конечно бросается в глаза отсутствие какой-либо отказоустойчивости на уровне всей “системы хранения”. Сами данные зеркалируются внутри одного сервера, но сам сервер не защищен ничем. Насколько изменится производительность, когда мы захотим обеспечить нормальную отказоустойчивость? Вот здесь и начнут играть сетевые протоколы, от которых мы так удачно избавились раньше, и вопрос задержек вернется на повестку дня.

Не использовались “фичи” по оптимизации хранения — компрессия, дедупликация. Конечно, никто в здравом уме не будет их включать во время тестов, но стоит помнить, что в реальной жизни они могут пригодиться. Хотя конечно и без того низкая стоимость как одного IOPs, так и всей системы в целом может позволить отказаться от этих возможностей.

А что предлагают конкуренты? Возьмем тоже не так давно опубликованный результат для IBM FlashSystem 900 — 440тыс IOPs, 0.49ms время отклика при 100% нагрузке (почти на 50% хуже, чем у DataCore) и целый 1.61$/IOPs (в 20 раз больше, чем у DataCore). Но что мы имеем с точки зрения заказчика? Полноценную СХД, подключаемую по FC (один файберный коммутатор даже входит в расчетную стоимость), которая обладает базовым функционалом по отказоустойчивости — не только по отношению к дисковым модулям, но и к контроллерам. Используя такую классическую СХД, заказчику не нужно настраивать и следить за работоспособностью операционной системы в системе хранения (в случае с DataCore использовался Windows Server 2008R2). Немаловажный фактор для пользователя это объем системы — в FlashSystem 900 использовалось 34ТБ (50% от полной емкости). А это в 10 раз больше, чем для теста SANsymphony-V. Сейчас, когда сотни тысяч IOPs перестали быть недостижимым пределом, для ряда решений полезная емкость системы снова выходит на первый план. И разница в цене гигабайта получается совсем не такая большая. Конечно, можно начать спорить, что производительность SANsymphony-V вырастет вместе с объемом, но есть определенные сомнения — кэш системы не получится пропорционально увеличить, а использование параллельно нескольких серверов с ПО DataCore вызовет снижение производительности за счет все тех же проблем с задержками в сетевых протоколах и интерфейсах.

Решение DataCore безусловно интересное и может быть успешно использовано для построения программно-определяемых систем хранения для задач, требующих максимальную производительность. Стоимость решения, особенно в эти непростые дни, может стать определяющим фактором для многих заказчиков. Но при проработке решения не стоит забывать про отказоустойчивость системы и правильно сравнивать цены различных вариантов, учитывая все особенности системы целиком, а не только абстрактную производительность или стоимость IOPs.

Сделать сайзинг системы, подобрать и сравнить варианты реализации и, конечно, подготовить проект всегда рады специалисты Тринити. Наша цель — помочь заказчику выбрать наиболее подходящее решение стоящих перед вами задач.

Другие статьи Тринити можно найти в блоге и хабе Тринити. Подписывайтесь!