Источник

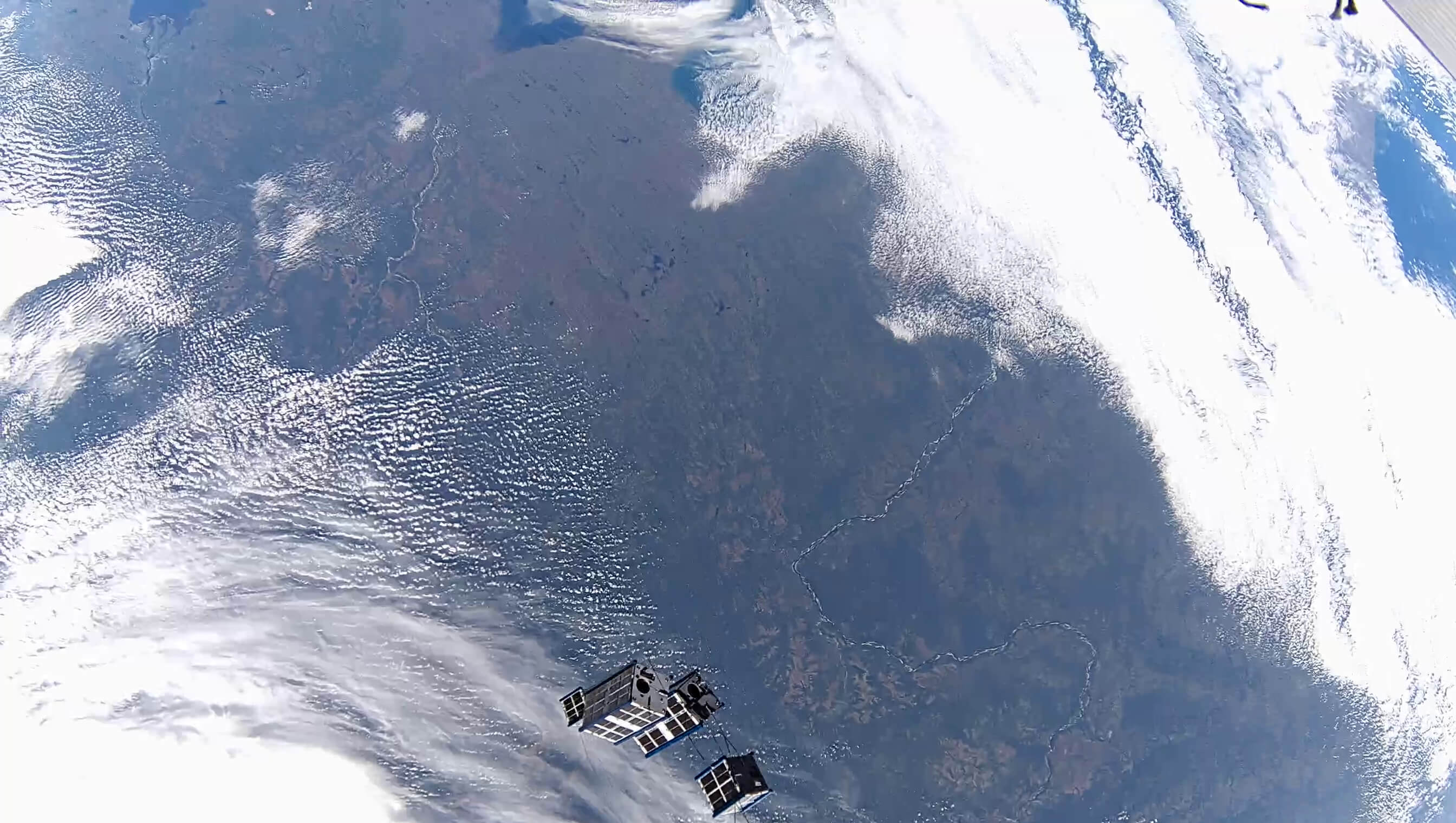

На орбитальной станции очень жёсткая энергетическая дисциплина. Генерация только с солнечных панелей, для теневой стороны — аккумуляторы, а потребители — всё вокруг. Поэтому даже пульты светятся только тогда, когда нужна красивая картинка для научпопа. Обычное состояние светодиодов на пультах — если система работает нормально, то диоды выключены. Включаются они для временно включаемых потребителей и по запросу на статус. То есть экономят даже на такой, казалось бы, мелочи.

Ещё для некоторых экспериментов нужно было копить энергию в особом режиме несколько дней.

Но самое неприятное — это когда при столкновении транспорта «Прогресс М-34» с модулем «Спектр» и последующим отсечением модуля для восстановления герметичности станция лишилась 40% генерации. В этот момент началась настоящая энергетическая экономия.

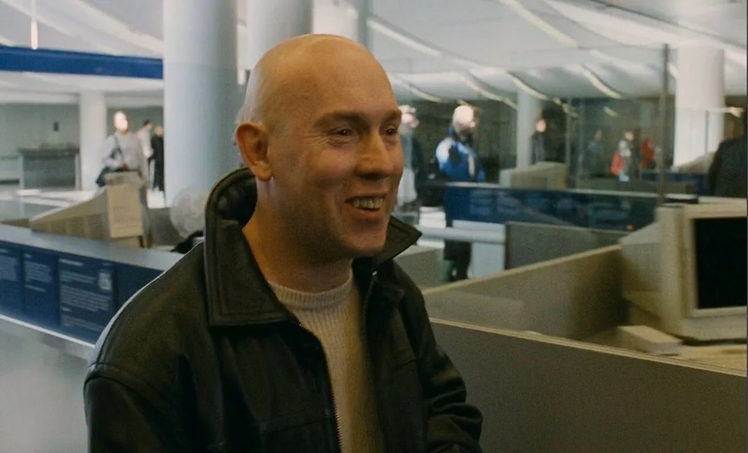

В общем, раз уж мы подписали с Александром Ивановичем Лазуткиным контракт на рекламу и ссылаемся на то, что энергопотребление станции сопоставимо с потреблением нашего ЦОДа, стоит рассказать про детали этого самого потребления. Рассказывает непосредственно Александр Иванович с нашими небольшими пояснениями. Итак, поехали!