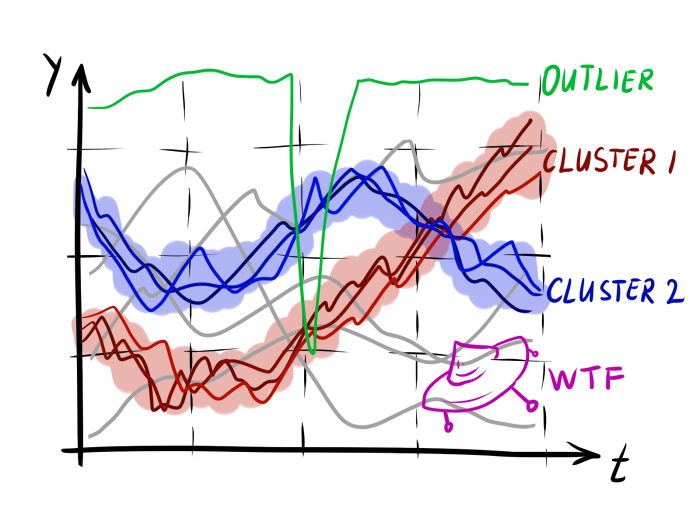

- Подсчёт уникальных людей, зашедших в определённую зону или перешедших через границу в кадре

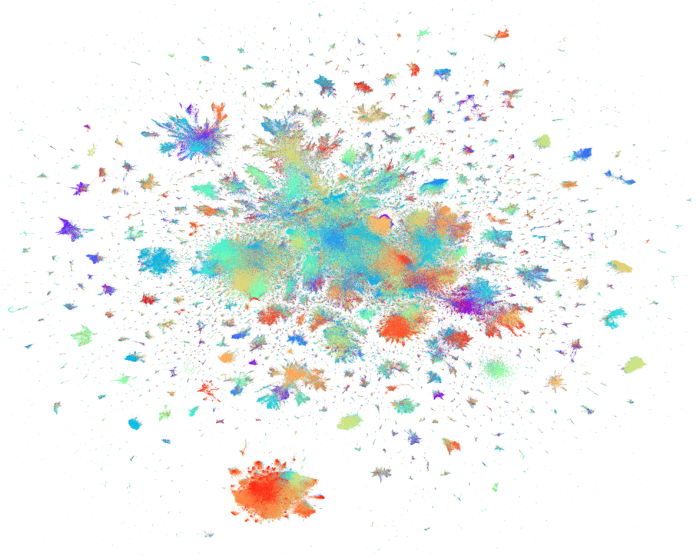

- Определение типичных маршрутов машин на стоянке и людей в магазине

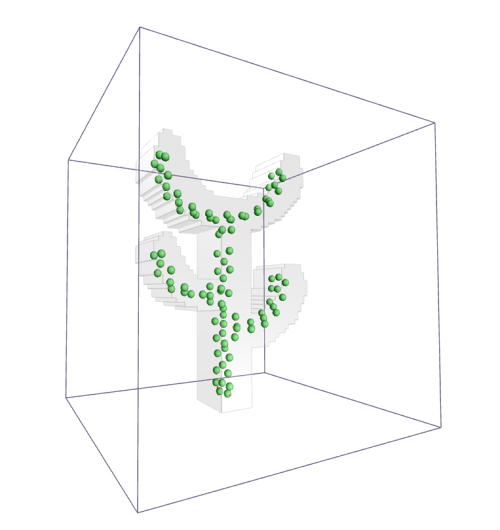

- Автоматический поворот камеры видеонаблюдения при смещении объекта

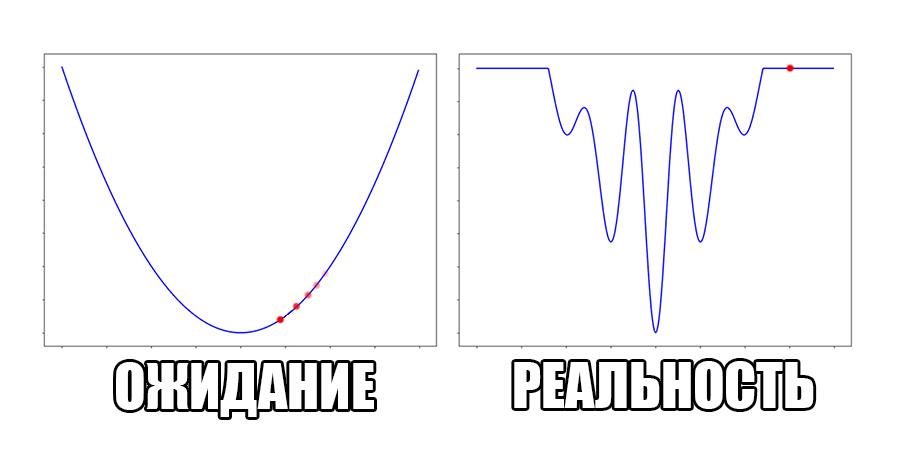

Даже не глядя в литературу, я могу с уверенностью сказать, что наилучший способ решить поставленную задачу — использовать нейронные сети. В общем-то, дальше можно было бы ничего и не писать, но не всегда в задачу можно кинуться парой GTX 1080Ti. Кому интересно, как отслеживают объекты на видео в таких случаях, прошу под кат. Я попробую не просто объяснить, как работают ASEF и MOSSE трекеры, а подвести вас к решению, чтобы формулы показались очевидными.