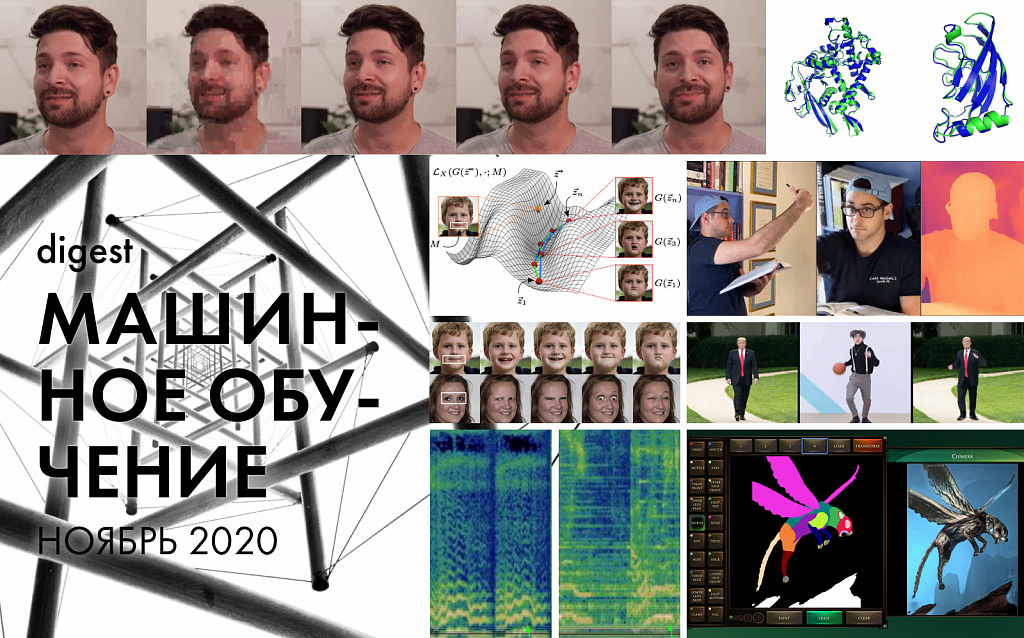

AlphaFold от DeepMind

Главная новость прошедшего месяца в том, что состоялся полноценный релиз открытой модели AlphaFold. Весной мы рассказывали, как DeepMind обучили модель предсказывать структуру белка по набору аминкислот, но данные о качестве результатов еще были неподтвержденными.

Результаты оказались очень впечатляющими, средняя оценка точности по тесту глобальных расстояний — 87 GDT. До этого показатель не превышал 45 GDT, то есть, модель дает 100% прирост точности. Ученым больше не потребуется тратить массу времени на реальные химические эксперименты.

Что это все значит, и почему это важно? Внутри каждой клетки любого живого организма содержатся белки, которые отвечают за все биологические процессы. Белок обладает сложной трехмерной формой, которая определяет его назначение и принцип работы. На сегодняшний день ученым известно о существовании 200 млн. разновидностей белков, но очень мало информации об их структуре. Распутанный белок представляет собой цепочку аминокислот, похожую на нить с бусинами. Взаимодействие кислот сворачивает белок в уникальную форму.

С 50-х годов ученые пытались предсказать форму белка по набору содержащихся в нем аминокислот. Теперь с AlfaFold исследования можно будет проводить быстрее, что даст толчок новым открытиям в разных областях — от борьбы с болезнями до разложения пластиковых отходов и сокращения уровня углерода в атмосфере.

Далее традиционно рассмотрим инструменты на основе алгоритмов машинного обучения, которые появились за прошедший месяц.

NeRF-модели

Появилось сразу два интересных алгоритма, в основе которых лежит метод Neural Radiance Fields.

Facebook совместно Корнелльским университетовм представили модель, которая генерирует динамические сцены на основе одного видео. По движению камеры модель анализирует пространство в привязке ко времени и пытается воссоздать трехмерную геометрию сцены. Глубина сцены рассчитывается по каждому кадру, после чего собирается общее представление. Таким образом можно генерировать новые кадры, снятые будто с другого ракурса.

А Google вместе с Вашингтонским университетом не стали забывать про маркетинг и не просто представили новую модель, но также придумали название новому типу медиаконтента — nerfie, видимо, чтобы было созвучно селфи. Модель также принимает на вход фото и видео с обычного смартфона и воссоздает сцену.

Deepfake-алгоритмы

Исследователи из университета Торонто представили опенсорсную модель, которая анализирует изменения на участках маски и находит дополнительные векторы для генерации изменений областей лица. Если не брать в расчет артефакты, меняющие цвет, то поведение морщин и складок кожи выглядит очень реалистично.

В прошлый раз мы рассказывали про Nvidia Maxine, набор нейросетей для видеоконференций. На его основе создали нейросеть Face-vid2vid, которая генерирует видео говорящей головы на основе референсной фотографии. Движение кодируется на основе представления ключевых точек лица. Пока доступно только демо, так что уже можно протестировать качество работы модели.

Impersonator++ — новая попытка создать полный дипфейк человека во весь рост. Модель генерирует человеческое изображение и переносит движения на статическую референсную фотографию. Доступен код и датасет.

В противовес развивающимся дипфейк-алгоритмам исследователи придумывают все новые способы борьбы с ними. Существующие модели обнаружения дипфейков ориентированы на традиционные методы вроде отслеживания неестественных движений век или искажений по краям лица. Intel и университет Бингемтон обучили алгоритим распознавать дипфейки по фотоплетизмограммам, то есть, по сердцебиению, которое предсказывается по смене цвета кожи. Точность обнаружения — 97.27%, однако модель обучалась на публично доступных датасетах.

Прочие инструменты и сервисы

Алгоритм анимирует изображения

Facebook и Вашингтонский университет продемонстрировали модель, которая преобразует статичные фотоизображения в реалистичное зацикленное видео. Метод предназначен для сцен с непрерывным плавным движением, вроде течения воды и клубящегося дыма, и основан на Эйлеровом описании движения.

Алгоритм использует метод image-to-image преобразований, и обучен на видео с изменениями среды. Новизна подхода в том, что видео зацикливается путем смешивания результатов перемещения точек вперед и назад во времени. Код, к сожалению, пока недоступен.

Удаление объектов с изображений

Появился новый открытый инструмент, который удаляет с фотографий нежелательные объекты и генерирует заполненные области. Авторы предлагают новый подход контекстного восстановления для сверточных нейронных сетей, который следит за соотношением расстояний между участками изображений. Помимо исходного кода авторы представили веб-версию, правда разворачивать ее придется самостоятельно.

Сhimera Painter

Google представил GAN-модель, напоминающую GauGAN от Nvidia. Она предназначена облегчить художникам рутинную работу по созданию ассетов для видеоигр. Создатели добавили веб-интерфейс с простым графическим редактором, в котором можно потренироваться в рисовании фантастических тварей.

Objectron от Mediapipe

Mediapipe выложили набор моделей и большой датасет для распознавания трехмерных объектов в режиме реального времени. Инструменты оптимизированы для работы на мобильных устройствах и уже обучены определять обувь, стулья, кружки и фотоаппараты.

Hum to search

Всем знакомо ощущение, когда в голове застряла песня, но не знаешь ни названия, ни слов, чтобы ее найти. Google представили новый сервис на основе нейросети, который поможет найти трек по напеву. В блоге компании подробно описан принцип работы модели и подход к ее обучению.

На этом все, спасибо за внимание и до встречи в новом году!