Comments 427

Итак, главный вопрос заключается в том, какую книгу(ы) я бы рекомендовал вместо этого? Я не знаю. Предлагайте в комментариях, если только я их не закрыл.

Как для 2008 года, я бы предложил «Совершенный код» (Code Complete) Макконнелла для начинающих разработчиков — гораздо менее категоричная книга, однако в 2020 году не все главы уже актуальны.

+1 за Макконела. Разносторонне, глубоко и без лишнего эпатажа в стиле «я писал код еще на древних египетских скрижалях»

Но, если вспомнить, что эта книга была, пожалуй, одной из первых, дававших базовые знания о грамотной промышленной разработке, много сейчас ей можно простить.

По сути, многие вещи, которые в ней были собраны вместе, сейчас являются стандартом и must have для всех профессиональных разработчиков — поэтому ее по-прежнему стоит рекомендовать.

Я согласен, что плохо для функции вносить неожиданные изменения в переменные своего собственного класса.

Методы в ООП взаимодействуют с состоянием объекта. Когда методы перестают это делать, а состояние начинает проталкиваться через аргументы, то код превращается в обычное процедурное программирование. Разве не так?

С более современными подходами, можно и состояние передавать через аргумент. Поля в таком случае скорее нужны для связей с другими объектами. И это по прежнему может быть ООП.

И это по прежнему может быть ООП.— но уже не Чистый Код.

Такие параметры лучше передавать аргументами метода

Вообще, идея интересная. Но ИМХО не для джавы и прочих ЯП, которые выбирают с учетом скорости разработки. Это что-то вроде const-correctness в c++, где вы можете помечать метод как const, гарантируя, что этот метод не может изменять поля своего объекта. Вот тут как раз люди с подобным осознанно заморачиваются (и все бы так делали). Только вот в плюсах это контракт типа «всё или ничего» — отдельные поля для указания выбрать нельзя. Ну есть еще mutable-поля, что по сути дает возможность их менять даже в конст-методах, но опять же, во всех. Если передавать все нужно аргументами метода — тут вылезут другие недостатки, вроде лишнего копирования тонны аргументов на каждый вызов и прочее, что тоже, согласитесь, не лучший вариант. Проскользнула мысль — разрешать для изменения указанные поля через синтаксис типа аттрибутов в C#, но многословность тоже никуда не исчезнет… Вообще, лично я бы смирился с тем, что в классе его поля — это как единая контролируемая неделимая сущность, и разрешить их изменять без договоренности «по одному» — нет большой выгоды. Но вот насчет статических полей и всяких глобальных переменных (если таковые имеют место быть в том или ином ЯП) — для их изменения как раз не помешало бы вводить те самые разрешения «по одному», ибо сайд-эффекты как раз имхо чаще завязаны на них (всякие errno и прочие). Плюс такого подхода — количество «разрешений» будет гораздо меньше, чем в первом варианте, а так же будет возникать ситуация, когда функции, изменяющие глобальные переменные, помимо своих собственных «разрешений» тащат за собой все разрешения всех вызываемых функций с сайд-эффектами. То есть, мы наглядно будем видеть, что там подкапотно ворочают в недрах вызовов. И да, этот список будет разрастаться, что будет являться показателем «я явно трогаю слишком много всего, надо что-то рефакторить», приводящее к будущим советам от новых гуру типа «не более пары разрешений на функцию» или «список разрешений должен помещаться в один экран» :)

Как-то так.

Например:

auto image = getImage();

image.mirror(); // плохой метод, меняет состояние объекта

auto mirrorImage = image.mirrored(); // хороший метод, состояние не модифицируется, но есть копирование

Тем более, что в современных С++ копирования можно избежать, если добавить перегрузку от rvalue-ref (метод Image mirrored() &&), например:

auto mirrorImage = getImage().mirrored(); // отлично, копирования нет, внешних побочных эффектов нет

В других языках может быть не всегда возможно избежать копии, но выбирая между производительностью и безопасностью\удобством чтения, лучше выбирать второе — оптимизировать ботллнек всегда можно потом. Например, иммутабельные строки выглядят как хороший пример такого выбора.

ну смотрите, у вас есть копирование. Причем картинки, тяжеловесного объекта. Вы всерьез считаете, что это всегда хорошо?

Во многих ситуациях — это плохо. Да, сложно работать с мутабельными объектами. Но жрать память, тратить беспечно ресурсы системы — не в каждом случае можно. В игровых движках за такую иммутабельность вам руки оторвут.

В программировании контроллеров — тоже.

Я к тому, что абстрактный спор — он оторван. Смотреть надо на целесообразность в конкретной реализации. Но лишнее копирование картинок — это даже на фронтенде не всегда хорошо.

ну смотрите, у вас есть копирование. Причем картинки, тяжеловесного объекта. Вы всерьез считаете, что это всегда хорошо?

Нет, не считаю, я считаю что не надо заниматься premature optimization и кидаться сразу делать АПИ мутабельным просто потому что «это быстрее».

Всегда можно воспользоваться вторым вариантом с перегрузкой по rvalue. Можно даже пойти дальше и оставить только эту перегрузку и не перегружать метод от lvalue, тогда уже компилятор будет бить по рукам, а не профайлер. На эту тему был доклад на cpp russia в прошлом году. Возможно, если бы писал класс Image, я бы так и сделал=)

Или, раз уж мы затронули тему игровых движков, то можно вспомнить статью Кармака 8 летней давности где он рассуждает о том что pure functions это хорошо, а сайд эффекты — плохо.

Это ложная дихотомия — либо мутабельность, либо скорость — можно взять и то и то, было бы желание.

Возможно, пример с картинкой не самый удачный, просто первое, что пришло в голову.

Вероятно, какой-нибудь class Matrix и transpose() vs. transposed() было бы лучшим примером.

ну смотрите, у вас есть копирование. Причем картинки, тяжеловесного объекта. Вы всерьез считаете, что это всегда хорошо?

Так ведь никто и не заставляет сразу же делать копирование. Для широкого класса операций (в том числе на картинках) можно результатом mirrored() вернуть нечnо, что ведёт себя как отзеркаленная картинка, но на деле просто осуществляет трансляцию координат из оригинального изображения при доступе. А например image.mirrored().mirrored() вообще вернёт image. Да даже с рисованием поверх этой картинки можно такие фокусы проворачивать, если операция рисования на самом деле создаёт только слой поверх оригинального изображения, а основной массив пикселей остаётся лежать как был.

Более того — в первой редакции этого кода можно и пожрать память, получить уже какой-то рабочий код, который умеет что-то делать с картинками, а потом начинать без изменения API его оптимизировать введением лени, отображений, трансляторов, определять когда нужно спекать эти отображения вместе, а когда не стоит, и прочую "магию".

Причем мы в таком случае бесплатно полчаем всякие undo/redo и прочие механизмы, потому что не ломаем данные которые у нас были.

Ломка данных опциональна, на самом деле. Например для того же рисования есть порог, при котором несколько "слоёв" имеет смысл объединить, чтобы не гонять доступ к пикселям через совсем уж толстые слои обёрток — потому что каждый слой будет требовать вычислительных расходов на каждую операцию доступа.

Для этого можно написать "фасад", который объединяет логику того что внутри него, но позволяет если что разобрать его обратно. Обычная персистентность же. Если то что внутри неизменяемо то в конструкторе считаем агрегацию для скажем десяти слоёв, и дальше работаем с ним как с цельным. А если нас просят сделать undo то мы можем взять наши сохраненные в конструкторе слои, выкинуть один последний и остальное вернуть как результат undo

Я говорил чуть про другое — когда из десяти слоёв undo при добавлении ещё одного слоя получается снова десять (или меньше), просто в каком-нибудь слое N будет лежат результат объединения слоёв N и N-m. Именно такая операция будет деструктивна к undo, зато позволит сэкономить на вычислениях.

auto image = getImage();

image.mirrorTo(image);

auto image = getImage();

auto mirrorImage = newImage()

image.mirrorTo(mirrorImage);

Неявная работа функции + лишнее действие. Не очень удобно.

Такой подход хорош только для супер-низкоуровневых АПИ где мы таким образом контролируем выделение памяти.

Но в сколько-нибудь высокоуровневом коде (а отражение картинок — это пример такого кода) параметры функции являются параметрами, а результат — это то что функция возвращает. Делать void-функцию которая мутирует параметры — ну блин, это вообще не очень.

auto image = getImage();

auto mirrored = std::move(image).mirrored();

std::cout << image.size() << std::endl; // warning, bugprone-use-after-move

image = getAnotherImage(); // OK

Такой подход лучше тем что существует тулинг, который позволяет отслеживать неправильное использование «мувнутых» объектов, а для общего случая (например mirror/nonmirror) такого тулинга нет — только программист знает, что ему нужно.

Если вам нужна копия, то придется явно это написать, и ревьюверу будет видно что тут тяжелая копия:

auto image = getImage();

auto mirrored = Image(image).mirrored();

Или можно воспользоваться Copy-On-Write (если объект полностью иммутабельный, то вам даже deep copy не нужно делать on write, что упрощает код и устраняет большинство проблем COW) и применить ваше решение с флажком «orientation» — тогда и копирование дешевое и иммутабельность сохраняется.

Если вам нужна копия, то придется явно это написать

Проблема в том, что вы же не думали об оптимизации заранее, сервис был маленький, ресурсов вагон и программист из комментария выше уже написал такой код:

auto image = getImage();

auto mirrorImage = image.mirrored(); // хороший метод, состояние не модифицируется, но есть копирование

setImage(mirrorImage);

В этом случае ему, на самом деле, копия была не нужна, исходную картинку можно было выбросить. В другом случае он же написал похожий код, вроде такого:

auto image = getImage();

auto flippedImage = image.flip(); // хороший метод, состояние не модифицируется, но есть копирование

setAnotherImage(flippedImage);

Только здесь ему уже надо было сохранить исходную картинку и получить перевернутую.

Эта история повторилась еще много-много раз. И когда вдруг поняли, что надо бы пооптимизировать лишние копирования, придется каждый такой кейс изучать заново и смотреть — где копирование было необходимым, а где можно и move. Считай, всю работу с картинками придется переписать.

Если программист из комментария не может решить где какой метод совать, есть куча других профессий.

Проблема в том, что вы не прочитали ветку, на которую я отвечал. А именно, пропустили заявление хабраюзера о том, что в современном С++ перемещение (почти всегда) заменяет мутирующие методы.

Но тут скорее речь о том, что если есть выбор между тем, менять состояние объекта или не менять, то лучше избегать побочных эффектов, то есть не менять.Этот тезис вообще ниначем не основан, для относительного низкоуровнего кода вообще вреден. Прежде чем совать иммутабельность в плюсы, надо десять раз подумать а зачем оно вам надо.

В конечном итоге тут все зависит от реализации getImage(), в плюсах красивым образом написать ее вообще невозможно. Писать мувы в таких местах это вообще боль. Под него еще надо сам image правильно написать. Вы же понимаете что мув тоже копирует объект, просто правильным образом разруливает ссылки на тяжелые объекты внутри?

Если вы так гоняете этот image, куда проще в shared_ptr его обернуть, это еще и быстрее будет.

Два метода, один под явное копирование, а второй для мутации объекта будет лучшим выбором.

Этот код вообще бессмысленный

auto image = getImage();

auto mirrored = std::move(image).mirrored();

std::cout << image.size() << std::endl; // warning, bugprone-use-after-move

image = getAnotherImage(); // OKВы получили объект из функции. Если этот объект создается внутри функции и возвращается, мув бессмысленен. Если он гдето там внутри продолжает использоваться, то мув сломает внутрянку этого кода. В таком случае копию всеравно придется делать.

Так куда понятнее и проще, и не нужен тулинг отслеживать мувнутые объекты

auto image = getImage();

image.flip();

auto copyImage = Image(getImage());

copyImage.flip();Если вы пишете низкоуровневый код, отталкивайтесь от производительности, а не от советов из книжек про визуально красивый код на джаве

Этот код вообще бессмысленный

Этот код иллюстрирует пример когда у вас был объект, вы его мутировали, а потом через вереницу ифов использовали:

auto image = getImage();

image.flip();

if (someLongCondition1)

foo();

if (someLongCondition2)

bar();

// your code goes here

baz(image); // упс, вам тут нужен был исходный имадж, а не флипнутый

Да, пример тривиальный (на то он и пример). В случае мувнутого объекта вам тулы скажут что вы делаете что-то не то, а в этом случае вам надо полагаться на ревью/тесты.

Или вам никогда не приходилось часами отлаживать баги где десяток стейтов накладываются друг на друга?

Не думаю, что класс Image должен заботиться обо всех возможных трансформациях. Сегодня надо отражать по вертикали, завтра понадобится отражать по горизонтали, ресайзить, делать Ч/Б, делать негатив, менять гамму, накладывать маску, делать блюр, и ещё сотни эффектов — всё пихать в Image?

Лучше уж сделать composer, которому на входе скармливается иммутабельный Image (тот просто отдаёт владение своим битмапом, чтобы избежать лишнего копирования), потом у композера запрашиваются визуальные эффекты (которые стараются делать преобразования по месту, и могут быть вообще "ленивыми"), и на выходе создаётся результирующий иммутабельный Image (который опять же просто получает владение на получившийся битмап):

auto sourceImage = getImage();

auto composer = Composer{ };

auto resultImage = composer

.addImage(sourceImage.release())

.mirrorX() // в идеале, эффекты в композиции должны быть "ленивыми",

.mirrorX() // и эта пара mirrorX() должна аннигилировать при вызове compose()

.mirrorY()

.grayscale() // в идеале, должен выполниться первым для оптимизации последующих

.negateColors()

.mask(maskingImage)

.gaussianBlur(10)

.compose();А лучше даже обозвать его не Composer, а Composition, и сделать его комбинируемым с собой.

Сегодня надо отражать по вертикали, завтра понадобится отражать по горизонтали, ресайзить, делать Ч/Б, делать негатив, менять гамму, накладывать маску, делать блюр, и ещё сотни эффектов — всё пихать в Image? Лучше уж сделать composer, которому на входе скармливается иммутабельный

Нет, лучше сделать библиотеку. При этом часть перечисленного функционала должна быть реализована как функции (ресайзить, делать блюр), а часть как процедуры (отражение, создание негатива) чтобы при необходимости можно было не создавать новый Image а делать внутри того который есть. А часть — отдельно как функции и отдельно как процедуры, если создание нового это быстрее чем копирование + модификация.

Ещё, как написали ниже, можно сделать библиотеку/неймспейс с нужными функциями и сделать их stateless/pure — на вход объект картинки и на выход объект картинки. Но тут вкусовщина, кому-то нравится писать Composer(getImage())).foo().bar().baz().toImage(), кому-то foo(bar(baz(getImage()))).

В достаточно старых языках программирования (FORTRAN, PL/I и большинство их ровесников) было четкое, на уровне языка, разделение вызваемых модулей на функции — которые возвращают значение на основе переданных аргументов (возможно, производя на эти аргументы какие-то побочные эффекты), и процедуры — которые что-то делают с переданными им аргументами, но значения не возвращают, и сам смысл которых — как раз в том, что для функций называлось бы побочным эффектом.

И вот мне кажется, что автор «Чистого кода» использовал слово «функция» именно в этом контексте.

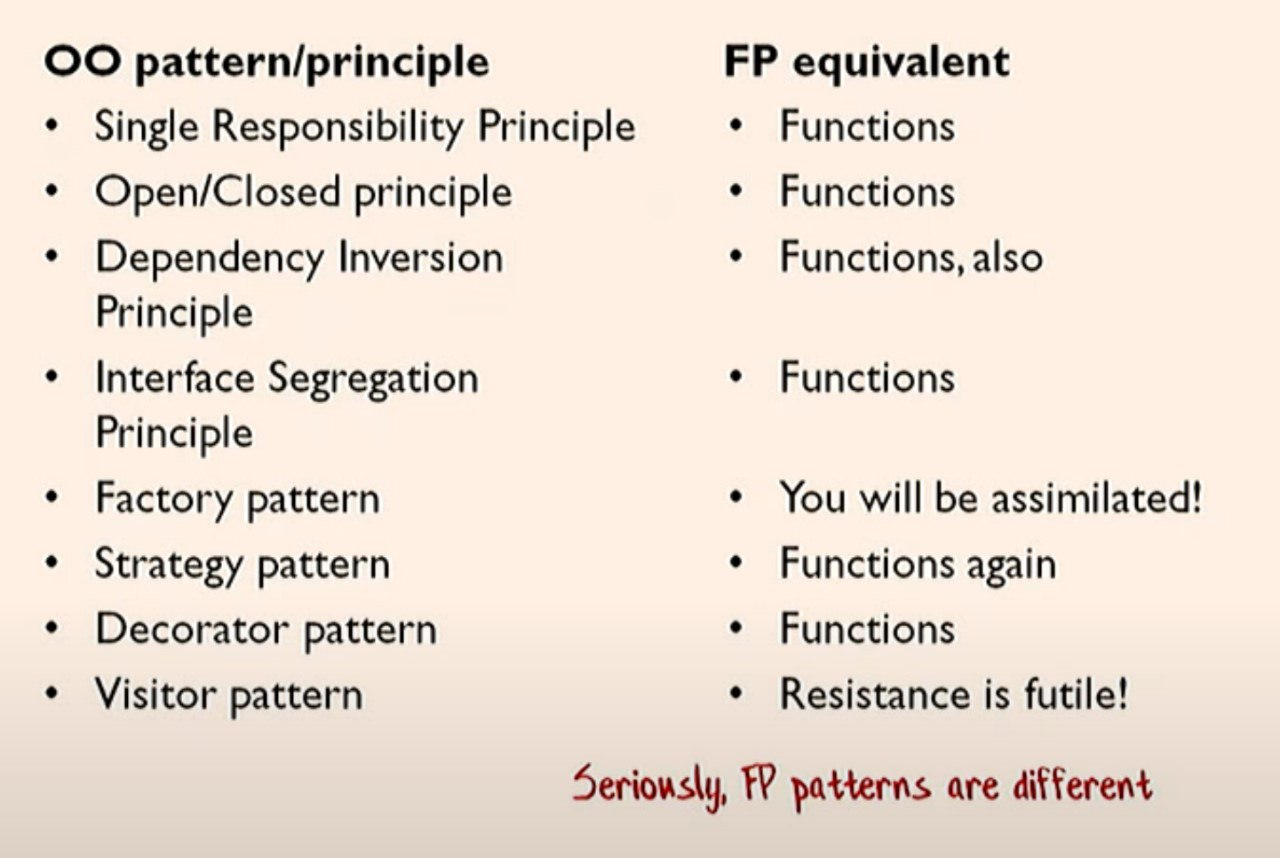

Нет, инкапсуляцию никто не отменял. Есть хороший доклад на тему ФП/ООП/Процедурщины, он довольно неплохо объясняет разницу между ними:

https://www.destroyallsoftware.com/talks/boundaries

Код кстати не какой-то хаскель/скала/идрис, а вполне приземлённый руби.

Очень рекомнедую глянуть, я для себя пару неожиданных вещей открыл.

По идее, чем больше параметров, тем сложнее. ООП стремится переложить большую часть сложности на этап создания объекта, и тем самым упростить интерфейс для конечных потребителей, уменьшая количество аргументов у метода до минимума. ФП, наоборот, оставляет потребителя разбираться с полным набором параметров самостоятельно. И в том и в другом подходе можно найти как свои преимущества, так и недостатки. Вот только практика показывает, что при попытке бездумно комбинировать разные подходы, вместо профита, получаются одни проблемы. Мода на ФП в ООП языках привела к тому, что порой на код без слез смотреть невозможно.

Ну чем вот отличается инстансный метод который неявно получает this от (MonadReader MyContext m) который получает тот же самый this точно также из эмбиент контекста? На мой взгляд, совершенно ничем

А если вы просто «потребляете» чей-то там класс или библиотеку, хотите понять почему-то там что-то не работает и у вас нет исходников, то да это проблема. Но как бы access modifiers именно для того и придумали чтобы вы не видели того, что вам не хотят показывать.

знать, на какие методы мне гарантированно можно не смотреть.

это тоже можно отнести к «вопросам к вашей IDE». И я бы даже сказал что это и нужно к ним относить. То есть для меня это всё из категории «найди все места где эта функция/переменная используется» или «найди все реализации этого интерфейса».

Перефразирую: как не читая тела функции понять, что она может делать, а что — нет?

В классическом ООП ответ: никак, вот есть у тебя void Foo() и можно гадать до посинения что он там делает.

Или как пример в статье которую я писал: я баг засадил, когда поменял 2 строчки кода местами, потому что певрая строчка (как потом оказалось) меняла стейт, который использовался следующей строчкой, и всё поломалось. Но менялось оно на уровне вложенности в десяток методов, за чем я не уследил.

Неплохо было бы такое ловить не на проде, а видеть сразу.

Есть такой термин — параметричность. Очень полезная штука. Например, возьмем функцию с такой сигнатурой:

foo : a -> aну или если вам ML не нравится возьмем раст:

fn foo<T>(t: T) -> T { ... }Эта функция может сделать две вещи: либо никогда не вернуть управление (запаниковать, войти в бесконечный цикл, ...), либо возвращает свой аргумент. Из этой информации и имени функции можно понимать что она делает, не читая её тело. Более того, в достаточно продвинутых языках можно генерировать тело по сигнатуре. То есть типы — первичны, а уж реализация — вторична, и во многом типа задают, что принципиально может делать функция, а чего — нет.

Как бы вы не попытались реализовать эту функцию, вы можете её реализовать только таким образом что я сказал. Если только не попытаетесь очень очень сильно саботировать сигнатуру, но обычно разработчик старается решить задачу, а не сделать аналог

#define TRUE FALSE

Причём в достаточно прошаренном языке (который не разрешает просто так эксепшны бросать тут и там) вам даже IDE самостоятельно сможет сгенерировать эту самую единственную реализацию:

В реальности, конечно, часто выбор больше, но все равно множество разумных реализаций (исходя из названия функции, её аргументов и результата) очень и очень невелико, а часто состоит из всего 1 варианта

В реальности, конечно, часто выбор больше, но все равно множество разумных реализаций (исходя из названия функции, её аргументов и результата) очень и очень невелико, а часто состоит из всего 1 вариантаНе с вами ли вы обсуждали, совсем недавно, пример, где это было нифига не так?

Да, теоретически можно придумать язык, где типы полностью опишут вам функцию — но в этом случае они сами уже станут более сложными, чем написание функции на «классических» языках.

Сложность должна где-то жить, это, увы банальная истина.

P.S. Это не отменяет, конечно, того факта, что передача данных из одной функции в другую через

this — это, в большинстве случаев, плохая идея. Я, как правило, рассматриваю функции, нарушающие, временно, инварианты объекты, в котором эти функции живут, скорее средством оптимизации, которое можно применять, если потеря читаемости не слишком важна.Да, теоретически можно придумать язык, где типы полностью опишут вам функцию — но в этом случае они сами уже станут более сложными, чем написание функции на «классических» языках.

Вам не обязательно нужен язык, где тип полностью описывает всё, что происходит внутри, хотя и это неплохо, достаточно чтобы комбинация имя функции + типы позволяли с высокой точностью определять, что она может делать и примерно, как именно.

Например, если бы я увидел вызов пары функций в монаде State мне бы в голову не пришло поменять их местами, не проверив, что ничего не поломалось. А в шарпе я в зимой такую ошибку совершил. Хотя там понятно почему так получилось: я проверил всего лишь два десятка функций на 3-4 уровня по коллстеку, а нужно было заглянуть на 8 функций внутрь чтобы увидеть что там стейт мутируется.

Я, как правило, рассматриваю функции, нарушающие, временно, инварианты объекты, в котором эти функции живут, скорее средством оптимизации, которое можно применять, если потеря читаемости не слишком важна.

В тех самых языках про которые я говорю для этого есть монада ST — которая гарантирует, что вся грязь не вылезает из скоупа и в итоге всегда возвращает объект в валидное состояние.

Из этой информации и имени функции можно понимать что она делает, не читая её тело.

Но я правильно понимаю что такая функция «имеет доступ» исключительно к своим параметрам и всё? И скажем «внутри» у неё в принципе не может быть скажем доступа к какой-то базе данных или стороннему сервису? Или в ней тоже как-то описывается что она с ними делает и это можно понять не читая тело самой функции?

Правильно, в ней не может быть никаких хождений в БД, запросов по сети, доступа к какому-либо неявному стейту и так далее.

если оно в фунцкии нужно то оно выглядит примерно как

foo : (MonadHttp m, SqlBackend m) => UserId -> m User

foo = ...Ну если мне нужна такая детализация, я могу дальше уочнить, например SqlReadonlyBackend m или UserRepository m, ну и так далее.

Но обычно достаточно разграничивать функции по принципу: лезет в сеть/нет, лезет в бд/нет, может возвращать ошибку/нет, может вернуть нулл/нет, работает со стейтом/нет, пишет в консоль/нет, ...

Ну если мне нужна такая детализация

Дело не в детализации, а в том что там конкретно делается. Вы знаете что конкретно ваша фунцкия запишет в UserRepository не читая её тело?

я могу дальше уочнить, например SqlReadonlyBackend m или UserRepository m, ну и так далее.

Вот именно «я могу». А кто-то может так и не делать. Ну то есть получите вы библиотеку от человека, который «не смог» и вместо UserRepository запихал в параметры весь SqlBackend. И дальше что?

То есть вот эти ваши «я могу» это уже на мой взгляд начинаются code conventions. А их и в ООП никто не отменял.

Дело не в детализации, а в том что там конкретно делается. Вы знаете что конкретно ваша фунцкия запишет в UserRepository не читая её тело?

Знаю, одно из нескольких действий которые есть в репозитории.

Вот именно «я могу». А кто-то может так и не делать. Ну то есть получите вы библиотеку от человека, который «не смог» и вместо UserRepository запихал в параметры весь SqlBackend. И дальше что?

Если по задаче нужна была такая детализация — то это примерно как использовать string везде и парсить в int по месту — можно, но обычо так стараются не писать.

То есть вот эти ваши «я могу» это уже на мой взгляд начинаются code conventions. А их и в ООП никто не отменял.

Как в мейнстрим ООП языках отличить функцию которая ходит в БД от функции которая этого не делает?

Знаю, одно из нескольких действий которые есть в репозитории.

Какой конкретно контент будет туда записан? Ну вот у вас есть функция, которая получает строку и репозиторий. Вы не читая тело функции можете понять записывает она туда строку один в один или перед этим её как-то модифицирует?

Как в мейнстрим ООП языках отличить функцию которая ходит в БД от функции которая этого не делает?

А как в вашем примере отличить в какой репозиторй пишет функция получающая как параметер SqlBackend и пишет она туда или только читает?

То есть я понимаю что вы мне хотите сказать и вижу какие преимущества даёт такой подход. Но он всё равно не избавляет вас от необходимости читать тело функции. Он максимум облегчает вам это. Но такого облегчения при желании можно добиться и другими путями. В том числе и в ООП. Например установив определённые конвенции и придерживаясь их.

Какой конкретно контент будет туда записан? Ну вот у вас есть функция, которая получает строку и репозиторий. Вы не читая тело функции можете понять записывает она туда строку один в один или перед этим её как-то модифицирует?

Ну если написано так:

foo : (UserRepository m) =>

(str : String) -> m (WriteResult m str)то значит, что использовалась та самая строка, что передана, без модификаций. Правда, такой уровень детализации в типах мне кажется излишним.

То есть я понимаю что вы мне хотите сказать и вижу какие преимущества даёт такой подход. Но он всё равно не избавляет вас от необходимости читать тело функции. Он максимум облегчает вам это. Но такого облегчения при желании можно добиться и другими путями. В том числе и в ООП. Например установив определённые конвенции и придерживаясь их.

Ну если я увижу функцию

addUser : (UserRepository m) -> UserName -> UserPassword -> m ()То я не буду читать её тело, я просто предположу то, что может любой разумный человек: что функция берет и пишет в БД юзера вот с такими параметрами. Причем пишет в БД, а не по сети, в эластик, в файл или ещё куда-то

Ну если написано так:

Я честно говоря вот так на первый взгляд не могу со 100% уверенностью понять что функция WriteResult только пишет и больше ничего не делает. То есть может я синтаксис не особо хорошо понимаю, но из чего это должно следовать?

Ну если я увижу функцию.

…

То я не буду читать её тело, я просто предположу то, что может любой разумный человек: что функция берет и пишет в БД юзера вот с такими параметрами.

Ну так и если я увижу функцию

UserRepository.AddUser(userName, userPassword)то предположу тоже самое. И чем мои предположения хуже ваших? :)

Я честно говоря вот так на первый взгляд не могу со 100% уверенностью понять что функция WriteResult только пишет и больше ничего не делает. То есть может я синтаксис не особо хорошо понимаю, но из чего это должно следовать?

из связи результата и входного параметра.

то предположу тоже самое. И чем мои предположения хуже ваших? :)

Да нет, просто я вот например не вижу:

- есть какое-то логгирование в этом AddUser или нет?

- она может завершиться с ошибкой или нет?

- а она чистая или нет, мы меняем какой-то стейт самого UserRepository (может, кэши какие-то)?

- ...

То есть тут вопрос в том, какие предположения мы достоверно можем отмести

из связи результата и входного параметра.

А как будет выглядеть эта связь если WriteResult ещё что-то делает кроме как писать? Как мне понять что произойдёт если result по каким-то там причинам не сможет быть записан в бд? Например если он в неправильном формате?

есть какое-то логгирование в этом AddUser или нет?

…

а она чистая или нет, мы меняем какой-то стейт самого UserRepository (может, кэши какие-то)?

Пониемаете, я вот лично в 99,999% cлучаев даже не хочу это знать. И по вашему получатся что ради того самого 0,001% я должен каждый раз передавать мой логгер/кэш в параметрах. Мне лично это менее удобно и создаёт больше проблем чем решает.

она может завершиться с ошибкой или нет?

Это вообще к ООП отношения не имеет. В той же Java есть вот такое

public void init() throws CustoмException

{

}А как будет выглядеть эта связь если WriteResult ещё что-то делает кроме как писать? Как мне понять что произойдёт если result по каким-то там причинам не сможет быть записан в бд? Например если он в неправильном формате?

Если в сигнатуре этого нет, значит запись не может завершиться неуспешно. А учитывая, что в реальности БД всегда может поломаться, можно сделать вывод что это сигнатура описывает in-memory базу :) И Этот вывод мы смогли сделать просто из сигнатуры, ну потому что не бывает физической БД которая никогда не падает при записи.

Пониемаете, я вот лично в 99,999% cлучаев даже не хочу это знать. И по вашему получатся что ради того самого 0,001% я должен каждый раз передавать мой логгер/кэш в параметрах. Мне лично это менее удобно и создаёт больше проблем чем решает.

А у меня получается, что очень часто это нужно знать. А то был у меня например случай, когда я безобидную функцию вида int x = Sqr(otherInt) написал в цикле, а у меня упал эластик, потому что в него триллион логов посыпалось. Ну или многострадальный пример когда я поменял 2 строчки, и тоже на проде взорвалось в другом месте. Это далеко не 0.001%

Это вообще к ООП отношения не имеет. В той же Java есть вот такое

алгебраические эффекты сильно сложнее чем чекед эксепшны, именно поэтому последние не получили распространения. Но да, это один из примеров, когда из сигнатуры видно, что функция может упасть (или нет). Но в ваша функция AddUser разве так написана?

А учитывая, что в реальности БД всегда может поломаться, можно сделать вывод что это сигнатура описывает in-memory базу:

Угу. А если у меня работа с чем-то о чём я не знаю может оно там поломаться или нет? Гадать? Или лезть в тело функции и разбираться?

И мне всё ещё интересно как будет выглядеть сигнатура у функции, которая каким-либо образом модифицирует содержание прежде чем записать его куда-то?

А у меня получается, что очень часто это нужно знать. А то был у меня например случай, когда я безобидную функцию вида int x = Sqr(otherInt) написал в цикле, а у меня упал эластик, потому что в него триллион логов посыпалось.

А Sqr(otherInt) это ваша функция или чужая? Если ваша, то вы извините, но выяснить пишет она там что-то в логи или нет, так это и в ООП не особо большая проблема. Да, в вашем варианте круг поисков будет поуже, но на мой вгляд это не особо-то и критично.

А если это чужая функция, то откуда она знает как в ваш эластик писать?

Но в ваша функция AddUser разве так написана?

Ну так ещё раз: это не зависит от ООП или не ООП. В некоторых языках такое указывать нельзя, в других можно, в третьих обязательно.

Да и вообще в теории вы и ООП язык наверное можете создать в котором надо будет указывать контекст, который может использовать функция. только подозреваю что это опять же мало кому надо.

Угу. А если у меня работа с чем-то о чём я не знаю может оно там поломаться или нет? Гадать? Или лезть в тело функции и разбираться?

И мне всё ещё интересно как будет выглядеть сигнатура у функции, которая каким-либо образом модифицирует содержание прежде чем записать его куда-то?

Придется для этого обёртку сделать, но ничего невозможного нет. В типах там будет указано, что результат — то же значение, что мы передали. Дальше при желании пишутся пара теорем, что резульатт действительно такой как мы ожидаем (ну, вместо тестов) и порядок.

Но обычно так заморчиваться не надо, геморроя много, а толку — не очень.

А Sqr(otherInt) это ваша функция или чужая? Если ваша, то вы извините, но выяснить пишет она там что-то в логи или нет, так это и в ООП не особо большая проблема. Да, в вашем варианте круг поисков будет поуже, но на мой вгляд это не особо-то и критично.

Ну, где-то в решение она объявлена, в сигнатуре ничего про логи не написано, принимает инт, возвращает инт.

Да и вообще в теории вы и ООП язык наверное можете создать в котором надо будет указывать контекст, который может использовать функция. только подозреваю что это опять же мало кому надо.

Я про практические языки которые есть на рынке: джава, шарп, хаскель,… То что можно сделать химеру — это конечно никто не спорит, только её нет. А говорить о несуществующем не вижу большого смысла.

Но обычно так заморчиваться не надо, геморроя много, а толку — не очень.

То есть получается что цена вопроса это субъективное понимание «геморроя» и «толка». И если кто-то, как например я, считатает что вся эта овчинка в принципе выделки не стоит, то получается что и ООП не проблема? :)

Ну, где-то в решение она объявлена, в сигнатуре ничего про логи не написано, принимает инт, возвращает инт.

И как долго вам пришлось выяснять что она всё-таки пишет логи? :)

Я про практические языки которые есть на рынке: джава, шарп, хаскель,…

Я бы сказал что на это просто нет достаточного спроса. Если бы он действительно был, то и ЯП бы быстро появились.

И как долго вам пришлось выяснять что она всё-таки пишет логи? :)

Да сразу узнал, когда мне написали, что эластик уронился после такого-то коммита.

Я бы сказал что на это просто нет достаточного спроса. Если бы он действительно был, то и ЯП бы быстро появились.

На то чтобы такое было в ООП языках — безусловно. Потому что эффекты или должны быть, или нет. Если они есть, то никакой нуллябельности по-умолчанию, экспепшнов по-умолчанию и так далее. Это, кстати, можно видеть в расте.

Но в существующих языках таких ломающих изменений конечно никогда не будет. А в новых оно понемногу появляется: Раст, Котлин, Свифт, ...

А так да, определённые вещи однозначно проще реализовывать при помощи ООП, а некоторые удобнее при помощи ФП. И поэтому скорее всего их начнут использовать параллельно. Например тот же дотнет вполне себе позволяет «миксить» C# и F#. Пока ещё не особо удобно, но надеюсь что со временем сделают получше.

Понимаете, если разбить ООП и ФП по фичам (в смысле, популярные языки), то окажется, что Java это A,B,C,D,

шарп это A,B,C,E,F,G, а какой-нибудь хаскель это B,C,F,G,H,I,G,K,L,M. Если нарисовать диаграммки Венна, то окажется что они практически пересекаются. Но в этих нюансах и кроется основное различие. И под ООП лично я по крайней мере понимаю те компоненты, которые свойствены Java/C#/..., но не свойствены Haskell/Scala/..., в примере выше это A и E.

Поэтому мне кажется, что все разговоры про смерть ФП или ООП от неоднозначной формулировке: кто-то под ООП подразумевает объединение всех ООП языков, а кто-то наоборот — пересечение с исключением всего что есть в не-ООП языках.

Как я писал в статье, я расцениваю ФП как подход с единственным правилом "Пиши ссылочно прозрачные (ака чистые) функции". Всё, если у вас код на 100% соблюдает эт оправило, то код — фп, а если нет — то нет. При этом, будет там иерархия классов, иок контейнер или ещё что-то уже совершенно не важно. И я считаю, что этот подход просто строго лучше чем альтернатива. Ну примерно как то, что концепция "функций" строго удобнее для людей чем лонг джамп или что понятие переменной человеком воспринимается проще чем регистр.

Сколькими способами можно например написать такую функцию?

fn: Int -> Int

Одним? Двумя?… Миллиардом?

Когда вам надоест писать метакод, и вы спуститесь на уровень пониже, то увидите, сколько вариантов может генерировать одна настоящая функция.

При чем тут метауровень? Это чисто параметричность — то что функция не зависит от аргумента. Именно поэтому обобщённые функции это круто — не только потому, что мы исключаем копипасту, но и потому, что мы по игнатуре видем, что может с объектами делать функция, а чего — нет.

Сколькими способами можно например написать такую функцию?

fn: Int -> Int

Одним? Двумя?… Миллиардом?

(2^32)^(2^32) — количество обитателей легко считается. Общая формула: a -> b имеет b^a обитателей.

Ну так когда мы можем понять РЕАЛИЗАЦИЮ по СИГНАТУРЕ — это и есть IoC, у нас реализация зависит от абстракции (ака сигнатуре), разве нет?). И плохо, когда работает наоборот: посигнатуре вроде мы имеем право работать, но вот нужно посмотреть реализацию и понять, что на самом деле вот так можно делать, а вот так — нельзя.

Ну так когда мы можем понять РЕАЛИЗАЦИЮ по СИГНАТУРЕ — это и есть IoC, у нас реализация зависит от абстракции (ака сигнатуре), разве нет?).

Я всё ещё не понимаю как вы там по сигнатуре угадываете конкретную реализацию? Вот есть у меня функция

int DoSomething(int x, int y);

как мне по одной только сигнатуре понять складывает она там или умножает? Или вообще что-то третье делает?

И плохо, когда работает наоборот: посигнатуре вроде мы имеем право работать, но вот нужно посмотреть реализацию и понять, что на самом деле вот так можно делать, а вот так — нельзя.

Вам всегда придётся куда-то смотреть как можно делать и как нельзя. Эта информация где-то должа быть записана. И я не вижу принципиальной разницы записана она в теле метода, в описании типа/класса, в какой-то аннотации или даже в форматe вызова функции.

По сигнатуре с конкретными типами почти никогда ничего сказать нельзя.

А вот сигнатура с генериками — совсем наоборот, очень редко когда нельзя сказать что она делает. Например функция:

fn T do_something<T,U>(T x, U y)

всегда возвращает первый аргумент и игнорирует второй (если не зависает паникой или ещё как).

Хотя в шарпе параметричность ломается с помощью typeof, это конечно очень жаль.

Или скажем как быть если внутри выполняется "(х + у) * (х-у) + (х +х)*(у * 42)… "?

Ну вы можете всё тело функции запихнуть так или иначев сигнатуру. Будет у вас тип AddXAndYMultipledByXMinusYPlusDoubleXMultYAnd42 — оно вам нужно? В чем смысл этих расспросов? Давайте я буду у вас спрашивать как что-нибудь в другом языке делается? Это уже переходит рамки приличия.

Будет у вас тип AddXAndYMultipledByXMinusYPlusDoubleXMultYAnd42

Т. е., чтобы добиться нужного уровня информативности (кажется все началось с необходимости понять, что происходит внутри метода, не заглядывая внутрь), надо второй раз «метаданными» написать реализацию метода?

Например, собрать рядом Expression, а в методе его скомпилить и выполнить — тоже нужно смотреть вне метода, чтобы понять, что он выполнит.

Не уходите, как раз к самому интересному подошли(=

Т. е., чтобы добиться нужного уровня информативности (кажется все началось с необходимости понять, что происходит внутри метода, не заглядывая внутрь), надо второй раз «метаданными» написать реализацию метода?

Да.

Поэтому так никто и не делает.

Но между "продублировать тело в сигнатуре" и "void Foo()" есть куча градаций. И золотая середина мне нравится куда больше, чем ни к чему не обязывающие сигнатуры мейнстрим языков.

И для того чтобы понять что делает функция foo : a -> a не нужны никакие сложные типы и дублирование тела в сигнатуре. Перефразируя, парметричность говорит что чем более абстрактная функция, тем меньше множество возможных её реализаций. А значит тем больше надежность и лучше работает интуиция, что функция может делать, а чего — нет.

И под "что может делать функция" я имею в виду не дословно расписать по шагам, что она делает, а класс, к которому функция относится, с той или иной степенью детализации. Я выше уже писал про "или нет", это всё про это.

Ну вот простой пример пусть будет функция:

bar : [a] -> [a]

bar xs = ...Я не знаю, как эта функция устроена, но я могу не глядя в реализацию сказать, что функция принимает список и возвращает список, причем результирующий список всегда состоит из элементов входного списка (повторяющихся 0..n раз, и возможно в другом порядке). Причем в случае раста это утверждение ещё строже: это элементы исходного списка, причем они повторяются не более одного раза (но некоторые могут в результате отсутствовать, вплоть до пустого списка). Часто этой информации мне будет достаточно, чтобы понять, как эту функцию вызывать и что делать с результатом.

Возможно кажется, что это всё бесполезные разглагольствования, но на самом деле это экономит часы и в итоге дни на отладку.

Перефразирую: как не читая тела функции понять, что она может делать, а что — нет?

Вот я всё и пытаюсь понять как такое должно работать. И получается что работает такое в ФП только если кто-то был настолько добр что поместил тело функции в сигнатуру. Что по вашим же словам обычно всё равно никто не делает. Плюс это самое тело функции вам всё равно надо читать, но просто в другом месте.

То есть бенефит от всего этого есть, но пожалуй только для не особо сложных функций. А если функция более-менее сложная, то вам и в ФП всё равно придётся лезть в её «тело» и разбираться уже там. Но взамен у вас сигнатуры заметно сильнее разбухают…

P.S.Ну или вот напишу я вам какой-нибудь, автодок, который автоматом копипэйстит тело функции в её комментарии. И сможете вы в ООП точно так же «понимать что делает функция не читая её тела».

P.P.S. И самое главное получается что каждый раз когда я буду менять реализацию своей функции, я должен буду менять её сигнатуру чтобы люди могли «понимать что она делает не читая её тела». И будет у меня при каждом багфиксе изменение сигнатур у каждого метода, который я хоть как-то тронул. Не сказал бы что такой вариант меня сильно радует…

То есть бенефит от всего этого есть, но пожалуй только для не особо сложных функций. А если функция более-менее сложная, то вам и в ФП всё равно придётся лезть в её «тело» и разбираться уже там. Но взамен у вас сигнатуры заметно сильнее разбухают…

Чем сложнее функция, тем наборот проще, потому что каждый констрейнт дает информацию о том, что она делает. По 3-4 консстрейнтам уже можно практически точно сказать, что делает функция.

P.S.Ну или вот напишу я вам какой-нибудь, автодок, который автоматом копипэйстит тело функции в её комментарии. И сможете вы в ООП точно так же «понимать что делает функция не читая её тела».

А этот комментарий будет проверяться компилятором? Например, что сложение не реализовано как вычитание? Раз уж доходит до абсурда

P.P.S. И самое главное получается что каждый раз когда я буду менять реализацию своей функции, я должен буду менять её сигнатуру чтобы люди могли «понимать что она делает не читая её тела». И будет у меня при каждом багфиксе изменение сигнатур у каждого метода, который я хоть как-то тронул. Не сказал бы что такой вариант меня сильно радует…

А ещё если смените String на Int то тоже код ломается, вот грустно. А у питонистов отлично — просто начал использовать переменную как число и ничего не поломалось. Красота.

Чем сложнее функция, тем наборот проще, потому что каждый констрейнт дает информацию о том, что она делает. По 3-4 консстрейнтам уже можно практически точно сказать, что делает функция.

Я бы сказал что они скорее дают информацию о том что она в принципе не может делать и таким образом сужают «область поиска». Это полезно, но «покупается» за счёт «разбухающих сигнатур».

А этот комментарий будет проверяться компилятором? Например, что сложение не реализовано как вычитание? Раз уж доходит до абсурда

Проверяться не будет. Но я могу написать это таким образом что комментарий всегда будет один в один выглядеть как тело функции. И если функция не компилируется, то и комментария не будет. Но да, это я дoлжен проявить желание такое сделать и заставить меня вы не можете. Как впрочем и в ФП вы не можете никого заставить писать грамотные сигнатуры.

А ещё если смените String на Int то тоже код ломается, вот грустно.

Да, ломается. Но по моему опыту в «ООП языках» тело функции меняется гораздо чаще чем её сигнатура. И как раз таки смена сигнатур это обычно breaking changes и этого стараются по возможности избегать.

Я бы сказал что они скорее дают информацию о том что она в принципе не может делать и таким образом сужают «область поиска». Это полезно, но «покупается» за счёт «разбухающих сигнатур».

Ну они не сильно-то разбухают. Особенно в наш век IDE

Проверяться не будет. Но я могу написать это таким образом что комментарий всегда будет один в один выглядеть как тело функции. И если функция не компилируется, то и комментария не будет.

Это не поможет, по той же причине почему копирования тела в динамическом япе не заменит типизации.

Да, ломается. Но по моему опыту в «ООП языках» тело функции меняется гораздо чаще чем её сигнатура. И как раз таки смена сигнатур это обычно breaking changes и этого стараются по возможности избегать.

В данном случае, изменение сигнатуры это изменение требований. И я лучше получу ломающее изменение, чем человек молча напишет default(T) внутри тела, не меняя функцию, и у меня потом будет поломка из-за 0/null (был прецедент)

А у питонистов отлично — просто начал использовать переменную как число и ничего не поломалось.Вы python и javascript/php не перепутали? Это в javascript/php можно сравнивать всё со всем и в результате нет тразитивности ни у ==, ни ну <

Для меня это выглядит сомнительно, потому что на моем личном опыте те ошибки, которые я чаще всего встречал, были вызваны именно ошибками в семантике, а не в типах. Неправильный формат сообщения, забытый вызов метода внешнего окружения, неправильный алгоритм подсчёта, и тд.

Всё это можно и нужно проверять типами. Типизированная форматирующая строка это вообще один из примеров для начинающих идрисистов. Ну и немного теории если есть сомнения.

C. И в 99% случаев действительно мне либо вообще не интересно знать, что делает компонент, либо я закладываю, что каждый мой код работает с 5-10 реализациями одного интерфейса, и если я даже сделаю интерфейс типа Add, чтобы по сигнатуре догадываться, что там может быть только сложение чисел, у меня остальные 9 реализаций скажут «А нам то что делать? У нас не сложение используется». Сделать в сигнатуре разрешение на сложение, вычитание, умножение, деление, чтобы можно было все нужные кейсы покрыть? Сигнатура становится монстроуозной, а по ней уже не скажешь, что конкретно она делает. Сомневаюсь, что даже на языках с навороченной системой типов можно описать, как происходит алгоритм расчёта, какие числа и в какой последовательности мы используем операторы, а именно в этом чаще всего я встречал косяки.

Есть понятие разумного уточнения. Конечно отдельно редко пишут сложить-вычесть, но например можно наложить ограничение Num — то есть всё, что умеет в основные 4 арифметических операций. Коротко и понятно. Если нужны ещё более абстрактные вещи можно объединить, и так далее.

Никто же не расстраивается, что List в сишарпе реализует пару десятков интерфейсов?

Мне кажется, в этом и прелесть ООП, что в нем класс не берет на себя дополнительную обязанность знать, что и как делает его зависимость.

Как раз ООП более ограниченное. Если у вас есть синхронный метод вы в наследнике не сможете сделать его асинхронным никак. Потому что сигнатура жестко фиксируется родителем.

Назовите мне хоть одну систему или свод правил, которая бы смогла запретить безалаберному человеку или вредителю делать его дело плохо.

Система типов любого мейнстрим языка запрещает передавать строчки вместо чисел или вызывать у объектов несущестующие методы, за счёт чего ликвидирует класс ошибок связанных с этим.

А если человек адекватный, то даже в языке без nullable можно сделать себе жизнь комфортной простой договоренностью.

Нет

Я не про нарушение форматирования строки, я про то, что сторонний сервис ждет, условно, одной строки, а человек по ошибке отправляет другую. По вашей ссылке, насколько я понимаю, о другом идет речь.

Ну, всё в типы не запихнуть, не спорю. Но б0льшая часть ошибок что у людей встречаются типами ловится. Например, из недавноего когда игра провалилась, а через год разработчики обнаружили, что в скрипте поведения ИИ опечатка из-за чего он просто не работал по факту. Починили и игра сразу стала интересной! Но поезд ушел.

Разыменование нуллов, неправильные контракты, поздняя валидация десериализованных данных, дедлоки и остальное — основные проблемы, и для всех них есть решение.

В вашем предыдущем сообщении речь шла о понимании, что происходит внутри метода. У метода в аргументах 2 Num, на выходе один, что он конкретно делает, сказать точно уже нельзя, потому что это не Add, над которым можно проводить только одну операцию.

Ну я знаю, что над аргументами происходит арифметическая операция. Когда я говорю "я понимаю что делает функция" это не значит, что я с закрытыми глазами опишу как она выполняется, а то, что чтобы понять как её использовать мне не надо лезть глубже сигнатуры.

Выглядит как попытка экстраполировать свой частный опыт на всех. Если у вас не вышло, то это не значит, что у других людей не получается.

Кроме вашего кода есть ещё код коллег, а ещё библиотеки и фреймворки которые не обязательно вашим договоренностям следуют (а скорее — как правило не следуют). А ещё люди ошибаются. Я уж точно.

И как это ограничение мешает писать говнокод? По-прежнему в такой системе тонны способов написать что-то медленное, затрачивающее тонны ресурсов, приводящее к падению приложения, трудночитаемое, неподдерживаемое, ошибочно написанное и т.д.

Я говорю про то что у вас нет ошибок "'number' doesn't have property 'length'", а не то что это сильвербулет.

Я не знаю, в каком языке можно унаследоваться/обернуть синхронный объект/метод с сохранением сигнатуры и сделать его асинхронным.

Любой язык с типами высших порядков. Скала, как пример.

Вот я о том и говорил, что все системой типов не покрыть, только простые вещи типа передачи строки вместо числа

Нет, это была аналогия. Насколько система типов мейнстрим языка лучше бестиповых скриптов, настолько же продвинута система типов помогает по сравнению с ней.

От мелочей вроде форматирующей строки заканчивая тайпсейф многопоток и типизированных конечных автоматов (где переход в неправильное состояние — ошибка компиляции). А как вы наверное знаете, довольно много всяких бузинес-правил можно выразить как КА.

Всё конечно покрыть нельзя, но можно в разы больше того, что люди делают.

И как это выглядит? Я просто такого ни разу не встречал.

trait MyInterface[Self]:

type F[A]

def (item: Self) getSomething() (using Monad[F]): F[Int]

class SyncInterface

class AsyncInterface

given syncInstance as MyInterface[SyncInterface]:

type F[A] = Id[A]

def (item: SyncInterface) getSomething()(using Monad[Id]): Id[Int] = 42

given asyncInstance as MyInterface[AsyncInterface]:

type F[A] = IO[A]

def (item: AsyncInterface) getSomething()(using Monad[IO]): IO[Int] = () => 42 Я использую в качестве затычки IO который просто синхронный коллбек, но на самом деле там должно быть что-то из библиотеки cats, например вот это: https://typelevel.org/cats-effect/typeclasses/async.html

Работать будет точно так же как и пример.

Про продвинутую систему типов не знаю, почему-то пока что я не настолько сильно замечаю, что с переходом от того же Objective-C к Swift, где система типов гораздо сильнее, у меня резко уменьшилось количество ошибок. Но видимо это разнится от человека к человеку.

Кроме продвинутой системы типов ещё некоторое значение имеет прокладка между монитором и креслом :)

Ни один самый продвинутый инструмент не работает сам по себе. Программист на фортране может писать на фортране на любом языке программирования

По поводу примера, я так понимаю, тут просто создаётся ещё одна функция, которая оборачивает вызов синхронной функции и возвращает его в лямбде? Если так, то что мешает в том же ООП сделать интерфейс с асинхронным методом, реализовать класс с ним, а внутри вызывать объект с синхронным методом?

Но это будет не то же самое. В случае выше у вас две реализации имуют типы Id[A] и IO[A], ну или Sync<T> и Async<T> соответственно. А третья реализация может например возвращать Option — тоже полезный кейс.

А возвращать асинхронный метод часто плохо, например в расте чтобы выполнить асинхронный метод нужен явный рантайм, там нет подковёрного неявного тредпула где можно втихую задачи бросать. А значит если библиотека требует асинка то она сразу требует +50 зависимостей, что не очень.

Ну и если посмотреть на это философски, то это все равно что у вас есть две реализации функции, одна должна возвращать число, а другая — строку, и вы делаете общий тип — строку, а ту которая возвращает число вы просто пишете как myint.toString(). Можно ли так сделать? Да, строки более "Общие" чем числа (как асинк более общий, чем синк). Но тут во-первых эстетически это грязь, а во-вторых вам нужно теперь помнить, где числа а где нет, чтобы знать, когда в число парсить (нам ведь нужно это число где-то получить, правда?). В случае асинка это означает, что мы должны помнить, когда можно заблокироваться, а когда нельзя, или везде писать асинк-авейт, даже там, где мы передали реализацию которая на самом деле синхронная.

Ну и наконец, писать Task.FromResult/Promise.resolve на каждый чих утомляет.

Вот я о том же) Eсли человек и его команда хотят облегчить себе жизнь, то можно ведь выработать определенные правила, например, для работы с теми же опциональными значениями. Человек + тот же код ревью будут заменять собой правила компилятора, не 100% идеально конечно, но и не на уровне пустой траты времени, и к этому еще и смогут когда нужно это игнорировать, если это требует ситуация, без сложной возни с системой ограничений языка.

Тем не менее, ни с какими договоренностями я не видел чтобы люди избавились от nullref exception. И атрибуты вешали, и договаривались называть TryXXX если нулл может вернутся — все равно не помогало. А вот с Option явным такого не случается.

Не совсем наверное понимаю суть различия. Вот у нас есть некий

Ну так ваш completion очень похож на TaskCompletionSource (ну или Promise.resolve из жс), тот же асинк, только в профиль.

А если вы пользуетесь разными интерфейсами, то это как-то другой пример. Я приводил пример как написать один интерфейс, и у него будет один наследник синхронный, другой асинхронный, а третий, например, синхронный, но с возможностью сообщить явно об ошибке.

С одним интерфейсом вы можете писать код, который работает как для синронных, так и для асинхронных вариантов. В вашем случае вы можете или с A работать, или с B, но вы не можете написать одну функцию которая работает как с А, так и с B одинаково.

Мне кажется, что и в языках с убер типизацией люди никуда не ушли от багов. Количество поуменьшилось, но все равно есть + добавились другие проблемы, увеличение времени сборки, сложный обход системы типов, если нужно в каком-то случае что-то подкрутить, прочее. Не знаю точно, но ощущение такое есть) Или действительно с той же Scala баги практически исчезли?

Programming Defeatism: No technique will remove all bugs, so let's go with what worked in the 70s.

Понятно, что всех багов не исправить. Но сидеть со старыми инструментами все равно как-то неправильно.

И да, целые классы багов ушли. Я вот не припомню ни одного memory-safety бага в сишарп проектах на которых я был. Совпадение?

Не спорю, просто хотел понять фразу про «ограничение в ООП». Если в ООП тоже можно превратить синхронный вызов метода в асинхронный, то в чем его ограниченность?

Ну смотрите, в примере выше я могу взять MyInterface и написать функцию которая, например результат на два умножает. В вашем случае у вас есть два интерфейса A и B, и нет общего MyInterface, и такую функцию написать не получится.

Добавление типизации в той же Java решило много проблем в сравнении с JavaScript и незначительно усложнило язык, а вот дополнительное наращивание типизации для меня выглядит так, что мы больше усложняем себе жизнь новыми ключевыми словами, ограничениями с выводом типов, нюансами при работе с типами, чем решаем насущных проблем.

Нет, это классический парадокс блаба: вы знаете Java поэтому смотрите на JavaScript сверху вниз и видите, как фичи джавы помогают. А когда вы смотрите "Наверх", то выидите "странные языки", которые возможно такие же мощные как джава, но с какими-то странными прибабахами и сложностями на ровном месте. И зачем?! Ведь я знаю, как то же самое сделать на джаве, где ничего этого нет.

Это решается только кругозором. Ну или не решается, и человек до конца жизни уверен, что нашел идеальный инструмент.

Можно, например, сделать у A дженерик для аргументов и результирующего значения, и у B тоже. Можно будет писать нужные реализации А для операций над T, строки, числа, и тд и тп. Единственному классу, реализующему асинхронную работу, будет без разницы, с какой именно реализацией А работать.

Ну это похоже на правду, за исключением того, что без типов высших порядоков вы не сможете написать такой генерик. Ну не выразить на сишарпе или джаве тип T<i32>, чтобы пользователь мог сам выбрать реализацию. Поэтому и не получится Sync<i32> или Async<i32> выбрать по месту.

Что до времени компиляции, то если вы не пишете тяп-ляп, то все те же инварианты нужно все равно проверять, но уже другими инструментами: тестами, куа-инженерами которые тыкают кейсы руками и так далее. И всё это на порядки медленнее самого тормознутого тайпчекера. Нет никаких предпосылок, почему именно джава идеал, убираем проверки — небезопасно, добавляем — тормоза.

Ну вообще я сначала писал на JavaScript, только потом начал на Java, затем на Objective-C, а потом перешёл на Swift с более навороченной системой типов, чем в Java. Но почему-то уровень типизации Objective-C/Java мне показался золотой серединой, чтобы и опечаток/ошибок с типами было по минимуму, и работать было по-прежнему комфортно. Более навороченные дженерики вроде и хорошо, но порой начинается война с тем, как объяснить компилятору своё намерение, если накрутил какой-нибудь абстрактный компонент.

Ну свифт не особо мощнее джавы, особенно учитывая Arc вместо полноценного гц, с ним может казаться даже менее высокоуровневым. Дальше по спектру это скорее всякие скала/хаскель, или Rust в стиле Томаки.

Но в целом я понял вашу идею, спасибо, что разъяснили про Scala и ваши взгляды на типизацию. С «ограниченностью ООП» холиварный был вброс, но не хочу его начинать, согласен разве что с тем, что в мейнстримовых языках подобные задачи решатся чуть большим количеством кода, но для меня это не ограничение парадигмы, а недоработка разработчиков языков, которые фокусируются на других вещах.

Про "ограниченность" я говорил в буквальном смысле: некоторые вещи не выразить, как концепцию. Можно работать без такой абстракции (в конце концов, всё в итоге компилируется в ассемблер, где таких абстракций нет, и часть этой трансляции можно выполнить руками), но такой абстракции — нет, нельзя сделать. И это не ругательство и разделение на "ограниченные" и "полноценные" япы а просто констатация факта — ну просто такую штуку выразить нельзя. Как в хаскелле нельзя выразить некоторые вещи которые можно в идрисе — ну просто язык не настолько расширяем чтобы это работало.

То есть я не ругал, а просто констатировал некоторое свойство некоторых существующих языков (но не парадкигмы как таковой, к слову).

Спасибо вам за дискуссию, мне было очень интересно узнать ваши взгляды. И спасибо за материал про типизацию форматирования строки, до этого я не знал, что под это подводят доказательную базу.

Взаимно, было приятно поболтать)

Как в хаскелле нельзя выразить некоторые вещи которые можно в идрисе — ну просто язык не настолько расширяем чтобы это работало.Тут есть ещё некая схожесть с тьюринговская трясиной.

Если в языке типы — это тьюринг-полный язык (как в C++ и, вроде бы, в Haskell), то на них, очевидно, можно выразить что угодно (в том числе всё, что умеет Idris тоже можно).

Однако практически — этим пользоваться, конечно, будет невозможно.

И то же самое случается часто с разными фичами, которые вроде как, предназначены для использования — но при этом пользоваться всем этим могут только единицы.

Хороший пример — метапрограммирование в C++. Появилось оно ещё в C++98 (причём оно в язык было не добавлено, а открыто… во время стандартизации этому уже внимание чуть-чуть уделили), однако «простые смертные» могут им пользоваться только начиная с C++17 — потому что только там есть такие вещи, как fold expression и constexpr if. С ними метапрограммирование начинает быть похожим на обычное программирование, в то время, как до того — у вас получался, плюс-минус, «типа-как-бы-Lisp-посреди-C++». Который «осиливали» немногие…

Так шаблоны это не типы, это именно что шаблоны, кодген по, собственно, шаблону. Можно ли сгенерировать что-то что будет тайпчекаться? Можно. Но это не типы, и удобство соответствующее.

Так шаблоны это не типы, это именно что шаблоны, кодген по, собственно, шаблону.Вы либо не в курсе того, что такое шаблоны в C++, либо передёргиваете. Вот какой-нибудь Maybe — это тип или нет? Ну, по крайней мере обычно считается, что да. А в C++ такая же, по сути, вещь — это шаблон. Только там была забавная фича — было разрешено делать специализацию для конкретного типа. Ну там, чтобы

optional<bool> сделать эффективнее чем с помощью стандартной схемы. Это сделало язык описания типов тьюринг-полным, что сразу же «приспособили к делу». В Haskell (ну… в GHC) есть полноценное метапрограммирование, так что это всё не очень нужно. А в C++ есть даже целые библиотеки, позволяющие на этом всём программировать…Maybe — тайплевел функция. В отличие от шаблона это полноценный объект.

Ну серьезно, в расте вы же легко можете отличить макрос от функции, пусть даже макрос гигиенический. Хотя их почти везде можно взаимозаменяемо использовать.

Шаблоны плюсов и макросы это абсолютно разные вещи.

Макросы си работают тупо на уровне текста, макросы раста на уровне AST, а шаблоны плюсов на уровне типов.

Например, std::optional<T> это полноценный тип. А вот my_macro!(T) это новый кусок кода который нельзя вставить никуда кроме корня файла.

Как соотносятся дженерики раста и шаблоны плюсов я ответить не могу. Пока внятных объяснений от местных теоретиков я тоже не видел :)

Макросы си

А я не про макросы в Си. Я про макросы в расте. Которые куда ближе к шаблонам, нежели что-то другое.

std::optional<T>Не знаю глубоко плюсов, но насколько я знаю, шаблоны это шаблоны, а не типы, они даже не чекаются если вы их не инстанцировали, а если инстанцировали то проверяется уже результат раскрытия, а не что-то другое. Это сильно отличается от понятия "типа".

насколько я знаю, шаблоны это шаблоны, а не типы, они даже не чекаются если вы их не инстанцировалиЧекаются-чекаются. Вот, например.

А вот так — уже нет.

а если инстанцировали то проверяется уже результат раскрытия, а не что-то другоеТаки чекается «что-то другое»: шаблоны могут в несколько этапов раскрываться и на каждом этапе чекается то, что не зависит от реализации шаблона. Собственно идея концептов (полноценных, который должны были быть в C++11, а не та версия, которая дожила до C++20) была как раз в том, чтобы они могли чекаться вообще на этапе объявления. Стали бы они в этом случае «полноценными типами» в вашем мире или нет?

В Haskell подобная конструкция называется полиморфными типами… и если честно, большой разницы я не вижу: точно также всё чекается когда вы вот это вот пытетесь из функции, оперирующей «неполиморфными» типами проверяется…

Typeable — это способ получать в рантайме информацию о типах, а полиморфизм генериков не имеет ничего общего с шаблонами. Вот сводная табличка от майкрософта: https://docs.microsoft.com/en-us/cpp/extensions/generics-and-templates-visual-cpp?view=vs-2019

И хотя она касается сишарпа, параметрический полиморфизм в хаскелле работает так же, пусть и чуть-чуть богаче с rank-2, type family, undecidable instances и прочими приколами.

Я тоже не специалист, но у меня есть ощущение что темплейты это такие тайплевел функции только на (условно) js, т.е. чекаются во время вызова (инстанциирования).

Хороший пример — метапрограммирование в C++. Появилось оно ещё в C++98 (причём оно в язык было не добавлено, а открыто… во время стандартизации этому уже внимание чуть-чуть уделили), однако «простые смертные» могут им пользоваться только начиная с C++17

Ну, не знаю… Я вот себя не считаю «небожителем», и с даже специалистом по C++, но вот template'ы и использовал, и свои писал ещё задолго до 2017 года.

Скорее всего тут дело в том, что это «метапрограммирование» в C++98 имело своего предшественника ещё в C — директиву препроцессора #define с параметрами. Которую мне тоже пришлось в свое время освоить, потому как использовалась она очень широко. Ну, а с template уже хотя бы некоторые вещи можно было делать по аналогии. Но некоторые другие (типа классов-функторов для STL) — таки да, пришлось осваивать.

Ну, а ещё эта аналогия и приобретенные ранее привычки очень помогали искать ошибки, которых тогда было в количестве — ибо в старых стандартах дозволялись многие вещи, которые потом, после разворачивания шалона, не компилировались с малопонятными ошибками.

Да, другие. В safe Rust внутри функции с такой сигнатурой у вас нет ни одной возможности получить валидное значение типа T кроме переданного x.

fn add<T: Add>(x: T, y: T) -> TА почему мы не можем создать и вернуть пустой Т, нужен DefaultConstructible трейт?

Да, если для T не задано констрейнтов мы ничего не можем сделать. Для создания пустого нужен констрейнт T : Default, всё верно. Для того чтобы вернуть значение полученное из какой-нибудь захардкоженной числовой константы понадобится констрейнт, ну и так далее.

T : From<i32>

Любой необходимый функции функционал (сори за каламбур) обязан быть объявлен в сигнатуре. Именно поэтому она даёт столько пищи для размышлений и в куче случаев является исчерпывающей информацией о том, что это за функция и как её использовать, не глядя в тело.

Именно поэтому она даёт столько пищи для размышлений

Хорошо, допустим у меня есть функции lower_bound и upper_bound — у них требования на Т одинаковые (наличие оператора< и… всё?). Да, исходя из того, что требуемый контейнер/рэнж должен быть RandomAccess, я могу по сигнатуре догадаться что это бинарный поиск, но какой из двух? Или я уже придираюсь и хочу слишком много?

Просто мне абстрактно кажется, что есть достаточно большой класс функций с одинаковыми требованиями на Т/U где не заглянув в код/не посмотрев имя функции (а там doWork или ProcessValues), нельзя догадаться о том, что функция делает.

В реальности, по имени функции и сигнатуре часто можно увидеть полезные вещи:

Может вернуть нулл (нужно проверять всегда результат)

Может вернуть ошибку (нужно обрабатывать такую возможность)

Может ходить по сети (тогда нужно подумать, прежде чем такую функцию запускать в цикле)

Может писать в БД (тогда нужно подумать, как прокинуть контекст соединения чтобы всё эффективно работало)

Ну и так далее.

Что до примера, то я не очень понял. Возьмем хаскель, там есть тайпкласс Bounded который задаёт две функции minBound/maxBound

Если я увижу функцию вида

doWork : (Bounded a, Ord a) => Vector a -> Vector aТо мне в принципе очевидно, что происходит сортировка какого-то вида. Какого — не знаю, если мне нужно узнать точнее то надо уже идти смотреть тело. Но например в расте если я увижу такую функцию (и мы уберём bounded), я буду точно знать, что если я передал например функцию с уникальными элементами, то в результе будут тоже только уникальные элементы, и если мне например важно чтобы элементы не повторялись то я знаю что мне не нужно повторно валидировать результат.

Может вернуть нулл (нужно проверять всегда результат)

В С# для этого добавили Nullable References.

Может вернуть ошибку (нужно обрабатывать такую возможность)

В Jave поддрживается и надеюсь что рано или поздно добавят и в C#. А пока да, при необходимости приходится полагаться на всякие exception reflector'ы.

Может ходить по сети (тогда нужно подумать, прежде чем такую функцию запускать в цикле)

Может писать в БД (тогда нужно подумать, как прокинуть контекст соединения чтобы всё эффективно работало)

Это да, «нативно» такое те же C# с Java не поддерживают. Но на мой взгляд для такого есть coding conventions. Они не панацея и «работают» гораздо хуже, но жить можно.

В С# для этого добавили Nullable References.

Которые нормально не работают, но уже лучше, да, шаг в том направлении о котором я говорю

В Jave поддрживается и надеюсь что рано или поздно добавят и в C#. А пока да, при необходимости приходится полагаться на всякие exception reflector'ы.

Ну так оно фигово работает в таком виде. Вот скажите, как мне написать сигнатуру такой функции:

void Foo(Action action) {

action();

}Где Foo бросает ровно те же исключения, что и action? Насколько мне известно, в Java такое записать невозможно.

Это да, «нативно» такое те же C# с Java не поддерживают. Но на мой взгляд для такого есть coding conventions. Они не панацея и «работают» гораздо хуже, но жить можно.

Так так со всем. Нет нулляблов — ну ладно, будем конвенциями не забывать проверять на нулл. Эксепшны? Будем конвеншнами указывать, что где может выброситься (например, в проектах Project.Core/Project.Common могут бросаться только *BusinessException). И так далее.

с миру по нитке, голому — рубаха, в итоге разница суммарно выходит очень и очень существенная. Ну и нет причин, почему нельзя жить лучше, если можно.

А в чём по вашему заключается кривизна работы nullable references?

И да, в куче языков чего-то нет и не хватает. Ну так и Рим не за один день строился.

1 нельзя написать T? FirstOrNull(IEnumerable<T> source), например.

2 По той же причине нельзя написать структуру данных, которая возвращает такую функцию, например, мне нужно было такой интерфейс реализовать:

interface ISettings<T>

{

T? GetSettings();

}3 null propagation не работает в половине случаев: при вызове конструктора, при вызове статических методов

4 ...

короче, список проблем существенный, можно ещё продолжать и продолжать. И если null propagation — ну ладно, мы не гордые, напишем руками. то невозможность такой интерфейс сдеалть очень расстроила.

Вроде для этого приспособили атрибуты:

[return: MaybeNull]

T FirstOrNull(IEnumerable<T> source)Ну так что это, как не костыли? Плюс оно не будет правильно работать. Например, из моих персональных экстеншнов:

public static IEnumerable<T> WhereNotNull<T>(this IEnumerable<T?> source) where T : class =>

source.Where(x => x is {})!;

public static IEnumerable<T> WhereNotNull<T>(this IEnumerable<T?> source) where T : struct =>

source.Where(x => x is {}).Select(x => x.GetValueOrDefault());Тут даже реализация отличается, не получится атрибутом это выразить. Ну или делать if typeof(..) { .. }

Ну так что это, как не костыли?

Не совсем костыли. Под капотом оно все равно в атрибуты разворачивается.

Тут даже реализация отличается, не получится атрибутом это выразить. Ну или делать if typeof(..) {… }

Увы, дженерики C# для такого не предназначены. Вам надо в C++ лезть.

Конечно, есть костыль, который позволяет делать перегрузку для случаев, когда аргумент — class и когда — struct, но я не рекомендую им пользоваться.

Если сравнение с шаблонами то вот простой пример:

public static class C

{

public static void DoIt<T>(T t)

{

ReallyDoIt(t);

}

private static void ReallyDoIt(string s)

{

System.Console.WriteLine("string");

}

private static void ReallyDoIt<T>(T t)

{

System.Console.WriteLine("everything else");

}

}Вызов C.DoIt("Hello") выведет "everything else" в сишарпе и "string" если это переписать на плюсовые шаблоны

Но я имел в виду то, что в сишарпе есть хак для того чтобы ломать параметричность:

void Foo<T>()

{

if (typeof(T) == typeof(int)) {

Console.WriteLine("AZAZAZA");

}

else {

Console.WriteLine("Some generic code");

}

}Это ломает многие представления о том, что может делать функция — по сигнатуре никогда не узнаешь, не лезет ли функция в метаданные типа.

IoC это когда реализация зависит от абстракции, и тело метода зависящее от сигнатуры тут полностью подходит. Да, это простой случай, но — случай.

— вся инфа передается через сигнатуру

— вся инфа передается через контекст и новый граф объектов собирается перед каждым вызовом метода

И то и другое в общем случае ведет к несопровождаемым системам, поэтому задача программиста тут — выбрать такую сигнатуру, которая будет принимать минимальный набор параметров, дающий и итоге клиентский код, легко поддающийся сопровождению. Во многих случаях такое решение принять легко, например я не видел случаев чтобы люди из бизнес логики в DAO передавали коннекшн до БД аргументом метода) Во многих других сложно. В общем апишка должна быть настолько абстрактной, насколько это возможно, но не более того. Проблема в том, что так умеют с первого раза только эльфы, но мы ведь сейчас про теорию)

Если вы этот код дописываете, то вы по идее видите что делает каждый метод.То есть я правильно понимаю, что «для упрощения» мне предлагается разбить огромную функцию на 500 строк на 200 функций по 5-10 строк и потом, когда я хочу вот это вот править, я должен изучать уже не 500 строк, а 1500 строк?

Это точно называется «упрощение»? По моему это карго-культ называется.

Мне кажется люди, которые занимаются вот этот творческой нарезкой лапши забывают принцип, который хорошо сформулировал Эйнштейн: Делай так просто, как возможно, но не проще этого.

Ибо эта вот «лапша» — это явное создание чего-то, что проще, чем это возможно. Если метод в 50, 100 или даже 500 строк не удаётся разбить на два метода, которые могут читаться и правиться совершенно независимо друг от друга… то его не нужно разбивать вообще!

Хотя в последнем случае, когда речь идёт о 500 строк, обычно удаётся выделить самостоятельные компоненты… но это не делается созданием десяти методов

do_⅕_of_work, do_⅖_of_work и так далее.Но на мой взгляд редко какую функцию на 500 строк нельзя разбить на отдельные функции влезающие на экран монитора так чтобы читаемость при этом не повысилась.

И у Мартина как раз и описывается как это стоило бы делать чтобы читаемость повышалась. И да он местами перегибает палку, но идея вполне понятна.

И да он местами перегибает палку, но идея вполне понятна.Нет. Идея нифига непонятно. Ибо цель — не получить текст, который приятно читать, а текст, который легко менять!

Потому что следующим действием за шинковкой кода в лапшу следует его обмазывание большим-большим количеством юниттестов.

Ребяяяты! Если вам, для того, чтобы понять — правильно вы поняли, что делает код или нет недосточно самого этого кода… то вы утратили его понимание, извините.

Оно теперь у вас сосредоточено в тестах, а не в голове разработчика.

И да, так иногда приходится-таки поступать… но это ни разу не то, к чему стоит стремиться…

Но на мой взгляд редко какую функцию на 500 строк нельзя разбить на отдельные функции влезающие на экран монитора так чтобы читаемость при этом не повысилась.Зависит от монитора. Некоторые функции в 100 строк уже сложно делить. Но функции в 2-3 строки — это почти всегда профанация. Они очень редко имеют смысл сами по себе, то есть это либо требование языка (скажем какая-нибудь функция

operator+ — это почти всего несамостоятельные 2-3 строки кода), либо часть группы функций… а тогда и не нужно считать что длина этой функции — 2-3 строки.Вообще не слишком полезно оперировать «длиной функции», скорее полезно выделать «неделимый блок кода», который нужно прочитать чтобы понять что функция делает.

Скажем в Haskell функции обычно структурированы реально как 1-2-3 строки… но при этом то, что я уподобил бы аналогу функции в обычных языках — это группа тесно связанных между собой функций, которые не имеют документации (то если не предназначены для самостоятельного использования).

Ребяяяты! Если вам, для того, чтобы понять — правильно вы поняли, что делает код или нет недосточно самого этого кода… то вы утратили его понимание, извините.

Оно теперь у вас сосредоточено в тестах, а не в голове разработчика.

Это как раз правильно, если только не заниматься Job security.

Другое дело, что при таком подходе тесты тоже становятся загадочными, и вот это уже плохо.

Нет. Идея нифига непонятно. Ибо цель — не получить текст, который приятно читать, а текст, который легко менять!

Цель получить и то и другое. И когда у вас вместо одной огромной функции несколько небольших, то и менять их проще. Грубо говоря если вы ваш метод на 500 строк разобьёте на 25 методов, то 20 строк, то какова вероятность что вам придётся фиксить все 25 методов при каком-то минорном багфиксе? По моему опыту она стрeмится к нулю. Обычно придётся пофиксить 1-2 метода. Ну может 3-4. Ну максимум половину.

Более того каждый метод можно отдать фиксить отдельному человеку и потом не будет особых проблем всё это замерджить обратно. А вот если у вас пяток человек паралелльно должны фиксить какой-то метод в несколько тысяч строк, то я могу только посочувствовать тому, кто это потом будет вместе мерджить…

Потому что следующим действием за шинковкой кода в лапшу следует его обмазывание большим-большим количеством юниттестов.

Если вам что-то мешает использоватъ юнит-тесты, то и не надо этого делать. Но если вы их используете, то да, маленькие методы тестировать проще чем один большой.

Зависит от монитора.

Конечно зависит. Но где бы я не работал обычно у людей мониторы были более-менее одинаковые и именно с этим пунктом ни разу проблем не возникало.

Некоторые функции в 100 строк уже сложно делить. Но функции в 2-3 строки — это почти всегда профанация.

Не надо пытаться всё обязaтельно разбить на функции по 2-3 строки. Но если у вас есть кусок кода, который можно вынести в отдельную функцию на 2-3 строки и ваша основная функция непомерно разрослась, то почему бы и не вынести?

Вообще не слишком полезно оперировать «длиной функции», скорее полезно выделать «неделимый блок кода», который нужно прочитать чтобы понять что функция делает.

Естественно. И я пока ни разу не встречал «неделимый блок кода» длинной в 500 строк. И даже длинной в 100 строк не могу припомнить.

А как вы это будете делать в ФП? Особенно интересует обращение к isSuite :-)

Методы в ООП взаимодействуют с состоянием объекта. Когда методы перестают это делать, а состояние начинает проталкиваться через аргументы, то код превращается в обычное процедурное программирование. Разве не так?