Comments 268

Это с одной стороны. А с другой, у любого облака ценник чуть ли не до х10 доходит, по сравнению с физическими серверами. И если всё равно нужно за свой счёт беспокоиться о сохранности данных — по сути, админить самостоятельно свою инфраструктуру — то на кой тогда черт нужно это облако? За ту же цену можно будет купить в несколько раз больше ресурсов в виде физического железа, в добавок в двух разных ДЦ, ещё и админа-аутсорсера на сдачу нанять.

Люди, которые платили яндексу, платили больше, надеясь на экспертизу в области, надежность (как следствие) и предсказуемость результата. А оказалось, платили лишь за бренд. Не оправдываю их, но после такого как-то пропадает уверенность в таких компаниях. Если их надежды не оправдались, тогда вопрос — зачем пользоваться яндексом и платить больше?

Гораздо более дешевые хостеры годами живут без таких факапов. А тут такое. Выводы о ценности такой услуги напрашиваются сами собой. Буду рад услышать аргументированные доводы, почему после этого стоит выбрать яндекс, если таковые найдутся

А убеждать кого-то в выборе того или иного сервиса или необходимости (отсутствия необходимости) его смены несерьёзно. Это каждый решает для себя сам.

Выбор сервиса для тех или иных целей — не выбор религии, поэтому убеждать и обосновывать нужно. Чем более осознанно вы подойдете к этому вопросу, тем меньше вреда смогут нанести возможные последствия, тем меньше времени займет дальнейшая работа и тем проще будет развиваться дальше.

Ах, да. Админу надо зарплату платить, да еще не стырил бы данных каких-нибудь ценных.

Менеджерам на квартальные не хватает из-за какого-то бездельника))

Гораздо более дешевые хостеры годами живут без таких факапов

Это же случайность.

То есть вы предлагаете полагаться «на авось».

Как вариант, поступать можно по аналогии с бэкапом на диски — делать копию на два независимых диска, снижая вероятность сбоя в разы. Например, делать бекапы в гугл и в дропбокс как в наиболее стабильные.

Но всё равно непонятно как сопоставить риски. Штатный админ точно так же может накосячить с бэкапами, и в случае чего мы окажемся в ситуации, что часть данных пропадёт.

Интересно узнать, как вы себе поставляете зарплату "рядового маркетолога-продажника", если не секрет? Хороший админ*3 — это как бы дофига денег, точно про рядового говорим, а не про топ-менеджера?

Нужно 24*7 — сразу минимум 2 админа, в идеале 3 ибо отпуска никто не отменял, а с вашим подходом, в самый критичный меомент админ скажет «гуляйте чудики, горите в своём котле».

Нужно 24*7 — сразу минимум 2 админа, в идеале 3 ибо отпуска никто не отменялдаже больше трех:

8-часовой рабочий день с двумя выходными в неделю — уже 3 человека для пятидневки без учета отпусков и больничных

А что если я, как единственный админ в конторе, уехал в отпуск на море?

Быть доступным это значит реагировать на экстренные инциденты.

Это называется дежурство на дому. Есть у медиков.

У админов и прочего технического люда такого режима работы юридически вроде нету. И ваше требование вероятно не законно. Но даже если закрыть на это глаза и провести аналогию с медиками, то у админа на домашнем дежурстве час идет за половину рабочего часа, то есть за 16 часов дежурства набегает 8 часов сверхурочных. По закону сверхурочных не может быть более 4 часов в течении двух часов подряд. Следовательно ваше требование и с этой стороны не законно.

И это я не затрагиваю еще вопрос оплаты сверхурочных.

UPD. Прочитал дальнейшие комментарии. Вывод: на вас ездит бизнес как на лохе, а вы мало того что гордитесь этим, так еще и считаете что другие должны жить также. Не надо так.

всё будет как в этом ролике

Я и был в такой ситуации) Когда был молодой и неопытный и меня хотели напрячь, возмутился. Весь отдел 6 «админов» заржал. Тогда я осознал глубину задницы. Отдел терпил, как «ведро с крабами», и тут я выскочка, который не хочет так жить. И сменил профессию на программиста)

поэтому почему бы не быть лояльным к компании с другой стороны?

Так в том то и дело, что это личный выбор каждого, быть лояльным за плюшки, например как у вас премии, или нет, но уж никак не «профессиональный долг настоящего сварщика».

Бизнес ездит на всех, на ком-то быстрее на ком-то медленнее

Это совершенно нормально. Он так и должен поступать.

Бизнесу совсем незачем вас нанимать иначе.

Любой бизнес требует от вас работы выдавать больше, чем платит вам.

А разница между стоимостью созданного вами и полученным вами за это вознаграждением — идет на развитие бизнеса и на прибыль владельцам.

Без этого существование бизнеса смысла и лишено вовсе.

Тут вопрос только в том: устраивает ли лично вас лично ваша конкретная рабочая нагрузка и лично ваша конкретная компенсация за эту нагрузку.

у админа на домашнем дежурстве час идет за половину рабочего часаКоллега, поделитесь нормативным документом? Я раньше дежурил на телефоне за четверть ставки.

Это называется дежурство на дому. Есть у медиков.

А в полиции — это еще более строго.

Смею полагать, и у админов на каких-то «ядерных/космических объектах» и т.п. — тоже есть подобное. И, возможно, что и вполне официально «военизировано» несение службы там.

В остальных случаях — добровольное соглашение между работником и работодателем.

Бывает — с доплатой. Бывает — без оной.

Представьте — вы единственный админ в конторе. Отключили электричество или там потоп какой-нибудь. Ваши действия в нерабочее время — забить или отреагировать.

Мои действия — немедленно написать заявление об увольнении.

Уверен, если забьете — то завтра же окажетесь на бирже труда — и это правильно.

Нет. Я окажусь на бирже труда сегодня, а завтра я уже буду работать в нормальных условиях.

Я не админ, но знаю, что хороших админов сейчас днем с огнём не сыскать. Их разбирают как горячие пирожки. Так зачем сидеть в какой-то говноконторе, которая требует быть на связи 24/7, но нанимать админов на смену не хочет?

Представьте — вы единственный админ в конторе. Отключили электричество или там потоп какой-нибудь. Ваши действия в нерабочее время — забить или отреагировать.

Мои действия — немедленно написать заявление об увольнении.

Нет. Я окажусь на бирже труда сегодня, а завтра я уже буду работать в нормальных условиях.

Гы.

И потом эти люди еще обижаются, что им «так мало платят, какие работодатели жадные».

А мало платят просто за недостаточную ответственность по разрешению сложных для фирмы ситуаций.

Наблюдаю картину в фирме, где персонал делится на 2 больших класса:

Одни поддерживают работу фирмы годами, что бы не случилось. Не с восторгом, но выходят на работу в выходные, если очень надо (к слову, это раза 4 за 2 года). И эта часть сотрудников получает более чем нормальные зарплаты. Стабильно годами.

Им дают, если надо любые авансы, любые кредиты без процентов и пр. и пр.

Ну и «обычные», которые «от звонка до звонка» и зарплаты у них те самые, «кот наплакал».

Вы конечно скажите — «так им и платят, вот они и работают».

А я скажу, что причинно-следственная связь тут обратная.

И потом эти люди еще обижаются, что им «так мало платят, какие работодатели жадные».

Какие «эти люди»? Я вот не жалуюсь. Мне хорошо платят.

И хорошим админам сейчас тоже отлично платят. Думаю, они тоже не жалуются.

Наблюдаю картину в фирме, где персонал делится на 2 больших класса:

Одни поддерживают работу фирмы годами, что бы не случилось. Не с восторгом, но выходят на работу в выходные, если очень надо (к слову, это раза 4 за 2 года). И эта часть сотрудников получает более чем нормальные зарплаты. Стабильно годами.

Подождите. Какие два класса?

Я отвечал вот на это:

Представьте — вы единственный админ в конторе.

Как один админ может делиться на два класса?

Если в компании несколько админов и нормально организован «on call», то это нормальня ситуация. И конечно за «on call» должны доплачивать.

Представьте — вы единственный админ в конторе.

Как один админ может делиться на два класса?

Запросто.

Мне, в частности, в свое время говорили, что предпочитают работать именно со мной, потому что я всегда доступен, даже в выходные, даже поздней ночью, а вот другой админ включал рабочий телефон только с 8 и до 17 часов и только с понедельника по пятницу.

В результате мои нескромные запросы по зарплате никого и не смущали.

Когда фирма решала с кем из нас работать — на момент когда у них все активно развивалось — предпочитали меня.

При выходе на стагнацию — переключились на более дешевого специалиста, несмотря на некоторые проблемы с его доступностью.

И конечно за «on call» должны доплачивать.

Вам никто и ничего не должен.

Это — только как вы сами сможете договориться.

Вопрос оплаты — сугубо индивидуален.

Кого-то устраивает одна сумма и один стиль работы. А кого-то — другая сумма и другой стиль работы.

Упомянутый выше админ, спустя некоторое время, купил землю и сейчас строит там дом.

С этого момента он стал доступен на телефоне и в выходные и поздно вечером.

Догадываетесь, почему так стало?

Даю подсказку: построить свой дом — это дорого.

Представьте — вы единственный админ в конторе. Отключили электричество или там потоп какой-нибудь.

Либо у этого единственного мега-админа уже заранее написаны инструкции, что если отключилось электричество — охранник Вася или Петя щиток проверит. Если затопило — Сантехник Гриша пусть сушит. А я приду в понедельник, повключаю сервера. И мне ничего не будет, так как с руководством есть договоренность что подобные факапы меня не касаются.

Либо нужно заранее бить тревогу, что один админ — это нереально. Нужны отпуска, нужны выходные, нужны больничные. Минимум два, либо пусть нанимают аутсорс контору, с админами по вызову.

Нормально построенный «бизнес процесс» не предполагает наличие кого-то доступного 24х7…

Если нужна круглосуточная поддержка — это решается дежурными операторами в режимесутки\трое.

Это же только при определенном достаточном для организации этого масштабе предприятия.

Фирм, когда масштаб попадает на границу — уже надо бы, но возможности еще ограничено — полным-полно.

Не нужно возводить в абсолют — не требуется 100% обеспечения доступности. Проспите звонок — ну и проспите звонок. Как отдельный частный случай — это не критично. Главное, чтобы остальные 30 звонков не проспали.

Это всего лишь компромиссный вариант — если вы не уезжаете каждые выходные из города, то статистически вы скорее доступы, чем недоступны.

Этого вполне достаточно.

Другой вопрос: а устраивает ли это лично вас при лично вашей зарплате. Или возможно, вам имеет смысл поднять разговор о доплате из-за необходимости всегда быть на связи.

P.S.:

В большом количестве случаев даже и приезжать не нужно. А зачастую проблема решается даже не полноценным удаленным вмешательством, а всего-навсего командой по телефону «нажми зеленую кнопочку, дождись красной лампочки и нажми синюю кнопочку».

имеет смысл поднять разговор о доплате из-за необходимости всегда быть на связи.

Тут не о «доплате» надо вопрос поднимать, а о полноценной почасовой оплате по ставке. С повышающим коэффициентом в ночи и праздники. Потому, что нахождение в режиме standby — это точно такая же полноценная работа, так почему она должна оплачиваться как-то иначе?

Разумеется, в этом случае пропущенный звонок — повод для санкций, это работает в обе стороны. Кого-то такая модель работы устроит, наверное.

А если «на тебе три копейки сверху и будь доступен 24х7» — это лесом сразу.

Ну и я принимал меры, чтобы меньше дёргаться. авто переключение нагрузки в резервный дц при проблемах в основном (несколько раз было, что дц перегревался, несколько раз отключали питание а дизель не запустился). И до сих пор им помогаю по звонку, хотя много лет там не работаю.

Рассчитывать что админ доступен 100% это тупо. Он может уйти в отпуск (а отпуск это значит 0% доступность и никак иначе!), серьёзно заболеть, быть допустим в поезде где сотовые ловят пару часов в сутки (даже если успеет принять звонок, инет там может выдавать 100 кбит и то недолго, лично сталкивался), может просто быть за рулём, ответить может а что-то начать делать только через час, если в пробку не встанет… А если ваш админ просто вас бросит и сбежит, или умрёт — фирму можно закрывать? Есть способы уволиться с минимальной передачей дел или вообще без неё.

Это всё-равно что говорить «поставим 1 диск в сервер, если он сломается, то будет доступен новый диск, а этот выкинут». А что данные потеряются это видимо не важно. И новый админ точно потребует дообучения под местные реалии, как правильно обманывать тупое начальство и обходить его тупые закидоны итд.

Если ит для фирмы важно — админов должно быть МИНИМУМ 2. Иначе это беспросветная тупость руководства и ничего более.

Возможно дешевле будет:

— делегировать эти функции другим сотрудникам (да даже руководству), если у них хватит квалификации

— договориться с админом таки быть доступным ночью/во время отпуска, денежно его смотивировать. Если заранее была договорённость о таких случаях, и админ не против — то я не вижу проблемы. Можно прописать время реакции на проблему.

— держать отдельного удалёнщика на случай экстренного восстановления в нерабочее время

— возможно в каких-то случаях выгоднее просто позволить сервису лежать до выхода админа на работу, и выплата компенсаций за простой будет дешевле, чем держать несколько человек.

у любого облака ценник чуть ли не до х10 доходит, по сравнению с физическими серверами.Позвольте тут встрять. Мы очень любим сервера на ovh и hetzner, те что десктопные, соотношение цена/качество великолепное, но даже по сравнению с ними облако стоит всего в 3-4 раза дороже, при условии постоянной равномерной нагрузки. Если же речь идет о настоящем серверном оборудовании расположенном в настоящем качественном ДЦ и неравномерной нагрузке — облако раза в 2 дороже получится, не больше. Откуда разница в 10х?

если всё равно нужно за свой счёт беспокоиться о сохранности данных — по сути, админить самостоятельно свою инфраструктуру — то на кой тогда черт нужно это облако?Облако эЭто не вирт.хостинг где хостер по идее должен бегать вокруг с салфеткой и подливать винишко, пока рубишь деньги на сайте. Облако это просто гибкий резиновый железный сервер, все нюансы с сохранностью данных остаются, а с админством зачастую даже усложняются.

но даже по сравнению с ними облако стоит всего в 3-4 раза дороже

Хотелось бы увидеть рассчеты и тесты. К примеру, может получалось, что если считать за одно и тоже разделяемое за счет гипертрединга ядро с частотой 2.1 в облаке, и физическое ядро процессора i9-9900K c частотой 3.60 (а по факту, даже больше за счет небольшого повышения частоты в среднем) в хецнере, то выходило х3 по затратам?

То, что я видел, ну не выходит 3-4 раза от хецнера. Скорее в х7-х8 поверю

Такие минусы, как произошли у Яндекса заставляют задуматься о желании переехать туда. С их-то ценником, мне кажется, можно не допускать такое. Надеюсь, что они, реально, сделают выводы и такого не повторится.

P.S. Если потерялись данные — проблема не Яндекса, а бизнеса (читай, админа), который не настроил бэкапы, тут я не оправдываю. Хотя, конечно, хостинг доверие потерял и часть данных гарантированно вылетели в трубу — за это тоже нужно давать хорошую плюшку.

P.P.S. Если упал какой-то важный сервис по ошибке Яндекса, то, на мой взгляд, Яндекс должен возместить ущерб такого падения. И дать шоколадку сверху.

А с другой, у любого облака ценник чуть ли не до х10 доходит, по сравнению с физическими серверами

Если вы пытаетесь использовать облачные ресурсы так как привыкли с ресурсами выделенными только вам — да, конечно, цена вас неприятно удивит.

Так ведь и смыл облака в том, что вы платите за реально потребляемые ресурсы, что позволяет вам простым и недорогим способом переживать пиковые скачки нагрузок и легко масштабироваться по небходимости — а за эту возможность нужно платить.

При грамотной архитектуре вашей системы, заточенной под облако, и при верной оценке профиля предполагаемой нагрузки — вы будете платить вполне разумную цену.

Обычно, чуть выше, чем без облаков — такая наценка за гибкость. Но это именно что чуть-чуть выше.

При грамотной архитектуре вашей системы, заточенной под облако, и при верной оценке профиля предполагаемой нагрузки — вы будете платить вполне разумную цену.

Тут то дьявол и скрывается) Не раз видел кейсы, когда затраты на написание кода, который позволит запустить приложение в облаке, и грамотно его масштабировать + трата ресурсов рантайма на сериализацию и десериализацию превышали затраты на high-end железо в 10-30 раз.

Условно, есть платформа страховой/банка/ритейла, которая содержит БД и обслуживает несколько тысяч клиентов и миллионы транзакций в день.

Вася силами небольшой команды взял за основу двухзвенку с одной огромной реляционной базой, которую установил на 4-х процессорный сервер (сразу уточню, что на Xeon Gold, а не E7, ибо радикально дешевле) с 3ТБ ОЗУ и десятком NVMe дисков. И еще купил такой же, чтобы он реплицировал первый по транзакт логу, и ждал своего часа, пока первый сдохнет, и мог взять на себя нагрузку через 5 секунд даунтайма. Да, нанял толкового ДБА (возможно, на фриланс на часов 5 в месяц), который почистил SQL код от лишних блокировок. Итого, затратил $100K

Петя же сделал все, как надо. Разбил все по микросервисам, нанял 5 команд разрабов, каждая из которых превышает по размеру васину (ибо микросервисов много, а интеграции между ними сами себя не сделают), сделал грамотный шардинг, реализовал общение микросервисов между собой через кафку, развернул в облаке да подключил автоскейлинг и лоад беленсинг. И да, базу взял монго, ибо реляционные не сильно хорошо скейлятся как правило.

Суровая правда жизни в том, что хоть решение Пети и будет обходится в облаке не сильно дороже, а то и дешевле, чем решение Пети, развернутое на земле (все таки, автоскейлинг да сезонность сделают свое дело), но будет требовать х10, а то и х100 вычислительной мощности по сравнению с решением Васи, и где-то надо будет эту мощность купить. И вполне может выйти, что Петя будет платить $100K амазону каждый месяц. Не забываем, что +4 команды программистов тоже чего-то стоят. Да и средний программист Пети стоит дороже, чем у Васи, ибо не может стоит одинаково крутой спец по клауд решениям и зашкварный говнокодер, привыкший писать прямые запросы в СУБД;)

Оно совершенно не избавляет от необходимости реализовывать отказоустойчивость на более высоких уровнях, просто позволяет делать это чуть удобнее/быстрее.

Если сделать всё правильно и применять облака нужными местами, то из них с лихвой можно выжать те деньги, которые за них просят. Но, конечно, если хранить боевую СУБД на облачной виртуалке, то ничем хорошим это не закончится.

Рассматривайте облако как дешёвый VPS на чужом сервере, который сегодня есть, а завтра нет. Не из-за сбоя или ошибки админа, а вот просто проснулись и его нет.

А лучше так любой рантайм рассматривать) И к входным данным относиться, как к троянским коням, которые намеренно невалидны, чтобы увалить программу. И да, сарказм при написании коммента не включен.

А в облаке боевая СУБД будет хранится в вакууме? Или накопители там с секретной фабрики секретного производителя жестких дисков?

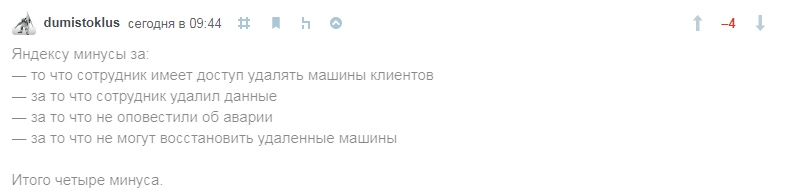

— то что сотрудник имеет доступ удалять машины клиентов

— за то что сотрудник удалил данные

— за то что не оповестили об аварии

— за то что не могут восстановить удаленные машины

Итого четыре минуса.

В остальном ситуация вполне рядовая.Мы бы так не сказали.

Тут архитектурно-идеологическая ошибка, это же не железный сбой, не софтовый сбой нарушающий целостность данных, это отсутствие элементарной защиты от человеческого фактора.

Окей, пусть раздолбай админ снес часть облаков. Но почему они сразу были физически удалены? Почему не просто помечены удаленными? Ведь стандартная процедура это шаг 1) отключение вдс и шаг 2) удаление вдс. Почему яндекс выполнил оба этих шага одновременно? Ведь это элементарные «стандарты», в том числе на случай ошибок. Эти шаги должны быть разнесены по времени хотя бы на 24 часа, а то и больше.

Это все равно что админ ввел на сервере rm -rf / и всему пришел кирдык, потому что работал из под рута, а не из под юзера. Так не делается. Не на таком уровне.

А есть другой довольно большой слой обычных разработчиков и мелкого бизнеса которые ранают свои инстансы в облаке. Одним удобно с точки зрения деплоя, вторым с точки зрения стоимость\поддержкла.

По хорошему хотелось бы посмотреть на соотношение людей которые бекапят облака vs людей которые полагаются на хостинг оператора.

(Ps У самого 4 виртуалки в облаке Хецнера. Честно — не бекаплюсь)

У яндекса это постоянство качества. То папку с виндой снесут при удалении яндекс-диска, то виртуалки, теперь.

Вы можете потерять данные из-за чего угодно.

Из-за пожара в датацентре, из-за описанной в статье человеческой ошибки, из-за скачка электроэнергии и т.п.

Если вам эти данные действительно нужны — просто используйте для дублирования несколько разных датацентров (и лучше разных хостеров).

Только сохранить так последние минуты\секунды весьма сложно будет.

Есть, только ни очень больно могут ударить по производительности.

Разумеется. САР-теорему ещё никто не обошел. Нет спала надеяться, что её обойдёт Яндекс. Поэтому план по сохранности данных нужно составлять с учётом своей специфики.

Сейчас пробуем AWS и пока-что не очень все радужно. За 60 дней два раза полностью исчез инстанц. оба раза получили от амазона автоматическую отписку в стиле «сорян, такое бывает». Я, конечно, и сам понимаю, что не бывает 100% доступности. Но два факапа за 60 дней на одном единственном инстансе это не радует, от слова совсем.

Понятно, что у нас есть асинхронные бэкапы, понятно что можно их восстановить. Не понятно как спасать транзакции, прошедшие в последние минуты и часы, причем без потерь в производительности.

Но только не инстансы в публичных облаках. Чем более оторвано от физики предлагаемое к аренде решение, тем сложнее понять, что с ним происходит. Грубо, в AWS о ситуации на физическом хосте знает только ПО управления облаком (и из него может посмотреть сотрудник поддержки; только людей живых в ДЦ совсем мало, так что — разговор скорее про контролирующий софт). И если что-то пошло не так (а машин там дофига, понятное дело), не факт, что все успеет с упреждением переехать и спастись. Ну спасать данные, которые по договору можно потерять, смысла вообще нет. Проще запилить скрипт «да, шит-хеппенс, с вашей ВМ случилось именно это».

Ну и да, облака сильны другим, они не про отдельные виртуалки, они про много не очень надежных ВМ, которые в сумме, порождаясь по мере необходимости, выдерживают многое, в т.ч. и выход отдельных ВМ из строя.

Самое гадкое, что первая часть марлезонского балета подхода — это «я вместо одной ВМ запилю пару», вторая — «я вместо пары ВМ в одной AZ» запилю несколько в нескольких, плюс балансировку", а третья, «опытная» — «я кроме нескольких AZ добавлю-ка в мое приложение ВМ-ки в разных облаках, ибо х.з.» Плюс, конечно, хитровыдуманная балансировка, автоскейлинг и пр. — и счета становятся не в 2-3 раза больше, чем было бы не хецнере, а прямо сильно заметно выше.

Да. На то мы и опытные ит-ники, чтобы планировать и иметь резерв, так? А то у вас и нас получается: либо быстро, но ненадёжно, либо долго, но дубово надёжно.

Странно только, что в облаках вм-ки крутятся на таких же железных машинах, но крутятся сильно менее надёжно. Нонсенс, но именно так!

Навскидку розничный ценник сервера получается как года этак 3 аренды.

То есть при необходимости держать сервер в датацентре — такой арендованный выходит в 4 раза дешевле.

Работаю с AWS с 2015. Много Production-окружений, много клиентов/аккаунтов.

Ни разу такого не было.

Может быть, вы что-то не так делаете? Да и саппорт Амазона не отвечает в духе «сорян, такое бывает» — у них очень адекватная и грамотная поддержка.

Как отметили в комментарии выше — да, у них бывает необходимость переноса ЕС2 на другой физический сервер, но в таком случае они чуть ли не за месяц присылают уведомление, и не удаляют его — а останавливают, и переносят. За всё время такое было раза 3 за всё время.

Есть только один минус — прайс вырастает x2 из-за этой необходимости. Облака не спасают :(

go.backupland.com/crash/amazon_crash/amazon_crash.html

Так что делать бэкапы нужно не только тем сервисом, в котором данные хранятся.

В общем никогда нельзя пренебрегать третим правилом бэкапа — проверить разворачивается ли он

Так у Яндекса же тоже только один цод лег, даже не регион, а цод.

Там нельзя размещать ценные данные!

Да, отчасти, когда какой-нибудь разработчик покупает вдс для своих нужд и тестов он не будет заботиться о бекапах (порой), потому что ему нужно просто что-то протестировать; но тут держим в уме, что он имеет в себе локальные копиии своего проекта.

Да, когда школьник покупает вдс для своего майнкрафт сервера — он так же не будет хранить бекапы либо потому что не умеет, либо потому что «ну зачем, в облаках же все круто».

И почему-то все так и считают, что раз «облако», то SLA 99.999%, потери данных никогда не было, нет и не будет, просадок связности не случается и на «мейнтейнс» они никогда не уходят. Но, имхо, это все как-то в реальной жизни не работает.

Мне кажется, что на физических своих серверах, что на серверах в облаке все равно нужно хранить не один и не два бекапа в разных частях для критичных данных. То есть бекамим внутри вм, бекамим на другую вм в Облаке в другой зоне, бекамим на какую-нибудь домашнюю тачку, если есть. И, как мне кажется, это best practice. И даже если данные потеряются, то головной боли при их восстановлении будет намного меньше.

Мне нравится правило 3-2-1

- 3 копии данных минимум

- 2 разных типа носителя(облака/диски/лееты)

- 1 оффсайт бэкап

я, конечно, понимаю пользователей, которые хотят «купить и не париться» относительно ничего, ведь «ну я ж в облаке».

… но, думаю, эти пользователи не имеют за собой каких-нибудь огромных продакшенов. А те, у кого такое уже случалось, научены опытом…

но ещё раз, как мне кажется, здравый человек или опытный администратор будет знать, что даже если сервер в облаке — это не сразу +100 к безопасности.

Прозрачность в подсчетах затрат.

Быстрое масштабирование вверх и вниз, большой выбор готовых шаблонов, удобство мониторинга, резервного копирования и управления.

И только как плюс: вы можете построить отказоустойчивое решение. )

Допустим есть вероятность в 3%, что что-то станет с продом за год. Это очень много.

Поэтому есть backup) Наличие backup позволяет нам восстановить данные. Но тоже не 100% данных, и не со 100% вероятностью. Допустим и там и там по 99%

Тогда наш урон это 3% * (1% + 1%) = 0.06%

Если мы к этом еще добавляем облако, которое теряет ваши данные раз в 1 млн случаев, то вероятность потерять данные для вас становится еще меньше.

Если мы копируем данные в другой ДЦ, от другого вендора — то мы еще раз многократно снижаем вероятность ущерба.

Вот за это снижение вероятности мы и платим.

Разве не в этом основное преимущество облака, на которое напирают маркетологи?

А это такая же маркетоложная ложь как и «у нас скидки ДО 90%»

Облако позволяет избежать части проблем, например, легко мигрировать сервис на другой сервер, если железо на старом сдохло.

Но, к примеру:

Если ваш сервис очень плохо переживает неожиданное отключение — то никакая защита в облаке вам не поможет. Вы должны сами об этом позаботится.

Добавилось правило:

Еще одна копия находится в не доступа админа.

Что бы обидчивый админ не снес все копии разом.

Имхо, правильным будет "экземпляра", а не "копии". Продакшн и 2 резервные копии, одна из которых далеко-далеко.

Осталось только, чтобы авторы правила "3-2-1" (Veeam) сами стали использовать именно такую трактовку.

Это все равно не помогает. Беда в необходимости синхронного лога репликации данных на другой точке. Когда речь идет про свое железо, можно сделать синхронный стендбай для базы, который висит на оптике в цоде, расположенном в 10 километрах. Латенси будет достотачно мал, даже для платежной системы или чего-нибудь такого. В облаках латенси между зонами или регионами (я уж не говорю про другое облако) не позволяет делать быстрые синхронные реплики.

Можно извращаться с N асинхронных реплик, в надежде, что суммарно получится восстановится in time. Можно попытаться разбить данные горизонтально на много реплик, чтоб снизить площадь поражения, но все равно гарантию это не даёт.

Справедливости ради, надо сказать, что Яндекс крупным клиентам в легкую оптику подтянет — все же локальность провайдера играет роль.

«мейнтейнс»

Maintenance — «мэйнтэнэнс».

А то купят подписку, разместят на одной машине фронтенд, бакенд и базу данных, а потом возмущаются, что доступность не 100% и машинка «без предупреждения» перезагружается.

Нужна непрерывность — закладывайте дублирование ролей.

Про резервное копирование уже только ленивый не написал. Не буду повторяться.

Эммм нет: Ажур например так сразу и говорит, что раз в месяц будем тушить ваши виртуалки (и тушат, на несколько секунд правда) — берите несколько в разных availability zones (или как они там у них называются).

А мы, кстати, не тушим, хоть и похожи на Azure.

надежности в 1 не бывает.

Буду ли после этого уходить из Яндекса? Не факт.

Есть и плюсы, которые терять не хочется. Ну, например, довольно оперативная и адекватная ТП.

Хотя пользуешься услугами таких гигантов как Яндекс или Гугл, почему-то до последнего не веришь, что у них такое возможно.

Реальность такова, что нельзя складывать яйца в одну корзину. У всех бывают сбои, все допускают ошибки. Нельзя пользоваться одним интернет-провайдером, нельзя пользоваться одним мобильным оператором, нельзя пользоваться одним облаком.

Сам до недавнего времени держал все данные в OneDrive. Вот уже 2 месяца как Майкрософт заблокировал мою учётку и не отвечает на запросы. То же может случится и с любым другим облаком, в том числе корпоративным, уверяю, во всех политиках использования написано о том, что провайдер имеет на это право.

Все думают, что их это не коснётся. Я тоже так думал, я обыкновенный пользователь, ничего противозаконного не делал, но это всё никого не волнует — должен держать вторую копию или делать регулярные бэкапы, так и написано в условиях использования.

Больше всего поразило, что они даже не сделали рассылку по жертвам удаления. Никак не связались вообще. При этом они знали, какие машины были удалены — в личном кабинете в логе действий значилось «Пользователь '-' удалил виртуальную машину xxx».

Я сам буду съезжать с Яндекса, доверие было не оправдано.

Хотя тот факт, что уведомления не разослали, именно на это и намекает…

Вот теперь там можно размещать данные ;)

Тыкните плиз в решения по централизованному бакапу OpenStack VM из облака?

На Backup в том же облаке надеяться бессмысленно.

Амазон присылает через 15 минут.

А ibm/softlayer вообще присылает все включая " у нас тут свич глючит, вроде вас не затрагивает, но вы имейте в виду" и " мы не уверены, что проблема у нас, но тут spotted какието мелкие задержки(+5-10ms от нормы), мы выясняем и вам сообщим".

насколько я понимаю и исхожу из статьи, Я.Облако запустилось в 2018 году. Не прошло почти и года.

почти все учатся на своих ошибках; думаю, и они научатся.

Есть механизмы, который снижают риски.

Это правильное проектирование бэкэнда проекта. С учетом того, что может натворить человек в пьяном угаре.

У одной игрушки была забавная авария — админы пролили пиво на прод.

У нас даже в 2U както было 4 сервера и свич внутри одного корпуса.

Печально. Проблема коснулась и меня… Камни в огород клиентов понятны, да они не делают бэкапы, да не так часто. Но зачем? Облачные сервера созданы для того, чтобы не заботиться об этом. Вероятность медного таза есть всегда. Особенно в реалиях, где продакнш сервер может упасть из-за проблем с блокировками. Но не суть.

Конкретно этот случай — большой косяк Яндекса и любого аналогичного ему сервиса.

Яндекс предупредил клиентов странным образом и не всех пострадавших. Это минус. О проблеме я узнал, когда дополнительный обслуживающий сервер сообщил мне об этом СМСкой (письмо от Яндекса пришло через несколько часов). Данные не пострадали, но пострадал аптайм. Т.е. когда машина падает по вине хостера — это можно пережить и сервер поднимался сам. а потом мы смотрим почему такое могло случиться. Держать дополнительный failover сервер стоит значительно дороже, чем доп.сервер обслуживания и не требуется на текущем этапе развития проекта.

Вторым косяком является то, что Яндекс допустил подобное. Это не техническая ошибка, а человеческий фактор. Существуют механизмы которые предупреждают, либо требуют дополнительных подтверждений при операциях массовых изменений.

Третий косяк: Яндекс молодцы, что сообщили об этом пострадавшим. Но остальные об инциденте не знали. Хорошо бы признать ошибку, извиниться и объяснить подробности. А еще бы возместить хоть как-то простой.

Клиентом Яндекса, вероятно, быть не перестану, но осадок остался. Былая надежность и стабильность Яндекса уже в прошлом после прихода эффективного менеджмента. Каждый раз да натыкаюсь на косяки в их продуктах.

Былая надежность и стабильность Яндекса уже в прошлом после прихода эффективного менеджмента.Яндекс никогда не был шикарной компанией без косяков. Тут же в комментариях вспоминают случаи с почтой и с яндекс диском. Очередной менеджер может и сделал хуже, но оно никогда идеально не было все же.

Косяки есть всегда и везде у любой компании. Я оцениваю ситуации в динамике. До 2012 Яндекса работал лучше, стабильнее и быстрее, а руководство более технически подкованным, чем сейчас. Сейчас же все иначе: менеджеры хорошо управляют людьми, но не проектами, просто потому что нет достаточного понимания специфики работы той или иной технологии. Зато есть скрам, дедлайны и показатели доходности проекта. И состряпать продающее решение "здесь и сейчас", пока его не состряпал конкурент работает. Сервис есть, приносит доход. Но до конца не отвечает ожиданиям потребителя. Как минимум по критерию безопасности и надежности. Эта тенденция глобальна.

Об том есть прекрасное размышление https://habr.com/ru/post/435268/

Касаемо косяков Почты и Диска — это как раз последствия. До 2012 года проблем Яндекса с точки зрения клиента можно было пересчитать по пальцам. Да, были, да крупные. Но сейчас крупнее и больше. Пример: https://habr.com/ru/post/357410/

И состряпать продающее решение «здесь и сейчас», пока его не состряпал конкурент работает. Сервис есть, приносит доход.А раньше не так разве было? Вспомнить тот же яндекс бар например — чем не решение вида «получить денег побольше сейчас и плевать на репутацию»? Если говорить про конкретные сервисы, то вы наверное правы, но в целом компания никогда не славилась безупречным сервисом. И попахивающие решения у них всегда были, года не проходит без очередного связанного с ними скандала.

Алекса-бар, помнится, лет 16 назад тоже был в антималварных базах, при этом компания считается серьезной.

А для чего тогда созданы облачные сервера?

Чтобы уносить туда прод без бэкапов, DR/HA/etc.?

Ну ок))

Облачные сервера созданы для того, чтобы не заботиться об этом.

Нет. Облачные серверы созданы для того, чтобы не держать инфраструктуру у себя. Но собирать систему за вас там никто не будет. Могут по доброте душевной или чтоб подстраховать себя, но не обязаны. А если их таки обязать и потребовать гарантии, то ценник будет уже не облачный, а заоблачный.

Это рассуждение сходно популярной мысли из недалёкого прошлого: «RAID создан для того, чтобы не думать о бэкапах» :)

Но стоит ли переплачивать в несколько раз только из-за удобного масштабирования?

«Сегодня в одном из пулов базовых дисков одновременно с работами по обновлению программного обеспечения произошел аппаратный сбой, повлекший за собой потерю данных. Проблема на данный момент устранена, однако часть дисков была уничтожена без возможности восстановления.

Резервное копирование указанной информации не производилось (ввиду особенностей работы виртуальных машин с блочными устройствами, крайне тяжело сделать надежную систему, которая сохраняла бы консистентные резервные копии, которые гарантированно корректно разворачивались при восстановлении).»

Когда-то давно, когда мне хватало виртуального хостинга — я вообще не задумывался о бэкапах, знал что всегда можно откатиться через веб-интерфейс провайдера (тоже не 100% надёжность конечно, но для тех сайтов хватало). Теперь мне приходится создавать аккаунт на другом облаке, настраивать бэкапы, следить чтобы в один момент бэкапы не перестали работать, периодически проверять нормально ли бэкапится, а если что-то случится — надеяться что инкремент соберётся без ошибок (а собирается он дофига времени).

Другое дело, что это ни раньше, ни сейчас не гарантия сохранности и off-site не заменяет. И облако может целиком стать недоступным по какой-то причине, и собственное здание может сгореть или туда придут какие-нибудь негодяи и всё украдут или арестуют.

Ну и собственный бэкап часто в принципе удобнее и возможности его шире.

Помню, была статья о том, как Амазон просрал данные, и намеренно заблокировал бекап, чтобы клиент не мог его скачать. Причем, клиент был довольно крупный, что-то вроде выделенного менеджера имел. Тогда была самая логичная идея, что клиенту случайно попали данные других клиентов, и в амазоне решили, что если это вскроется, то будет большим зашкваром, чем самовольное удаление данных и бекапов с неадекватными объяснениями

Как раз от скачка напряжения и от пожара скорее всего там всё защищено дублированием. А вот от человеческого фактора не может защитить вообще ничто.

Как можно выпилить руками всё (описанное) так, что раскатать назад, пусть очень-очень долго и на некое состояние «до», невозможно вообще? Дубли, рейды, все нюансы tier? Или оно как-то вообще рандомно существует на миллионах носителей как некое пространство, рандомно занимающееся чтением-записью на основе некой файловой структуры?

Ладно, я не разбираюсь в облаках, но вот у меня хостер хранит 7 снимков (по одному на день недели) в отдельном кластере 100 гигового VPS. Даже, если я полностью выпиливаю VPS до состояния невменяемости, либо не дай bsod что-то случается с физиком у хостера, — они поднимают его «днём до». Что не так с облаком?

$ grep "SUSPEND" vm-status.log | grep -o -P "(?<=machine name: )\w+" | xargs -I{} rm -Rf /customer-data/vms/{}

$ cat vm-status.log

#...

machine name: unneeded-vm status: SUSPEND

machine name: customer-production-server status: ACTIVE

machine name: customer-production-server status change: POWER at 2019-04-05 23:22:02

machine name: customer-production-server status change: SUSPENDED at 2019-04-05 20:13:02

# ...

Не ошибается, тот, кто ничего не делает. Хорошо это или нет, сложно сказать, не удивлюсь, если в Google, да и везде так же. Хотя в своей книге они пишут красиво. Кто ж в книге правду скажет.

В любом случае, админы грамотные, но всего лишь люди. И их очень редкие ошибки, могут вам дорого обойтись. В той же книге написано, что Гугл закладывает на отказоустойчивость процентов 99.99 остальное очень дорого. А при больших масштабах это много и не хотелось бы попасть в оставшийся процент.

Что надёжней? Хороший админ с кучей, не только вашего, оборудования или плохой админ на вашем сервере? ИМХО более менее одинаково, т.к. плохой админ всё сразу вряд ли сотрёт, совсем клинический случай не берём, но будут частые небольшие простои. А при хорошем админе простоев меньше, но уж если случилось, то как в этом случае.

Бекапы бекапами, но на развёртывание, восстановление, судебные иски от заказчиков уйдёт уйма времени, денег, ресурсов и денег.

Некоторые компании (например нетфликс) преднамеренно выключают сервисы рандомным способом, что бы убедиться что система может с этим справится. Посмотрите в сторону Chaos Engineering.

А реальность, увы, гораздо сложнее…

Радует, что в абсолютном большинстве случаев (а может и во всех) виной был человеческий фактор, т.е. наши с вами коллеги-расп*здяи, против которых защититься сложнее всего.

Эм. А кого приводить в пример-то, кидаясь какашками? У AWS тоже можно нагуглить достаточно много инцедентов.

Например, я видел крайне мало новостей о каких-то сбоях/утратах данных/утечках баз, которые сопровождались бы пометкой о том, что технический руководитель лишён премии и бонусов, программисты отправлены на аттестацию, команда тестировщиков наказана, а безопасникам поставили в трудовую штамп «не подходит для умственной работы». Не то, что я бы считал, что все компании ничего не делают с разгильдяями, но пишут об этом крайне мало. И у многих работников возникает ощущение, что за эпичный провал почти ничего не будет, а вот удачное собеседование принесёт прибавку к зарплате, либо офис с полдником. Поэтому почему бы не стать экспертами в собеседованиях, либо не пытаться взяться за непосильные или неадекватно трудные задачи?

И правильно делают, что не наказывают. Если создать атмосферу страха, то нечего будет защищать в итоге. Толковые айтишники уйдут к конкурентам. Те, что останутся, будут по 10 раз все перепроверять, и находить любые причины не делать сколько нибудь рискованные фичи в принципе. Клиенты уйдут к конкурентам, где готовы к факапам, и за счет этого быстро развиваются.

Компания может признать вину (взрыв Galaxy Note 7), не признать вину, но загладить ее (зеленые экраны Huawei Mate 20 Pro), не признать вину, по крайней мере сразу (потеря связи iPhone 4). Но в любом случае коммуницировать с сообществом покупателей будут либо топы, либо никто (втихую поменяют устройство).

Потому что успехи и неудачи принадлежать корпорации, а не отдельному человеку.

Ничего не утверждаю, просто фантазирую вслух.

Привет, это команда Облака. Пишем здесь только сейчас, потому что было важно разобраться в произошедшем.

Коротко о самом инциденте. На 16 мая были запланированы регулярные технические работы по остановке и удалению виртуальных машин заблокированных пользователей. Но при формировании списка был применен неверный принцип фильтрации, и в список попали активные машины. Удаление было остановлено, как только мы обнаружили ошибку.

Мы приносим извинения за этой сбой. Всем, кого он затронул, в качестве компенсации будут начислены гранты в Облаке. Кроме того, для пострадавших пользователей мы временно отключим тарификацию снимков дисков. И гранты, и нулевая тарификация вступят в силу в течение трёх рабочих дней.

Для предотвращения подобного в будущем мы, во-первых, в рамках процедуры блокировок облаков строго разделим остановку и удаление виртуальной машины и её дисков. Во-вторых, при удалении диска виртуальной машины будет автоматически создаваться его копия.

Вот наш пост с подробным разбором произошедшего: https://cloud.yandex.ru/blog/posts/2019/05/16information

$ rbd --cluster cluster1 --pool mirror rm image

Removing image: 100% complete...done.

$ rbd --cluster cluster2 --pool mirror info image

rbd: error opening image image: (2) No such file or directory

$ rbd --cluster cluster2 --pool mirror trash list --all --format json --pretty-format

[

{

"id": "10346b8b4567",

"name": "image"

}

]

$ rbd --cluster cluster2 --pool mirror trash restore --image new_image_name 10346b8b4567

$ rbd --cluster cluster2 --pool mirror ls

new_image_nameyandex.ru/legal/cloud_termsofuse/?lang=ru#index__section_hq4_3cp_1fb

Радует, что Яндекс на месте не стоит, придумывают новые сервисы и дорабатывают предыдущие.

Публичное облако всегда дешевле использовать на коротком временном промежутке. Больших капитальных затрат не требует на Оборудование, помещение и т.д.

В долгосрочной перспективе облако будет всегда или почти всегда дороже.

Поэтому облако имеет смысл использовать для проверки своих бизнес идей. Если идея выгорела, можно обдумывать переход на свое оборудование или аренду стойки в дата центре с конкретным SLA или еще что-нибудь.

Может сам Яндекс будет предоставлять услуги с требованиями по SLA для тех, кто хочет инфраструктуру на аутсорс отдать.

Про потерю данных и резервное копирование. В Условиях использования указано: «3.1. Платформа предоставляется на условиях «как есть» (as is). Яндекс не предоставляет никаких гарантий в отношении безошибочной и бесперебойной работы Платформы или отдельных её компонентов...» и так далее.

В целом от инцидента Яндекс станет только лучше. Думаю, больше они такого фейла не допустят. Но могут допустить другие :)

А про доп услугу в виде SLA им стоит подумать.

В таких случаях есть один ресурс, который никто и никогда не возместит: время. То время, которое потратите на восстановление из резервной копии, пусть даже все данные удалось спасти, и минут через немного всё заработало вполне штатно.

И да, «ложки вернули, но осадок остался». Доверия к Яндекс.Облаку теперь меньше. У меня большой опыт работы с AWS, но подобного рода ляпов там таки не было. Хотя были и потери данных, и потери виртуальных машин в целом.

Shit happens. Яндекс удалил часть виртуальных машин в своем облаке