Одна городская легенда гласит, что создатель сахарных пакетиков-палочек повесился, узнав, что потребители не разламывают их пополам над чашкой, а аккуратно отрывают кончик. Это, разумеется, не так, но если следовать такой логике, то один британский любитель пива "Гиннесс" по имени Уильям Госсет должен был не просто повеситься, но и своим вращением в гробу уже пробурить Землю до самого центра. А все потому, что его знаковое изобретение, опубликованное под псевдонимом Стьюдент, уже десятки лет используют катастрофически неправильно.

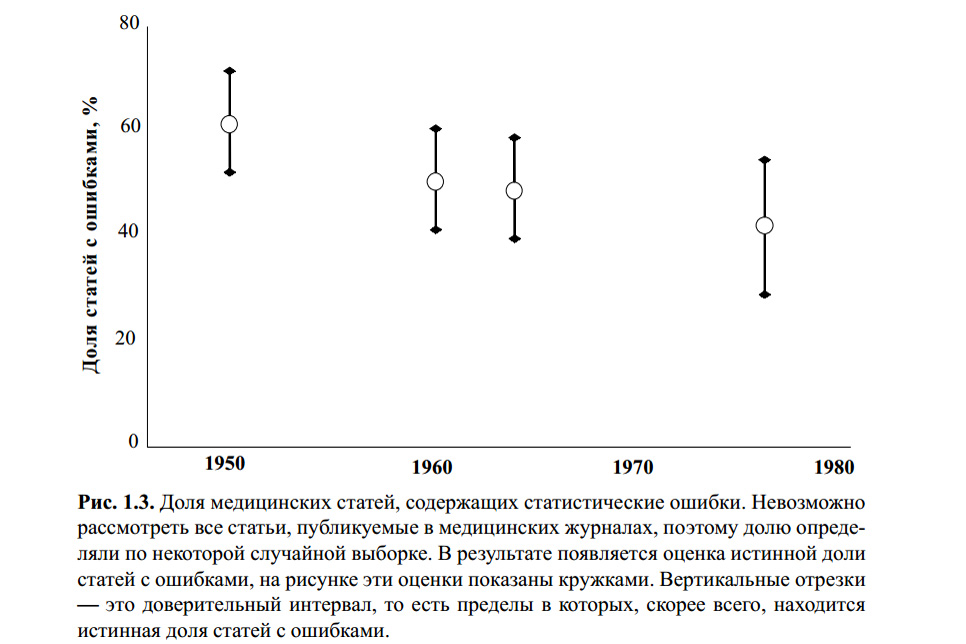

Рисунок выше приведен из книги С. Гланц. Медико-биологическая статистика. Пер. с англ. — М., Практика, 1998. — 459 с. Мне неизвестно, проверял ли кто-нибудь на статистические ошибки расчеты для этой диаграммы. Однако и ряд современных статей по теме, и мой собственный опыт говорят о том, что t-критерий Стьюдента остается самым известным, и оттого — самым популярным в применении, по поводу и без.

Причиной этому является поверхностное образование (строгие преподаватели учат, что надо "проверять статистику", иначе уууууу!), простота использования (таблицы и онлайн-калькуляторы доступны во множестве) и банальное нежелание вникать в то, что "и так работает". Большинство людей, хоть раз применявших этот критерий в своей курсовой или даже научной работе, скажут что-то вроде: "ну вот, мы сравнивали 5 злых школьников и 7 школьников-геймеров по уровню агрессии, у нас значение по таблице выходит близко к р=0,05 и это значит, что игры — зло. Ну да, не точно, а с вероятностью 95%". Сколько логических и методологических ошибок они уже сделали?

Основы

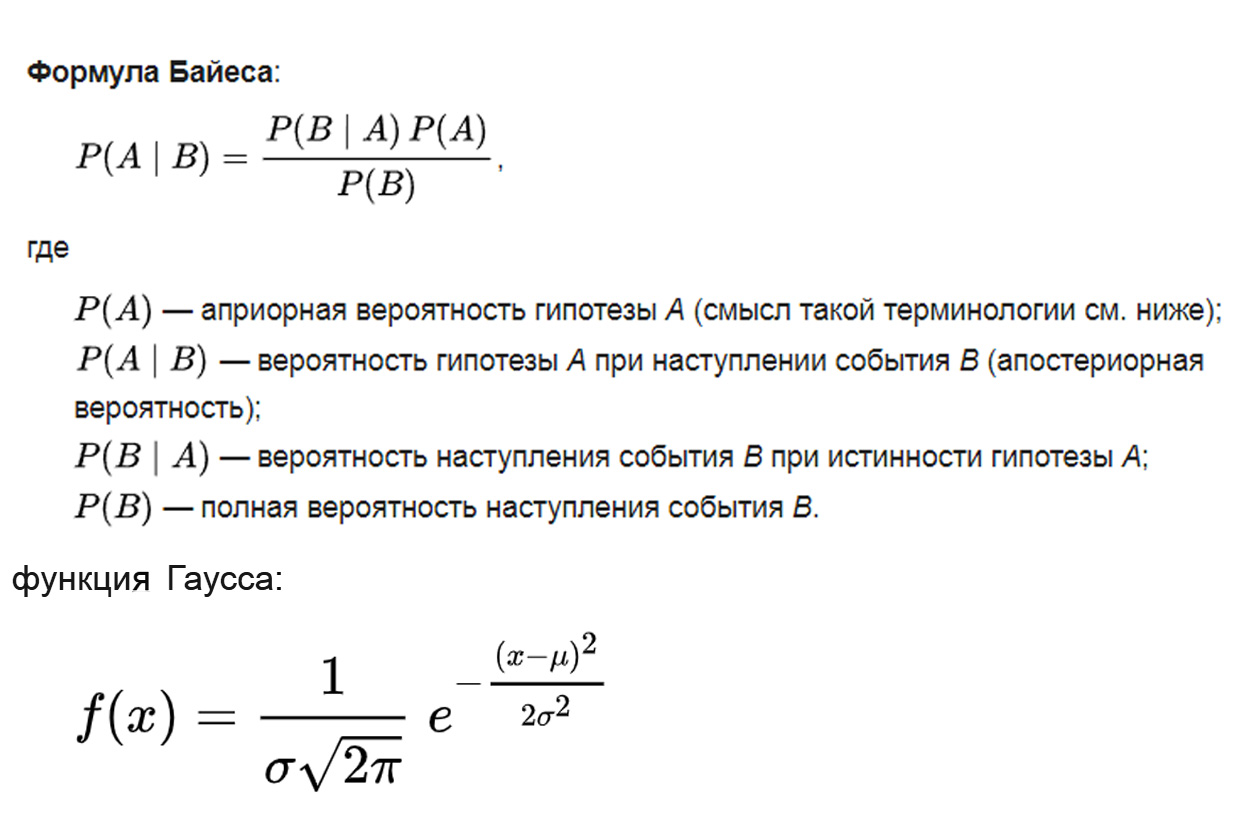

На чем основан t-критерий Стьюдента? Логика берется из теоремы Байеса, математическая основа — из распределения Гаусса, методология базируется на дисперсионном анализе:

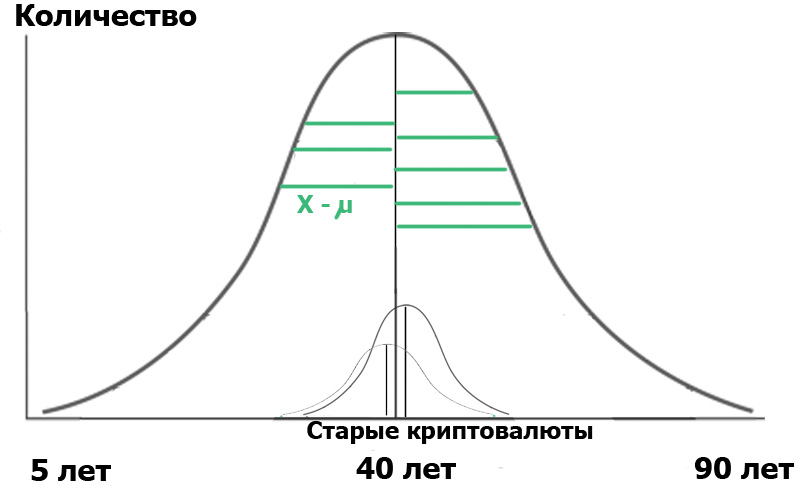

где параметр μ — математическое ожидание (среднее значение) распределения, а параметр σ — среднеквадратическое отклонение (σ ² — дисперсия) распределения.

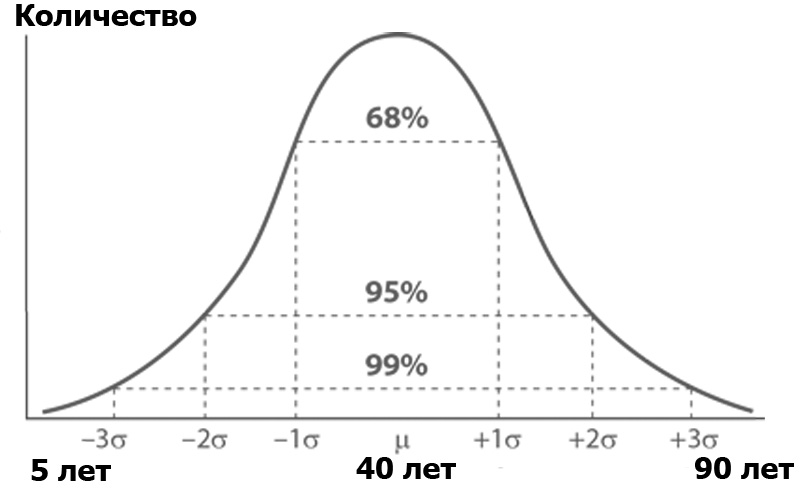

Что такое дисперсионный анализ? Представим себе аудиторию Хабра, сортированную по числу людей каждого из определенных возрастов. Количество людей по возрасту, скорее всего, будет подчиняться нормальному распределению — согласно функции Гаусса:

Нормальное распределение имеет интересное свойство — почти все его значения лежат в пределе трех стандартных отклонений от среднего значения. А что такое стандартное отклонение? Это корень из дисперсии. Дисперсия, в свою очередь — это сумма квадратов разности всех членов генеральной совокупности и среднего значения, деленная на число этих членов:

То есть, каждое значение вычли из среднего, возвели в квадрат, чтобы убить минусы, и затем взяли среднее, просто просуммировав и поделив на число этих значений. Получилась мера средней разбросанности значений относительно среднего — дисперсия.

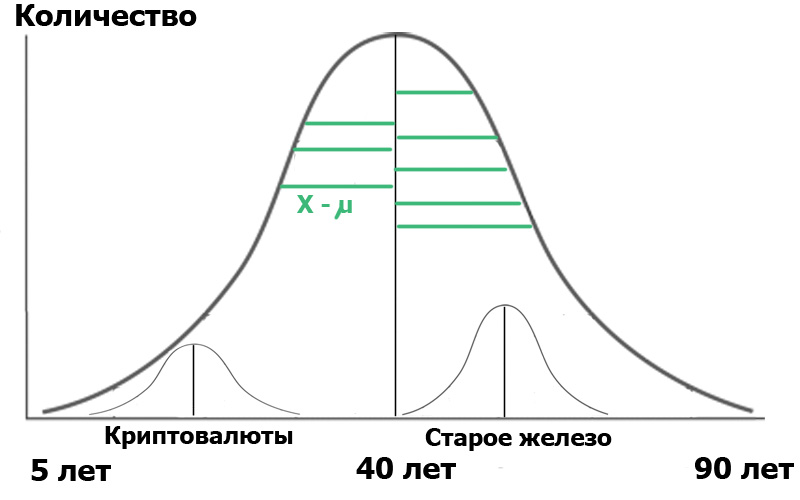

Представим, что мы отобрали в этой генеральной совокупности две выборки: читателей хаба "Криптовалюты" и читателей хаба "Старое железо". Мы распределим их по возрасту — у каждой из тем есть свое поколение фанатов. Делая случайную выборку, мы всегда получаем распределения, близкие к нормальным. Вот и сейчас у нас получились маленькие распределньица внутри нашей генеральной совокупности:

Для наглядности я показал зеленые отрезки — расстояния от точек распределения до среднего значения. Если длины этих зеленых отрезков возвести в квадрат, просуммировать и усреднить — это и будет дисперсия.

А теперь — внимание. Мы можем охарактеризовать генеральную совокупность через эти две маленькие выборки. С одной стороны, дисперсии выборок характеризуют дисперсию всей генеральной совокупности. С другой стороны, средние значения самих выборок — это тоже числа, для которых можно вычислить дисперсию! Итак: у нас есть среднее от дисперсий выборок и дисперсия средних значений выборок.

Тогда мы можем провести дисперсионный анализ, грубо представив его в виде логической формулы:

F= (дисперсия совокупности по средним значениям выборок) / (дисперсия совокупности по дисперсиям выборок)

Что нам даст вышеозначенная формула? Очень просто. В статистике все начинается с "нулевой гипотезы", которую можно сформулировать как "нам показалось", "все совпадения случайны" — по смыслу, и "не существует связи между двумя наблюдаемыми событиями" — если строго. Так вот, в нашем случае, нулевой гипотезой будет отсутствие значимых различий между возрастным распределением наших пользователей в двух хабах. В случае нулевой гипотезы наша диаграмма будет выглядеть как-то так:

Это означает, что и дисперсии выборок, и их средние значения очень близки или равны между собой, а потому, говоря очень общо, наш критерий

F= (дисперсия совокупности по средним значениям выборок)/ (дисперсия совокупности по дисперсиям выборок) = 1

А вот если дисперсии выборок равны, но возраста хабраюзеров действительно сильно отличаются, то числитель (дисперсия средних значений) будет большим, и F будет намного больше единицы. Тогда и диаграмма будет выглядеть скорее как на предыдущем рисунке. А что нам это даст? Ничего, если не обратить внимание на формулировку: нулевой гипотезой будет отсутствие значимых различий.

А вот значимость… ее мы задаем сами. Она обозначается как α и имеет следующий смысл: уровень значимости есть максимальная приемлемая вероятность ошибочно отвергнуть нулевую гипотезу. Иными словами, мы будем рассматривать наше событие как достоверное отличие одной группы от другой, только если вероятность Р нашей ошибки меньше α. Это и есть пресловутое р<0,05, потому как обычно в медико-биологических исследованиях уровень значимости задают в 5%.

Ну а дальше — все просто. В зависимости от α существуют критические значения F, начиная с которых мы отвергаем нулевую гипотезу. Они и выпускаются в виде таблиц, которыми мы так привыкли пользоваться. Это — что касается дисперсионного анализа. А что со Стьюдентом?

Так говорил Студент

А критерий Стьюдента — это просто частный случай дисперсионного анализа. Я опять не буду перегружать вас формулами, которые легко гуглятся, а передам суть:

t= (разность средних значений выборок) / (стандартная ошибка разности выборочных средних)

Так вот, все это длинное объяснение нужно было, чтобы очень грубо и бегло, но наглядно показать, на чем основан t-критерий. И соответственно, из каких его неотъемлемых свойств напрямую вытекают ограничения его использования, на которых так часто ошибаются даже профессиональные ученые.

Свойство первое: нормальность распределения.

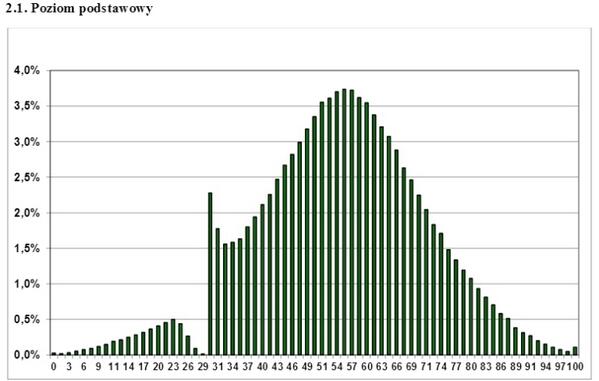

Это — пару лет как гуляющий по Интернету график распределения баллов сдачи польского государственного экзамена. Какой можно из него сделать вывод? Что этот экзамен не сдают только совсем отбитые гопники? Что преподаватели "дотягивают" учеников? Нет, только один — к распределению, отличному от нормального, нельзя применять параметрические критерии анализа, вроде Стьюдента. Если у вас однобокий, зубчатый, волнистый, дискретный график распределения — забудьте про t-критерий, его использовать нельзя. Тем не менее, это иногда успешно игнорируется даже серьезными научными работами.

Что же делать в таком случае? Использовать так называемые непараметрические критерии анализа. В них реализуется другой подход, а именно ранжирование данных, то есть уход от значений каждой из точек к присвоенному ей рангу. Эти критерии менее точны, чем параметрические, но по крайней мере их использование корректно, в отличие от ничем не оправданного использования параметрического критерия на ненормальной совокупности. Из таких критериев наиболее известен U-критерий Манна-Уитни, причем зачастую его используют как критерий "для малой выборки". Да, он позволяет иметь дело с выборками до 5 точек, но это, как уже должно быть понятно, не основное его назначение.

Свойство второе: вы же помните формулу? Значения F-критерия менялись при отличии (увеличенной дисперсии) средних значений выборок. А вот знаменатель, то есть, сами дисперсии, меняться не должны. Поэтому еще одним критерием применимости должно быть равенство дисперсий. О том, что эта проверка соблюдается еще реже, говорится например, тут: Ошибки статистического анализа биомедицинских данных. Леонов В.П. Международный журнал медицинской практики, 2007, вып. 2, стр.19-35.

Свойство третье: сравнение двух выборок. t-критерий очень любят использовать для сравнения более, чем двух групп. Делается это, как правило, следующим образом: попарно сравниваются отличия группы А от В, В от С и А от С. Затем на основании этого делается некий вывод, что является абсолютно некорректным. В этом случае возникает эффект множественных сравнений.

Получив достаточно высокое значение t в каком либо из трех сравнений исследователи сообщают что «P < 0,05». Но на самом же деле вероятность ошибки значительно превышает 5%.

Почему?

Разбираемся: допустим, в исследовании был принят уровень значимости 5%. Значит, максимальная приемлемая вероятность ошибочно отвергнуть нулевую гипотезу при сравнении групп А и В — 5%. Казалось бы, все правильно? Но ведь точно такая же ошибка произойдет в случае сравнения групп В и С, и при сравнении групп А и С тоже. Следовательно, вероятность ошибиться в целом при такого рода оценке составит не 5%, а значительно больше. В общем случае эта вероятность равна

P′ =1 − (1- 0,05 )^k

где k — число сравнений.

Тогда в нашем исследовании вероятность ошибиться при отвергании нулевой гипотезы составляет примерно 15%. При сравнении четырех групп число пар и соответственно возможных попарных сравнений равно 6. Поэтому при уровне значимости в каждом из сравнений 0,05

вероятность ошибочно обнаружить различие хотя бы в одном равна уже не 0,05, а 0,31.

Такую ошибку все же несложно устранить. Один из способов — это введение поправки Бонферрони. Неравенство Бонферрони указывает нам, что если k раз применить критерии

с уровнем значимости α, то вероятность хотя бы в одном случае найти различие там, где его нет не превышает произведения k на α. Отсюда:

α′ < αk,

где α′ — вероятность хотя бы один раз ошибочно выявить различия. Тогда наша проблема решается очень просто: нужно разделить наш уровень значимости на поправку Бонферрони — то есть, на кратность сравнений. Для трех сравнений нам необходимо взять из таблиц t-критерия значения, соответствующие α = 0,05/3 = 0,0167. Повторюсь — очень просто, но эту поправку нельзя игнорировать. Да, кстати, увлекаться этой поправкой тоже не стоит, уже после деления на 8 значения t-критерия излишне устрожаются.

Далее идут "мелочи", которые очень часто вообще не замечают. Я сознательно не привожу тут формул, чтобы не снижать читаемость текста, но следует помнить, что расчеты t-критерия варьируются для следующих случаев:

Различный размер двух выборок (вообще, нужно помнить, что в общем случае мы сравниваем две группы по формуле для двухвыборочного критерия);

Наличие зависимых выборок. Это — случаи, когда измеряют данные у одного больного в различные интервалы времени, данные у группы животных до и после эксперимента, и т. д.

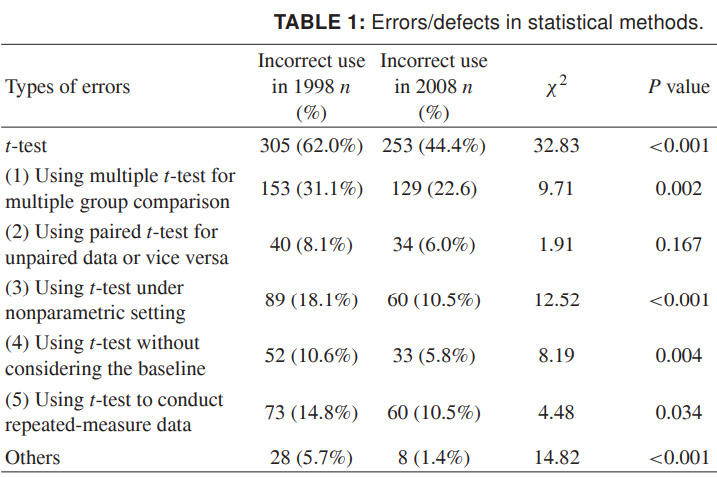

Напоследок, чтобы вы представили весь масштаб происходящего, я привожу более свежие данные по неправильному использованию t-критерия. Цифры приведены для 1998 и 2008 года для ряда китайских научных журналов, и говорят сами за себя. Очень хочется, чтобы это оказалось в большей степени небрежностью оформления, чем недостверными научными данными:

Источник: Misuse of Statistical Methods in 10 Leading Chinese Medical Journals in 1998 and 2008. Shunquan Wu et al, The Scientific World Journal, 2011, 11, 2106–2114

Помните, низкая значимость результатов — еще не такая печальная вещь, как ложный результат. Нельзя доводить до научного греха — ложных выводов — искажением данных неправильно примененной статистикой.

Про логическую интерпретацию, в том числе неправильную, статистических данных, я, пожалуй, расскажу отдельно.

Считайте правильно.