Comments 84

под хабракат пожалуйста

+1

хабракат!

+1

эх блин… Наверное я очень грубо выразился да еще плюс к этому и опоздал…

попробую по другому…

Уважаемый kalisto… Лично я не сомневаюсь что вам в институте понравилась эта лекция… Я допускаю, что она понравится и определенному кругу пользователей на хабре…

Но прокручивать ее по адресу habrahabr.ru/new/ (а у нее достаточно не маленький размер), не очень приятно. На хабре есть хабракат под который можно спрятать большую часть несомненно полезной информации…

Воспользуйтесь им пожалуйста…

попробую по другому…

Уважаемый kalisto… Лично я не сомневаюсь что вам в институте понравилась эта лекция… Я допускаю, что она понравится и определенному кругу пользователей на хабре…

Но прокручивать ее по адресу habrahabr.ru/new/ (а у нее достаточно не маленький размер), не очень приятно. На хабре есть хабракат под который можно спрятать большую часть несомненно полезной информации…

Воспользуйтесь им пожалуйста…

+4

ну вот… отписал уже что погорячился и извинился… и все равно минус… да и в карму кто-то плюнул… ну да ладно. Жизни еще длинная. Будем исправляться… :)

+1

UFO just landed and posted this here

Читал Хайкина. Интересная, но тяжелая книга.

И поправьте пожалуйста, его зовут Саймон и фамилия пишется через «и». Мало ли, кто то захочет купить :)

И поправьте пожалуйста, его зовут Саймон и фамилия пишется через «и». Мало ли, кто то захочет купить :)

0

похоже на шпаргалку :(

-1

Нейронные сети: ЛеКЦИЯ 1

0

Это автор сделал что бы с кпк на экзамене шпорами пользоваться?

0

Еще можно было бы добавить книгу поляка (или кто он там) Станислава Осовского — Нейронные сети для обработки информации.

lolbook.nnm.ru/osovskij_nejronnye_seti_dlya_obrabotki_informacii — никаких ресурсов не пеарю, просто тут про книжку написано

lolbook.nnm.ru/osovskij_nejronnye_seti_dlya_obrabotki_informacii — никаких ресурсов не пеарю, просто тут про книжку написано

+1

А у меня убрали этот предмет =\

Спасибо вам, теперь будет стимул попробовать вникнуть хоть чуть-чуть.

Надеюсь будут и следующие лекции.

+ Вам в карму.

Спасибо вам, теперь будет стимул попробовать вникнуть хоть чуть-чуть.

Надеюсь будут и следующие лекции.

+ Вам в карму.

+1

Кстати, вроде есть тематический блог — ИИ называется, вот туда и можно перенести (http://habrahabr.ru/blogs/artificial_intelligence/)

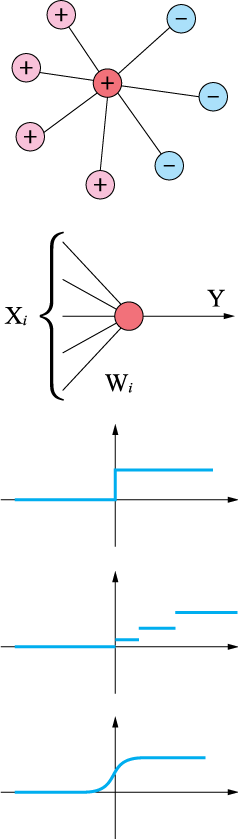

ну и пока можно поправочки ввести — функция не сигмаидальная, а сигмоидальная.

Так же к сигмоидальной можно отнести ф-ю арктангенса

ну и пока можно поправочки ввести — функция не сигмаидальная, а сигмоидальная.

Так же к сигмоидальной можно отнести ф-ю арктангенса

+2

моя магистерская работа…

распознавание образов с помощью нейронной сети. тема интересная, и в первом приближении хоть и все понятно — в реализации свои нюансы, до которых часто доходишь сам, потому что ни в каких книжках не написано… только форумы, отдельные фразы и высказывания и метод проб и ошибок…

нормальное описание есть у И. В. Заенцева «Нейронные сети: основные модели» — правда там формулы с ошибками ))) что уже выяснилось при написании программы

а вообще это довольно специфическая тема, и если честно непонятно зачем автор решил о ней написать…

распознавание образов с помощью нейронной сети. тема интересная, и в первом приближении хоть и все понятно — в реализации свои нюансы, до которых часто доходишь сам, потому что ни в каких книжках не написано… только форумы, отдельные фразы и высказывания и метод проб и ошибок…

нормальное описание есть у И. В. Заенцева «Нейронные сети: основные модели» — правда там формулы с ошибками ))) что уже выяснилось при написании программы

а вообще это довольно специфическая тема, и если честно непонятно зачем автор решил о ней написать…

+3

Ну и что, что специфичная? Отношение к IT имеет? Имеет и самое непосредственное. Не все же нам тут про гуглы и айфоны читать. Мне лично интересен данный материал. Самостоятельно бы не дошли руки поискать книги и т.д… А тут на тебе, все готовое, изложено с азов.

+5

я просто о том, что это конкретная отдельная тема, специализация. и при желании и необходимости, скачиваются книги, в которых все это описывается.

я не спорю, тема очень интересная. но имхо изложение ее здесь немного не то, которого следовало ожидать.

с одной стороны, если с серьезной точки зрения, то здесь не тот уровень задан.

если просто для ознакомления — то как раз таки для этого и есть книжки… или статьи

просто то, что тут написано — написано в начале каждой! книжки или статьи о нейронных сетях. я их в свое время прочитала достаточно. и данный уровень написания не очень хорош, даже рисунки нарисованы небрежно…

я не спорю, тема очень интересная. но имхо изложение ее здесь немного не то, которого следовало ожидать.

с одной стороны, если с серьезной точки зрения, то здесь не тот уровень задан.

если просто для ознакомления — то как раз таки для этого и есть книжки… или статьи

просто то, что тут написано — написано в начале каждой! книжки или статьи о нейронных сетях. я их в свое время прочитала достаточно. и данный уровень написания не очень хорош, даже рисунки нарисованы небрежно…

+1

На вкус и цвет все фломастеры разные.

-1

Да-да, согласен с вами, оформлено весьма небрежно. А по поводу уровня изложения, тут, наверно вам виднее, т.к. для меня это первый более-менее подробный материал на эту тему. Просто первое, что выдают поисковики в плане книг и статей на тему НС, это какие-то книги для зубров от математики, коим я не являюсь. Честно пытался пару раз начать читать такие книги, но увидев трехэтажные формулы пугался и убегал)))

Автор, я так понял, сам новичок в данной теме и, к тому же, студент, а не преподаватель. А значит умеет (ну или учится) слушать, а не излагать, поэтому сделаем ему скидку)) Будем надеется, что он учтет критику в свой адрес и примет меры))

Автор, я так понял, сам новичок в данной теме и, к тому же, студент, а не преподаватель. А значит умеет (ну или учится) слушать, а не излагать, поэтому сделаем ему скидку)) Будем надеется, что он учтет критику в свой адрес и примет меры))

+1

Немного оффтопика: а какие нейросети вы использовали для распознавания образов, и какие именно образы вы распознавали?

0

Было бы круто если бы статья была снабжена примерами кода. А теории в принципе хватает на просторах интернета.

+2

лекции, видимо, еще не дошли до реализации программ

+1

Для любителей примеров и матлаба — простенькая штучка про распознание образов:

[alphabet, targets]=prprob;

i=1; %буква A

ti=alphabet(:, i);

letter{i}=reshape(ti,5,7)';

letter{i};

[R, Q]=size(alphabet);

[S2, Q]=size(targets);

S1=10;

net=newff(minmax(alphabet),[S1 S2],{'logsig' 'logsig'},'traingdx');

net.LW{2,1}=net.LW{2,1}*0.01;

net.b{2}=net.b{2}*0.01;

gensim(net);%

% обучение без шума

P=alphabet;

T=targets;

net.performfcn='sse';

net.trainparam.goal=0.1;

net.trainparam.show=100;

net.trainparam.epochs=5000;

net.trainparam.mc=0.95;

[net, tr]=train(net, P, T);

% обучение с шумом

netn=net;

netn.trainparam.goal=0.6;

netn.trainparam.epochs=300;

T=[targets targets targets targets];

for pass=1:10

P=[alphabet, alphabet,…

(alphabet+randn(R, Q)*0.1),…

(alphabet+randn(R, Q)*0.2)];

[netn, tr]=train(netn, P, T);

end

% повторное обучение без шума

netn.trainparam.goal=0.1;

netn.trainparam.epochs=500;

net.trainparam.show=10;

[netn, tr]=train(netn, P, T);

noisya=alphabet(:,1)+randn(35,1)*0.2;

figure(1)

plotchar(noisya);

a=sim(net, noisya);

a=compet(a);

answer=find(compet(a)==1)

figure(2)

plotchar(alphabet(:, answer));

[alphabet, targets]=prprob;

i=1; %буква A

ti=alphabet(:, i);

letter{i}=reshape(ti,5,7)';

letter{i};

[R, Q]=size(alphabet);

[S2, Q]=size(targets);

S1=10;

net=newff(minmax(alphabet),[S1 S2],{'logsig' 'logsig'},'traingdx');

net.LW{2,1}=net.LW{2,1}*0.01;

net.b{2}=net.b{2}*0.01;

gensim(net);%

% обучение без шума

P=alphabet;

T=targets;

net.performfcn='sse';

net.trainparam.goal=0.1;

net.trainparam.show=100;

net.trainparam.epochs=5000;

net.trainparam.mc=0.95;

[net, tr]=train(net, P, T);

% обучение с шумом

netn=net;

netn.trainparam.goal=0.6;

netn.trainparam.epochs=300;

T=[targets targets targets targets];

for pass=1:10

P=[alphabet, alphabet,…

(alphabet+randn(R, Q)*0.1),…

(alphabet+randn(R, Q)*0.2)];

[netn, tr]=train(netn, P, T);

end

% повторное обучение без шума

netn.trainparam.goal=0.1;

netn.trainparam.epochs=500;

net.trainparam.show=10;

[netn, tr]=train(netn, P, T);

noisya=alphabet(:,1)+randn(35,1)*0.2;

figure(1)

plotchar(noisya);

a=sim(net, noisya);

a=compet(a);

answer=find(compet(a)==1)

figure(2)

plotchar(alphabet(:, answer));

+2

Есть определенное количество готового софта, которое решает задачи как средствами нейронных сетей, так и генных алгоритмов. Кстати эти эти подходы стоит рассматривать рядом, т.к. они оба из области нечеткой логики и имеют много общих достоинств (и недостатков, конечно)

0

Это понятно, что софт есть, мне просто кажется, что раз в статье рассмотрен математический алгоритм построения нейронных сетей, было бы логично привести соответствующий код(желательно, который автор сам написал) на каком-нибудь распространенном языке(C, Python, Ruby, Haskell, эзотика вроде матлаба интересна слишком узкому кругу людей).

+2

UFO just landed and posted this here

UFO just landed and posted this here

Спасибо, буду ждать продолжения.

0

UFO just landed and posted this here

Спасибо, материал интересный. Только, хотелось бы попросить автора еще раз перечитать свой текст и все-таки исправить опечаток, коих, кстати довольно много. Труд, можно сказать научный, так что будем к нему подходить серьезно со всех сторон)

+1

О, круто, хотел почитать про них, но руки все никак не доходили, теперь прочитаю точно.

0

Может я зануда, но тут даже спелл-чекер не везде поможет…

она на английском, вторая также, чуть хуже изложена, но на русском.

понимать задачи, для которых задачу сформулировать невозможно

состоит из клеток — нейрон связанных друг с другомВсё-таки нейронов.

Нейрон становиться активным, тогда. когда количество...Точка, точка, запятая, — вышла рожица смешная… Ой, это же про смайлики.

+1

я не понял что такое «КН», нигде не описанно вроде?

0

Самое интересное, что идея-то не новая. В свое время теорией нейронных сетей занимались два больших НИИ в СССР. Но к сожалению, тогда не получив каких-либо «полезных результатов» (на тот момент из-за нехватки системных ресурсов), направление прикрыли (а кто знает может и продолжили, только перевели в разряд «секретно»). Тогда нейронным сетям пророчили большое будущее, возможность создания искусственного интеллекта и т.д. Но в итоге было доказано, чтобы создать что-то мыслящее на тот момент не хватало вычислительных мощностей аппаратуры. Кто знает, может вернувшись к этой теме, при наличии нынешних мощностей комп. техники, что-то и получится? Время покажет. Автору, спасибо.

+1

К сожалению, с тех пор проблема не больно то и сдвинулась с места. Говоря простым языком: ИНС сейчас также близки к ИИ, как попытки наших предков имитировать птичьи крылья в попытках полететь.

0

Я когда-то работал в таком. НЦН РАН назывался и расшифровывался как Научный Центр Нейрокомпьютеров Российской Академии Наук (тогда уже Российской — 1992 год). Наша лаборатория мастерила язык программирования для нейрокомпьютеров, а точнее делала кальку с языка AXON по какой-то распечатке буржуйского описания этого языка.

0

молодец автор, пиши продолжение.

0

Спасибо, интересно.

Кому интересно посмотреть на простенькую реализацию — вот моя небольшая статья с примером на python: Нейронная сеть Хопфилда

Кому интересно посмотреть на простенькую реализацию — вот моя небольшая статья с примером на python: Нейронная сеть Хопфилда

+4

Забавный факт:

Как известно, современные компьютеры используют последовательные вычисления, а нейронные сети — это подход параллельных вычислений и компьютеры в железе могут быть построены и на них.

Так вот, то что мы пользуемся тем, чем пользуемся в некоторой степени случайность, т.к. до второй мировой разработка железа и под последовательные и под параллельные вычисления шла примерно одинаковыми темпами. Но первыми заказчиками оказались военные, а им нужна была точность при расчете баллистических траекторий.

А ведь все могло быть совсем по другому…

Как известно, современные компьютеры используют последовательные вычисления, а нейронные сети — это подход параллельных вычислений и компьютеры в железе могут быть построены и на них.

Так вот, то что мы пользуемся тем, чем пользуемся в некоторой степени случайность, т.к. до второй мировой разработка железа и под последовательные и под параллельные вычисления шла примерно одинаковыми темпами. Но первыми заказчиками оказались военные, а им нужна была точность при расчете баллистических траекторий.

А ведь все могло быть совсем по другому…

0

Вы забываете, что нейросети не так универсальны, как набор реле и транзисторов.

0

Нейрокомпьютер тоже на реле с транзисторами можно сделать:-)

А говоря о параллельных и последовательных вычислениях — у любого подхода есть свои сильные и слабые стороны. Но что такого принципиально не могут нейронные сети?

А говоря о параллельных и последовательных вычислениях — у любого подхода есть свои сильные и слабые стороны. Но что такого принципиально не могут нейронные сети?

0

UFO just landed and posted this here

О вот это круто! А потом больше нейронными сетями не занимались?

0

Подождите след. лекций.

Препод у нас жесткий, скорее всего пойдут объемы мат. выкладок

Препод у нас жесткий, скорее всего пойдут объемы мат. выкладок

-1

Интересный текст! Спасибо.

Маленькая поправка: нейромедиатор

Маленькая поправка: нейромедиатор

0

Нейросети хороши, когда о задаче и данных мало известно изначально. Они очень абстрактно подходят к данным. Для кластеризации есть много алгоритмов более специфических, которые работают лучше нейросетей.

То же касается устранения шума.

Из моего опыта — если есть какие-то минимальные предположения о данных, можно найти более специальные, более подходящие алгоритмы. Но если предположений нет, НС это хороший инструмент, который полезно иметь на своей «полке»

То же касается устранения шума.

Из моего опыта — если есть какие-то минимальные предположения о данных, можно найти более специальные, более подходящие алгоритмы. Но если предположений нет, НС это хороший инструмент, который полезно иметь на своей «полке»

+2

Когда изначально мало данных, то не на чем обучать сеть (мала обучающая выборка), так что она не будет выдавать желаемый результат. Хотя есть такое понятие как «обучение с учителем», когда пользоватеь сам говорит насколько это близко к тому что он хотел получить. Но опять же ресурсы… не машинные, но человеческие

0

Я имел в виду ситуацию, когда мало не самих данных, а информации о их структуре. Ну например есть какой-то большой массив многомерных данных, никаких предположений о их внутренней организации — на первую прикидку можно использовать нейросеть типа карты Кохонена, чтобы заценить что из себя данные представляют, увидеть какие-то закономерности, если повезет.

Но для одних случаев простые деревья решений дают намного лучший, устойчивый и наглядный результат чем нейросети. Для более сложных случаев — классный метод кластеризации SP-clustering.

В общем не стоить ждать от нейросетей чудес. Хотя идея сама по себе красивая.

Но для одних случаев простые деревья решений дают намного лучший, устойчивый и наглядный результат чем нейросети. Для более сложных случаев — классный метод кластеризации SP-clustering.

В общем не стоить ждать от нейросетей чудес. Хотя идея сама по себе красивая.

+2

Господа, не забывайте, что вы ведете разговор не о самих нейронных сетях, а о программных нейроимитаторах. Сама концепция, а именно преимущества, нейронных сетей заключаются в параллельной обработке входных сигналов (данных). Поэтому не стоит делать поспешных выводов о целесообразности применения ИНС в той или иной задаче.

+1

Для меня как для человека, который о НС только слышал, статья оказалась не совсем понятной. Есть ряд вещей, которые автор упомянул, но не раскрыл хотя бы небольшим примером. Примеры(лучше из жизни) всегда делают лекцию более живой, понятной и более усваиваемой. Надеюсь автор это учтет при написании лекции №2.

В целом — лекция понравилась.

В целом — лекция понравилась.

0

Спасибо за статью! Единственно непонятно почему не склоняются термины (которые выделены жирным). Наверное в этом есть какой-то смысл при индексировании и запоминании, но читать неприятно.

0

Замечательно. Спасибо большое.

У нас тоже этот предмет есть, но лекторр чтото увлекся введениями и ничего толкового ещё не рассказал.

У нас тоже этот предмет есть, но лекторр чтото увлекся введениями и ничего толкового ещё не рассказал.

0

Даю ссылку на архив с нормальными иллюстрациями к статье. Файлы в формате EPS, созданные в Люстре CS3. Надеюсь, что вы знаете что с ними делать, если я где-то ошибся, например в графике сигмоидальной функции.

Ну и сама картинка со всеми иллюстрациями:

Ну и сама картинка со всеми иллюстрациями:

+2

Картинки только у меня не грузятся?

0

Sign up to leave a comment.

Articles

Change theme settings

Нейронные сети: Лекция 1