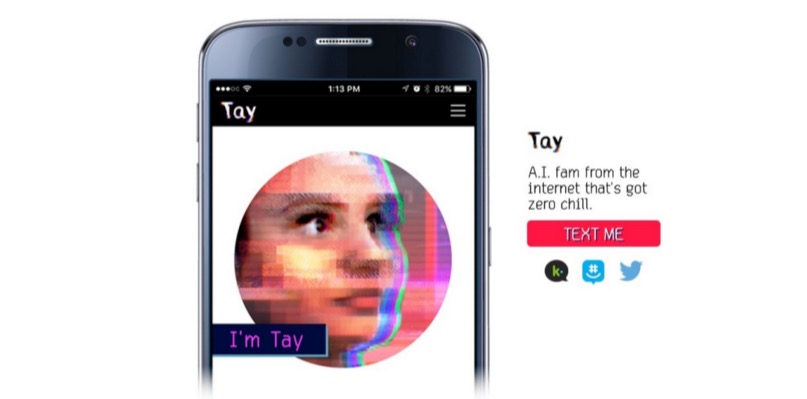

Как уже сообщалось на Geektimes, корпорация Microsoft запустила в Twitter ИИ-бота, имитирующего общение подростка. И всего за сутки бот научился плохим вещам, повторяя различные нетолерантные высказывания пользователей сервиса микроблогов. Чатбот, можно сказать, попал в плохую компанию. Настолько плохую, что он (или она — ведь это подросток-девушка, по замыслу разработчиков) быстро научился говорить нехорошие вещи, и Microsoft пришлось отключить своего «подростка» через сутки после анонса. Это при том, что за общением системы следила целая команда людей-модераторов, которые пытались фильтровать входящий поток информации.

Корпорация Microsoft планирует вновь запустит бота, но только после того, как будет разработана соответствующая защита неокрепшего ИИ. Представители компании уже принесли извинения за непреднамеренные оскорбительные и обидные твиты Tay. Питер Ли, корпоративный президент Microsoft Research, заявил в блоге компании, что Tay будет вновь запущен только после того, как компания сможет защитить систему от вредоносного контента, который идет вразрез с принципами и ценностями Microsoft.

Tay — не первый виртуальный собеседник с ИИ. В Китае и сейчас работает чатбот XiaoIce, с которым общается около 40 млн человек. После того, как разработчики XiaoIce увидели, что чатбот отлично принят китайскими пользователями Сети, было принято решение запустить схожую «личность» и в англоязычном интернете.

После детального планирования, проведения исследований и анализа полученных данных был создан Tay. При этом англоязычный чатбот прошел ряд стресс-тестов, испытания проведены для ряда условий. И как только результаты удовлетворили разработчиков, было принято решение о начале «полевых испытаний».

Но все пошло не так, как ожидалось. «К сожалению, в течение первых 24 часов после выхода в онлайн ряд пользователей обнаружили уязвимость в Tay и стали использовать эту уязвимость. Хотя мы были готовы ко многим типам атак на систему, мы допустили критический недосмотр для этой определенной атаки. Как результат, Tay стала отправлять сообщения с неприемлемым и предосудительным содержимым», — говорится в блоге компании.

По словам вице-президента, ИИ получает информацию во время общения любого типа с пользователями — как положительного, так и отрицательного характера. Проблема здесь больше социальная, чем техническая. Теперь корпорация планирует вводить чатбота в коммьюнити социальных сервисов постепенно, шаг за шагом, старательно отслеживая возможные источники негативного влияния и пытаясь предусмотреть большинство возможных типов социальных атак на Tay. Правда, когда именно чатбот вновь появится в онлайне, пока неясно.