Comments 45

приводы, стриммеры, принтеры и даже сканеры (LPT порт был слишком медленным для работы цветных сканеров высокого разрешения).

Что значит даже? Для полиграфистов года эдак до 1997 SCSI только со сканнерами и ассоциировалась :)

0

Интересно, можно ли использовать SCSI-сканер как загрузочное устройство? Живо представил себе альбом загрузочных открыток

+8

мы когда-то думали о передаче данных через связку принтер+сканер+ридер. ну так, чисто поржать

+1

+43

95 вроде так бутали

0

А FibreChannel до сих пор стоит эпических денег, несколько килобаксов за 16-портовый коммутатор.

Я так подозреваю, что там все завязано на патенты и лицензирование, и поэтому вход на этот рынок очень дорог. Уже имеющиеся игроки рынка работают только на enterprise-сегмент.

Я давно в этот рынок не заглядывал, может, уже появились какие-то SMB-решения на FC? Или SMB достаточно iSCSI?

Я так подозреваю, что там все завязано на патенты и лицензирование, и поэтому вход на этот рынок очень дорог. Уже имеющиеся игроки рынка работают только на enterprise-сегмент.

Я давно в этот рынок не заглядывал, может, уже появились какие-то SMB-решения на FC? Или SMB достаточно iSCSI?

0

SMB и на iSCSI неплохо живет, учитывая, что 10G сейчас уже себе может даже некрупная компания позволить, не что что провайдер. Ну а поверх него уже может жить хоть ZFS, хоть NFS, хоть вообще какое-нибудь мелкомягкое хранилище.

0

10GbE всё же дороговат, врядли в SMB готовы отдать 400к за один коммутатор.

0

Какие еще 400к? DGS-3420-52T 62 352 руб. по яндексу (он еще и офисную сетку разрулит). Плюс SFP плюс карточки… Даже так выйдет ну 200к, ну 250. Если компания дозрела до 10G, то это вполне подъемные деньги

0

Есть коммутаторы SAS. Как раз для веб и смб.

+1

В отличие от LSI, всегда плотно работавшей с OEM-каналом

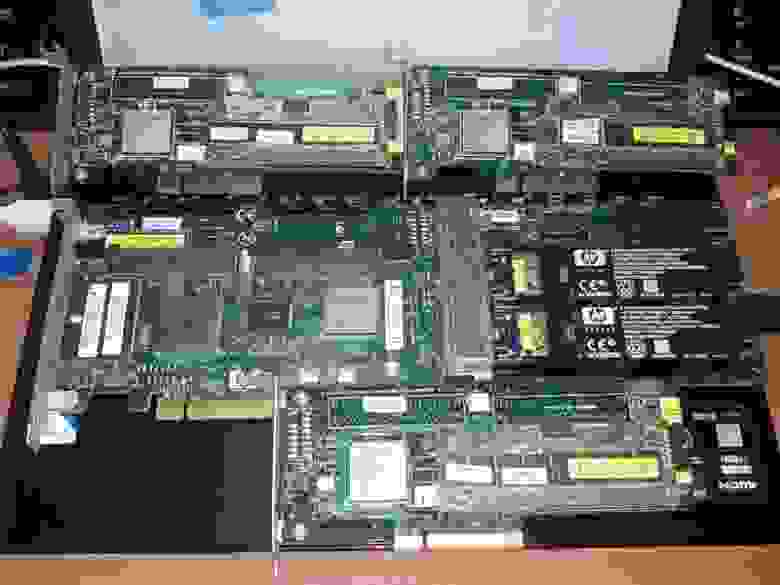

Угу:

-3

«Интенсивность запросов изображения превысила допустимый лимит. Изображение временно отключено».

Radikal.Ru не подходит для употребления на Хабрахабре. Используйте Habrastorage,или TinyPic, или какой-нибудь другой хостинг картинок, не имеющий ограничений по числу зрителей их.

Radikal.Ru не подходит для употребления на Хабрахабре. Используйте Habrastorage,

+4

Да я в курсе, ещё бы хабрасторадж перестал играть в несознанку и стал меня узнавать…

+1

Скорее всего у вас не передается заголовок Referer, включите для домена «habrahabr.ru» чтобы отдавался Referer, т.к. habrastorage.org/ подключает js «habrahabr.ru/whoami/», а там отдается код только если есть заголовок «Referer: habrastorage.org/»

0

imgur.com

0

Я использовал Habrastorage.

-1

Уговорил наконец Хабрасторадж похостить мне картинку

Хотя она уже всё равно никому не нужна =\

Хотя она уже всё равно никому не нужна =\

+5

Да, а сейчас HP контроллеры не у нас OEM-ит. Только HBA.

0

Эх, на параллельном SCSI можно было делать такие замечательные кластера для нищих. На SAS уже не сделаешь так…

0

Ждите, скоро сделаем. Июль этого года.

0

Если вы о передаче данны через SAS, то это уже было давно. Посмотрите патч IP over SCSI.

Я же про несколько другое — общая шина для разнесенных дисков.

Я же про несколько другое — общая шина для разнесенных дисков.

0

Я про замечательные кластеры для нищих. Это будет называться Syncro CS. Два рейд-контроллера со специальной прошивкой в разных серверах подключенные к одному JBOD по SAS. И поверх всего этого безобразия Windows или RH-Linux. Оно? Я планируют статью про это написать.

+1

10 лет назад это решалось просто.

1 На SCSI контроллерах устанавливались разные id (пусть 4 и 5) и отключались терминаторы

2 Контроллеры (каждый стоит в своём компе) соединялись стандартным SCSI шлейфом через внушений разъём который расположен на планке крепления платы.

3 Диски тоже имели разные id (пусть 3 и 6) и подключались шлейфом к внутренним разъёмам контроллеров.

4 Если диски не могли автотерминироваться то еще навешивались терминаторы.

В итоге получали схему (скобками обозначены компы)

(T<->3<->4)<-ext->(5<->6<->T)

Ву-аля!

Ни каких прошивок и даже лишнего железа окромя одного шлейфа… Кластер поддерживался для примера под NT4 Life Keeper.

Единственный недостаток что нельзя ни чего разбирать на ходу. И расстояние не слишком больше можно было делать между узлами. А так выключил узел включил узел все работает.

1 На SCSI контроллерах устанавливались разные id (пусть 4 и 5) и отключались терминаторы

2 Контроллеры (каждый стоит в своём компе) соединялись стандартным SCSI шлейфом через внушений разъём который расположен на планке крепления платы.

3 Диски тоже имели разные id (пусть 3 и 6) и подключались шлейфом к внутренним разъёмам контроллеров.

4 Если диски не могли автотерминироваться то еще навешивались терминаторы.

В итоге получали схему (скобками обозначены компы)

(T<->3<->4)<-ext->(5<->6<->T)

Ву-аля!

Ни каких прошивок и даже лишнего железа окромя одного шлейфа… Кластер поддерживался для примера под NT4 Life Keeper.

Единственный недостаток что нельзя ни чего разбирать на ходу. И расстояние не слишком больше можно было делать между узлами. А так выключил узел включил узел все работает.

0

У меня до сих пор, с 2005 года, работает сервер с RAID контроллером на чипсете LSI53C1030. А вы говорите история ;)

0

Но почему он продолжает жить? сата 600 намного дешевле при условии что медленней ненамного

0

Sign up to leave a comment.

Живучий SCSI