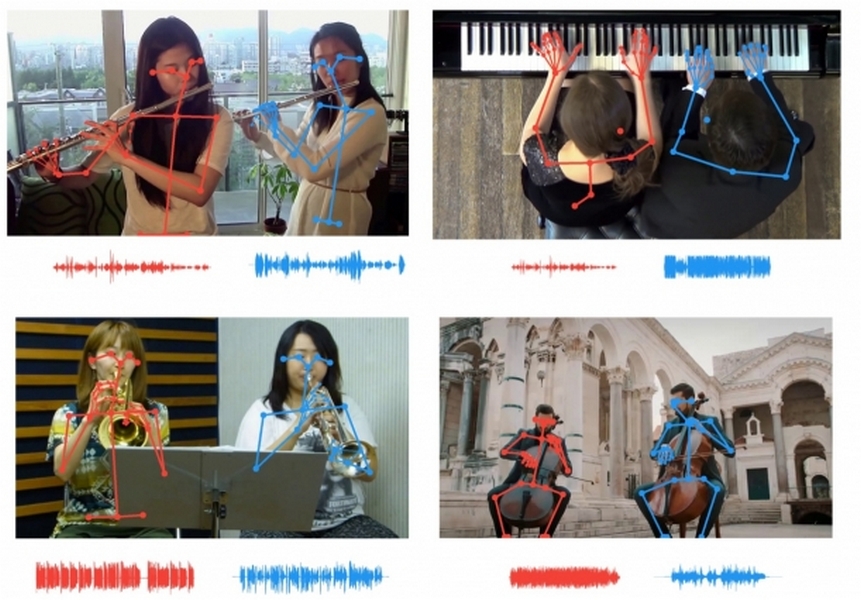

Исследователи Массачусетского технологического института представили нейросеть, которая анализирует движения тела, чтобы определить звуки отдельных инструментов. Она сопоставляет движения музыкантов с темпом отдельных партий, позволяя выделить одну флейту или одну скрипку из ряда подобных инструментов.

Инструмент Music Gesture можно применять для разных задач: от микширования звука и увеличения громкости инструмента в записи и до снижения уровня посторонних шумов, которые могут служить помехой во время видеоконференцсвязи.

В этом и других подобных проектах исследователи использовали синхронизированные аудио-видео-треки для обучения. Антонио Торралба, профессор МТИ и соавтор исследования, отмечает: «Мультисенсорная обработка является предшественником систем ИИ, которые смогут выполнять более сложные задачи».

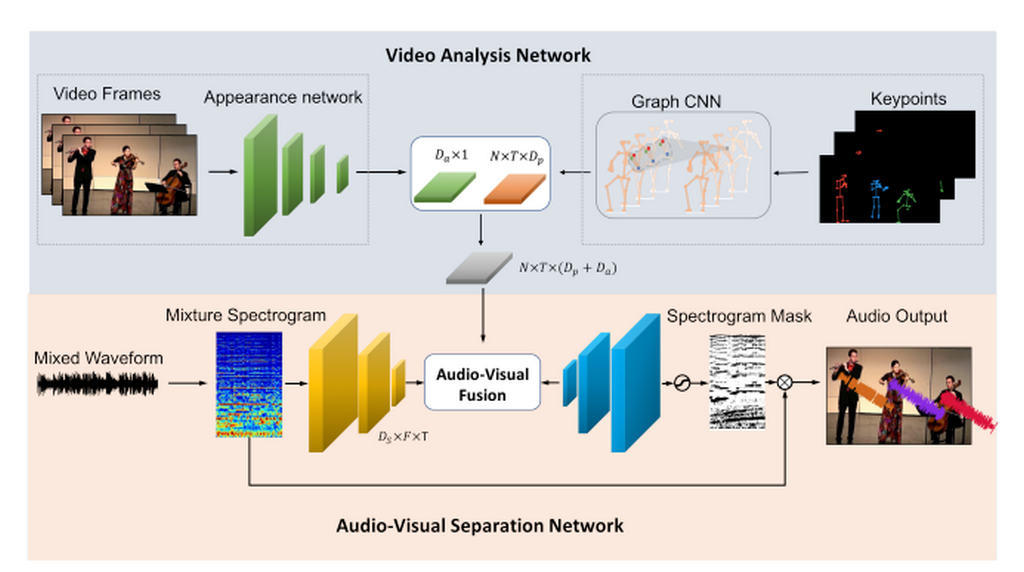

Сначала ученые применили контекстно-зависимую графовую сеть для интеграции визуального семантического контекста с динамикой тела, и затем — аудиовизуальную модель слияния, чтобы связать движения тела с соответствующими звуковыми сигналами.

Текущий инструмент базируется на другой работе, в которой использовали сигналы движения в последовательностях изображений. Ее самое раннее воплощение, PixelPlayer, позволяло кликать на определенный инструмент в концертном видео, чтобы сделать его звучание громче или тише.

Обновление PixelPlayer позволяет различать две скрипки в дуэте, сопоставляя движения каждого музыканта с темпом партии. Новейшая версия включает анализ данных о ключевых положениях тела, которые используют также спортивные комментаторы для отслеживания движений спортсменов. Это позволяет получить более точные данные, чтобы отличить почти идентичные звуки, производимые музыкантами.

Ранее исследователи использовала модели глубокого обучения, обученные на парных аудио-видео данных, чтобы научить их распознавать естественные звуки, такие как пение птиц или рокот волн. Между тем Google в сотрудничестве с орнитологической лабораторией Корнелльского университета уже запустила конкурс по созданию алгоритма, который будет распознавать и классифицировать птичьи голоса.

Модели глубокого обучения также могут определять географические координаты движущегося автомобиля по звуку его двигателя и шин, катящихся к микрофону или от него. В последнем исследовании МТИ предполагается, что инструменты слежения за звуком могут служить полезным решением для автомобилей с автопилотом, дополняя работу камер при плохих условиях вождения. Отмечается, что звуковые трекеры могут помочь в управлении ночью или в плохую погоду.

См. также: