Comments 133

А кэширование горячего контента сделали или файла идет с диска?

0

*или скачивание файла идет с диска

0

Да, кэширование на ssd'шках, по мере роста нагрузки будет подбираться эффективные параметры работы кэш-серверов.

+2

Сейчас потестим :)

+2

Обязательно потом расскажите о результатах =)

0

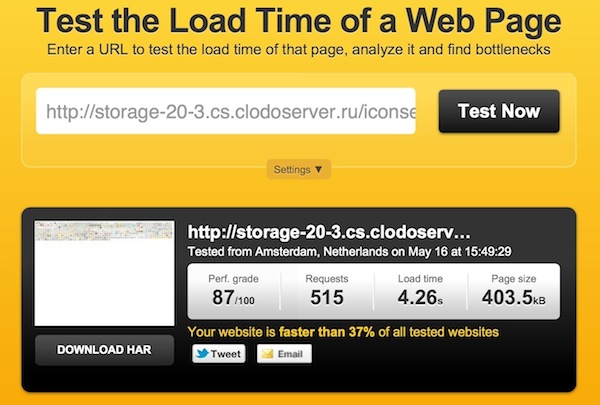

Протестировал через сервис tools.pingdom.com/fpt/

Storage от Selectel

Storage от clodo.ru

У вас сколько уровней кэширования?

Storage от Selectel

Storage от clodo.ru

У вас сколько уровней кэширования?

+4

UFO just landed and posted this here

Если кому не хватит перечисленных промо-кодов, отдаю свой: Z2AYPAO2AL.

0

В сравнении, на мой взгляд, не хватает Google Cloud Storage (бывший Google Storage for Developers).

0

Расскажите лучше как именно всё у вас работает. Используете весь комплекс Open-Stack или только Swift? Форкали ли его под свои задачи?

0

Зачем весь стек OpenStack? Только swift. Модифицировать оригинальный код не пришлось (пока :-)), а о деталях устройства будет рассказано отдельно.

+3

Ну например nova для динамического управления виртуальными машинами в облаке :)

Просто знакомые ребята из компании N используют swift в своём облачном хранилище и упираются во многие недоработки, в результате сейчас пилят свой форк.

Просто знакомые ребята из компании N используют swift в своём облачном хранилище и упираются во многие недоработки, в результате сейчас пилят свой форк.

0

Лично я не очень в восторге от кода swift и периодически хотелось (и приходилось) его пилить, но в результате наше решение обходится без модификаций их кода. Причем заложена возможность поменять бекэнд хранилища (swift) на что-то другое если очень уж захочется :-)

А облачные ВМ у нас построены не на OpenStack.

А облачные ВМ у нас построены не на OpenStack.

+2

UFO just landed and posted this here

Максимальный размер файла в S3 — 5 гигабайт при использовании одной команды PUT или же 5 терабайт при добавлении с использованием multipart uploading.

+3

Swift и соответственно наше хранилище тоже поддерживанию загрузку файлов больше 5Гб через специальное API — docs.openstack.org/api/openstack-object-storage/1.0/content/large-object-creation.html

+2

Очень интересно.

Не понял только, что дает промо-код :)

Не понял только, что дает промо-код :)

+1

А почему я тыкаю в «Хранилище» и попадаю в «Данные плательщика»?

Что нужно для заказа услуги?

Что нужно для заказа услуги?

+1

Селектел нашел наконец админа-копирайтера?)

+1

А аналог Amazon simpledb не планируете?

+2

Радует возможность доступа по FTP. Такое хранилище хорошо подходит для хранения бекапов сайтов/БД/почты и т.д…

0

На сколько понимаю, трафик между облаком и хранилищем учитывается как исходящий в облаке?

0

А если файл-архив с резервной копией весит больше 5Гб?

0

Задам вопрос по-другому. У меня у вас облачный аккаунт, крупный. Некоторые архивы больше 5Гб. На нем стоит ISPmanager. Как это все подружить с вашим Storage? Без бубна и такой-то матери?

0

При создании архива делите его на тома меньшего размера, очевидно же =)

+3

Баланс у вас пополнить нелья, paysecure.ru/ лежит.

0

Хм, а теперь меньше 100 рублей через Qiwi уже нельзя зачислить?

Или для всех методов оплаты это не деньги, теперь?

Или для всех методов оплаты это не деньги, теперь?

+1

Люто бешено плюсую. Надеюсь при минимальной цене качество не пострадает! :)

0

Какова задержка между хранилищем и облаком?

Возможно ли создать несколько контейнеров? Если да, то каково максимальное их кол-во?

Возможно ли создать несколько контейнеров? Если да, то каково максимальное их кол-во?

0

А где можно посмотреть на SLA для данной услуги?

+1

SLA пока нет, есть стандартный договор selectel.ru/about/documents/

0

Эм… И как мне по стандартному договору узнать гарантированную надежность и работоспособность вашего сервиса? У Amazon я её точно знаю — 99,99% для RRS и 99.999999999% для обычного стораджа.

+2

Вы же понимаете, что эти цифры не имеют физической силы и даже у Amazon'а может все рухнуть на день-два, чтобы они там не писали у себя в SLA. В SLA более важны пункты о размере компенсаций/неустойки, в этом плане мы всегда идем на встречу клиентам, и в случае неполадок с нашей стороны, обязательно выплачиваем компенсации клиентам.

-1

Вы не правы. Я говорю как активный потребитель услуг S3. Мы храним на S3 несколько десятков терабайт данных клиентов (мы работаем в b2b сегменте), при этом для нас важно насколько эти данные в сохранности — Amazon в данном случае сохранность и доступность гарантирует. Ни о каких компенсациях в случае потерь (про недоступность мы не говорим) говорить не имеет смысла, так как финансовые потери, что понесем мы и наши клиенты, а так же репутационные потери вы при всем желании не сможете компенсировать. Идти и предлагать руководству переход с S3 на Selectel со словами «Они обещают если, что, всё компенсировать» как вы понимаете не серьезно.

0

а в чем гарантии амазона-то? в кусочке текста на сайте где написано что они не упадут? а что Вы будете делать когда упадут?

+2

Тут штука не в гарантиях, а в аргументах для начальства)

0

У Амазона есть определенная репутация, которой он рискует в случае нарушения заявленных в SLA гарантий. Это очень серьезный риск.

Кстати любимый всеми DropBox хранит все данные как раз на серверах Амазона. Для вас это что-нибудь значит? ;)

Кстати любимый всеми DropBox хранит все данные как раз на серверах Амазона. Для вас это что-нибудь значит? ;)

+1

Меня мало волнует репутация амазона, я никому не доверяю, и делаю бэкапы даже сверх-надежных вещей, которые «в принципе не могут упасть», как например облако селектела со злополучным багом в линуксе, или факап гугла с потерей данных пользователей почты.

Однако когда оно упадет, мне будет намного удобнее стрясти компенсацию с селектела, например (не дай бог конечно), чем сидеть, держась за голову, и говорить «ну зато у них репутация пострадала».

Однако когда оно упадет, мне будет намного удобнее стрясти компенсацию с селектела, например (не дай бог конечно), чем сидеть, держась за голову, и говорить «ну зато у них репутация пострадала».

0

Мне больше нечего вам сказать, суть моего комментария вы не уловили.

0

Сравнение тарифов не полное, но не буду рекламировать себя и конкурентов.

Есть цены более вкусные.

Есть цены более вкусные.

0

UFO just landed and posted this here

А вам известны компании которые предоставляют услуги облачного хранения на базе elliptics? Сам проект то интересен, но у swift уже много коммерческих пользователей и стабильное api которое много кто поддерживает, например битрикс :-))

+1

Я возвращаюсь с cloudconf'а — де-факто swift можно считать установившимся стандартом. Он всех устраивает по функционалу и причин «почему не он» (именно в рамках object storage) никто привести не может.

То есть к реализации претензии могут быть — а к модели работы и API?

То есть к реализации претензии могут быть — а к модели работы и API?

+2

UFO just landed and posted this here

Я может что то делаю не так, но у меня через curlftpfs если копировать папку с облака на первый проход пишет не возможно создать файл, а сам создает папки и файлы по 0б, а на второй пишет IO ошибка и файл заливает и всё ок.

cp -v -R {source} {dest}0

UFO just landed and posted this here

UFO just landed and posted this here

Тоже столкнулся с первой проблемой. У меня уже 6 часов прошло, панель все еще не дает привязать домен к контейнеру. В итоге файлы с облака недоступны пользователям сайта.

0

А зачем вы даете пользователям ссылки на файлы которые еще не доступны?

+3

файлы лежали в хранилище Clodo, решил перенести в Selectel

+2

Обновление ДНС действительно может занимать много времени (особенно если вы меняете запись, а не задаете новую), но на это, как вы понимаете, мы никак не можем повлиять — так уж ДНС устроен.

Сама проверка на соответствие ДНС записи необходима как защита от «угона» чужих доменов. Поэтому пока запись не добавите и тайаут кэша ДНС не пройдет привязка домена не будет выполнена.

Если вы переносите свои данные к нам, то было бы логично сначала потестить на новом домене (тогда и проблем с кэшированием ДНС не будет), а потом перевести на основной. Учитывая что мы позволяем привязывать несколько доменов к одному контейнеру такой сценарий не создаст проблем для пользователей вашего сайта.

Сама проверка на соответствие ДНС записи необходима как защита от «угона» чужих доменов. Поэтому пока запись не добавите и тайаут кэша ДНС не пройдет привязка домена не будет выполнена.

Если вы переносите свои данные к нам, то было бы логично сначала потестить на новом домене (тогда и проблем с кэшированием ДНС не будет), а потом перевести на основной. Учитывая что мы позволяем привязывать несколько доменов к одному контейнеру такой сценарий не создаст проблем для пользователей вашего сайта.

+3

Эмигрант :)

+1

А как часто обновляется табличка «Потребление»?

0

Обновление данных (в том числе всех параметров внутри веб-панели) может происходить с задержкой до 5-10 минут.

+1

Счетчики скачиваний да, запаздывают на какие-то секунды, максимум минуты.

А вот на вкладке «Потребление» все по нулям спустя почти сутки.

Тестовые объемы скачиваний были небольшие — но на пару копеек там вроде как должно было набежать.

А вот на вкладке «Потребление» все по нулям спустя почти сутки.

Тестовые объемы скачиваний были небольшие — но на пару копеек там вроде как должно было набежать.

0

Огромное количество опечаток в доке по API — куда направить перечень?

+2

В Opera 11.64 через веб-интерфейс выбираю «Создать каталог», но высвечивает: «Ошибка передачи файла в хранилище» и создается файл с тем именем которое вводилось для папки.

0

Кхм…

Насчет нецелевого использования облака оно может и верно, но по цене облако чуток но дешевле получается: 0.64-0.74 против 0.8.

Опять таки это сужает область применения хранилища. Довод про 3-х кратное резервирование конечно хорош, но после неприятной истории с Amazon панацеей я это не считаю, да и насколько помню, облаку тоже гарантировали что-то подобное.

Насчет нецелевого использования облака оно может и верно, но по цене облако чуток но дешевле получается: 0.64-0.74 против 0.8.

Опять таки это сужает область применения хранилища. Довод про 3-х кратное резервирование конечно хорош, но после неприятной истории с Amazon панацеей я это не считаю, да и насколько помню, облаку тоже гарантировали что-то подобное.

0

Тариф на хранение данных такой же как и в облаке на дисках, а трафик в два раза дешевле. Откуда вы взяли числа 0.64-0.74?

+1

Облако:

Сеть: отправлено (исходящий трафик): 64 копейки за гигабайт

Диск: прочитанный/записанный объем: 10 копеек за гигабайт

Хранилище

Сеть (исходящий трафик): 0.8 руб. за Гб

Внимание вопрос, с чего вы взяли, что трафик в 2 раза дешевле? Написано же 0.8.

Сеть: отправлено (исходящий трафик): 64 копейки за гигабайт

Диск: прочитанный/записанный объем: 10 копеек за гигабайт

Хранилище

Сеть (исходящий трафик): 0.8 руб. за Гб

Внимание вопрос, с чего вы взяли, что трафик в 2 раза дешевле? Написано же 0.8.

-1

А почему вы сравниватие стоимость хранения в сторадже и стоимость прочитаного/записанного объема данных системой в облаке?

Стоимость хранения на сторадже и хранение данных на виртуальной машине в облаке равны.

Исходящий трафик чуть дороже, но вы совершенно ничего не платите за входящий…

Стоимость хранения на сторадже и хранение данных на виртуальной машине в облаке равны.

Исходящий трафик чуть дороже, но вы совершенно ничего не платите за входящий…

0

Я не сравниваю стоимость хранения. Стоимость хранения, на текущий момент, одинаковая.

Почему не учитываю входящий трафик? Я за него и так не плачу. Точнее, объем GET запросов даже меньше, чем объем «мусора» идущего со стороны интернета.

То есть в сумме, хранилище получается хоть немного но дороже. А где выгода? Надо же и стоимость миграции учитывать тоже…

Признаюсь, мне хранилище импонирует, но при его использовании я потеряю от 12 до 37%. И меня это печалит.

Почему не учитываю входящий трафик? Я за него и так не плачу. Точнее, объем GET запросов даже меньше, чем объем «мусора» идущего со стороны интернета.

То есть в сумме, хранилище получается хоть немного но дороже. А где выгода? Надо же и стоимость миграции учитывать тоже…

Признаюсь, мне хранилище импонирует, но при его использовании я потеряю от 12 до 37%. И меня это печалит.

+1

Удивляюсь я с ваших расчетов, но больше всего мне интересна причина, по которой вы не учитываете стоимость таких ресурсов как оперативная память, процессорное время и стоимость всех операций ввода/вывода.

Есть 5Гб контента, надо раздать 1Тб.

Хранилище за месяц:

Закачать 5Гб — бесплатно

Раздать 1Тб — 800 рублей

Хранение — 16.20 рублей

Итого: 816.20 рублей

Берем виртуалку со средним количеством оперативной памяти равной 256Мб(достаточно для раздачи статики):

Расчет за месяц:

Оперативная память — 105рублей

Закачать 5Гб контента — 1.30 рублей

Раздать 1Тб контента — 740 рублей

Хранение — 16.20 рублей

Получается примерно 862.5 и это еще без учета стоимости всех операций ввода вывода…

Есть 5Гб контента, надо раздать 1Тб.

Хранилище за месяц:

Закачать 5Гб — бесплатно

Раздать 1Тб — 800 рублей

Хранение — 16.20 рублей

Итого: 816.20 рублей

Берем виртуалку со средним количеством оперативной памяти равной 256Мб(достаточно для раздачи статики):

Расчет за месяц:

Оперативная память — 105рублей

Закачать 5Гб контента — 1.30 рублей

Раздать 1Тб контента — 740 рублей

Хранение — 16.20 рублей

Получается примерно 862.5 и это еще без учета стоимости всех операций ввода вывода…

0

Все зависит от методики подсчета. Если хранить и отдавать допустим ISO и отдавать чем-нибудь «толстым» апачем, допустим, то да, ваши расчеты имеют право быть.

Насчет 256Мб для статики вы усложняете. Достаточно 64 и будет работать, но у вас 128 это минимум. Плюсуем сюда еще такую штуку как архивы. Информация хранится в архивах, отдается распакованной. Плюс забор файлов не рандомный, то есть 128Мб еще и на небольшой кеш хватает.

Так проценты и накапливаются.

Насчет 256Мб для статики вы усложняете. Достаточно 64 и будет работать, но у вас 128 это минимум. Плюсуем сюда еще такую штуку как архивы. Информация хранится в архивах, отдается распакованной. Плюс забор файлов не рандомный, то есть 128Мб еще и на небольшой кеш хватает.

Так проценты и накапливаются.

+1

Не могли бы вы привести свою методику подсчета?

0

Зачем?

Нет, если вам интересно, то 12-37% это при решении задачи через API и ухищрения.

При решении «в лоб» все гораздо скучнее получается. Как я говорил, в моем случае информация в виде архивов хранится, поэтому хранимый объем был бы разный для облака и для хранилища и разница достигала бы 3-4 раза минимум

А тут вы сами понимаете, хранилище для моей задачи совсем невыгодным становится.

С учетом же ухищрений (не учитывая стоимость миграции) исходящий трафик становится величиной значимой. И разница в 5-15копеек за месяц превращается уже в приличную сумму.

Нет, если вам интересно, то 12-37% это при решении задачи через API и ухищрения.

При решении «в лоб» все гораздо скучнее получается. Как я говорил, в моем случае информация в виде архивов хранится, поэтому хранимый объем был бы разный для облака и для хранилища и разница достигала бы 3-4 раза минимум

А тут вы сами понимаете, хранилище для моей задачи совсем невыгодным становится.

С учетом же ухищрений (не учитывая стоимость миграции) исходящий трафик становится величиной значимой. И разница в 5-15копеек за месяц превращается уже в приличную сумму.

0

Если я правильно понял, вы храните данные в сжатом виде, как-то очень быстро и экономно распаковываете их налету и за счет этого облачный сервер получается дешевле?

Ну так ради бога, используйте облако, в чем проблема?

Ваш случай видимо какой-то очень специфический, в целом соотношение тарифов выглядит более чем разумным.

Ну так ради бога, используйте облако, в чем проблема?

Ваш случай видимо какой-то очень специфический, в целом соотношение тарифов выглядит более чем разумным.

+2

Вы поняли правильно но только последние два сообщение из этой ветки.

Я всего лишь указал на факт, что облако, при прямых руках, хоть на 5-15к но дешевле. А для случаев с возможностью хранения сжатого контента так и еще больше. После чего озвучил мысль, что с текущими тарифами, хранилище, продукт сугубо специфичный и переместив статику на него сильно не сэкономишь.

Я всего лишь указал на факт, что облако, при прямых руках, хоть на 5-15к но дешевле. А для случаев с возможностью хранения сжатого контента так и еще больше. После чего озвучил мысль, что с текущими тарифами, хранилище, продукт сугубо специфичный и переместив статику на него сильно не сэкономишь.

0

P.S. Надо бы запретить сотрудникам фирмы выставлять оценки в блоге этой же фирмы. А то прям не хабр а рекламная площадка получается. :-)

-4

Странно, но по ощущениям CDN отдает дольше картинки, чем сам облачный сервер:

Сервер — static.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg

CDN — st.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg

Сервер — static.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg

CDN — st.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg

+1

Как-то вы странно смотрели скорость (в обоих тестах dns-кеш прогрет)

time wget static.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.066s

user 0m0.000s

sys 0m0.004s

time wget st.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.089s

user 0m0.004s

sys 0m0.004s

time wget static.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.066s

user 0m0.000s

sys 0m0.004s

time wget st.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.089s

user 0m0.004s

sys 0m0.004s

0

У меня

0.98 — для сервера

1.50 — для CDN

Уважаемый amarao, судя по сообщению silverqh0st, static — это сервер, так что ваши результаты подтверждают, а не опровергают сообщение.

0.98 — для сервера

1.50 — для CDN

Уважаемый amarao, судя по сообщению silverqh0st, static — это сервер, так что ваши результаты подтверждают, а не опровергают сообщение.

+2

Да, вы правы.

Какой-то несколько странный CDN, если он медленнее обычного nginx'a.

Какой-то несколько странный CDN, если он медленнее обычного nginx'a.

+1

Попробуйте повторить операцию 10 раз.

У меня с пятого раза вот такие данные.

для st

для static

У меня с пятого раза вот такие данные.

для st

real 0m 0.02s

user 0m 0.00s

sys 0m 0.02s

для static

real 0m 0.02s

user 0m 0.00s

sys 0m 0.01s

0

Минимальный результат из 10-ка:

$ time wget st.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.485s

user 0m0.000s

sys 0m0.004s

в тоже время обычный nginx:

$ time wget static.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.342s

user 0m0.000s

sys 0m0.004s

$ time wget st.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.485s

user 0m0.000s

sys 0m0.004s

в тоже время обычный nginx:

$ time wget static.solnyshko.dn.ua/image/cache/data/2012-04-19/6914-500x500.jpg -O /dev/null -o /dev/null

real 0m0.342s

user 0m0.000s

sys 0m0.004s

0

Пардон.

Не те данные вставил.

st

real 0m 0.21s

user 0m 0.01s

sys 0m 0.07s

static

real 0m 0.23s

user 0m 0.01s

sys 0m 0.06s

Не те данные вставил.

st

real 0m 0.21s

user 0m 0.01s

sys 0m 0.07s

static

real 0m 0.23s

user 0m 0.01s

sys 0m 0.06s

0

смотрите ответ выше…

0

Тест главной страницы с использование CDN:

Url теста: tools.pingdom.com/fpt/#!/hED0GHvG1/solnyshko.dn.ua

И с использованием nginx:

Url теста: tools.pingdom.com/fpt/#!/iRsSl92yr/solnyshko.dn.ua

Наглядное сравнение и, на мой взгляд, достаточно показательное.

Url теста: tools.pingdom.com/fpt/#!/hED0GHvG1/solnyshko.dn.ua

И с использованием nginx:

Url теста: tools.pingdom.com/fpt/#!/iRsSl92yr/solnyshko.dn.ua

Наглядное сравнение и, на мой взгляд, достаточно показательное.

0

Тесты из разных точек.

0

CDN:

tools.pingdom.com/fpt/#!/ywID5vwyr/solnyshko.dn.ua

Nginx:

tools.pingdom.com/fpt/#!/fQdP9MeFV/solnyshko.dn.ua

Так достаточно чистый эксперимент?

tools.pingdom.com/fpt/#!/ywID5vwyr/solnyshko.dn.ua

Nginx:

tools.pingdom.com/fpt/#!/fQdP9MeFV/solnyshko.dn.ua

Так достаточно чистый эксперимент?

0

Знаете, раздачу с nginx можно считать как эталон, т.к. он тупо отдаёт локальный файл не выполняя вообще никаких дополнительных действий. А хранилище устроено значительно сложнее и для отдачи файла требуется выполнить ряд промежуточных действий на каждый запрос, поэтому в любом случае оно будет несколько медленнее, вопрос лишь в том на сколько (решение этого вопроса как раз уже наша работа).

Упреждая вопрос «за зачем тогда хранилище если оно чуток да медленней локального nginx?»: дело в размере и цене :-) Вероятно вы получите выигрыш в стоимости при хранении и раздачи большого объема данных для вашего сайта, чем если бы вы хранили и раздавали тот же контент с вашего хостинга. Плюс не надо задумываться о том сколько хостер предоставляет вам дискового пространства и бэкапить эти данные тоже не нужно.

Упреждая вопрос «за зачем тогда хранилище если оно чуток да медленней локального nginx?»: дело в размере и цене :-) Вероятно вы получите выигрыш в стоимости при хранении и раздачи большого объема данных для вашего сайта, чем если бы вы хранили и раздавали тот же контент с вашего хостинга. Плюс не надо задумываться о том сколько хостер предоставляет вам дискового пространства и бэкапить эти данные тоже не нужно.

+1

Фейсбуковый CDN по скорости сравним с nginx:

$ time wget fbcdn-sphotos-a.akamaihd.net/hphotos-ak-ash4/427996_281378548597041_259422847459278_666223_1237247689_n.jpg -O /dev/null -o /dev/null

real 0m0.513s

user 0m0.008s

sys 0m0.000s

$ time wget solnyshko.dn.ua/image/test.jpg -O /dev/null -o /dev/null

real 0m0.531s

user 0m0.004s

sys 0m0.004s

Иногда, как тут, даже быстрее!

$ time wget fbcdn-sphotos-a.akamaihd.net/hphotos-ak-ash4/427996_281378548597041_259422847459278_666223_1237247689_n.jpg -O /dev/null -o /dev/null

real 0m0.513s

user 0m0.008s

sys 0m0.000s

$ time wget solnyshko.dn.ua/image/test.jpg -O /dev/null -o /dev/null

real 0m0.531s

user 0m0.004s

sys 0m0.004s

Иногда, как тут, даже быстрее!

0

наконец-то!

0

В табличке указана стоимость хранения 3 р. за 1 Гб в месяц.

На сайте написано: 4.5 р. за 1 Тб в час.

Считаем: (4.5 / 1024) * 24 * 30 = 3.1640625 р. за 1 Гб в месяц.

Или я не так посчитал?

На сайте написано: 4.5 р. за 1 Тб в час.

Считаем: (4.5 / 1024) * 24 * 30 = 3.1640625 р. за 1 Гб в месяц.

Или я не так посчитал?

0

Цены конечно приятные и за размещение, и за трафик, но есть ли какие нибудь гарантии, что через какое то время вы не поднимите их резко вверх до уровня своих конкурентов?

При текущих ценах это все очень интересно и перспективно.

При текущих ценах это все очень интересно и перспективно.

0

что-то не могу примонтировать с помощью CloudFuse.

> Unable to authenticate.

что надо писать в качестве username и api_key?

> Unable to authenticate.

что надо писать в качестве username и api_key?

0

Еще вопрос, кол-во файлов в одной папке ограничено?

Например не более 65 тыс файлов на одну папку.

Например не более 65 тыс файлов на одну папку.

0

Имхо, вы сильно раньше начнёте ощущать тормоза, так зачем экспериментировать? :)

0

Не ограничено, по сути хранилище объектное, папки там это просто виртуальные объекты. Если я не прав, пусть меня поправят коллеги.

0

У вас есть ограничение в 5 доменов, это 5 доменов на контейнер или на все доступные контейнеры?

0

А какой уровень избыточности?

0

Планируется ли снять ограничение 5 ГБ на один файл при загрузке через FTP? Сразу можно было под бекапы использовать.

0

Sign up to leave a comment.

Selectel Storage — облачное хранилище